基于压缩感知的回声状态神经网络在时间序列预测中的应用

李莉 於志勇 黄日方菀

摘要:数据预测作为城市计算的一部分,在帮助理解各种城市现象本质及预测城市未来中有着举足轻重的作用。回声状态神经网络作为一种新型的循环神经网络模型,广泛应用于数据预测领域。传统的回声状态神经网络由输入层、储备池和输出层3个部分组成,其储备池中具有大量稀疏连接的神经元,对输入数据进行非线性变换可输出高维的内部状态。针对高维变换在求解输出权值矩阵时的耗时问题,提出一种基于压缩感知方法的回声状态神经网络,利用测量矩阵,将高维的内部状态压缩成低维后再求解输出权值矩阵。混沌时间序列预测实验结果表明,相对于传统模型,该方法能在误差损失允许范围内,将计算时间最大程度降低到40%左右。

关键词:数据预测;回声状态神经网络;储备池计算;压缩感知;时间序列预测

DOI: 10.11907/rjdk.192786

开放科学(资源服务)标识码(OSID):

中图分类号:TP306

文献标识码:A

文章编号:1672-7800(2020)004-0009-05

Echo State Networks Based on Compressed Sensing Applied to

Time Series Prediction

1.2

LI Li'.2 , YU 2hi-yong"2 , HUANG Fang-wan(1.College of Math.enzatic.s and Computer Science . Fuzhou Urziver.sity; 2. Fujian Provirzcial Kev Laboratory of lVetworking Conzputing

and Intelligent Information Proce.s.sing , Fuzhou Univer.sity . Fuzhou 350116 . China )Abstract : As a part of' urban compu ting, data prediction play s an important role in understanding the natu re of various urban phenome-na and predicting the future of cities. As a new ty pe of' circular neural network model. echo state network ( ESN) has heen widely usedin the field of data prediction in recent years. The traditional ESN consists of three parts : input layer, reservoir and output layer. Thereservoir has a large nuruber of sparsely connected neurons and outputs high-dimensional internal states through nonlinear transforina-tion of input data. It is time-consuming to solve the output weight matrix by high-dimensional transformation. To solve this problem,this paper proposes an ESN based on corupressed sensing method, ,,-hich corupresses the high-diruensional internal state into thelow-dirnensional by using a discrete cosine transf'orru matrix . and then solves the output weight matrix. The experimental results of cha-otic time series prediction show that corupared with the traditional model. this method can reduce the computation time to about 35% inthe allowable range of error loss.Key Words: data prediction; echo state networks; reservoir computing; compressed sensing; time series prediction

O 引言

时间序列预测指基于先前获取的一段時间内的某个系统相关变量的值,借助一定的方法对该变量的未来值进行预测…。其在交通流、空气质量、电力负荷等领域,对帮助理解各种城市现象的本质,更好地服务城市居民生活起着举足轻重的作用。

收稿日期:2019-12-22

基金项目:国家自然科学基金项目(61772136)

作者简介:李莉(1995-),女,福州大学数学与计算机科学学院硕士研究生,研究方向为数据预测;於志勇(1982-),男,博士,福州大学

数学与计算机科学学院副教授,博士生导师,研究方向为普适计算;黄防菀(1980-),女,硕士,福州大学数学与计算机科学

学院讲师,研究方向为智能计算、数据挖掘。本文通讯作者:黄防菀。

在众多时间序列预测方法中,循环神经网络(Recur-rent Neural Network.RNN)利用隐藏层的白连接,能够有效保留输入信息,以发现数据中可能相距很远的事件之间的时间相关性,逐渐成为时间序列预测研究热点[2]。从理论上来说,RNN能够适用于任意步长的时间序列预测,但是由于传统RNN采用随时间的反向梯度传播算法(BackPropagation Through Time,BPTT)进行参数训练,随着RNN在时间维度上层数的加深,会带来梯度消失或梯度爆炸等问题,从而造成网络性能下降[3]。

针对这些问题,Jaeger[4]提出了回声状态神经网络(]Echo State Neural Network.ESN),为解决RNN的梯度问题开辟了新途径。作为一种新型的RNN,ESN引入了储备池计算概念。当外部数据输入时,会在储备池内部形成复杂、非线性映射关系。ESN用一个巨大的、随机生成且保持不变的储备池替代传统RNN的中间隐层。由于ESN的输入权值和储备池白连接权值都是随机生成的,因此在学习训练过程中,ESN只需要学习输出连接权值,这大大降低了训练阶段的计算复杂度,同时也避免了BPTT算法带来的梯度问题。

ESN储备池在具备上述优点的同时也带来了一个新问题:为了得到输入信息的高维表示,储备池通常设计的非常庞大,其产生的高维内部状态在求解储备池到输出层的连接权值时要耗费许多时间。因此,本文提出一种基于压缩感知( Compressed Sensing,CS)的回声状态神经网络CS-ESN,在高维的内部状态投入到计算输出连接权值之前,先用一个测量矩阵对其进行压缩,在误差损失允许范围内甚至减少误差的情况下,明显降低计算输出连接权值的运行时间,提高模型计算效率。

1 相关工作

ESN凭借储备池计算这一特点,广泛应用于强化学习”1、非线性系统识别[6]、认知建模[7]等领域,其最成熟的应用集中在时间序列预测上[8-9]。

ESN储备池计算的基本思想是生成一个足够大的复杂动态空间,当这个动态空间达到一定的复杂度时,就可利用内部状态线性地组合出所需要的对应输出[10]。储备池规模在前人的经验结论中为节点越多,能表现的系统就越复杂,所以ESN需要远大于一般神经网络的节点规模,这就导致储备池计算往往建立在高维变换基础上。计算复杂度的提高与计算效率的降低成为不得不考虑的问题。因此,如何生成一个合适的储备池一直是ESN的研究重点。

ESN的另一研究重点是如何得到储备池与输出层之间的输出连接权值矩阵。常见的求解方法包括伪逆法、岭回归法、奇异值分解法等,但在求解输出连接权值矩阵时,因为储备池规模较大,通常容易出现求解复杂的问题。为解决储备池对输入数据进行高维变换后带来的这一问题,Vladimir等[11]提出了4种稀疏线性回归算法,如Lasso、Elastic Net等,在训练ESN的输出连接权值时减少矩阵中至少80%的权重个数,从而达到降维效果;Sigu-d LCikse等[12]在其论文中,将主成分分析法(Principal ComponentAnalvsis,PCA)与ESN相结合,即储备池输出高维的内部状态后,先通过PCA方法映射到一个低维子空间,得到低维的内部状态,再投入到计算输出连接权值中。在时间序列预测的实验中,两种方法都能够很好地对高维数据进行降维处理,从而减少ESN的计算复杂度,且对模型精度有所提升。近年来利用压缩感知技术进行数据压缩逐渐成为代替PCA的主流方法。压缩感知利用高维数据潜在的稀疏特性,相较于奈奎斯特采样理论,可从较少的测量值中还原出原始数据。

2 CS-ESN

2.1 ESN模型简介

ESN是利用储备池计算进行训练的循环神经网络模型,由输入层、储备池和输出层3部分组成。储备池中包含大量神经元(数量为几百个甚至上千个),神经元之间采用随机稀疏连接。ESN结构如图l所示。

图1中,ESN除必不可少的输入层一储备池、储备池一储备池和储备池一输出层之间的连接(实线箭头)外,还加入了输入层一输出层(虚线箭头)的直接连接。K、N和L分别表示输入层、储备池和输出层的神经元个数。和分别表示输入层一储备池、储备池一储备池、储备池一输出和输入层一输出层的连接权值矩阵。和以下统称为输出连接权值矩阵,需要通过训练得到,其它矩阵在网络中为随机初始化生成。

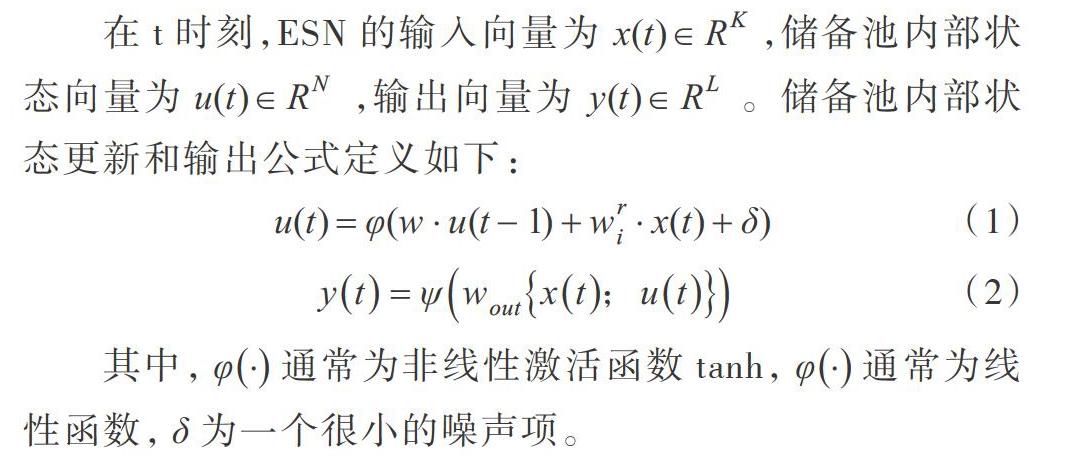

在t时刻,ESN的输入向量为X(t)∈RK,储备池内部状态向量为u(t)∈RN,输出向量为y(t)∈RL。储备池内部状态更新和输出公式定义如下:

其中,通常为非线性激活函数tanh,通常为线性函数, 为一个很小的噪声项。

李莉,於志勇,黄昉菀:基于压缩感知的回声状态神经网络在时间序列预测中的应用

为了更好地训练 ,本文采用长度为s的训练序列S(输入一输出对):

在网络初始阶段,先随机初始化生成 和 ,投入序列S的输人 运行网络进行训练,根据公式(1)得到内部状态序列 ,… 。初始阶段的内部状态一般需要丢弃,可从某个时刻h开始记录内部状态,将相应的输入向量和内部状态向量一起构成矩阵M,将对应的目标输出向量构成矩阵Z:

本文采用伪逆法,即采用线性回归的矩阵伪逆计算,通过将M的伪逆与Z相乘计算输出连接权值:

2.2 结合测量矩阵的CS-ESN模型

压缩感知理论指出,只要信号是可压缩的或在某个变换域是稀疏的,那么就可用一个测量矩阵将变换所得高维信号投影到一个低维空间上,然后通过求解一个优化问题,就可从这些少量的投影中以高概率重构出原信号[13]。。在压缩感知问题中,测量矩阵经常为随机矩阵,比如均值为0,有一定的高斯分布矩阵等,其行数远小于列数。目前比较常见的测量矩阵包括高斯随机矩阵、随机伯努利矩阵、特普利茨矩阵和结构随机矩阵等。利用测量矩阵进行压缩处理的结构如图2所示。

如圖2所示,g为n维的向量,D为mxn大小的测量矩阵。向量g与测量矩阵D相乘后,从n维降到m维,得到向量 ,从而达到压缩效果。

本文的CS-ESN根据实际需求生成一个测量矩阵,在利用高维的内部状态计算输出连接权值 .之前,增加一个压缩处理步骤,即储备池输出高维的内部状态后,通过测量矩阵映射到一个低维的子空间,得到低维的内部状态再用于输出连接权值 的计算。结合测量矩阵的CS-ESN结构如图3所示。

从图3可以看出,在ESN训练阶段,训练序列的输人x(t)投入到储备池中得到高维的内部状态u(t),观测矩阵与其相乘进行压缩得到低维的内部状态 (t)后,将其投入到输出层求解输出连接权值 。假设ESN的储备池大小为1000维,输人x(t)为10维,输出 为1维。当输入被投入到储备池中时,便会由储备池进行一个非线性的1000维变换,得到的内部状态u(t)为1000维。此时直接将内部状态u(t)投入输出层进行连接权值矩阵 的计算,要耗费的时间即为1000维的内部状态与10维的输入l维堆叠后得到的矩阵,以及输出y(t)训练得到连接权值矩阵 。如果在内部状态u(t)投入到输出层之前,先将其压缩到400维,即利用一个400×l000大小的测量矩阵,将测量矩阵与内部状态相乘得到400维的内部状态 (f),再根据上述步骤去训练连接权值矩阵 ,所要耗费的时间便可随着内部状态u(t)的压缩而降低,ESN的计算效率随之提高。

测量矩阵包含随机测量矩阵和确定性测量矩阵。随机矩阵中的高斯矩阵和伯努利矩阵都能以很大概率满足RIP,即约束等距条件[4]。(RIP条件从理论上看是实现压缩感知的测量矩阵的最佳约束条件)。随机测量矩阵优点是所需测量数较少,但其具有不确定性、存储量大等缺点。确定性测量矩阵包括循环测量矩阵、Chirp测量矩阵等,是另一种常用的压缩感知测量矩阵,计算复杂度低,相对于随机测量矩阵有优势,实际应用能力较强。

本文选择的测量矩阵为高斯随机矩阵GRM( GaussianRandom Matrix)与确定性测量矩阵中的离散余弦变换DCT(Discrete Cosine Transfonn)矩阵。

GRM构造形式为:对于一个rnxn的矩阵 ,其矩阵中的元素 ,是独立的随机变量且服从如下分布:

即服從期望为0,方差为1/m的高斯分布[15]。该测量矩阵具有很强的随机性,具有较大概率满足RIP条件,在压缩感知过程中广泛使用。

DCT矩阵是与傅里叶变换相关的一种变换,它类似于离散傅里叶变换,但是字典的元素均为实数[16]。在对确定的变换矩阵的正交变换中,DCT被认为是一种最佳变换。对于一个长度为n的一维离散时间序列信号,其离散余弦变换序列为。DCT矩阵用数学表示如下:

3 实验

3.1数据集简介

本文选用时间序列预测中常用的两个基准任务,即Mackev-Glass时间序列预测和NARMA信号。

Mackev-Glass(MG)时间序列中的输入信号由MG时滞微分系统生成,公式如下:

其中, 通常设为0.1,参数r=17,初始值x(01=1.2。时间序列一共生成4994个观测点,前70%作为训练集,用来学习输出连接权值 ,后30%作为测试集,用来评估回声状态神经网络模型的学习效果。

Non-Linear Auto-Regres sive

Moving( NARMA)数据集最初由Jaeger[17]提出,包含对下列r阶系统输出建模:

系统的输入x(n)为[O,1]间随机分布的噪声。NAR-MA任务需要至少r个过去时间步的记忆,因为系统的输出 由输入和第r个时间步的输出决定,通常设定r=10。数据集一共包含10000个点,训练集与测试集的划分与作用同MG数据集一样。图4分别展示两个数据集前200个输入的复杂情况。

3.2评价指标

为了对比ESN与CS-ESN两种模型效果,本文选用标准化均方根误差NRMSE(Normalized Root Mean Squared Er-ror)与运行时间RT(Running Time)作为评价指标。NRMSE公式定义如下:

其中 表示求平均,y为ESN网络输出 ,为目标输出。

RT为计算内部状态和输出连接矩阵的总时间,以秒为单位。

3.3实验设置

储备池是ESN的核心结构,ESN的最终性能由储备池的各个参数决定。储备池参数有储备池大小N、储备池谱半径,)和储备池稀疏度 。从图4可以明显看出,同样数量的输人数据,NARMA相对于MG而言更无规律性,复杂度更高。因此,ESN模型参数对于两个数据集的设置情况也有所不同,主要体现在储备池规模上。

根据前期工作,本文将ESN模型参数设置如表l所示。

表1中 ,为噪声项,即为ESN加入一个偏置。ESN在求解输出连接权值时使用伪逆法,容易导致病态解问题,文献[18]建议在内部状态上加入噪声项以改变矩阵性质,从而改善解的性能。根据ESN定义,要使储备池保持“回声状态属性”谱半径应满足p

3.4实验结果与分析

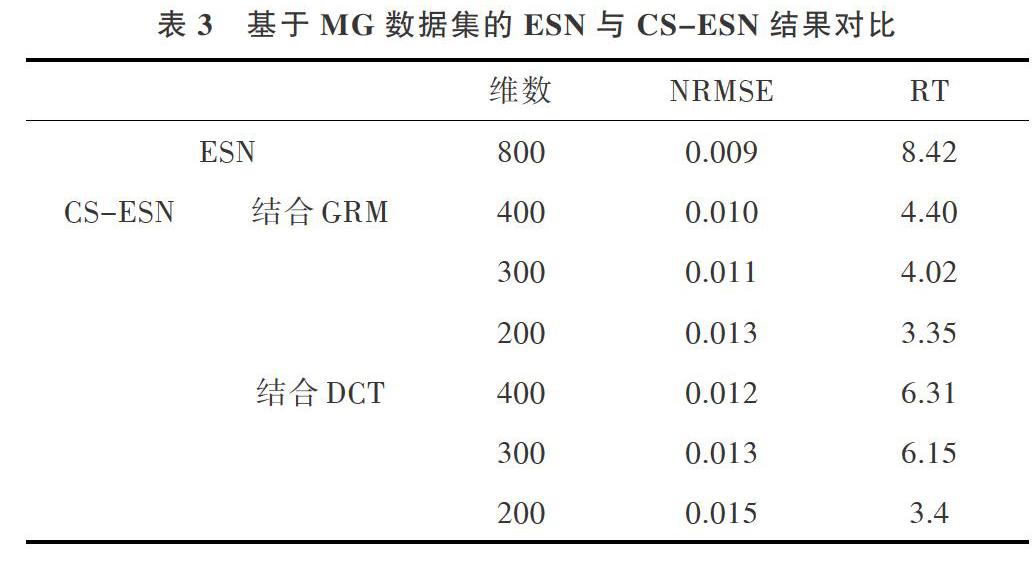

考虑到实验中运行时间RT略有浮动,实验结果取10次运行的平均。GRM中CS-ESN的NRMSE值受随机生成影响,取其最好结果,DCT中CS-ESN的NRMSE值不变且唯一。实验结果对比如表3和表4所示,其中维数指参与计算输出连接权重的内部状态维数。

李莉,於志勇,黄昉菀:基于压缩感知的回声状态神经网络在时间序列预测中的应用

从表3和表4可得出以下结论:①CS-ESN通过将储备池的内部状态进行压缩降维操作,可有效降低网络训练的运行时间。对于MG数据集而言,当结合GRM的CS-ESN将储备池从原来的800维压缩到400维时,NRMSE仅比原始模型略大一点,RT已能够降低到原始模型的52%左右;压缩到200维时,RT最高降到原始模型的40%左右。对于NAMRA数据集而言,也有类似结论;②不可否认的是,在对内部状态进行压缩降维的同时,会丢失部分信息,从而造成预测精度下降。对于MG数据集而言,由于数据集的复杂度不高,CS-ESN可以把内部状态从800维压缩到200维,且精度仍保持在较好范围内。但是对于复杂度较高的NARMA数据集而言,当内部状态压缩超过原有维度的50%(500维)后,其预测精度将出现明显下降,这意味着在今后T作中必须考虑在不同数据集上,CS-ESN针对预测精度和网络训练时间的平衡问题;③从测量矩阵的选择来看,结合GRM的CS-ESN相对于结合DCT的CS-ESN在NRMSE和RT上普遍要好,其原因是本文对GRM进行了10次随机,并选取了最好的结果。有可能存在一个测量矩阵使CS-ESN压缩后的精度与原始模型相同,甚至比原始更高,这是本文后续研究工作的重点;④储备池的参数配置也是一个有待研究的问题。本文实验中CS-ESN与ESN所处条件相同,即参数配置都一样,适合ESN模型的参数可使其达到很好的精度,却不一定适用于CS-ESN模型。在未来研究中可考虑对压缩后的ESN模型进行参数调整,以进一步提高CS-ESN的预测精度。

综上所述可得出如下结论:如果精度损失在允许范围内,基于压缩感知的ESN模型能够明显降低原始ESN的运行时间,在一定程度上提高ESN的计算效率。

4 结语

本文结合压缩感知理论提出一种改进的回声状态神经网络CS-ESN。在时间序列预测的基准数据集上进行实验,证明在与ESN处于相同的配置条件下,CS-ESN使用测量矩阵将高维的内部状态压缩到一定维度时,能够明显降低计算时间,且损失精度仍在拟合效果较好范围内。在压缩感知理论中,测量矩阵设计很关键,后续工作可以采用字典学习或参数设计方法得到一个性能较好的测量矩阵,并通过真实数据集验证其有效性。这样不仅能提升ESN的计算效率,还能增强ESN的预测能力,并且对动态储备池分析也有价值。

参考文献:

[1]史志伟,韩敏.ESN岭回归学习算法及混沌时间序列预测[J].控制与决策,2007,22(3):258-261.

[2]BIANCHI F M. MAIORINO E. KAMPFFMEYER M C,et al. An orer-view and comparative analvsis of recurrent neural networks for shortterm

load forecasting [EB/OL].http://www.doc88.corn/p-3773567817998.html 2017.

[3]JUN WAMIKAWA. JUN TANI. Building rec:urrent neural networks toimplement multiple attractor dYnamics using the gradient descentmethodFJl. Advances in Artificial Neural Svstems. 2009(8):1-1 1

[4]JAECER H. The "echo state" approach to analysing and training re-current neural networks[M].uhervachtes lernen, 2001

[5]BLSH K, ANDERSON C.Modeliiig reward functinns for incompletestate representations via echo state networks[C]. IEEE InternationalJoint Conference on Neural Networks, 2005: 2995-3000.

[6]PALL G PLO'CER. ARCHIR A, TOBIAS CU"NTHER, et al. Echostate networks for mobile rohot modeling and contrr)l[C].Robot Soc-cer World Cup,2003: 157-168.

[7]RAO Y N, KIM S P.SANCHEZ J C. et al. Learnig mappings in brainmachine interfaces with echo state networks[Cl. IEEE InternatirinalConference on Acoustics, Speech, and Signal Processing, 2005:233-236.

[8]JAEGER H,HASS H. Harnessing nonlinearity: predicting chaotic sys-tems and saving energy in wireless communication[J]Scienc.e, 2004,304( 5667):78-86.

[9]韓敏,史志伟,郭伟.储备池状态空间重构与混沌时间序列预测[J]物理学报,2007.56(1):43-49

[10]]罗熊,黎江,孙增圻.回声状态网络的研究进展[j].工程科学学 报,2012, 34(2): 217-222.

[11]CEPERIC V. BARIC A. Reducing complexity of echo state netwnrkswith sparse linear regression algorithms[C]. 2014 UKSim-AMSS16th International Conference on Computer Modelling and Simula-tion, Camhridge, 2014: 26-31.

[12]LKSE S,BIAhrCHI F M, JEhrSSEN R. Training echo state net-works with regularization thrr)ugh dimensionality reduction[J] Cr,g-nitive Cnmputation, 2017,9(3):364-378.

[13]李峰,郭毅压缩感知浅析[M]北京:科学出版社,2015.

[14]陈善雄.压缩感知理论在异常检测中的应用研究[M].北京:科学出版社.2017.

[15]党骏,马林华,田雨,等.m序列压缩感知测量矩阵构[J]西安电子科技大学学报,2015(2):186-192

[16]JAECER H. Adapti,'e nonlinear svstem identification .vith echo statenetworksF M]. Nips, 2002: 609-616.

[17]鲁业频,李凤亭,陈兆龙,等.离散余弦变换编码的现状与发展研究[J]通信学报,2004. 25(2):106-118

[18]黄标兵回声状态网络时间序列预测方法及应用研究[D].长春:吉林大学,2017.

[19] JAEGER H. Long shorL-term memorv in echo statenetworks: Details of a simulation stu dv[R]Technical repnrt, Technical. Jacohs Univer- sitv Bremen.

[20]IAN GOODFELLOW, YOSHLiA BENCIO. AARON COLRVILLE.Deep LearningEM]Beij ing: Posts and Telecorn Press, 2017

(责任编辑:杜能钢)