基于Inception-ResNet-v2的乳腺癌辅助诊断方法*

何欣颖 吴黎明 郑耿哲 吴佳毅

(1.广东工业大学机电工程学院,广东 广州 510006 2.佛山沧科智能科技有限公司,广东 佛山 528200)

0 引言

癌症是当前严重威胁人类健康的主要疾病,其中乳腺癌是影响女性健康最主要的恶性肿瘤之一。乳腺癌的诊断主要有影像学检查和病理学检查2种方法,其中病理学检查是乳腺病变良恶性的最终诊断依据[1]。因此,病理图像的分析诊断对判断是否存在癌症极其重要。但病理图像存在细胞重叠、病变细胞形态差异细微、染色不均等特点,导致病理医生依据经验耗费大量时间仔细观察和鉴别做出的诊断,存在受主观人为因素影响且可能出现漏诊误诊的可能[2]。高效准确地自动分类病理图像,对缓解病理医生的压力和给出更加客观、准确的结果尤为重要[3]。

学者们针对乳腺癌病理图像自动分类开展了相关研究。在传统机器学习算法方面,Kowal等[4]基于自适应阈值和聚类分割方法,采用K-means、模糊C均值、竞争学习神经网络和高斯混合模型4种聚类算法对细胞核进行分割,实验结果表明准确率达96%~100%;Spanhol等[5]公布了由7909幅乳腺癌病理图像构成的BreaKHis数据集,并在此数据集上采用基于纹理表示的全局方法,利用局部二值模式(local binary patterns, LBP)、局部相位量化(local phase quantization, LPQ)等6种纹理描述符提取特征并用支持向量机(support vector machine, SVM)、随机森林(random forest, RF)、二次判别分析(quadratic discriminant analysis, QDA)和K近邻4种分类器进行分类,准确率达80%~85%。上述方法都是基于传统机器学习进行病理图像分类,需要人工设计特征,存在专业知识要求高、提取特征耗时及难以提取高层次特征的问题。

近年来,将深度学习运用到医疗图像分析领域成为研究热点之一[6]。深度学习与传统机器学习最大的不同在于其特征表示是从大量数据中自动学习得到,能从大量的数据集中逐步提取更高层次的抽象语义特征,避免了人工设计及提取特征的局限性[7]。Spanhol等[8]将BreaKHis数据集以随机和固定滑动窗口的方式,在不同放大倍数的图像中采样块训练AlexNet网络,识别率最高达89.6%,无法满足临床需要。Deniz等[9]提出先用迁移学习预训练AlexNet,VGG16网络,再对网络进行微调,实现乳腺癌病理图像的自动分类,最佳精度值达93.78%,证明了使用迁移学习进行预训练比直接使用深度卷积网络或 SVM的效果更好。

由于目前缺乏大量公开、已标注的数据集,本文基于深度卷积神经网络实现乳腺癌病理图像的自动分类,采用迁移学习解决数据稀少、易过拟合的问题;用数据增强,增加训练的数据量,提高模型的泛化能力,满足更加精准地判断乳腺病理图像的需求。

1 模型与方法

1.1 Inception-ResNet-v2网络

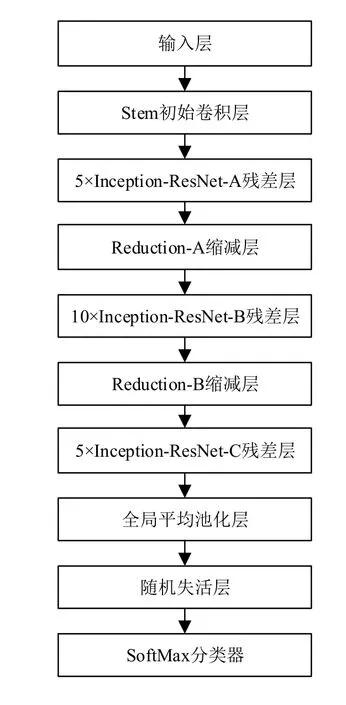

对比目前常用的深度卷积神经网络模型AlexNet,VGG,Inception、ResNet等,本文选用在ILSVRC图像分类基准测试中实现当下较好成绩的 Inception-ResNet-v2网络作为基本结构,实现乳腺癌病理图像分类。Inception-ResNet-v2网络在Inception V3基础上引入了残差网络跳跃连接的方法,加深网络深度的同时,避免了梯度消失、梯度爆炸的问题,提高了网络性能;将卷积核进行分解,提升了计算能力,使得网络深度进一步增加,并增加了网络的非线性,整体结构如图1所示。

图1 Inception-ResNet-v2网络总体结构

Inception-ResNet-v2要求输入层为299×299×3的RGB图片;中间各层得到的结果称为特征图(Feature Map),主要包括组合卷积、池化、残差、张量连接等运算,其中组合卷积以“多通道卷积—批归一化—激活运算”的方式进行;输出层以SoftMax分类器为基础,利用特征图中的各个特征分量预测图片属于某类别的概率。

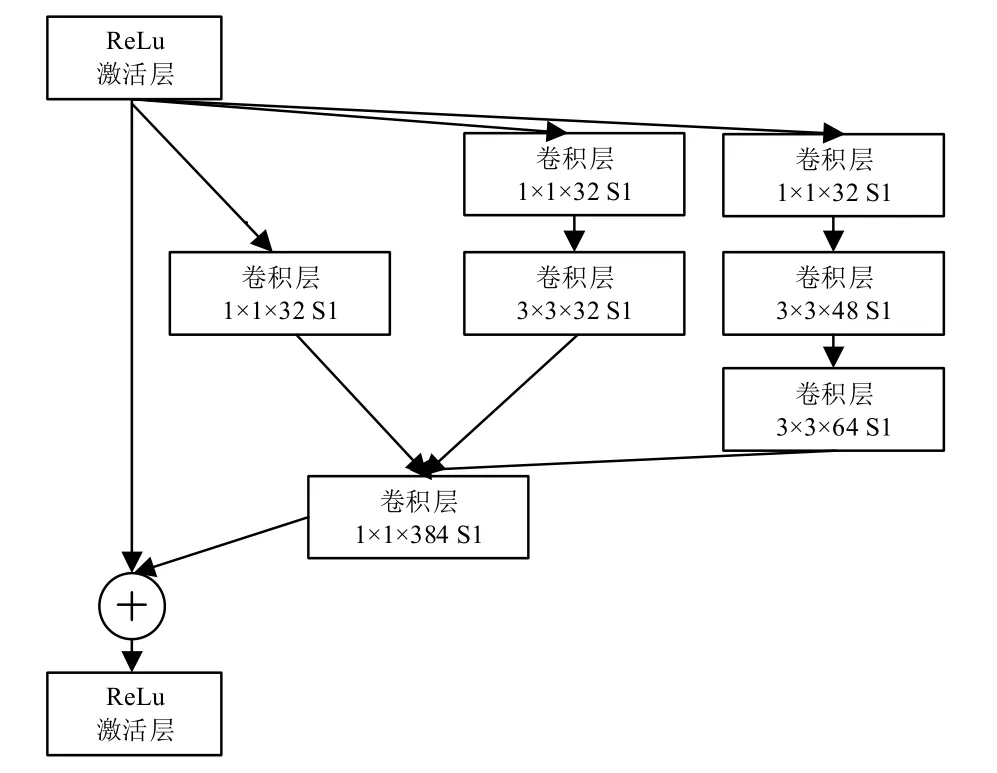

该网络的特征提取模块为 Inception-ResNet-A、Inception-ResNet-B、Inception-ResNet-C多路卷积残差模块,结构分别如图2、图3、图4所示。Feature Map经ReLu激活函数后进入右路通道进行组合卷积运算;通过张量连接、残差结构后,再进入ReLu中进行激活处理,其中 S1代表卷积步长为 1。在 Inception-Resnet-B、Inception-Resnet-C结构中,右路卷积将7×7和 3×3 的卷积核分解成 1×7、7×1 和 1×3、3×1 的不对称卷积核,在提高运算性能的同时加深了网络深度及非线性。

Inception-ResNet-v2网络结构最终得到的Feature Map是一个1×1792维的特征向量。SoftMax分类器以1792维向量作为输入,输出向量的维度与类别数相同。对于每张输入图像x(i),其标记为y(i)∈ { 1 , 2,…,k} ,共k类,本文仅对乳腺癌病理图像做良恶性分类,即k= 2。用假设函数估计其属于每个类别j的概率p(y(i)=j|x(i)),则假设函数hi为

矩阵θ中,每一列参数负责每一类的预测。在训练过程中通过式(2)、式(3)优化θ矩阵以及前面所有层的卷积核参数,使损失函数LossFunc(θ) 最小,得到最终的权重值。

式中,m为输入的病理图像数;1 (y(i)=j)为指示性函数。

图2 Inception-ResNet-A

图3 Inception-ResNet-B

图4 Inception-ResNet-C

1.2 数据增强与迁移学习

卷积神经网络需要学习的参数众多,因此需要大规模的数据集才能防止过拟合。但现阶段获得由专业病理医生标注的大规模数据集极其困难且代价昂贵,导致缺乏大规模、已标注的医疗图像训练数据。本文采取迁移学习、数据增强的方法来解决此问题[10-11]。

迁移学习通过在大规模数据集上进行预训练,得到模型初始化参数;再迁移到目标数据集上进行微调和训练,从而加快并优化模型的学习效率[12]。本文在ImageNet数据集(包含1400余万幅图像和2万多个类别)上对Inception-ResNet-v2进行预训练,得到的模型参数作为网络初始化参数;然后迁移到目标数据集BreaKHis上进行微调训练。同时采用仿射变换方法对原始图像进行数据增强,主要通过将图像旋转、平移、翻转、颜色变换等,将数据集扩充5倍。

2 实验

2.1 数据集

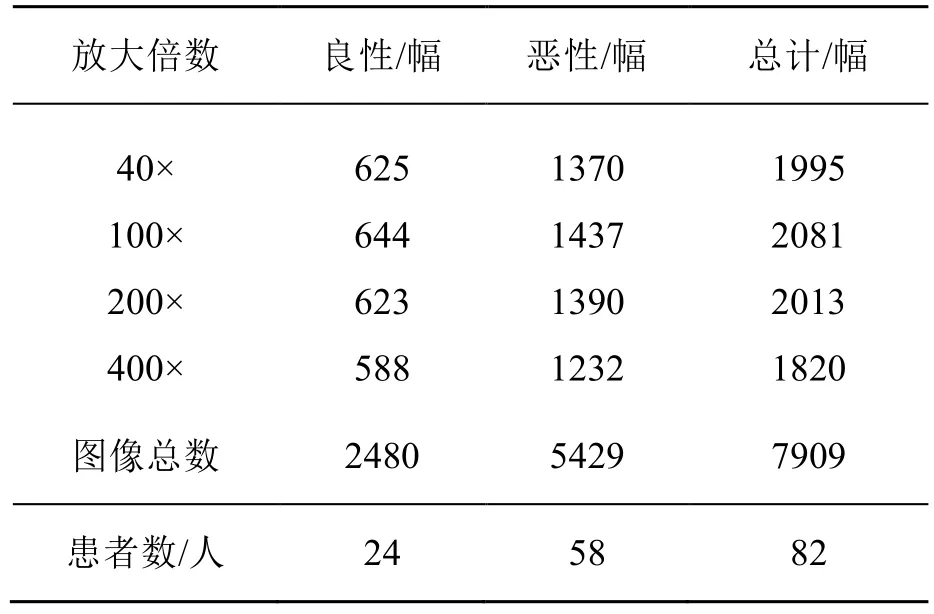

本文使用BreaKHis数据集[6],其数据来自于82位患者的病理切片,每张病理切片均采用4种放大倍数,共7909幅。其中2480幅良性样本和5429幅恶性肿瘤样本,数据集分布情况如表1所示。

表1 BreaKHis数据集具体分布情况

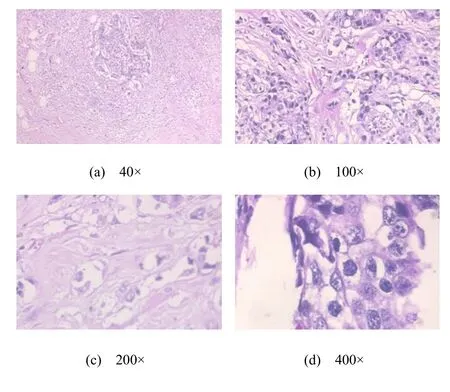

每张图像的固定像素为700×460,模式为三通道RGB、PNG格式。数据集的每幅样本都已做好标注,如SOB_B_TA-14-4659-40-001.png是通过外科开放活组织检查(SOB)收集、放大倍数为40×的管状滑动腺瘤(TA)类型的良性肿瘤(Benign)的图像1,其图像来自幻灯片14-4659。图5为数据集恶性肿瘤中的小叶癌(LC)放大不同倍数的图片。

图5 不同放大倍数下的恶性肿瘤病理图像

将上述数据集按照6:2:2的比例随机划分成训练集、验证集、测试集;将图片大小 700×460裁剪成299×299送到网络中进行微调训练,实验结果为5次随机分配数据集实验的平均值。

2.2 实验平台与超参数

本文实验平台配置包括:处理器 Intel i7-7700k;内存 32 G DDR4 2400 MHz;2个 Nvidia GeForce GTX1080Ti显卡;固态硬盘 850EVOSATA3(120 G);操作系统为 64位 Ubuntu14.04 LTS;实验框架为TensorFlow开源框架。

在微调阶段将训练集、验证集中的图像送入预训练好的Inception-ResNet-v2网络进行训练,使用自适应矩估计(Adam)梯度优化算法对权重、偏置进行更新;初始学习率设置为0.001;动量因子取0.9和0.999;每次训练的批量数为64;当训练迭代次数达20000次时,将学习率调为0.0001,便于收敛网络。

2.3 实验结果与分析

对于二分类问题,本文使用图片识别率即准确率(ACC)作为模型的评价指标

式中,Nall为测试集中所有的图像数目;Nr为测试集中正确分类的图像数目。

为验证数据增强、迁移学习的有效性,本实验对是否采用数据增强及迁移学习前后3种分类结果进行对比,如图6所示。

图6 数据增强及迁移学习前后的分类结果

图6结果显示数据增强、迁移学习后,准确率都有大幅度提高,证实了模型在预训练时学到了一些浅层特征,有助于模型在目标数据集上更好地学习;证实了数据增强,扩充数据集后,能有效提高模型的分类性能。在 40×放大倍数下,得到的准确率最高达96.8%,反映了 40×放大倍数的病理图像包含了更多区别良恶性肿瘤的特征,包括组织结构及细胞核特征。

为验证Inception-ResNet-v2网络性能,在相同的实验环境和训练策略下,对比与 Inception-ResNet-v2卷积层数相近的ResNeXt-101和SENet-101网络的训练性能。以均值平均精度(mAP)作为指标进行比较,分别计算3条P-R曲线(即精确率—召回率曲线)的积分得到mAP值,如表2所示。

表2 mAP对比结果

由表2可知,Inception-ResNet-v2的mAP值高于ResNeXt-101和SENet-101网络模型,该网络模型在总体分类性能上略优于其他二者。

3 结论

本文利用深度学习方法实现了乳腺癌病理图像的自动分类,比传统机器学习方法能提取到更高层的抽象语义特征。通过实验,验证了迁移学习和数据增强的有效性,及基于Inception-ResNet-v2网络模型的分类性能略优于其他相近的网络模型。实验在40×放大倍数下,准确率达96.8%,在一定程度上可应用于实际医学辅助诊断场景。