基于DPN深度学习网络的红外与可见光图像融合

宋建辉,周 航,刘砚菊,崔 洁

(沈阳理工大学 自动化与电气工程学院,沈阳 110159)

图像融合是一种增强技术,其可将多种信息源的图像融合在一块,给人眼提供更多的视觉信息[1]。红外图像提供了热辐射信息,而可见光图像提供了细节信息,两者相融合能够有效提取可见光图像的细节信息,显示红外图像中的区域目标和背景[2]。目前红外与可见光图像融合已经很好地应用在军事、医疗、工业等方面。

图像融合包括了像素级融合、特征级融合和决策级融合,目前最成熟的融合方法依旧是像素级融合[3]。像素级融合中最简单的方法还是加权平均法[4]。像素级融合方法还包括拉普拉斯金字塔(LaplAcianPyramid,LAP)[5]、离散小波变换(Discrete Wavelet Transform,DWT)[6-7]、非下采样剪切波变换(Non-Subsampled Shearlet Transform,NSST)[8]等。Zhou Zhiqiang等[9]提出使用高斯和双边滤波混合的多尺度分解,但这些多尺度变换方法在特征处理上还有很多不足。有些研究者利用深度学习对图像进行特征处理,深度学习算法使用大量的图像训练网络,进而获得图像的更多特征,如Hou R C等[10]在对医学图像的融合里应用了卷积神经网络(Convolutional Neural Network,CNN),且取得不错的融合结果。Liu D等[11]将深度学习网络VGG19应用于多聚焦图像融合,也获得了良好的性能。深度学习在图像融合方面,相较于传统融合算法具有很大的优势,然而传统的卷积神经网络一般会由于网络层数的增加,梯度会不断的变小甚至消失,计算量增大,于是研究者们在卷积神经网络的基础上进行改进,提出了残差网络、密集卷积神经网络等。

将密集卷积神经网络与残差网络的两种网络相结合,既能充分处理深度特征,也减少了参数冗余等问题,从而获得更好的融合性能。本文将红外与可见光图像分解为高频和低频部分,低频部分使用平均融合策略进行融合;利用双路径网络(Dual Path Networks,DPN)对高频部分进行深度特征处理;然后对得到的特征进行正则化、卷积处理,利用最大选择策略得到高频部分融合图;最后对低频与高频部分融合图像进行重构,得到最终融合图像。

1 相关工作

DPN是由ResNet的改进版ResNeXt与DenseNet结合组成的网络。ResNet是一种残差网络,使用捷径链接和残差表示方法,因此更易优化。残差网络的残差跳跃结构改变了传统神经网络固定输出模式,使神经网络中某一层输出跨过好几层作为后面某一层的输入;这种跳跃式输出结构增加了网络的准确率。ResNeXt是ResNet的改进版,是ResNet和Inception的结合体。Inception就是拆分转换再合并的一种结构。ResNeXt将一条残差路径变成了多条残差路径。图1为残差块结构图,其中左边是ResNet残差块结构,右边是ResNeXt残差块结构;右边是将一条路径分成32条路径,再将其进行卷积操作,然后相加,两者通道数不变。

2017年由清华大学、康奈尔大学和Facebook研究者们共同提出了基于卷积神经网络改进的网络,称为密集卷积神经网络[12]。该网络将所有网络层两两连接,既所有的先前层特征都可以作为输入,每层的特征加上先前层的特征作为输出,使得特征在不断重复使用,减少了特征丢失,同时也减轻了随着网络层数的增加梯度不断减少的问题。其网络结构如图2所示。

密集块是密集卷积神经网络核心,过渡层在两个密集块之间,过渡层的存在不仅降低了计算量,还避免了网络训练时过拟合的问题,增加了网络的鲁棒性。DPN是ResNeXt与DenseNet两个网络的结合体,图3为两个网络结合的结构图,其左边为DenseNet,右边为ResNeXt;两边进行相加操作,然后进行3×3的卷积操作且再进行1×1的维度变换;接着通道分裂,左边的原输入进行合并操作,右边的原输入进行相加操作,既形成了DPN网络,其网络结构如图4所示。

2 融合算法

(1)

(2)

(3)

2.1 低频部分融合

(4)

2.2 高频融合部分

(1)提取深度特征。利用DPN网络对图像高频部分的深度特征进行提取,定义网络的特征提取层为H,提取到的特征层为Lk,m表示特征层的通道数量,则

(5)

(6)

(7)

(8)

2.3 重构图像

最后对获得低频融合图像和高频融合图像进行重构,得到最终的融合图像F(x,y),其表达式为

F(x,y)=Fb(x,y)+Fd(x,y)

(9)

3 实验结果及分析

本文实验在Pycharm平台完成。选取三组红外与可见光图片进行实验,第一组红外图像的特征较强;第二组可见光图像特征较强;第三组红外与可见光的图像特征较为均衡。分别将本文算法融合结果与RestNet融合方法和DenseNet融合方法的融合结果做对比。

第一组实验结果如图6所示。

从图6中可以看出,对比ResNet融合方法与DenseNet融合方法,本文算法相对来说亮度更高,清晰度也更好,另外在图中的小框标注处的孔洞处轮廓也最为明显。

第二组实验结果如图7所示。

图7中可以看出,ResNet融合方法中上方的框中的树叶间隙处信息近乎完全丢失,DenseNet融合方法该处信息也有所丢失,前两种算法在竖框处有重影,而本文算法很好地保留了可见光图像中的信息。

第三组实验结果如图8所示。

图8中可以看出,ResNet算法的融合图像在车窗处信息丢失;DenseNet融合方法的融合图像在车窗处较为清晰,但车窗内的座椅信息丢失;本文算法的整体清晰度高,且车窗内信息保留较好。本文算法在该处信息保留较为完整,本文算法比另外两种融合方法清晰度高。

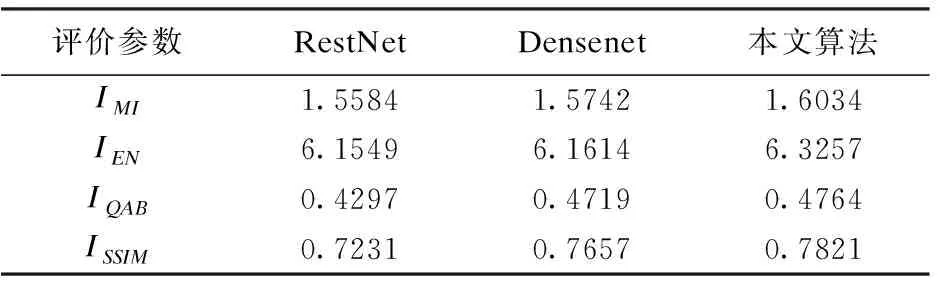

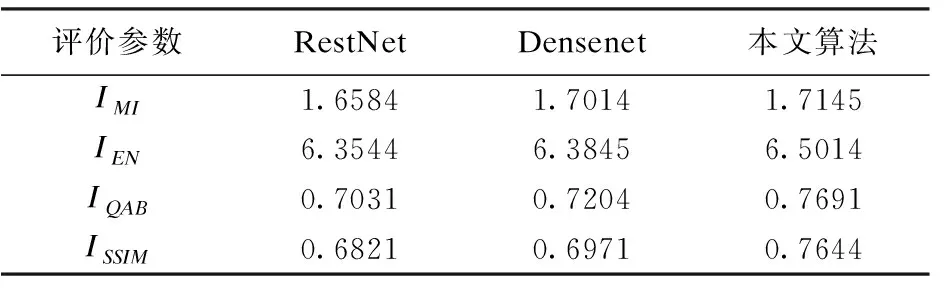

本文采用互信息(IMI)、信息熵(IEN)、边缘信息保留(IQAB)、结构相似度(ISSIM)等客观评价参数对融合结果进行对比分析。其中图像的互信息指的是源图像与融合后图像之间的信息量;信息熵是指融合图像信息量的大小;边缘信息保留指的是融合图像的边缘信息保留效果;结构相似度是评判源图像与融合图像之间的相似性。上述评价参数数值越大,表示融合效果越好。各客观评价参数如表1、表2、表3所示。

表1 第一组实验各算法融合性能评估

表2 第二组实验各算法融合性能评估

表3 第三组实验各算法融合性能评估

从表1中的数据可以看出,本文提出的融合算法客观评价参数值比另外两种算法参数值高,说明本文算法的结构相似度更高,边缘信息保留更多。

从表2中的数据可以看出,本文提出的融合算法客观评价参数值比另外两种算法参数值高,说明本文算法得到的融合图像效果更好。

从表3中的数据可以看出,本文提出的融合算法客观评价参数值更好,结构相似度数值比另外两种算法的参数值更高,证明了本文算法在红外与可见光图像的融合上的优越性。

4 结论

提出的基于DPN深度网络的红外与可见光图像融合方法,很好地结合了两种网络的优势,即有残差网络参数少、计算快,又有密集卷积神经网络的可以重复使用特征的特点,更好的突出了图像的高频部分特征,对图像的细节信息利用率更大,背景信息保留完整,人物目标突出,图像整体清晰度更高。