联合书目数据库重复书目数据控制工作实践研究

——以深圳“图书馆之城”为例

陈 娟

(深圳图书馆,广东 深圳 518000)

书目数据是计算机可识别和可处理的揭示馆藏文献资源的信息联合书目数据库,特别是区域联合书目数据库,汇集了同一区域多个图书馆的书目数据。在一个联合书目数据库内,同一种文献被重复记录了两次或两次以上,被称为重复记录[1]。当重复记录超过一定比例时,通常会被认为是质量问题。重复数据不仅造成书目数据库的容量快速膨胀,还给成员馆使用数据造成不必要的筛选麻烦[2]。因此,重复数据的清理与合并工作成为各大联合编目系统书目数据维护工作的业务范围,业界关于重复数据的产生原因、合并模式等探讨较多[3-5],已基本形成共识,但是基于实践的重复数据系统控制的总结探讨却较少。

深圳“图书馆之城”的建设目标是整合全市公共图书馆服务系统和文献资源,在全市范围内为市民提供统一的图书馆服务[6]。统一书目管理是深圳“图书馆之城”开展统一服务的重要基础,总书目库数据质量关系着统一服务的质量。正常情况下,同一种文献对应一条书目记录,合库前,由于“图书馆之城”各成员馆编目规则不统一、编目质量参差不齐以及数据库合并等诸多原因,深圳“图书馆之城”总书目库中存在大量重复书目数据。用ISBN 检索时,有时会检出两条及以上书目记录(如图1),个别情况是因为一号多书,多数情况下是一种书出现一条或几条重复记录。据统计,截至2014 年底,中央书目库数据为251 万条,ISBN重复的数据达42万余条,重复记录占比约为16.7%,重复数据若不及时加以控制和规范,每年递增速度将达到3 万条以上。重复数据和冗余数据给读者OPAC书目检索带来了巨大的困扰,也给工作人员书目查重造成了极大的不便,同时也对“图书馆之城”统一服务的整体效果产生了一定的负面影响。因此,“图书馆之城”重复书目数据控制工作被提上了日程。近4年来,通过控制重复数据产生源头、回溯清理历史重复数据,深圳“图书馆之城”的中文图书重复书目数据控制工作取得了一定的成效。

图1 OPAC中查到的重复书目示例

1 控制重复数据产生源头

为了控制重复数据产生的源头,首先要对中央书目库中新增记录进行严格管理。只有控制了中央书目库新增书目记录,不再继续灌入大量重复数据,再组织专门人员开展重复书目数据清理工作,才能起到事半功倍效果。为了对中央书目库中新增书目记录进行严格管理,采取了以下措施。

1.1 搭建联合采编平台

按照《美国图书馆学会词汇》的定义,联合编目是指“一组各自独立的图书馆开展的书目原始编目的协作活动,成员馆之间有义务相互提供书目记录”。联合编目可以降低成员馆的编目成本,提高编目工作质量,避免书目数据资源的重复建设。2014 年,深圳“图书馆之城”召开馆长联席会议,提出搭建“图书馆之城”联合采编平台,将成员馆的书目数据、采访数据与馆藏数据等整合起来,按照统一模式实施数据的加工、构建和运行管理,要求各成员馆在统一平台上开展联合采编工作。2015 年,深圳“图书馆之城”联合采编平台搭建完成,自同年6 月深圳大学城图书馆首批接入平台,截至2018 年底,深圳“图书馆之城”联合采编平台已经整合了包括深圳图书馆、深圳大学城图书馆(深圳市科技图书馆)等9个区馆、11个成员馆的书目数据(如表1)。中央书目库中书目数据已有近300万条,中文书目数据278万条,占整个中央书目库书目数据总量的92%,这其中又以中文图书书目数据占绝大部分。因此,中文图书书目数据质量的控制工作是深圳“图书馆之城”书目质量管理工作的重中之重,联合采编平台的建立是书目质量控制工作得以开展的基础保障,取消了原有数据批接收模式,按系统权限进行分级控制,建立多种有效机制,堵住了重复数据产生的主要源头。

表1 各区馆加入联合采编平台时间

1.2 发布书目质量控制规范

2016 年底,深圳“图书馆之城”各主要成员馆数据均已全部完成回溯书目数据批导入,中央书目库新增数据主要来源于各成员馆新编数据。由深圳图书馆和深圳市标准技术研究院联合起草的《公共图书馆统一服务书目质量控制规范》(简称《规范》),在两年的时间里,经过多轮专家论证、修改,于2017年11月14日由深圳市市场监督管理局发布,并于2017年12月1日起正式实施。通过《规范》的制订、应用与实施,可以有效控制重复数据和冗余数据产生源头,规范“图书馆之城”各成员馆的编目行为,提高编目数据的质量,降低中央书目库中重复数据和冗余数据比例,最终提升“图书馆之城”统一服务效果与影响力。

1.3 定期进行编目培训,规范编目流程和细则

编目人员的业务素养对中央书目库的书目数据质量有深远影响。编目操作不规范,没有查重或查重不彻底,直接新增数据,就会给中央书目库增加重复书目记录。合库前,各成员馆编目人员参差不齐,部分成员馆没有设置审校岗位,同时,各成员馆均不同程度地将编目业务进行了外包,而书商提供的外包编目人员不固定,很多外包编目人员没有经过系统培训或者培训不到位就上岗编目。为了提升各成员馆编目人员的业务素养,按照《规范》要求,自2015年起,深圳“图书馆之城”的采编协调工作组每年组织举办中文图书编目规范培训班,培训的主要内容包括:中文图书编目规则及实例分析、中文图书编目流程、ULAS 平台介绍等。到2018年底,培训班已成功举办了3期,学员均来自各区馆和书商的编目人员。为了给“图书馆之城”书目建设筛选合格的编目人员,每期学员都需通过严格的编目考核,取得“图书馆之城”编目员资格证书后,才能在联合采编平台中上岗编目。据统计,3期培训班中取得“图书馆之城”编目员资格证书的学员一共有84人(如表2),占参加考核总学员人数的68.3%。

表2 2015~2018年编目培训考核通过情况

1.4 系统提供多次判重机制

书目质量控制光靠人工校验是不够的,加上编目系统软件的某些功能干预可以事半功倍。在各成员馆书目数据批量导入时,系统会根据重点字段进行系统判重进行初次合并,判重的字段有:题名字段、ISBN 号/统一书号、出版年代、页码等。通过匹配以上字段,系统对判重记录进行自动合并,在合库时就可以控制部分重复数据的产生。在联合采编平台中,设置了ISBN 重复提醒功能,即书目数据交送时由系统判定中央书目库是否有ISBN 相同的数据,如有则提示普通审校员只能交送馆藏,不能交送该书目数据。对于ISBN 确有相同的图书(如多卷书),需经高级审校员核实后,由该高级审校员交送。通过系统提供的多次判重机制,在关键环节把关确认,进一步控制了重复书目数据产生源头。

2 回溯清理历史重复数据

在联合采编平台建立起来之后,深圳“图书馆之城”的中心馆——深圳图书馆,专门针对已有重复书目数据开展了集中合并工作。集中合并工作采用时间回溯的方式,已开展了近4 年,目前还在进行中,大概可以分为以下3个阶段。

2.1 初步拟定合并原则,工作间隙清理

集中合并是指组织专门人员使用专门的数据合并程序开展重复书目数据清理工作。实际上,在深圳“图书馆之城”各成员馆书目数据批量导入工作结束后,就专门针对已有重复书目数据开始了重复数据集中合并工作,并初步确立了重复数据合并处理原则:①对照某几个关键字段确认为同一种书的情况下合并,不能确认为同一种书的情况下不合并;②合并以国家图书馆、CRLnet 和CALIS的数据为准;③同年的平精装合并成为一条记录,并增加一条010 字段;④分类号不同的同一种书,增加690 字段并合并;⑤价格不同的同一种书,增加010字段并合并……这些合并原则是重复数据清理工作最初遵循的规范,从2015—2017年,“图书馆之城”采编工作协调组在工作间隙清理重复数据记录大约为14.7万条。

图2 采编协调工作组QQ群

2.2 重复数据处理工作优化,集中清理

在原有合并原则基础上,根据工作中遇到的问题,采编协调工作组召开小组工作会议,集中商讨,调整并细化了合并原则,结合实例形成了《深圳市“图书馆之城”中央书目库重复数据合并操作规范》,对合并流程进行了详细指引,较之前的合并原则更具操作性、更全面细致。由于记录总是存在着细微差异性,在判重字段确定的前提下,合并操作规范中对匹配字段的比对设定了检查原则:忽略全角、半角的输入方式、外文字母的大小写、空格及各种标点符号、各种特殊字符、阿拉伯数字与汉字的对应等(如版本说明205 字段@a 子字段“二版”与“2 版”应视为相同)。另外,合并操作规范中列出了只有3 种情况的重复数据是不需合并的:分卷册著录数据,同一种书的复制品(只有深圳图书馆有这种类型的数据),同一种书的不同版本数据。需合并的数据中,对每一种合并情况及对应的操作步骤都有操作示例。

采编协调工作组还建立了工作群(如图2),对合并操作规范以外遇到的特殊情况,及时在群里讨论决定是否合并、如何合并。

2018 年开始,重复数据清理工作成为采编协调工作组全年的重点工作。据统计,2018 年清理重复数据记录大约为12.7 万条(见图3),接近前3年重复数据清理的总和。

图3 2015~2018年重复数据合并统计

2.3 更新系统合并功能模块,提升合并工作效率

从2015年到2018年底,合并工作可以在两个界面进行操作:联合采编平台的“验收管理”模块(图4)和“图书馆之城”统一平台的“书目双屏合并”模块。这两种渠道都需要操作员将有重复记录的ISBN 号输入到检索框中,通过在操作界面的左右两屏中逐条对比重要字段来判断是否需要进行合并。这两种界面都非常考验工作人员的眼力、耐心,容易引起视觉疲劳,特别是在多卷书的分卷册众多、重复记录多的情况下更需要认真对待。少儿图书这种情况尤其多见——同一个故事系列共用一个ISBN号,一个系列有20-30种书,如果每一种书对应有两条及以上的记录需要合并,通过翻前后记录来对应卷册再核对各字段已经让人眼花,很容易误操作或漏合并,而且系统在频繁翻前后记录的情况下容易“崩溃”。2019 年初,系统部在联合采编系统中新增了“书目查重合并”新模块,提供了数据合并的新界面(如图5),新界面较以往的两种合并界面有以下几个优势:①无需操作员输入ISBN 号;②重要字段通过表格对比列出,更清晰简洁;③多卷书的分卷册可以通过题名和其他字段对比,直接选中然后在左右屏分别显示,不需要一条条翻前后记录;④对于有大学城图书馆的书目数据,保留其记录号的操作较以往更简便。2019 年初,采编协调工作组在部门内部对新界面进行了操作培训,重复数据的清理工作在新界面下继续进行,“书目查重合并”新界面得到了工作组的一致好评,合并工作效率也随之提高。

图4 原查重合并操作界面

图5 升级后的“书目查重合并”界面

3 重复书目数据控制工作成效

3.1 各成员馆书目数据共建共享,编目工作效率大大提升

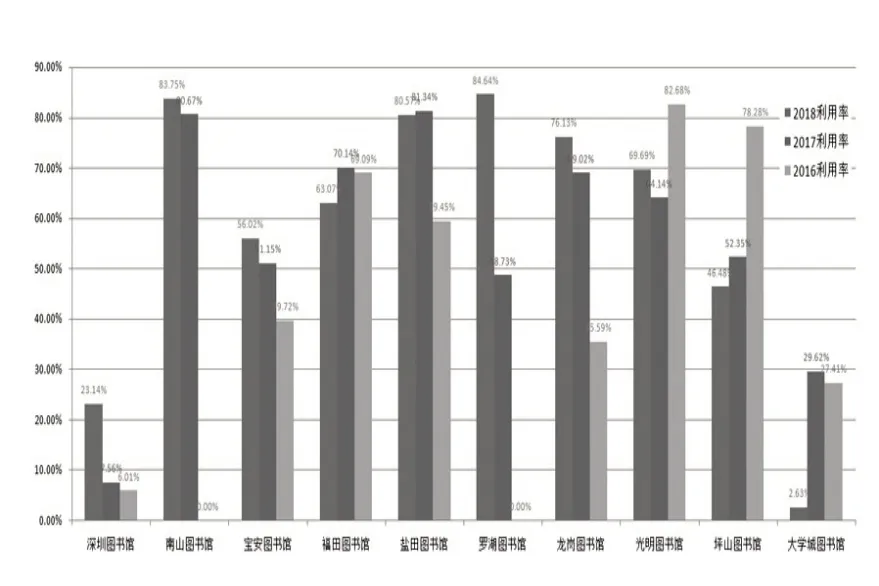

在ULAS 平台下,一家成员馆新增或下载数据,其他馆不用重复编目,直接验收追加馆藏即可,大大减少了重复工作量,提高了各成员馆的工作效率。据统计(见图6),2016~2018年,各成员馆书目数据利用率(只直接追加馆藏的记录条数占总记录条数的比例)平均为60%左右,部分成员馆书目数据利用率为80%以上(南山图书馆、罗湖图书馆、盐田图书馆)。成员馆中,深圳图书馆和大学城图书馆的书目数据利用率较低,这是因为深圳图书馆新书订购到货更早,承担了大部分新书书目数据的制作工作,而大学城图书馆参考的分编库与其他成员馆不同所致。在“图书馆之城”执行持证上岗编目以来,各成员馆提供的书目数据较之前更规范和统一,书目数据质量大大提升,在2018 年,深圳图书馆的书目数据利用率从个位数提升到了23%,相比而言,有4个成员馆(福田图书馆、盐田图书馆、光明图书馆、坪山图书馆)的数据利用率较前两年有一定幅度的降低,在一定程度上说明各成员馆书目数据共建共享的责任意识进一步加强。

图6 2016-2018年成员馆书目数据利用情况

3.2 重复数据产生源头得到有效控制

联合采编平台于2015年搭建完成,并于同年6月深圳大学城图书馆首批加入,至2016 年底有80%的成员馆加入。从表3 中可以看出,2016~2018 年,每年需合并的重复数据总量较以往大大降低了,2017~2018 年,每年只有 400 条左右的重复数据需要清理,数量降低一方面得益于《规范》的制定实施,另一方面也是经过编目培训班学习,编目员业务水平提升、操作更规范的结果,说明重复数据产生的源头得到了有效控制。

3.3 重复数据的总量和占比大大降低

2014 年底第一次统计结果显示,重复数据有42 万条左右,占中央书目库总量(约为251 万)的16.7%,经过近4 年的回溯集中合并处理,截至到2019年3月,重复数据总量为12万左右,占比约为4.4%(中文图书书目数据总量约为270 万),2007~2015年重复记录清理量每年2.5万条左右,一共清理重复记录27.4 万条,历史重复数据的清理工作已初步完成约75%。

表3 2007~2018年重复数据比例

续表3

3.4 OPAC查询体验提升

通过对重复书目数据的合并清理,不仅给中央书目库“减负”,减少了各成员馆编目查重的困扰,也让读者在OPAC 检索有了更好的使用体验(如图7)。相对于合并前的同一本书对应4条检索结果(图1),需要读者一一点开查询馆藏所在进行取舍,合并后,同一本书只有一条检索结果,且所有馆藏分布在一个窗口展示,一目了然,大大节省了读者的操作时间。重复书目数据合并后,OPAC给读者提供了更好的使用体验。

图7 OPAC中重复书目合并后的显示界面

4 结语

在重复书目数据控制工作实践中,我们也发现了一些需要改进的问题,例如错误合并和漏合并的情况不可避免,要提前拟定好对策。深圳“图书馆之城”第一轮重复书目数据回溯清理工作预计在2019年底基本完成,同时,为了防止旧界面清理工作完成的不彻底,同时防止新导入少量书目数据存在重复,在第一轮重复数据清理工作完成后,需要对中央书目库所有未做标记的重复书目数据进行重新统计,再次进行清理维护。

联合书目数据库中重复书目数据控制工作是一个系统工程,需要统筹计划,逐步推进。此项工作涉及业务范围广,远非一个部门能够单独解决,尤其需要计算机技术部门的大力支持和密切配合,深圳“图书馆之城”的书目质量控制工作实践也证明了这一点,系统提供的多次判重功能、模块更新与升级,都对重复书目数据控制工作给予了强力支撑。一个系统功能较好的联编系统与重复书目数据控制工作成效息息相关。重复书目数据控制工作不是一项阶段性工作,而是一项书目数据维护常规工作,应根据实际情况不断地系统调整与策略优化。