基于TV-L1结构纹理分解的图像融合质量评价算法

张斌 罗晓清 张战成

摘 要:为对图像融合算法进行客观准确的综合评价,提出一种基于总变差正则化(TV-L1)结构纹理分解的评价算法。根据对人类视觉系统的研究,可知人们对图像质量的感知主要来自图像底层视觉特征,而结构特征以及纹理特征是最重要的图像底层视觉特征,但目前的图像融合质量评价算法并没有利用这两种特征来进行评价。鉴于此,将图像进行二级结构和纹理分解,根据结构和纹理图像蕴含图像特征的不同,从结构图像和纹理图像两方面分别进行相似度评价,综合各级得分得到最终的评价总得分。然后基于30幅图像的数据集和8种主流融合算法,参照已有的11种客观评价指标,用波达计数法和肯德尔系数检验了该评价指标的一致性,另外在主观评价图像集上验证了该客观评价指标与主观评价的一致性。

关键词:图像融合;融合质量评价;总变差正则化;结构相似度;结构和纹理分解

中图分类号:TP391.41

文献标志码:A

Image fusion quality evaluation algorithm based on TV-L1 structure and texture decomposition

ZHANG Bin1, LUO Xiaoqing1*, ZHANG Zhancheng2

1.School of Internet of Things Engineering, Jiangnan University, Wuxi Jiangsu 214122,China;

2.School of Electronics and Information Engineering, Suzhou University of Science and Technology, Suzhou Jiangsu 215009, China

Abstract:

In order to objectively and accurately evaluate the image fusion algorithms, an evaluation algorithm based on TV-L1 (Total Variation regularization) structure and texture decomposition was proposed. According to the studies on human visual system, humans perception to image quality mainly comes from the underlying visual features of image, and structure features and texture features are the most important features of underlying visual feature of image. However, the existed image fusion quality evaluation algorithms ignore this fact and lead to inaccurate evaluation. To address this problem, a pair of source images and their corresponding fusion results were individually decomposed into structure and texture images with a two-level TV-L1 decomposition. Then, According to the difference of image features between the structure and texture images, the similarity evaluation was carried out from the decomposed structure image and the texture image respectively, and the final evaluation score was obtained by integrating the scores at all levels. Based on the dataset with 30 images and 8 mainstream fusion algorithms, compared with the 11 existing objective evaluation indexes, the Borda counting method and Kendall coefficient were employed to verify the consistency of the proposed evaluation algorithm. Moreover, the consistency between the proposed objective evaluation index and the subjective evaluation is verified on the subjective evaluation image set.

Key words:

image fusion; fusion quality evaluation; total variation regularization; structural similarity; structure and texture decomposition

0 引言

圖像融合是指通过传感器针对不同的场景捕获不同内容的图片,经过整合形成一幅质量更高图像的技术[1]。如何丰富融合图像的信息量和改善图像质量是图像融合的关键技术之一,也是衡量各种融合方法效果的基本准则。采用科学合理、客观公正的方法对融合图像进行评价,对在实际应用中选择融合算法以及现有融合算法的改进和研究新的融合算法等具有十分重要的指导意义。因此,融合质量评价是图像融合技术中不可或缺的核心内容之一[2]。图像融合质量评价方法分为两类:一类是将融合图像交给人眼的进行主观感觉度量的方法。最经典的是曼彻斯特大学的Petrovic[3]教授2007年提出的主观测量方法,通过多个测试者对不同融合方法得到的融合图像中的特定目标进行识别,依据识别时间和识别的正确率,判断图像融合方法的优劣。由于在大部分情况下人是融合图像的直接使用者,所以该方法具有一定的可靠性以及直接性。但是该方法也存在一定的局限性:1)由于人脑的感知图像的机制非常复杂,从而导致人的主观感觉有可能是不一

样的。2)评价成本高。该方法非常耗时耗力,并且效率也比较低。3)受环境的影响比较大,比如观察距离、光照等都会影响人的判断。另一类是通过计算相关指标来定量地模拟人类的视觉系统(Human-Visual-System, HVS)的客观法[4]。该方法通过定量的测量使得融合效果具有较高的客观性,是如今流行的图像融合质量评价方法。从原理上可以把客观法分为三类[5]:

1)基于统计特性的评价指标[5]:文献[6]提到的平均梯度,可以敏感地反映出图像的微小细节反差和纹理变换特征,用来评价图像的相对清晰度,平均梯度越大,图像的层次越多,纹理也就更加清晰;文献[7]中的边缘强度,是指边缘与邻近像素的对比强度,边缘越丰富,融合图像越清晰;文献[8]使用的空间频率,反映的是空间域内图像的总体活跃度。但是上述评价指标无法反映源图像和融合图像之间的依赖程度,而这种依赖程度可以体现融合图像的质量,因此一般不能将上述评价指标单独用于图像融合质量评价。

2)基于信息量的客观指标[5]:文献[9]提到的互信息,它是衡量两个域之间变量的依懒性,用来比较融合图像与源图像之间灰度分布方面的相似情况;文献[10]设計的非线性的信息熵,它和互信息的定义是类似的。但是该类指标没有相应的参数可以调节,适应程度比较差,需要与其他的指标进行综合评价。

3)基于人类感知的评价指标[5]:该指标是基于人类的视觉系统对图像的感知原理来判断融合图像的优劣。其中人眼对图像的边缘信息、结构化信息以及空间频率信息是非常敏感的。

Xydeas和Petrovic认为人类视觉系统对图像的边缘十分敏感[9],提出了通过融合图像保留源图像中边缘信息的完整程度,从而达到评价融合图像的质量。该方法首先用Sobel算子检测出图像的梯度和边缘角用来计算边缘强度和方向信息,然后求和归一化。由于人眼对图像边缘较为敏感,该方法与人眼主观评价具有较高的一致性。同样利用边缘信息的还有Liu等[9]提出的基于双层的哈尔小波变换指标。该方法从小波分解的高阶和带通分量中提取边缘信息。Wang等[11]认为人类视觉系统对图像的失真程度也较为敏感,据此他们提出了通用图像质量评价(Universal Image Quality Index, UIQI)。该指标通过计算源图像和融合图像之间的结构损失、亮度失真、以及对比度相似性,进而作出相应的评价。该指标有效地对源图像和融合图像的结构失真进行计算,评价效果得到了学术界的认可。在Wang的UIQI的基础上,Piella等[12]作出了一定的改进,分别提出了图像融合质量指数Q0、加权融合质量指数Qw、以及边缘相关融合质量指数QE。图像融合质量指数Q0在UIQI的基础上引入了局部窗体,利用局部窗体对图像进行分割。然后计算每个窗体的相似程度。由于Q0对图像的每一区域没有区别对待,而人眼对图像每一块区域感知程度是不同的,所以随后提出了加权融合质量指数Qw,该评价指标对图像中信息丰富的窗体给予较大的权重,而具有较少信息的窗体采用较少的权重,使得该指标取得了较好的效果;由于人眼对图像边缘也比较敏感,将边缘图像引入到Qw中,据此提出了QE边缘相关融合质量指数。视觉研究人员发现人类视觉系统对图像的感知是高度结构化的[13],所以Wang在UIQI的基础上提出了结构相似性(Structural SIMilarity index, SSIM)的客观评价,使得图像质量评价领域从像素阶段上升到了结构阶段。但是对模糊图像评价时效果

不太理想。将结构性引入评价的还有两种基于结构相似矩阵的评价指标,分别是Cvejic指标[14]和Yang指标[15]。Cvejic指标是通过计算源图像与融合图像的协方差来定出加权系数。Yang指标与最后主观结果具有一定的差异性,因为没有考虑到源图像与源图像之间的差异性导致了评价效果不太好。最后根据对比敏感度函数(Contrast Sensitivity Function, CSF)人类视觉系统对图像空间频率的感知程度,据此,Chen等[16]提出了利用CSF来用于评价指标。由于CSF无法捕获非线性的局部信息,所以首先将图片进行分块,然后计算区域的显著度。同样利用CSF方法的还有Chen-Blum指标[17],它是利用该函数得到最后的显著度特征图来计算指标。

根据对人类视觉系统的研究,人们对图像质量感知主要来自于图像底层视觉特征,其中纹理特征是最重要的特征之一[18]。纹理特征产生的位置与图像在人眼视觉系统中产生的区域是一样的,此外纹理特征还有比较好的表征图像质量感知的能力。图像的结构特征是整张图像的轮廓[19],人眼对轮廓也有着较高的辨识度,所以结构特征也是一个比较重要的特征。但是上述指标并没有对图像的纹理特征和结构特征进行单独评价。目前在结构纹理分解的研究领域中总变差正则化(Total Variation regularization, TV-L1)[20-21]的表现是最好的,并且在2014年Fang等发表的文章的中就已经将图像的TV-L1分解的结构和纹理作为重要的特征用在了图像分类上,并取得了较好的效果。受此启发,本文提出基于TV-L1结构纹理分解的图像融合质量评价方法。鉴于纹理特征和结构特征在实际图像中所占的比例不同,而在TV-L1结构纹理分解中的系数λ恰好可以调节纹理特征和结构特征的权重,所以本文算法能够准确地评价融合图像的质量。

1 客观评价方法

1.1 TV-L1多级分解

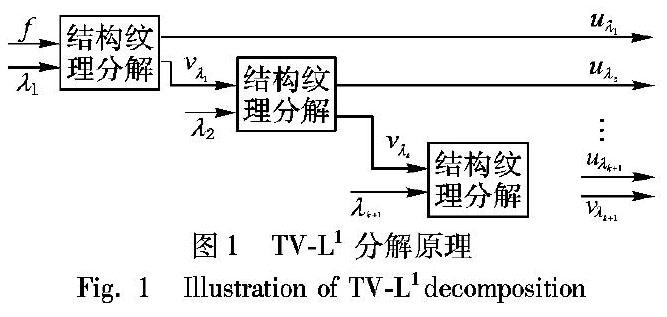

TV-L1分解[21]是将一幅图像多级分解为纹理图像和结构图像的方法。分解原理如图1所示。首先将原图像f分解为结构图像uλ1和纹理图像vλ1,有f= uλ1+vλ1 ,即结构图像和纹理图像合并就是原图像,参数λ1调节结构和纹理比例。接着保留结构图像,继续将刚刚分解的纹理图像用系数λ2进行结构纹理分解,得到第二级的结构图像uλ2和纹理图像vλ2。此后不断地如此分解,最后vλk=uλk+1+ vλk+1,也就是上一级的纹理图像被分解为下一级的结构图像和纹理图像。

1.2 λ参数对分解图像的影响

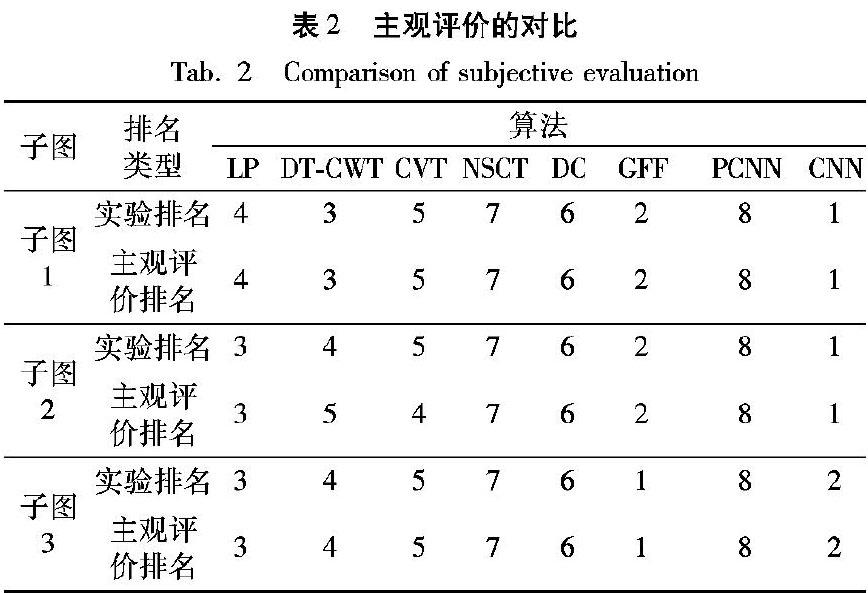

分解系数λ调节纹理图像和结构图像的权重在TV-L1分解中有重要的意义。以一幅用不同参数λ分解的多聚焦图像为例。如图2所示,第一行为两张源图像和一张融合图像,下面三行左边两列是对融合图像(c图)的一级分解图像,右边两列是二级分解图像。

从图2中可以看到随着系数λ不断地增大,结构图像越来越清晰,纹理图像会逐渐模糊。不同场景的融合图像都有类似的效果,这将在2.2节中详细讨论。

1.3 结构纹理分解评价指标构造

假设A、B分别是针对同一场景但是由不同传感器获得的图像,F表示图像A和B的融合图像。本文具体构造流程如图3所示。

本文的创新点是将融合图像质量评价与人类视觉感知中的视觉信息分离和整合理论结合起来,即人眼分别通过图像的纹理信息和结构信息感知图像,然后再将两种信息结合作出综合的评价。另外图像可以分解为结构信息和纹理信息,且在特定尺度下,纹理信息包含着重要的结构信息,所以为了将图像分解得更加细致,将一级分解的纹理图像继续分解得到二级的纹理图像和结构图像。

1.2节介绍到,随着系数λ不断地增大,结构图像越来越清晰,纹理图像会逐渐模糊,而当系数为0.8时,纹理图像已经非常模糊,所以把系数设置在[0,1]。由于设置的初始权重

较小,且纹理信息总是包含着重要的结构信息,即纹理图像的权重要大于结构图像的权重,所以把初始分解系数λ分配为结构图像,而纹理图像的权重为1-λ。二级分解也是如此。

由于本文的纹理信息包含着大量的结构信息,而结构信息中有着丰富的边缘信息,所以本文采用基于边缘信息的客观指标(QG)来计算融合得分,因为该指标是通过评估从源图像到融合图像的边缘信息转移量来衡量图像融合质量。该指标的计算公式为:

QG=∑Nn=1∑Mm=1[QAFwA(i, j)+QBFwB(i, j)]∑Nn=1∑Mm=1[wA(i, j)+wB(i, j)](1)

其中:QAF和QBF分别是源图像A与源图像B分别与融合图像F边缘宽度与方向的相似度;wA(i, j),wB(i, j)分别是QAF和QBF的权重。

构造的步骤如下:

步骤1 分别将源图像A、B和融合图像F用系数λ进行分解,分别得到结构图像SA1、SB1、SF1以及得到纹理图像DA1、DB1、DF1。将1-λ作为纹理图像的权重。

步骤2 对三幅纹理图像用相同系数λ继续分别将DA1、DB1、DF1分解,得到结构图像SA2、SB2、SF2 以及三幅纹理图像DA2、DB2、DF2。三幅二级结构图像SA2、SB2、SF2的权重系数为λ(1-λ),三幅二级纹理图像DA2、DB2、DF2的权重为(1-λ)2。此时,可看出(用源图像A举例):

DA1=DA2+SA2(2)

所以可以得出:

1-λ=λ(1-λ)+(1-λ)2(3)

步骤3 最后分别用边缘梯度指标QG指标计算DA2、DB2、DF2的融合分数Score3,接着算出SA2、SB2、SF2的融合得分Score2,最后计算一级分解的结构图像SA1、SB1、SF1的相似度Score1。

此时,可得出(以图像A为例):

fA=SA1+DA2+SA2(4)

步驟4 计算出最终融合分数:

Score=Score1*λ+[Score2*λ*(1-λ)+Score3*(1-λ)2](5)

2 实验结果与分析

在本文中,将采用拉普拉斯金字塔融合(Laplacian Pyramid fusion, LP)[22]、双树复小波变换融合(DualTree Complex Wavelet Transform fusion, DTCWT)[23]、曲波变换融合(CurVelet Transform fusion, CVT)[23]、非下采样轮廓波变换融合(NonSubsampling Contour wave Transform fusion, NSCT)[23]、对比度的图像融合(Directive Contrast fusion, DC)[24]、导向滤波融合(Guided Filter Fusion, GFF)[25]、脉冲耦合神经网络融合(Pulse Coupled Neural Network fusion, PCNN)[26]、卷积神经网络融合(Convolutional Neural Network fusion, CNN)[27]等8种常用的融合方法进行评价实验。

实验图像集涵盖3类图像融合类型:多聚焦图像融合、医学图像融合和红外可见光图像融合。每一类图像包含10组测试数据。这3种类型已经包括了图像融合在现实应用中的典型情况,从而有效验证融合算法的客观指标。

2.1 实验设置

步骤1 引入波达计数法[9],其中选取了引言中提及的11种经典评价指标来做测试。11种融合指标排列成11行,8个融合算法排成8列,这样就组成了11行8列的矩阵。然后利用每种融合指标对8种融合算法进行评价,根据8种融合算法的分数得出排名。这样每一行就对应着8种融合算法排名。每一列就是每种算法在11个评价指标中的各自排名。最后在每一列上采用波达计数法来对每种融合算法根据融合指标排名作出综合的排名。采用的波达计数规则为:排名最高的权重为1,排名第二高的权重为1/2,依此类推,排名11位的权重为1/11。根据此规则对这8种融合算法得出最终的排名序列a。如表1所示,以3种算法、3个指标为例,这个例子里面:方法1最好,方法2次之,方法3最差。

步骤2 用1.3节中的算法分别对上述的8种融合方法进行计算融合分数,根据融合的分数高低,得到8种融合方法的排名序列b。例如,第一步中的方法1、2、3在此算法中,排名序列b是1、2、3。

步骤3 使用肯德尔系数来测试排名序列a和排名序列b的相关性[9]。例如:根据上两步例子中的排名序列a和排名序列b,得出肯德尔系数的结果为1。

2.2 λ参数选择

在TV-L1结构纹理分解算法中,如何选择合适的参数λ是一个重要的问题。鉴于纹理信息包含着大量的结构信息,所以本文将系数λ设为 0.2、0.3、0.4开展实验,使得纹理特征权重始终大于结构特征的权重。对于多聚焦图像而言,人眼一般会更加专注于图像纹理,据此将多聚焦图像的λ调为0.2。对于医学图像来说,医生在关注图像纹理特征的同时,也会比较关注结构特征。例如,医生会依据结构特征来判断病灶的边界,以此来判断病灶是否侵入其他的器官,所以将医学图像的λ设计为0.4。对于红外可见光图像而言,把系数设置为0.2。如军人会缜密地分析融合图像每个位置的细节,从而作出对应的行动方案。每类图像中挑选一幅来显示分解结果。由于篇幅有限,只显示融合图像、融合图像一级分解结构图像以及二级分解纹理图像。

从图4的多聚焦图像和红外可见光图像可以看出:λ=0.2时分解的图像中纹理比较清晰,结构相对模糊。多聚焦图像中的字迹依然比较清晰以及红外可见光图像中的森林和草地的细节也比较清晰。而对于医学图像,λ=0.4分解得出的结构特征是相对明显的,可以清晰地观察到相关结构的边缘。

据此,将分解医学图像的系数设置为0.4,将红外可见光图像和多聚焦图像的分解系数设置为0.2进行实验测试。然后对3类图像用相对应的系数分解,将分解的图像按照1.3节的算法计算出8种融合分数,得出2.1节的排名序列b。再用波达计数法得出排名系列a,最后利用肯德尔算法计算

两种数列的肯德尔系数。最后的结果如图5所示,横坐标表示数据集序号,纵坐标表示肯德尔系数。

根据肯德尔系数的定义,如果实验的相关系数值在50%以上,就表明测试的两个变量线性相关性较好。从图5中可看出,实验所测试的3类图像实验的肯德尔系数都在50%以上,其中3类图片的肯德尔系数大部分达到了70%左右。对于红外可见光图像而言,系数甚至达到了80%以上,而医学图像的肯德尔系数达到了90%以上。所以客观实验结果验证了本文的融合指标与其他主流的客观指标有比较高的关联度,从而证明了此评价算法具有较高的可靠性。

但是从图5也可以看出,对于同一类图像的肯德尔系数大小差距有点大,例如医学图像的肯德尔系数在50%~100%,红外可见光的图像在50%~90%。肯德尔系数之所以有较大的差别,是由于不同图像包含的纹理信息以及结构信息的内容不一样导致的。例如:以在红外可见光图像总体表现最好的CNN算法为来说明肯德尔系数的表现,如图6所示,每行是一组融合原图像及其一级结构和纹理分解图像。

因为将红外可见光图像分解的系数设为0.2,对应的分解图像为结构信息较少,而纹理信息较多。图6(b)的第一行结构图像中依然有大量的树叶边缘,说明结构信息较多;图6 中第二行显然是含有结构特征较多、纹理特征较少的图像。所以这两行图像的肯德尔系数是较低的;而对于图6(c)的第三行和第四行可以观察到,图像中树枝和草地占据了图像的大部分区域,说明纹理特征是较多的,含有的结构特征是比较少的,所以这两幅图像的肯德尔系数表现得很好。医学图像和多聚焦图像的肯德尔系数也有类似的表现。

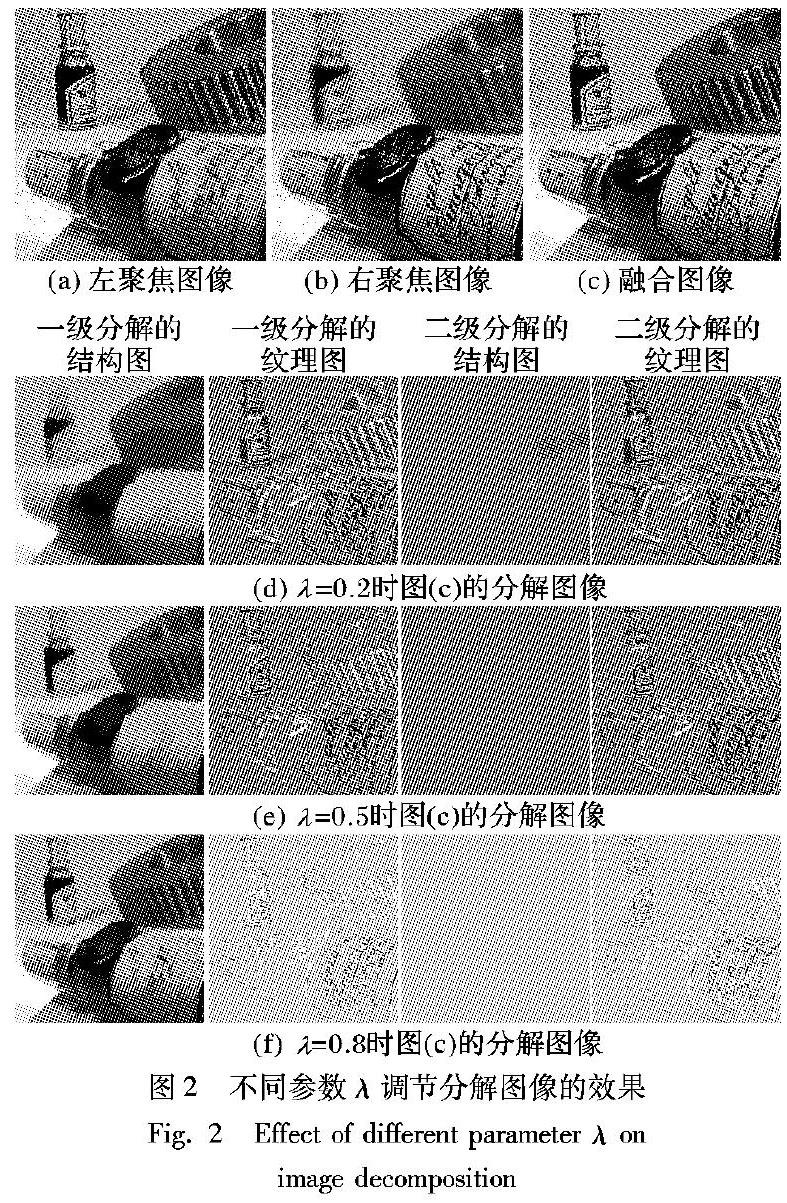

2.3 对比主观评价

为了进一步验证本文算法的正確性,对每类图像中的3幅图片作了小范围的主观评价。按照国际标准ITU-R的规定,邀请了20位同学来作主观评价(其中包括10位方向为图像质量评价的同学,10位研究方向为其他方向的同学,其中包括4位为江南大学医学院的同学主要评价医学图像)。评价前对研究其他方向同学讲清楚主观评价目的、实验过程、评价指标的定义等。最后每位在规定的相同时间,且在相同环境下作出相应的投票,表2是图4中3类图像(多聚焦图像为子图1、医学图像为子图2、红外可见光图像为子图3)的主观评价与本文的实验排名结果。

由于篇幅有限,将每幅融合图像分数最高的和得分最低的以及与图像2中与主观排名不一致的图像用图7展示:图7中(a)和(b)是多聚焦图像表现最好和最差的算法图像;(c)和(d)属于红外可见光图像效果最好和最差算法图像;(e)和(f)图是医学图像表现最好与最坏的图像;(g)与(h)是医学图像与主观评价不一致的两幅图像。

从表2可以看出本文评价指标和主观评价指标是非常吻合的:从图7中观察到得分最高的融合方法比最低的融合方法效果明显要好。虽然图像2中DTCWT算法和CVT算法主观排名与本文指标不一致,但是从图7中可以看到这两种融合图像丢失信息的程度差不多,难以判断哪个较好。其他的对比的几组图像与这3组图像的效果类似,据此说明本文的评价指标可以比较客观地评价各种融合效果。

3 结语

针对传统图像融合评价评价未考虑图像结构和纹理内在的区别的问题,本文提出了一种基于TV-L1结构和纹理分解的客观评价指标。该算法利用人们对图像质量感知主要来自于图像底层视觉特征的特点,并且依据TV-L1中分解系数的作用,将图像二级分解为结构图像和纹理图像,在结构图像和纹理图像上根据结构相似性分别设计融合评价指标,最后将各级的分解图像得出的相似性综合起来得出最终的相似性。结合已有11种客观指标和8种图像融合算法,基于波达计数法和肯德尔系数进行了30组图像的客观评价实验,实验表明本文所提融合评价算法能够比较客观地评价图像融合的质量。但本文只是将图像进行了二级分解,未将图像进行更加多级的分解,下一步将进行更加多级的分解实验,来观察是否随着分解级数的增加,算法的可靠性更高。

参考文献

[1]HASSEN R, WANG Z, SALAMA M M A. Objective quality assessment for multiexposure multi-focus image fusion [J]. IEEE Transactions on Image Processing, 2015, 24(9): 2712-2724.

[2]MALVIYA A, BHIRUD S G. Objective criterion for performance evaluation of image fusion techniques [J]. International Journal of Computer Applications, 2010, 1(25): 57-60.

[3]PETROVIC V. Subjective tests for image fusion evaluation and objective metric validation [J]. Information Fusion, 2007, 8(2): 208-216.

[4]張小利,李雄飞,李军.融合图像质量评价指标的相关性分析及性能评估[J]. 自动化学报,2014,40(2):306-315.(ZHANG X L, LI X F, LI J. Validation and correlation analysis of metrics for evaluating performance of image fusion [J]. Acta Automatica Sinica, 2014, 40(2): 306-315.)

[5]TIRUPAL T, MOHAN B C, KUMAR S S. Multimodal medical image fusion based on Yagers intuitionistic fuzzy sets [J]. Iranian Journal of Fuzzy Systems, 2019, 16(1): 33-48.

[6]ZHANG X, FENG X, WANG W. et al. Edge strength similarity for image quality assessment [J]. IEEE Signal Processing Letters, 2013, 20(4): 319-322.

[7]SHAH P, MERCHANT S N, DESAI U B. Multifocus and multispectral image fusion based on pixel significance using multiresolution decomposition [J]. Signal, Image and Video Processing, 2013, 7(1): 95-109.

[8]HOSSNY M, NAHAVANDI S, CREIGHTON D. Comments on ‘Information measure for performance of image fusion [J]. Electronics Letters, 2008, 44(18): 1066-1067.

[9]LIU Z, BLASCH E, XUE Z, et al. Objective assessment of multiresolution image fusion algorithms for context enhancement in night vision: a comparative study [J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2012, 34(1): 94-109.

[10]CVEJIC N, CANAGARAJAH C N, BULL D R. Image fusion metric based on mutual information and tsallis entropy [J]. Electronics Letters, 2006, 42(11): 626-627.

[11]WANG Z, BOVIK A C, SHEIKH H R. et al. Image quality assessment: from error visibility to structural similarity [J]. IEEE Transactions on Image Processing, 2004, 13(4): 600-612.

[12]PIELLA G, HEIJMANS H. A new quality metric for image fusion [C]// Proceedings of the 2003 International Conference on Image Processing. Piscataway, NJ: IEEE, 2003:173-176.

[13]PISTONESI S, MARTINEZ J, OJEDA S M, et al. Structural similarity metrics for quality image fusion assessment: algorithms [J]. Image Processing on Line, 2018, 8: 345-368.

[14]CHEN H, VARSHNEY P K. A human perception inspired quality metric for image fusion based on regional information [J]. Information Fusion, 2007, 8(2): 193-207.

[15]LI S, HONG R, WU X, et al. A noval similarity based quality metric for image fusion [C]// Proceeding of the 2008 International Conference on Audio, Language and Image Processing. Piscataway, NJ: IEEE, 2008: 167-172.

[16]CHEN H, VARSHENEY P K. A human perception inspired quality metric for image fusion based on regional information [J]. Image Fusion, 2007, 8(2): 193-207.

[17]CHEN Y. BLUM R S. A new automated quality assessment algorithm for image fusion [J]. Image and Vision Computing, 2009, 27(10): 1421-1432.

[18]程剛,王春恒.基于结构和纹理特征融合的场景图像分类[J].计算机工程,2011,37(5):227-229.(CHENG G, WANG C H. Scene image categorization based on structure and texture feature fusion [J]. Computer Engineering, 2011, 37(5): 227-229.)

[19]FANG Y, CHEN Q, SUN L, et al. Decomposition and extraction: a new framework for visual classification [J]. IEEE Transactions on Image Processing A Publication of the IEEE Signal Processing Society, 2014, 23(8): 3412-3427.

[20]WANG Z, WANG W, SU B. Multi-sensor image fusion algorithm based on multiresolution analysis [J]. International Journal of Online Engineering, 2018, 14(6): 44-57.

[21]BEHRMANN M, KIMCHI R. What does visual agnosia tell us about perceptual organization and its relationship to object perception? [J]. Journal of Experimental Psychology: Human Perception and Performance, 2003, 29(1): 19-42.

[22]陈浩,王延杰.基于拉普拉斯金字塔变换的图像融合算法研究[J].激光与红外,2009,39(4):439-442.(CHEN H, WANG Y J. Research on image fusion algorithm based on Laplacian pyramid transform [J]. Laser and Infrared, 2009, 39(4):439-442.)

[23]LIU Y, LIU S. WANG Z. A general framework for image fusion based on multi-scale transform and sparse representation [J]. Information Fusion, 2015, 24: 147-164.

[24]BHATNAGAR G, WU Q M J, LIU Z. Directive contrast based multimodal medical image fusion in NSCT domain [J]. IEEE Transactions on Multimedia, 2013, 15(5): 1014-1024.

[25]LI S, KANG X, HU J. Image fusion with guided filtering [J]. IEEE Transactions on Image Processing, 2013, 22(7): 2864-2875.

[26]屈小波,闫敬文,肖弘智,等.非降采样Contourlet域内空间频率激励的PCNN图像融合算法[J].自动化学报,2008,34(12):1508-1514.(QU X B, YAN J W, XIAO H Z, et al. Image fusion algorithm based on spatial frequency-motivated pulse coupled neural networks in nonsubsampled Contourlet transform domain [J]. Acta Automatica Sinica, 2008, 34(12): 1508-1514.)

[27]LIU Y, CHEN X, WANG Z, et al. Deep learning for pixel-level image fusion recent: advances and future prospects [J]. Information Fusion, 2018, 42: 158-173.

This work is partially supported by the National Natural Science Foundation of China (61772237), the Fundamental Research Funds for the Central Universities (JUSRP51618B), the Technological Innovation Projects of Major Industries in Suzhou City (SYG201702).

ZHANG Bin, born in 1994, M. S. candidate. His research interests include image fusion.

LUO Xiaoqing, born in 1980, Ph. D., association professor. Her research interests include image fusion, medical image analysis.

ZHANG Zhancheng, born in 1977, Ph. D., association professor. His research interests include image fusion, medical image analysis.