多波束卫星动态信道资源分配算法

刘召 许珂

【摘 要】多波束卫星移动通信系统通过频率复用技术提升了频谱效率,但由于波束间通信业务量分布具有非均匀特性,导致资源利用率较低。针对以上问题,结合强化学习技术,研究设计能够避免同频干扰的动态资源分配算法,结果表明,该算法大大降低了系统阻塞概率,信道资源得到进一步有效利用。

【关键词】强化学习;信道资源分配;Q-learning

中图分类号:TN510.50

文献标志码:A 文章编号:1006-1010(2019)05-0027-06

1 引言

卫星移动通信系统经历了全球波束、区波束到多点波束的发展历程,通过多波束间频率及资源动态灵活配置,可进一步提升卫星移动通信系统性能[1]。在多波束卫星移动通信系统中,每颗卫星携带多个波束,分别覆盖地面不同区域,这些波束合起来共同完成单颗卫星的地面可视区域覆盖。卫星移动通信系统覆盖范围较广,尤其是高轨卫星,有些波束区域可能覆盖极地、沙漠等终端用户较少的区域,而有些波束则覆盖在城市、村庄等卫星终端用户较多的地区,如图1所示。

由于卫星终端在地理空间上分布不均匀,使得卫星移动通信系统波束间的通信业务量差异较大,信道资源需求量不同。若采用固定频谱分配方式,即使该波束内的用户没有使用该资源,其他波束用户也不能使用该资源,容易造成信道资源的浪费[2]。

对动态资源分配方式而言,所有的信道资源均可以被各个波束用户所使用,根据各个波束的业务请求用户数进行资源的分配,相比于固定频谱分配方式,具有较高的资源利用率优势。然而,由于每个波束用户均可以使用所有的信道资源,在资源分配的过程可能会将同一个信道分配给距离较近的用户,进而产生干扰,影响系统通信服务质量。因此,在设计动态资源分配方案时应考虑用户的信道增益信息,避免同频干扰的影响。另一方面,作为机器学习的一种,强化学习旨在智能体与环境的交互中,通过环境的反馈而提升自身决策能力[3]。因此可以结合强化学习技术,通过卫星与当前通信环境进行交互,获得信道的增益等状态信息,根据各波束用户的业务请求实现卫星系统资源的动态分配,提高系统通信服务性能[4]。

2 基于Q-learning的动态资源分配算法

强化学习的思想来自于条件反射理论和动物学习理论,它是受到动物学习过程启发而得到的一种仿生算法。智能体(Agent)通过对感知到的环境状态采取各种试探动作,获得环境状态的回馈奖赏值,从而修改自身的动作策略以获得较大的奖励或较小的惩罚,强化学习就是这样一种赋予Agent学习自适应性能力的方法[5]。强化学习算法的基本模型框图如图2所示:

图2表示了智能体与环境交互的过程,为了方便表述,通常会将强化学习问题建模为一组马尔科夫决策过程(MDP, Markov Decision Process),所以强化学习着重研究在转移概率和奖赏函数未知的情况下,系统如何学习最优策略[6]。具体而言,智能体在时刻t通过对环境的观测以获得对环境的抽象表达即状态St∈S,然后智能体基于优化目标策略,并根据当前状态St选择执行动作at∈A(St),进而环境发生变化时以概率p(St+1|St,St,at)进入下一个状态St+1∈S,同时从环境中获得立即收益rt+1∈R。

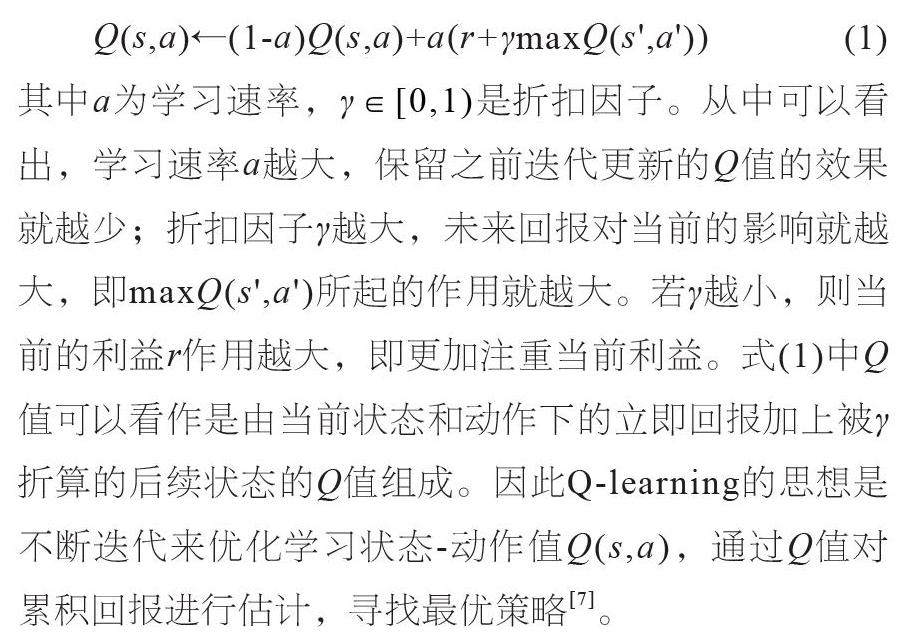

Q-learning是强化学习中一种经典的无模型学习算法,它利用状态-动作值函数Q(s,a)带入Bellman公式(式(1))中进行迭代更新,利用奖赏函数r作为估计来选择下一步动作并优化状态-动作值函数。

其中a为学习速率,γ∈[0,1)是折扣因子。从中可以看出,学习速率a越大,保留之前迭代更新的Q值的效果就越少;折扣因子γ越大,未来回报对当前的影响就越大,即maxQ(s',a')所起的作用就越大。若γ越小,则当前的利益r作用越大,即更加注重当前利益。式(1)中Q值可以看作是由当前状态和动作下的立即回报加上被γ折算的后续状态的Q值组成。因此Q-learning的思想是不断迭代来优化学习状态-动作值Q(s,a),通过Q值对累积回报进行估计,寻找最优策略[7]。

考虑到每个业务请求时刻下,各个小区的用户业务请求数量不同,信道资源分配不均的问题,本文提出基于Q-learning的动态资源分配算法,该算法根据每时刻下波束对信道资源需求量不同,实现一种能够使卫星移动系统的总体性能达到最优的信道资源分配方案,并且在信道资源分配过程中,考虑到同频干扰的影响,避免将同一信道资源分配给复用距离之内的用户或波束。进一步地,对动态资源分配问题进行分析,将其转化为强化学习中智能体与环境交互过程中的一组马尔科夫决策过程。把卫星看做Agent,本文以地球同步轨道卫星为例,将当前业务请求时刻下的各个波束业务请求用户数量和波束对信道占用的初始状态映射为环境,在每个业务请求时刻下,根据智能体所处的环境,利用Q-learning算法来观测环境状态和获取环境的奖励信号,学习状态-动作值函数,逐步改变信道资源分配策略,完成卫星系统的动态信道资源分配。其动态资源分配模型如图3所示:

在图3中,Q值表完成从环境状态到相应动作Q值的映射,Agent根据Q值表采用ε-greedy方法选择动作,进一步地,Agent观测当前环境的状态,再利用获得的环境奖励信号根据式(1)进行Q值表的更新。

由于本文所提的動态资源分配算法采用的是Q-learning算法,该方法是基于时间差分(TD, Temporal Difference)无模型的强化学习方法,不需要对MDP过程中的状态转移概率进行建模,但需要对相应动态资源分配优化问题中的状态、动作和收益等基本要素进行定义。

2.1 状态空间

状态是对环境形式化的抽象,同时也是确定所执行动作的依据。卫星通信系统通过星载多波束发射机在地面上形成N个波束,由B={n|n=1,2…,N}表示。系统中可用的信道集合由C={m|m=1,2…,M}表示,其中每个信道资源正交且互不重叠,大小为Csubc=Ctotc/M,Ctotc表示系统总共可用的信道资源。波束n的信道资源分配状态可以用矢量wn标识,记为wn=[wn,1,wn,2,…,

wn,M]T,其中每一项wn,m∈{0,1}表示波束n对子信道m的占用情况,1表示占用,0表示空闲未占用。则卫星系统中所有波束的信道分配向量构成了卫星系统总的信道分配矩阵,表示为W=[w1,w2,…,wN]。

为了缩小状态空间,加快学习速率,考虑到在进行动态资源分配时,需要避免或者抑制同频干扰的影响,可以从环境W矩阵中抽象出的状态为当前各个波束可用的信道资源矩阵V=[v1,v2,…,vN],其中vn=[vn,1,vn,2,…,vn,M]T,表示每个波束可用的信道资源情况,在进行状态转移时已经将同频干扰的影响考虑在内,vn矢量中的每个元素取值及所代表的意义如式(2)所示:

假设相邻小区不能使用同一信道资源,当波束a占m号信道资源后,则在可用信道资源矩阵V中,波束a对于m号信道资源取值为1,其相邻波束对于m号信道资源的情况取值为-1,即表示该信道资源不可用,从而也避免同频干扰的存在。为此,该Q-learning算法中的状态可以定义为式(3):

如式(3)所示,状态空间中不同状态由可用信道资源矩阵表示,对于所有的波束而言,当前没有可用的信道资源或所有波束下用户均有资源可用时,则到达终止状态。当未达到终止状态时,智能体可以根据当前状态中可用的信道资源进行动态资源分配动作的选取。

2.2 动作空间

动作是智能体对环境的输出,在本文所提算法中,即将可用的信道资源分配给业务请求的用户。根据智能体所处的环境和状态,动作选择的依据是从可行动作集合A(st)中依概率ε选择具有最大Q值的动作去执行。为此,首先需要确定既定状态st下的可行动作集合A(st)。在本方案中,每个状态下可行的动作集合为各个波束可用的信道的集合,基于此,将动作at定义为式(4):

该动作at表示在状态st下可用的信道资源集合(即状态st中取值为0的元素集合)中,选取波束n,为其分配信道资源m。通过不同状态下根据Q-learning中策略选取不同动作,将卫星系统中可用的信道资源分配给各个波束。

2.3 回馈奖赏

收益是智能体与环境交互过程中来自环境的反馈,是对在确定状态下选取动作后的评价,也是衡量动态资源分配算法性能优劣的指标。为了计算方便,可以将奖赏函数设计为与系统性能正相关的标量值,我们以系统阻塞概率来衡量系统性能,即优化目标是系统的阻塞用户数量最小,考虑到每业务请求时刻下,根据各波束业务请求用户量学习出一种信道资源最优分配方式,则设计的奖赏应与终止状态时的系统性能有关,故在智能体每达到终止状态后给一个最终奖励,如式(5)所示:

式(5)中Rmax表示的最大的奖赏值,为一标量正值;Ublock表示当前系统阻塞用户数,Uall表示系统中总共请求业务的用户数。从式(5)中可以看出,系统中阻塞用户数越少,获得的奖励越多,则系统的总体效用性能也越高。因为智能体更加注重到达最终状态时的奖励,故可以将在状态转移过程的立即奖赏设置为0。

基于上文所述的環境、状态、动作和奖赏的定义,本文所提的基于Q-learning动态资源分配算法的具体实现如下所示:

初始化卫星系统相关参数,V=,W=;

初始化Q-learning算法中相关参数,给定学习速率a,折扣因子γ,初始探索概率εinit;

初始化Q(s, a);

For t=1, T个业务请求时刻;

更新

Q(s, a), s∈S,a∈A(s),给定探索概率ε=εinit;

初始化该时刻下智能体所处的环境,Vt←Vt-1,Wt←Wt-1;

For every episode

给定初始状态s0=Vt;

更新探索概率ε=max(ε-εgap,εf);

Repeat

根据状态si计算可行的动作集合A(si);

在状态si下以ε概率随机选择动作ai∈A(si);

否则选择ai=argmaxaQ(si ,a);

执行动作ai改变环境Vt、Wt,并获取下一状态si+1和奖赏回报ri;

更新Q值表;

Q(si ,ai)←Q(si ,ai)+α(ri +γmaxQ(si ,a)-Q(si ,ai));

s=si;

Until s是终止状态;

End For

输出最终策略π(S)=argmaxaQ(s ,a)

和最终信道分配结果Wt;

相关性能统计。

算法流程中的动作选择策略采用ε贪婪策略,即以概率ε∈[0,1]随机进行动作选择,否则选择具有最大Q值的动作并执行,如此可避免陷入局部最优,探寻可行的全局最优方案。为了加速收敛,对探索概率ε采用线性下降准则,衰减因子记为εgap,以从初始的探索概率εinit衰减到最终的探索概率εf。

3 仿真结果与分析

为了更好地验证所提算法的性能,我们在matlab仿真平台上进行了验证,选取了不同业务分布下作为仿真场景,并与固定的频率复用信道分配(FCA, Fixed Channel Allocation)算法进行了对比。结果表明,所提出的基于Q-learning的动态资源分配算法(Q-learning DCA)在多种场景下可以达到较低的阻塞概率。

仿真中将多波束卫星假定为7个波束,业务到达模型服从参数为λ的泊松分布,业务持续时长服从参数为μ的负指数分布,具体的仿真参数配置如表1所示:

仿真中用于对比的算法为FCA算法,即传统的频率复用方案,该算法中系统将可用的信道固定划分为几个子集,每个波束从划分子集中选择一个集合作为可用的信道分配集,本次仿真中取FR=4。

3.1 波束间业务量均匀分布情形

本场景下每波束的业务到达率相同,业务持续时间恒定为μ=3个业务时刻,图4所示的为两种算法在不同业务到达率λ(个/业务时刻)下的系统阻塞概率性能:

如图4所示,阻塞率随着业务到达率的增加而变大,这主要是因为随着业务的增加,由于可用的信道数是固定的,会有更多的业务因无法获得服务而被阻塞。相同业务到达率下,所提的Q-learning DCA算法相比FCA算法可实现更低阻塞率。如在业务到达率λ=80时,FCA和Q-learning DCA两种算法的阻塞率分别为0.321和0.157。同时,在系统阻塞率性能为0.10时,FCA和Q-learning DCA两种算法的可承载业务量分别为λ=40和λ=68,也就是说,所提的Q-learning DCA算法相比于FCA算法,可提升约0.7倍的负载承载量。

3.2 波束間业务量非均匀分布情形

本场景下波束间业务非均匀分布,业务持续时长恒定为μ=3。图5为两种算法在不同业务平均到达率λ-下的系统阻塞率性能:

如图5所示,系统阻塞率随着业务平均到达率λ-的增加而变大,该仿真结果及原因与图4基本相同。而进一步通过对比图5和图4,可发现FCA算法的系统阻塞率在非均匀分布情形下明显高于均匀情形。作为对比,Q-learning DCA算法在均匀与非均匀业务情况下,阻塞率性能基本保持不变。此外,在系统阻塞率值表为0.10时,FCA和Q-learning DCA算法可承载业务量分别为λ-=35和λ-=66。也就是说,Q-learning DCA算法相比于FCA而言可提升0.9倍左右的业务承载量。

3.3 算法收敛性能分析

根据上述不同场景下的性能分析,可以看出所提出的Q-learning DCA算法相比于传统的FCA算法均有较大性能提升。图6给出了所提算法在学习过程中的收敛效果。从图中可以看出,在智能体学习过程中,Q-learning DCA算法大约在9 000次时性能趋于稳定。

4 结束语

本文基于强化学习算法,提出了基于Q-learning的单颗多波束卫星的动态信道资源分配算法,给出了详细的算法设计,最后通过仿真表明,该算法可降低卫星系统阻塞率,提升系统信道资源利用率。

参考文献:

[1] Vasavada Y, Gopal R, Ravishankar C, et al. Architectures for next generation high throughput satellite systems[J]. International Journal of Satellite Communications and Networking, 2016,34(4): 523-546.

[2] 杨澄雄,徐智超. 多波束卫星通信系统资源的动态分配研究[J]. 信息通信, 2015(5): 209.

[3] 焦李成,赵进,杨淑媛,等. 深度学习、优化与识别[M]. 北京: 清华大学出版社, 2017: 197-208.

[4] Xu Z, Wang Y, Tang J, et al. A deep reinforcement learning based framework for power-efficient resource allocation in cloud RANs[C]//IEEE International Conference on Communications. IEEE, 2017.

[5] R Sutton, A Barto. Reinforcement Learning: an Introduction(second edition)[M]. 2017: 1-7.

[6] Santos E C. A Simple Reinforcement Learning Mechanism for Resource Allocation in LTE-A Networks with Markov Decision Process and Q-Learning[J]. 2017.

[7] 周志华. 机器学习[M]. 北京: 清华大学出版社, 2016: 371-397.

[8] Mengmeng C, Weina H. A printed quadrifilar-helical antenna for Ku-band mobile satellite communication terminal[C]//2017 IEEE 17th International Conference on Communication Technology (ICCT). IEEE, 2017: 755-759.

[9] Wang X, Li X, Leung V C M. Artificial Intelligence-Based Techniques for Emerging Heterogeneous Network: State of the Arts, Opportunities, and Challenges[J]. IEEE Access, 2017(3): 1379-1391.

[10] Li R, Zhao Z, Xuan Z, et al. Intelligent 5G: When Cellular Networks Meet Artificial Intelligence[J]. IEEE Wireless Communications, 2017(99): 2-10.

[11] Sanctis M D, Cianca E, Araniti G, et al. Satellite Communications Supporting Internet of Remote Things[J]. IEEE Internet of Things Journal, 2016,3(1): 113-123.