大空间图像型火焰检测方法研究

亓文杰 王亚慧 郭晓冉

关键词: 大空间图像; 火焰检测; 运动检测; 颜色空间; 稀疏光流; 识别特征

中图分类号: TN911.23?34 文献标识码: A 文章编号: 1004?373X(2019)04?0076?04

Research on large space image flame detection method

QI Wenjie, WANG Yahui, GUO Xiaoran

(Beijing University of Civil Engineering and Architecture, Beijing 100044, China)

Abstract: In order to improve the accuracy of the image flame detection algorithm and meet its real?time requirement, the three?frame difference and background update combining method is adopted to extract the motion foreground region. The color model is established in the RGB space and Lab space to segment the suspected flame region. The Lucas?Kanade sparse optical flow algorithm is used to track the motion region, and obtain the main motion direction of the flame which is taken as the flame recognition feature to determine whether any real fire occurs. The experimental results show that the algorithm has a good real?time performance and robustness, can effectively improve the accuracy of flame recognition, reduce false detection rate, and has an important application value in the large space public building fire?proof system.

Keywords: large space image; flame detection; motion detection; color space; sparse light flow; recognition feature

0 引 言

近年来建筑物内火灾事故频繁,给人们带来大量的财产损失。火灾是否能得到及时有效的预防已经成为保卫人身安全的重要因素。感烟、感温等探测器受到建筑物内高度、空间、温湿度、粉尘颗粒、气体流速等因素的影响,不适合大空间内火灾探测[1]。本文通过改进的三帧差分?背景更新法来提取运动区域,使用帧差分法和背景更新法相结合的方式。在RGB空间和Lab空间分别建立火焰颜色模型和亮度模型,得到火焰的疑似区域,同其他颜色空间相比,该方法可以准确地分割出火焰区域[2]。最后利用金字塔Lucas?Kanade稀疏光流算法对运动区域进行跟踪,来获取火焰区域的相位分布,进而排除疑似火焰的物體[3]。通过实验验证本文使用的方法可以快速、准确地检测到火焰区域并且报警。

1 火焰探测模型

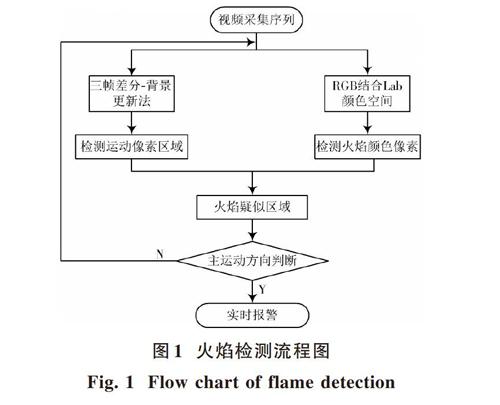

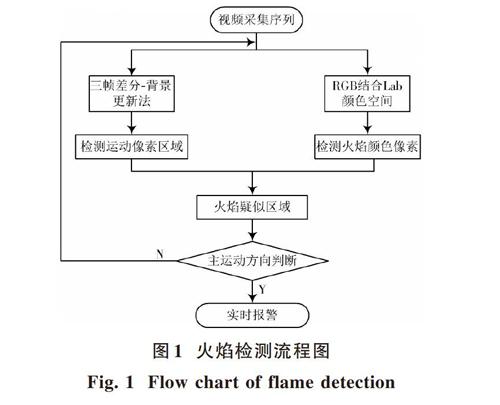

火焰监控视频中,大多数时间是处于无火状态的,本文采用运动检测和颜色空间相结合的方法来提取火焰疑似区域。对于无火的视频,将无法检测到火焰疑似区域,不用对其进行后续检测,很大程度上避免了大量的计算,提高了算法的实时性。当检测到火焰疑似区域时,通过进一步判断该区域的主运动方向特性来排除类似火焰移动的物体[4]。算法流程如图1所示。

1.1 火焰运动目标检测

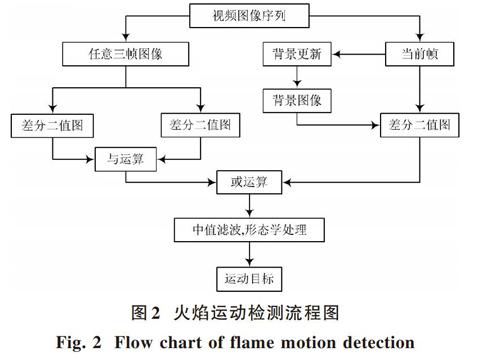

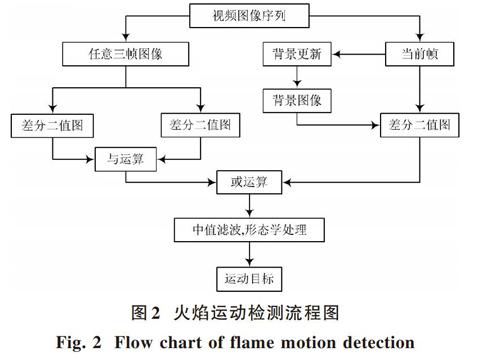

建筑物内火灾大多数存在强光干扰,并且对火灾检测的实时性和准确性都有很高的要求。本文采用帧差分法和背景更新法相结合的方法,充分结合两种方法中准确提取运动目标和对光线适应性强的优点[5]。火焰运动目标检测流程如图2所示。

1.1.1 三帧差分法

帧间差分法容易出现漏检、双影和空洞等现象,而三帧差分法能够有效地避免传统帧差法存在的漏检、双影现象[6]。三帧差分法先是提取临近的三帧图像,然后每两个临近的图像做帧差,再对两次的帧差结果做与运算,得到火焰运动目标方程,具体公式如下:

[f(k,k-1)x,y=1, fk-fk-1≥T10, fk-fk-1<T1] (1)

[fk+1,kx,y=1, fk+1-fk≥T10, fk+1-fk<T1] (2)

[dfkx,y=1, fk,k-1x,y∩fk+1,kx,y=10, fk,k-1x,y∩fk+1,kx,y≠1] (3)

1.1.2 背景更新法

在摄像头固定的情况下,监测场景中背景由于受到光照强度变化、物体运动等因素的影响会发生缓慢变化,因此本文提出一种建筑物内自适应背景更新法[7]。该方法确保了背景模型的实时性和准确性,对环境中的光线变化、背景干扰不敏感,避免出现漏报等情况发生。背景更新如下:

[Bkx,y=αBk-1x,y+1-αfkx,y, fkx,y=0Bk-1x,y, fkx,y=1] (4)

式中:[Bkx,y]是第k幀背景图像的像素灰度值帧;[fkx,y]是第k帧图像;[α]为背景的更新速度,[α∈0,1]。

1.2 自适应阈值的选取

利用人工设置的经验阈值在复杂的环境中不太适用。本文采用Otsu法获取动态阈值,实现自适应二值分割。Otsu将图像分为[C0]和[C1]两类,类间方差达到最大值时的灰度值为最佳阈值。基本思路如下:图像大小为[M×N] ,灰度范围为[0,L-1],设图像中灰度为[i]的像素数为[ni],灰度级[i]出现的概率[pi=niM×N];将图像中灰度为[0,t]的像素点归为[C0]类,灰度级为[t+1,L-1]的像素点设为[C1]类。[P0t],[P1t]表示[C0]类和[C1]类出现的概率;[μ0t],[μ1t]表示[C0]类和[C1]类的平均灰度级。

[ P0t=i=0tpi] (5)

[P1t=i=t+1L-1pi=1-P0] (6)

[μ0t=1P0ti=0tipi] (7)

[μ1t=1P1ti=t+1L-1ipi] (8)

图像的类间方差[δbt]可表示为:

[δbt=P0tμ20t+P1tμ21t] (9)

Otsu阈值T可表示为:

[T=argmax1≤t<LP0tμ20t+P1tμ21t] (10)

1.3 运动目标提取

将分别通过三帧差分法和背景更新法获取二值图像进行“或”运算,提取运动目标背景区域[8]。此外,变化的光照亮度和噪声对运动目标的检测受到背景自适应更新和阈值的影响,但是得到的运动目标中往往还会有部分噪声和空洞现象的存在,因此必须进行形态学操作等后续处理。

2 火焰颜色探测

2.1 Lab颜色空间

选择比较合适的颜色空间对于火焰图像分割有十分重要的意义。Lab颜色模型要通过RGB颜色模型转换得到,首先通过RGB转换到XYZ空间,再由XYZ转换到Lab空间,其转化公式如下[9]:

[X,Y,ZT=0.412 4530.357 5800.180 4230.202 6710.715 1600.072 1690.019 3340.119 1930.950 227RGB]

[X′=X255Xn,Y′=Y255,Z′=Z255Yn,][Xn=0.950 456,Yn=] [1.088 754]

[L=116fY′-16 a=500fX′-fY′+128 b=200fY′-fZ′+128 ] (11)

[fX′],[fY′],[fZ′]可以用统一公式表示:

[fm=m13, m>0.008 8567.787m+16116, m≤0.008 856]

转化后,[L∈0,100],[a,b∈0,255]。

2.2 RGB空间和Lab空间颜色分割

RGB模型是最常见的颜色空间,目前大多数图像采集设备都是以RGB模型为标准。当火灾火焰燃烧时,它的亮度值和颜色值与背景图像差别较大。R分量所占的比例明显高于其他分量,本文结合RGB模型中的红色分量R和Lab模型中的L分量亮度信息对候选火焰区域进行分割[10]。分割条件如下:

[R≥RTL≥LTR≥G≥B]

式中:[RT]是RGB模型中红色分量的阈值;[LT]是Lab模型中L分量的阈值。[RT],[LT]通过统计直方图的方法获得[11]。文中将[RT]设为[170≤RT≤190],[LT]设为[70≤LT≤80],能取得较好的实验效果。本文算法得到的火焰区域结果见图3。

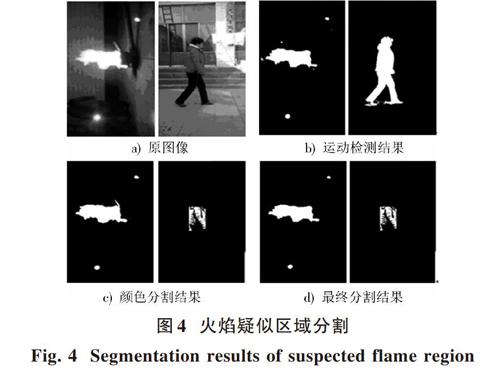

对比图3b)和图3c),本文算法不仅能够提取出完整的火焰区域,而且排除了大部分噪声和火焰周围的反射光的影响,分割后得到疑似火焰区域。实验结果如图4所示。

从实验结果可以看出,通过以上两种方法提取得到的二值图像,仍有一些类似火焰颜色的动态干扰物不被发现。这些都可能产生误报,引起不必要的恐慌和损失,本文将引入光流法获取火焰方向信息,解决一些移动的具有火焰颜色以及全由光反射影响下的火灾。

3 火焰运动方向探测

火焰运动多为大位移,L?K光流计算方法只适用于小位移运动,图像金字塔适用于大位移运动。基于金字塔的光流法具体做法是从图像金字塔的最高层开始计算光流,然后将该层计算结果作为下一层计算的起始值,重复这个过程直到金字塔的最底层[12]。通过上述方法,有效跟踪更大的尺度和更快的运动。

假定[px1,y1],[px2,y2]是跟踪的某一角点在相邻两帧的位置,那么相位角[θ]可表示为:

[r1=y2-y1r2=x2-x1θ=arctanr1r2] (12)

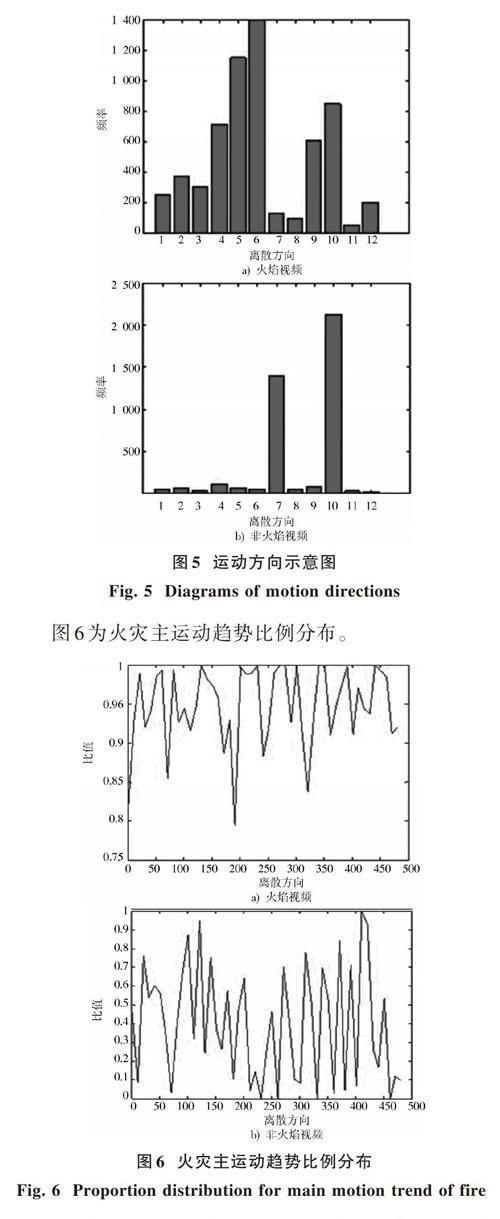

依据[r1],[r2]的正负,判断[θ]属于[0,2π]中的哪个区间,进而判断火焰目标大致运动。为了方便统计火焰方向,归一化所有得到的相位角将[0,2π]分为12个方向区间。利用Lucas?Kanade稀疏光流算法计算光流,得到的火焰视频和非火焰视频运动方向的方向码数据。实验结果如图5所示。

由图5可知,火焰的运动趋势在1~6区域内占据了大多数。非火焰视频的色谱频率只是在某个单一离散方向上频率远超其他方向,发生火焰的视频图像的色谱频率在多个离散方向上都比较高,可以轻易地判断出火焰的运动方向。设[n1],[n2],…,[n12]为疑似火焰区域在1~12运动区间上出现的次数,火焰在各个离散方向中主要运动趋势可以通过下式进行计算:

[α=i=16nii=112ni] (13)

由图6可知,通过设定主运动方向的阈值[α],判断是否超过阈值来确定发生火灾的状况,进而确定是否报警。本文通过多次实验总结设定阈值[α]为0.8。通过火焰的主运动方向特征,可以把图4中误判的穿着红色衣服的行人进行排除。

4 结 论

相比传统传感器火焰检测,本文提出一种简便有效的火焰检测方法。首先通过三帧差分法和背景更新法相结合的方式获取完整的火焰运动目标区域,分析火焰的颜色特性,然后在RGB空间和Lab空间分别进行火焰分割,提取疑似火焰区域。最后通过基于金字塔的光流法判断火焰的主运动方向,排除疑似火焰的运动物体干扰。

参考文献

[1] LI Z, MIHAYLOVA L S, ISUPOVA O, et al. Autonomous flame detection in videos with a Dirichlet process Gaussian mixture color model [J]. IEEE transactions on industrial informatics, 2018, 14(3): 1146?1154.

[2] JIANG B, LU Y, LI X, et al. Towards a solid solution of real?time fire and flame detection [J]. Multimedia tools and applications, 2015, 74(3): 689?705.

[3] LI H. Research on a new photoelectric detection method to anti?muzzle′s flame or light disturbance and projectile′s information recognition in photoelectric detection target [J]. Optoelectronics and advanced materials?rapid communications, 2014, 8(7): 653?658.

[4] LI Z, ISUPOVA O, MIHAYLOVA L, et al. Autonomous flame detection in video based on saliency analysis and optical flow [C]// Proceedings of IEEE International Conference on Multisensor Fusion and Integration for Intelligent Systems. Baden?Baden: IEEE, 2016: 218?223.

[5] DIMITROPOULOS K, BARMPOUTIS P, GRAMMALIDIS N. Spatio?temporal flame modeling and dynamic texture analysis for automatic video?based fire detection [J]. IEEE transactions on circuits and systems for video technology, 2015, 25(2): 339?351.

[6] TOULOUSE T, ROSSI L, CELIK T, et al. Automatic fire pixel detection using image processing: a comparative analysis of rule?based and machine learning?based methods [J]. Signal, image and video processing, 2016, 10(4): 647?654.

[7] MAHDIPOUR E, DADKHAH C. Automatic fire detection based on soft computing techniques: review from 2000 to 2010 [J]. Artificial intelligence review, 2014, 42(4): 895?934.

[8] HAN T, LIN B. Research on flame image recognition method in natural scene [C]// Proceedings of IEEE International Conference on Information and Automation. Ningbo: IEEE, 2016: 1776?1780.

[9] ZHAO X, KONG W, WEI J, et al. Gas chromatography with flame photometric detection of 31 organophosphorus pesticide residues in Alpinia oxyphylla dried fruits [J]. Food chemistry, 2014, 162: 270?276.

[10] 宋宁,强彦,董林佳.林火监测中基于视觉的火焰检测方法[J].科学技术与工程,2017,17(25):268?273.

SONG Ning, QIANG Yan, DONG Linjia. Vision based flame detection method in forest fire monitoring [J]. Science technology and engineering, 2017, 17(25): 268?273.

[11] 戴静,严云洋,范勇,等.基于BEMD和SVM的火焰检测算法[J].常州大学学报(自然科学版),2017,29(2):71?77.

DAI Jing, YAN Yunyang, FAN Yong, et al. Flame detection based on bidimensional empirical mode decomposition and support vector machine [J]. Journal of Changzhou University (Natural science edition), 2017, 29(2): 71?77.

[12] 严云洋,杜静,高尚兵,等.融合多特征的视频火焰检测[J].计算机辅助设计与图形学学报,2015,27(3):433?440.

YAN Yunyang, DU Jing, GAO Shangbing, et al. Video flame detection based on fusion of multi?feature [J]. Journal of computer?aided design & computer graphics, 2015, 27(3): 433?440.