基于全卷积神经网络的空间植物图像快速识别①

樊 帅,王 鑫,阎 镇

1(中国科学院 空间应用工程与技术中心 中国科学院太空应用重点实验室,北京100094)

2(中国科学院大学,北京 100049)

随着人类空间活动越来越频繁,人类在太空中的活动时间也越来越长.因此,在空间环境下研究植物生长规律,建立人类空间生存的生态支持系统以解决人类在太空长期生存的自给自足或部分自给自足问题具有重要的意义[1].在空间植物培养实验中,培养箱为植物提供生长所需的环境条件,同时通过相机拍摄空间植物生长的图像,然后人为观测空间植物的生长过程,分析植物生长状态[2,3].但是,随着更多空间实验的进行,图像数据量增长,使得人工判读效率低、误差较大.因此,基于计算机视觉技术的空间植物自动识别成为当前研究的热点[4].

早先图像识别的方法利用浅层特征对图像进行识别,浅层特征有图像灰度特征、颜色特征、纹理特征、梯度特征等[5].浅层特征提取的方法主要包括主成分分析方法[6]、流行学习方法[7]、基于核的方法、基于字典的方法等[8].然而,这些方法只能提取浅层特征,难以从复杂图像场景中学习出稳定性好且不变性好的深层特征.

深度学习方法[9]的提出以及在图像领域的广泛应用,使得图像识别的精度显著提高,并逐渐成为主流图像识别方法[10].卷积神经网络(Convolutional Neural Network,CNN)是近年来兴起的一种人工神经网络与深度学习理论相结合的模式识别方法,目前已经成为图像领域中的研究热点之一[11–13].但是,空间植物图像干扰因素多且数据量大,而卷积神经网络方法在进行图像识别时,耗用时间长且精度不高.全卷积神经网络(Fully Convolutional Networks,FCN)方法是基于CNN的改进模型,能够实现多类别的同时分类和密集的语义分割,分类精度很高而且速度快[14].

因此,本文所提出的基于全卷积神经网络的空间植物图像快速识别的方法能够很好的解决上述存在浅层图像识别方法难以提取空间植物图像分层特征,以及深层卷积神经网络方法识别时间较长、精度不高的问题,取得了较好的识别效果.此外,本文将以某航天器上的空间植物拟南芥图像为例对提出的方法进行验证.

1 本文方法

本文所提出的基于全卷积神经网络的空间植物图像快速识别方法,主要包括以下三个步骤: 1)构建全卷积神经网络结构; 2)学习全卷积神经网络参数; 3)基于全卷积神经网络的空间植物图像快速识别.

1.1 构建全卷积神经网络结构

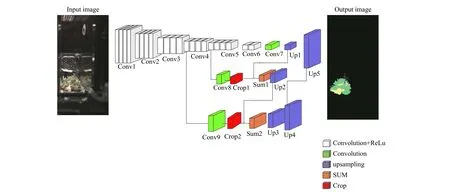

如图1所示,是本文所构建的全卷积神经网络的层次结构图.为了有效表示空间植物图像,除了输入层外,本文选择卷积层来提取空间植物图像的多层特征,引入归一化层对数据进行规范化处理,增加上采样层实现像素级识别分类结果输出.基于上述层类型,排布输入层、多个卷积层、Relu激活函数、归一化层和上采样层,以构成全卷积神经网络的层次结构.

图1 全卷积神经网络结构

图1所示的网络结构中,conv1到conv6都是卷积部分,conv1到conv5包含卷积层的个数都是4个,conv6包含2个卷积层.conv1到conv6中的卷积部分选择卷积核为3×3的卷积层来提取空间植物图像的多层特征.与一般的网络结构不同的是,本文并没有使用pooling(池化层)进行降维,而是在每一个卷积部分的最后一个卷积层采用步长为2进行降维,这样做可以减少位置信息的损失.conv1到conv6每一个卷积部分都采用归一化层使得输出转化为一个标准正态分布从而加速网络结构的学习.

采用卷积核为1×1的卷积层conv7、conv8、conv9,分别将conv6、conv4、conv3卷积部分的输出转化为N通道的特征图像,N表示最终输出的类别数目,本文中类别数是5,分别是绿叶片、绿长茎、绿长茎叶、枯叶片和背景.采用上采样层up1将conv7进行上采样,同时采用剪裁层crop1将conv8的输出剪裁成与up1输出尺寸大小相同,再采用相加层sum1相加.对conv9、crop2、up2进行相同操作.卷积层conv7的输出包含了空间植物图像的深层特征,而卷积层conv8、conv9的输出包含了空间植物图像的浅层特征.

因此,本文的所构建的网络结构能使网络具备提取由浅层至深层的特征,同时融合深层、浅层多尺度的特征,实现空间植物图像场景的有效准确表示,为实现空间植物的准确识别奠定基础.

1.2 学习全卷积神经网络参数

参数学习包含两个步骤: 1)训练一个初始网络;2)在初始网络的基础上进行fine-tune.参数学习的第一步是训练卷积层conv1到conv7的参数,从而得到一个初始网络.为了训练卷积层conv1到conv7的参数,本文先构建了一个VGGNet,如图2所示.

图2 VGGNet

在VGGNet中conv1到conv7网络结构的设置与全卷积神经网络结构中的设置相同.在VGGNet训练之前,先将所得到的训练图像剪裁成为图像尺寸为12×12大小的图像块,如图3所示.

图3 VGG部分训练样本

基于如图3所示的训练集,本文利用带有动量的随机梯度下降(SGD)方法学习网络中权值参数.在训练网络之前,设置动量系数为0.99,权值衰退系数即惩罚因子被设置为0.0005.学习率被初始化为0.000 06,当验证数据集的分类精度停止上升时以10为因子递减学习率.通过VGG网络训练得到卷积层conv1到conv7的参数,从而得到一个初始的网络模型.

参数学习的第二个步骤就是对初始网络进行finetune.与VGG网络训练不同的是全卷积神经网络FCN的方法能够接受任意尺寸大小的图像,不需要对原始图像进行切块.因此,在建立数据集时,选择不同生长周期的空间植物图像进行标注.如图4所示的是FCN的训练样本,对图像中所需要识别的类别进行标注.

图4 FCN训练样本

基于所得到的初始网络和训练集对网络进行finetune.与VGG网络训练相同,FCN训练利用SGD方法进行参数学习.在参数学习之前设置一个固定的学习率10–10,动量系数为0.99,权值衰退系数为0.0005.当fine-tune完成之后就可以得到一个有效的网络模型.

1.3 基于全卷积神经网络的空间植物图像快速识别

利用上述所得到的网络模型对空间植物图像进行有效的识别.选择不同生长周期的空间植物图像输入网络模型中,经过一次前向计算产生密集的识别结果,从而实现了空间植物图像的快速识别.

2 实验结果

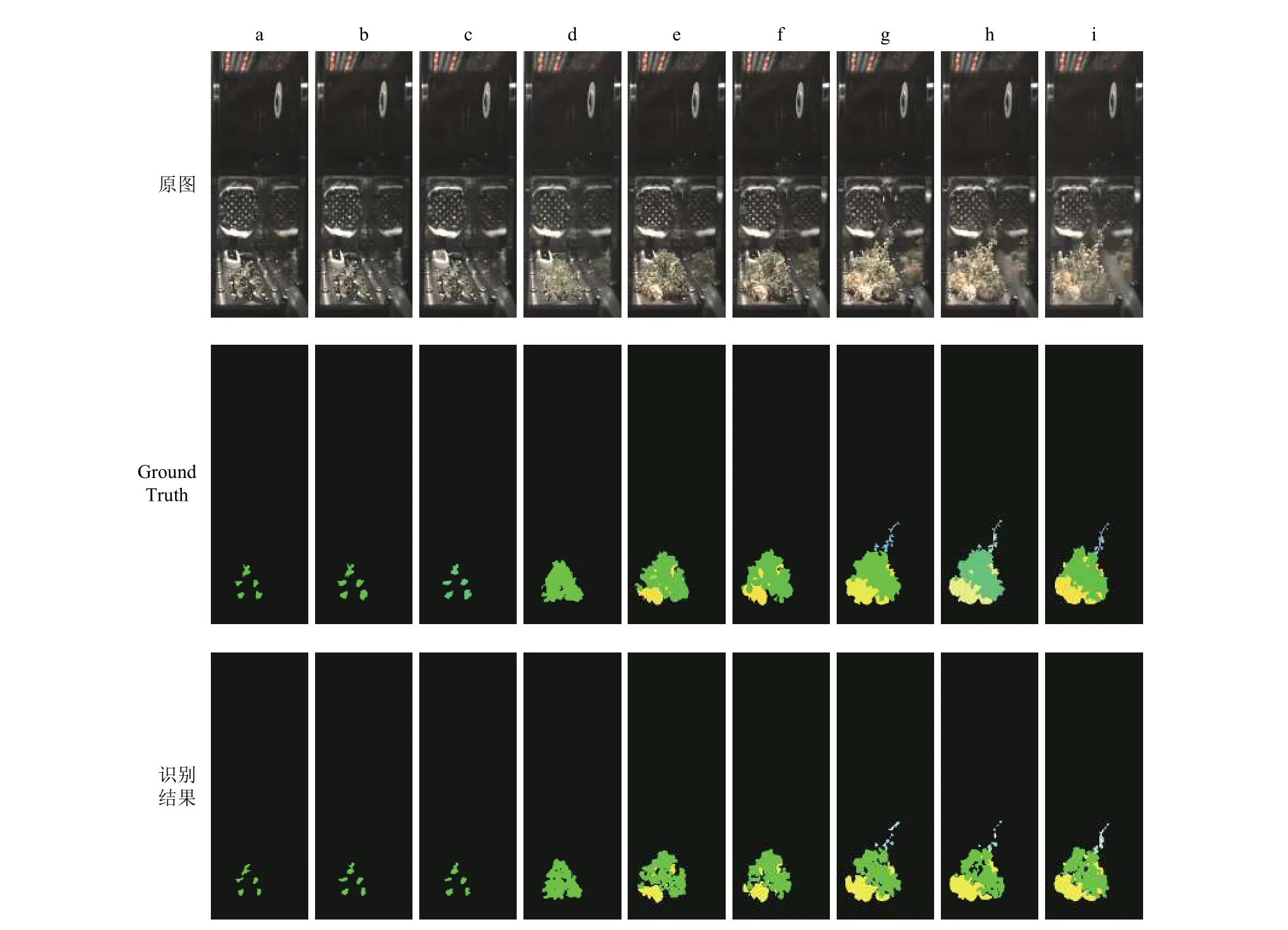

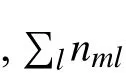

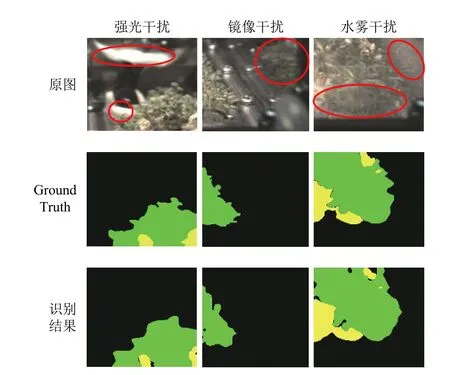

利用训练样本进行模型训练之后,利用测试样本对模型进行验证.选择部分不同生长周期的测试样本进行测试,识别结果如图5所示,a、b、c是拟南芥的幼苗期,d、e、f是团簇期,g、h、i是长茎期.如图6所示,分别是强光干扰、镜像干扰、水雾干扰条件下的空间植物局部识别图像.如图7所示的是本文方法与VGG方法的对比结果图.其中,GroundTruth中的不同颜色区域代表空间植物不同类别的真实区域.

图5 不同生长周期识别结果

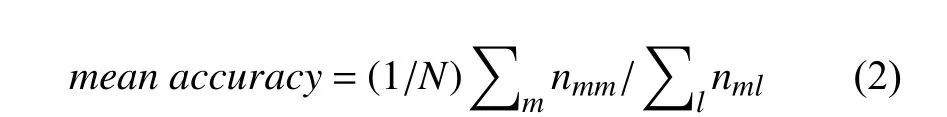

同时,本文对识别的pixel accuracy(像素精度)和mean accuracy(平均精度)以及识别一张图像的时间Rtime进行测试.像素精度是指正确识别的像素占总像素的比例; 平均精度是指计算每个类别被正确分类像素的比例,之后求所有类的平均值.两者的计算公式如下:

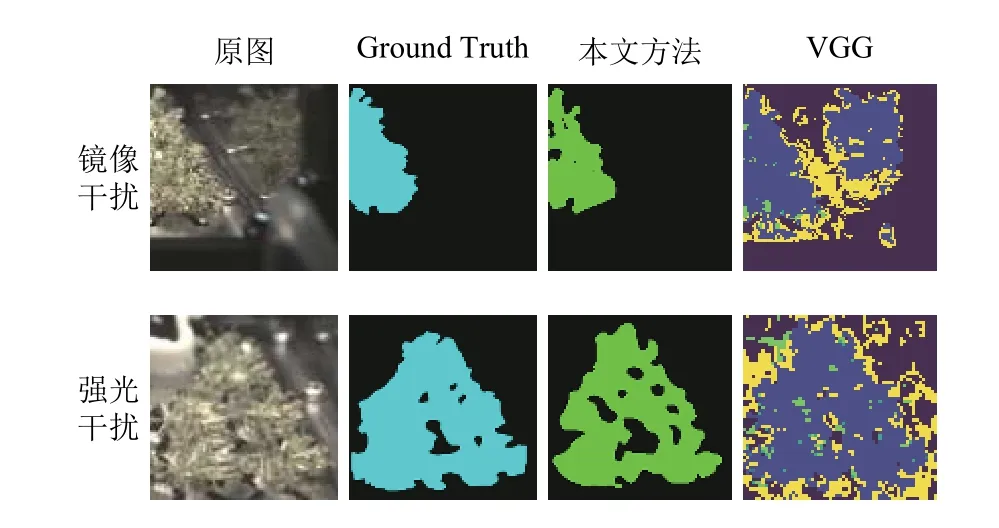

选择500张不同生长周期的拟南芥图像利用本文方法和VGG方法进行测试,所得到的图像的像素精度、平均精度和识别时间如表1所示.

此外,从表1可以看出,本文所构建的基于全卷积神经网络的方法所识别出的图像的像素精度和平均精度值都要比VGG方法的高.本文方法的像素精度高达到96.58%,而VGG的方法为78.42%; 本文方法的平均精度值为85.63%,而VGG的方法为60.73%.同时VGG方法平均识别时间长达668.253 s,而本文方法平均识别时间仅仅为0.156 s,两者的识别速度相差非常大,本文方法识别速度非常快,因此可以处理大量的数据.由此可以看出,本文方法能够准确、快速的实现空间植物图像的识别.

图6 干扰条件下的局部识别结果

图7 实验对比结果

表1 像素精度、平均精度和识别时间

3 实验结果分析

图5展示了拟南芥在不同生长周期的识别效果,在a、b、c中,此阶段拟南芥处于幼苗期,只有绿叶片,识别难度较小; d、e、f中,此时,拟南芥处于团簇期,有绿叶片和枯叶片,同时由于镜像的影响,在培养箱壁上也出现了拟南芥的影像,识别难度增加; g、h、i中,拟南芥处于长茎期,有绿叶片、绿长茎、绿长茎叶、枯叶片,其干扰因素主要是强光以及镜像影响,同时i中还有水雾的影响,此时识别种类多、干扰因素多,识别难度很大.在图5中,对照Ground Truth,从最终的识别结果可以看出,本文所提出的方法对于不同生长周期的空间植物的各个类别都能准确的识别出来.在图6中,红色标记出来的分别是图像中的强光、镜像、水雾干扰的区域.对照Ground Truth可以看出,对于培养箱中的干扰因素,强光、镜像、水雾干扰因素,本文所提出的方法能够很好的排除这些干扰因素,实现空间植物的准确识别.图7展示的是在强光、镜像干扰因素下本文方法和VGG方法的识别结果,对照Ground Truth可以看出,本文方法能够不受这些干扰因素的影响,将空间植物准确识别出来,而VGG的方法虽然能够将植物识别出来但是受镜像干扰因素的影响将培养箱玻璃壁上的植物镜像误识别为空间植物.而且在强光干扰条件下VGG的方法虽然能够将植物基本识别出来,但是也存在误识别的问题.

4 结论与展望

本文提出的一种基于全卷积神经网络的空间植物图像快速识别的方法,很好的解决了目前浅层图像分割方法难以提取空间植物图像分层特征以及深层卷积神经网络方法识别时间较长的问题.通过对实验结果的分析,可以看出本文提出的基于全卷积神经网络的空间植物图像快速识别的方法,能够对空间植物图像实现高精度、快速的识别.此外,结合图像的语义解译技术,基于计算机视觉技术的空间植物图像自动识别及语义解译也将会是一个有价值的研究方向.