循环神经网络中基于特征融合的口语理解

张晶晶 黄浩 胡英 吾守尔·斯拉木

摘 要: 口语理解(SLU)性能的好坏对口语对话系统有着至关重要的作用。在对基本循环神经网络及其变体长短时记忆(LSTM)网络和门限循环单元(GRU)网络结构分析的基础上,提出一种特征融合的循环神经网络结构。该结构首先把输入送到隐含层训练得到特征表示;然后该特征信息与源输入及历史输出信息一起送入另一隐含层训练;最后送进输出层得出结果。对上述不同的循环神经网络的结构及提出的模型在ATIS数据库上进行口语理解实验。结果表明,提出的特征融合的循环神经网络结构的性能要优于传统循环神经网络及其变体结构。

关键词: 口语理解; 循环神经网络; 长短时记忆; 门限循环单元; 特征融合; 自然语言

中图分类号: TN711?34; TP391 文献标识码: A 文章编号: 1004?373X(2018)20?0157?04

Abstract: The performance of spoken language understanding (SLU) is of fundamental importance to a spoken language dialogue system. A feature fusion based recurrent neural network structure is proposed on the basis of analyzing the structures of basic recurrent neural network (RNN) and its variants of long short?term memory (LSTM) network and gated recurrent unit (GRU) network. In the structure, the input is sent to the hidden layer and trained to obtain feature representation. The feature information, together with the source input and historical output information, is sent to another hidden layer for training, and then sent to the output layer to obtain results. An SLU experiment was carried out on the ATIS database using the above different recurrent neural network structures and proposed models. The results show that the performance of the feature fusion based recurrent neural network structure is better than that of the conventional recurrent neural network and its variants.

Keywords: SLU; RNN; LSTM; GRU; features fusion; natural language

0 引 言

口语对话系统是由自动语音识别、口语理解(Spoken Language Understanding,SLU)、对话管理和语言生成、语音合成等部分组成[1]。口语理解性能对于口语对话系统作用十分重要。口语理解的研究出现于20世纪70年代初,经过几十年的发展,大致可以分为基于知识的方法、数据驱动的方法以及两者结合的方法。

随着神经网络在自然语言处理领域的成功应用,人们开始探索不同的神经网络的功能。RNN被验证了在解决序列化问题上有着显著的效果。RNN能够利用上下文信息,但是,RNN在计算时会出现梯度弥散问题,且对长文本处理效果不佳。针对该问题,Hochreiter 和 Schmidhuber在1997年提出长短时记忆网络(Long Short?Term Memory,LSTM)[2],克服了传统RNN梯度消失和梯度爆炸的问题。2014年, 文献[3]提出了LSTM的一个变体门限循环单元(Gated Recurrent Unit,GRU),使得LSTM的结构大大简化。RNN在解决序列问题上的优势在于网络当前输出不仅与当前时刻的输入有关,还与历史输出有关。

本文在RNN,LSTM和GRU神经网络的基础上提出一种特征融合的循环神经网络结构,实验结果表明,对于上述RNN网络结构,特征融合方法都提高了口语理解性能。

1 口语理解问题

口语理解的目的在于自动识别出用户口语表达自然语言的领域、类别和意图,然后提取出相关的概念以达到系统对用户使用的语言进行理解的目的。口语理解主要由领域检测、意图识别和槽值填充三部分组成。领域检测和意图识别是分类问题,槽值填充是标注任务。槽值填充是对句子中的每一个词进行标注。表1给出了对句子进行处理的结果。

表1中,句子中分别标注不同的BIO标签,分别表示Beginning, Inside, Outside。B表示词语的开始;I是中间词;O表示的是句子中其他词语,对句子理解没有实际的意义。

2 循环神经网络及其变体

2.1 基本的循环神经网络

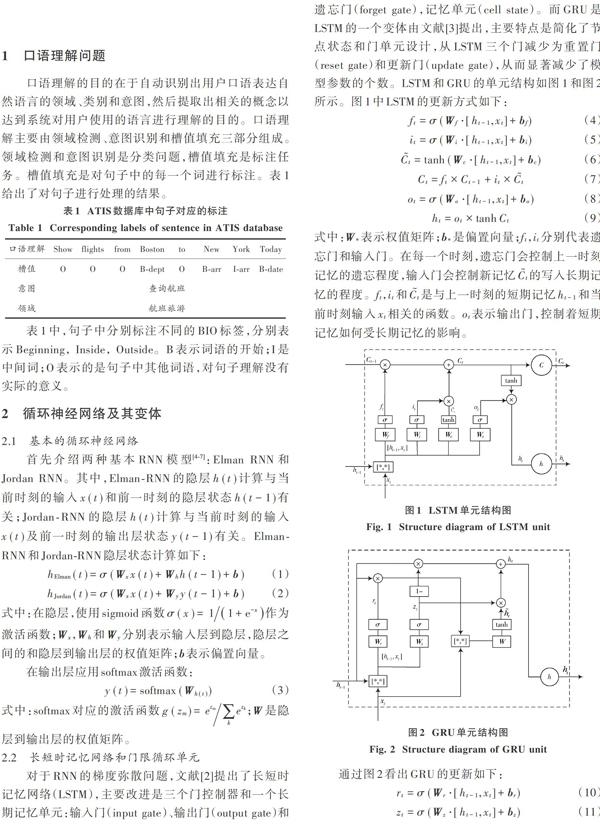

2.2 长短时记忆网络和门限循环单元

式中:更新门[zt]是控制当前时刻需要遗忘多少历史信息和接收新的信息;重置门[rt]用来控制从候选状态[ht]中有多少信息是从历史信息[ht-1]中得到。

3 基于特征表示融合方法的循环神经网络

3.1 特征表示融合方法循环神经网络结构分析

特征融合的循环神经网络建立在上述RNN(传统RNN, LSTM以及GRU)网络的基础上,由4层神经网络组成,其中包含词嵌入(word embedding)层,两个隐层和最后的softmax層。其中,第一个隐层可以是不同的RNN结构单元,第二个隐层是[sigmoid]层结合RNN训练特点对几种特征信息进行融合。具体结构如图3所示。

特征融合循环神经网络模型结构最大特点是在神经网络模型中的第二个隐含层将4种不同的特征信息进行融合。这4种特征信息分别是:上一个隐含层的输出的特征信息;前一时刻隐含层传入的历史信息;源输入的信息送入隐含层;前一时刻的输出信息送入隐含层。

这4种特征信息经过sigmoid激活函数,对其进行特征融合训练得到信息送进输出层。

3.2 特征表示融合方法的工作原理

在上述神经网络结构中,输入为[x=(x1,x2,…,xn)],经过RNN不同的单元节点隐含层更新,具体的单元节点计算方式如第2节所示,将训练之后的信息传入第二个隐层,融合4种特征信息进行训练。在该隐含层数据的训练更新如下:

4 实验过程及结果分析

4.1 实验条件设置

本文在Linux操作系统服务器版Ubuntu 16.04上使用Python 2.7.6的theano[8]库搭建神经网络实验平台,并使用ATIS数据库进行口语理解实验验证提出方法的有效性。ATIS (Airline Travel Information System)数据库被广泛地作为口语理解任务的基准测试数据库,包含4 978条训练语句,测试集共893条语句,数据集共有127个语义槽标签。

4.2 实验结果及分析

条件随机场(Conditional Random Fields,CRF)[9]是处理序列标注最常用的方法,并且在序列处理问题上取得了比较好的效果。本文首先应用CRF模型与Elman?RNN,Jordan?RNN,LSTM和GRU在ATIS数据集上进行实验, 结果如表2所示。

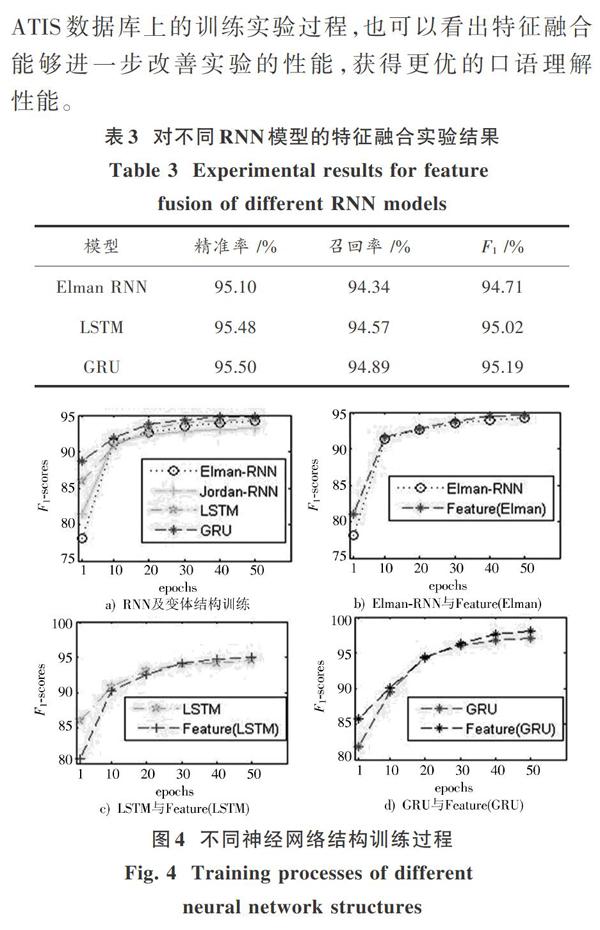

由表2看出,基本RNN模型Jordan,Elman与CRF模型相比,F1值高出0.19%,1.3%。所以RNN在解决口语理解的序列标注问题上更具优势。而RNN变体LSTM和GRU比基本Elman?RNN提高了0.3%和0.57%,故GRU取得了更优的性能。

表3给出对Elman?RNN,LSTM和GRU神经网络进行了特征融合的实验结果。从表2与表3的比较可以看出,相同的神经网络单元节点加入特征融合处理之后,网络结构对于实验处理的效果得到明显提升。图4是比较RNN及其变体结构和对应的特征融合网络结构在ATIS数据库上的训练实验过程,也可以看出特征融合能够进一步改善实验的性能,获得更优的口语理解性能。

5 结 语

针对RNN的口语理解模型提出基于特征融合的口语理解方法。该方法是一个4层的神经网络模型结构,特点是在第二个隐含层将上一隐层的输出、前一时刻隐层状态、源输入和历史输出4种不同的特征信息进行融合训练从而获得传递信息传向输出层。在ATIS数据库上的口语理解实验表明,本文提出的基于特征融合的循环神经网络在口语理解实验上取得了更优的性能。

注:本文通讯作者为黄浩。

参考文献

[1] 俞凯,陈露,陈博,等.任务型人机对话系统中的认知技术:概念、进展及其未来[J].计算机学报,2015,38(12):2333?2348.

YU Kai, CHEN Lu, CHEN Bo, et al. Cognitive technology in task?oriented dialogue systems: concepts, advances and future [J]. Chinese journal of computers, 2015, 38(12): 2333?2348.

[2] HOCHREITER S, SCHMIDHUBER J. Long short?term memory [J]. Neural computation, 1997, 9(8): 1735?1780.

[3] CHO K, VAN MERRI?NBOER B, GULCEHRE C, et al. Learning phrase representations using RNN encoder?decoder for statistical machine translation [J/OL]. [2014?09?03]. http://xueshu.baidu.com/s?wd=paperuri%3A%282ba31a0b87d74d2531

7da3521cca2915%29&filter;=sc_long_sign&tn;=SE_xueshusourc?

e_2kduw22v≻_vurl=http%3A%2F%2Farxiv.org%2Fabs%2F1406.1078&ie;=utf?8≻_us=9851577233160611135.

[4] MESNIL G, HE X, DENG L, et al. Investigation of recurrent?neural?network architectures and learning methods for spoken language understanding [J/OL]. [2013?08?01]. https://www.microsoft.com/en?us/research/wp?content/uploads/2016/02/IS13_RNNSLU_cameraready.pdf.

[5] MESNIL G, DAUPHIN Y, YAO K, et al. Using recurrent neural networks for slot filling in spoken language understanding [J]. IEEE/ACM transactions on audio, speech, and language processing, 2015, 23(3): 530?539.

[6] YAO K, ZWEIG G, HWANG M Y, et al. Recurrent neural networks for language understanding [C/OL]. [2014?10?14]. https://www.researchgate.net/publication/266798083_Recurrent_Neural_Networks_for_Language_Understanding.

[7] JOZEFOWICZ R, ZAREMBA W, SUTSKEVER I. An empirical exploration of recurrent network architectures [C]// Proceedings of 32nd International Conference on Machine Learning. Lille: Association for Computing Machinery, 2015: 2342?2350.

[8] AL?RFOU R, ALAIN G, ALMAHAIRI A, et al. Theano: a Python framework for fast computation of mathematical expressions [J/OL]. [2016?05?09]. https://www.researchgate.net/publication/302569301/download.

[9] SUTTON C, MCCALLUM A. An introduction to conditional random fields [J]. Foundations and trends in machine learning, 2011, 4(4): 267?373.

[10] MIKOLOV T, JOULIN A, CHOPRA S, et al. Learning longer memory in recurrent neural networks [J/OL]. [2015?04?16]. https://research.fb.com/wp?content/uploads/2016/11/learning_longer_memory_in_recurrent_neural_networks.pdf?.

[11] HENDERSON M, GA?I? M, THOMSON B, et al. Discriminative spoken language understanding using word confusion networks [C]// Proceedings of IEEE Spoken Language Technology Workshop. Miami: IEEE, 2013: 176?181.