自然环境下多类水果采摘目标识别的通用改进SSD模型

彭红星,黄 博,邵园园,李泽森,张朝武,陈 燕,熊俊涛※

(1. 华南农业大学数学与信息学院/南方农业机械与装备关键技术教育部重点实验室,广州 510642;2. 山东农业大学机械与电子工程学院,泰安 271018;3. 华南农业大学工程学院,广州 510642)

0 引 言

自然环境下的水果识别检测是利用计算机视觉技术获取水果目标位置信息,并将获得的位置信息传递给水果采摘机器人的机械手臂,从而能够精确地进行后续的水果采摘工作[1]。因此,水果的目标检测是水果采摘自动化领域的重要组成部分,近些年来,很多传统水果检测识别算法相继提出。

Ji等[2]研究了基于区域生长和颜色特征分割的方法,通过支持向量机识别提取的苹果颜色和形状特征,但是对于叶面遮挡引起的平均误差率较大;Si等[3]设计一种双目立体视觉的采摘机器人,通过RGB颜色通道色差R-G阈值和色差比例(R-G)/(G-B)定位苹果的像素位置,并通过随机环方法确定水果的二维信息,然而需要水果进行复杂的预处理且很难确定水果图像面积阈值;Lu等[4]提出了一种基于颜色信息和轮廓片段的柑橘识别方法,采用融合色差信息和归一化RGB模型的分割技术,通过对分割果实片段的椭圆拟合分析达到室外自然光照下的识别目的,但是在初步分割阶段未排除光照影响;Wang等[5]利用小波变换归一化荔枝图像减小光照影响,并采用基于颜色K-means聚类算法从树叶和枝干中分割出荔枝图像,虽然在没有遮挡的情况能够达到较高的识别率,但是没有考虑到荔枝簇类生长的特性;Lü等[6]采用基于径向基核函数的多分类支持向量机从树叶和枝干中分割出柑橘果实,然而水果区域的训练像素选取非自适应且对小目标水果识别不佳;Zhao等[7]应用残差变换绝对值和的块匹配方法检测潜在的柑橘果实像素,构建一个支持向量机实现较高的识别精确率,但是对于遮挡以及光照不均匀水果的识别表现不佳。

通常自然环境下获取的果蔬图像都具有较大的差异性和复杂的背景噪声,上述传统的图像识别模型受限于自身算法的局限性,无法找到通用的特征提取模型,只能设计识别检测一种特定水果,泛化性不强,算法没有得到很好的推广。Krizhevsky等[8]提出AlexNet卷积神经网络(convolutional neural network,CNN)架构在分类识别中崭露头角,对图像的识别精度具有里程碑式的贡献。CNN具有非线性特征表达能力强,泛化性能好等优势,能够很好地完成物体的识别检测任务,已用于水果识别[9]和病虫害的检测[10-12]。近年来,相关研究人员利用不同深度架构[13-14]的CNN不断刷新图像分类、识别的精确率,水果图像检测技术也得到了进一步的发展。Suchet等[15]提出多尺度多层感知器和卷积神经网络 2种特征提取算法对苹果进行分割,但是只针对单类水果进行识别;傅隆生等[16]利用参数优化和结构约简的 LeNet模型对田间环境下的猕猴桃进行自主特征学习,但对于遮挡和重叠果实没有达到很好的效果;Sa等[17]和熊俊涛等[18]采用Faster R-CNN深度卷积神经网络分别构建甜椒和柑橘检测系统,但其目标检测框过大,易导致目标检测不够精准;Liu等[19]提出基于CNN的SSD(single shot detector)深度学习物体检测方法,实现兼顾速度的同时提高了检测的精度,有学者对其做了进一步的改进[20-23]。

本文以苹果、荔枝、脐橙、皇帝柑 4种水果为研究对象,对自然环境下采集的多类水果图像进行识别检测技术研究,提出一种结合ResNet的SSD深度检测改进框架,并训练端到端的识别检测推理模型,通过对水果识别的多组试验对比,以期实现简化特征提取过程的同时提高了水果识别的精度及其鲁棒性,为自然环境下的水果采摘技术提供参考。

1 试验材料

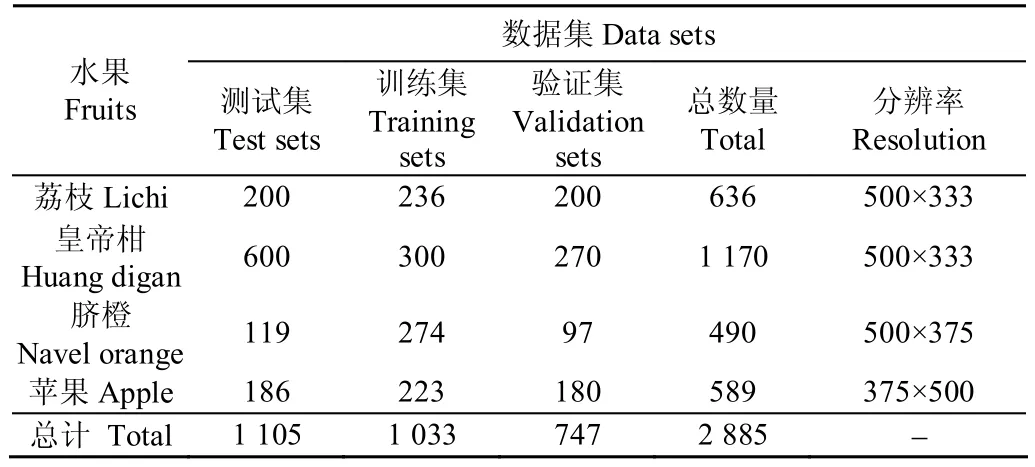

本文试验的荔枝、皇帝柑图像于2017年6月和12月使用Canon EOS 60D相机采集自广东省广州市,图像分辨率为5 184×3 456像素,苹果、脐橙图像于2017年6月和 12月使用手机采集自甘肃省天水市和江西省赣州市,图像分辨率为3 024×4 032像素。在原始数据集基础上经过预处理缩放到表 1中的大小,以减小后期特征提取时对硬件处理的压力,并将处理后的数据集按照广泛使用的PASCAL VOC[24]竞赛的数据集格式分为如表1所示的训练集、验证集和测试集,训练集是随机从整体数据集中独立同分布采样得到,且测试集和验证集互斥,保证了后期评价标准的可靠性。验证集用于训练过程中确定模型中的超参数,而测试集用于评估模型的泛化能力。

表1 水果数据集种类及数量Table 1 Category and quantity of fruit data sets

数据集的标注包含感兴趣区域的 4元组参数(Xmin,Ymin,Xmax,Ymax),分别表示标注框的左上角和右下角的坐标,用于评测模型精确度时根据输出框与标注框重合率大小判定匹配分数,为网络模型提供了预定义输出。训练集标注的优劣在一定程度上决定了模型检测的精度,因此训练集中标注的水果图像应该尽可能的覆盖各种光照、角度、大小的变化。

在用于自然环境下的水果识别检测过程中,该文采用端到端的检测模型,首先利用ImageNet数据集上的预训练模型对水果的训练图集进行训练,得到目标检测推理模型,然后利用训练性能好的模型进行水果的检测测试,得到检测结果。

2 水果检测模型结构

2.1 经典SSD深度学习模型

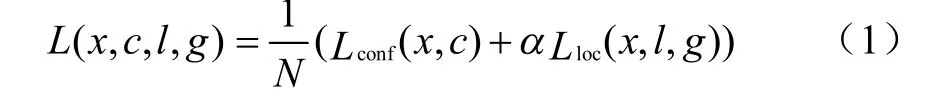

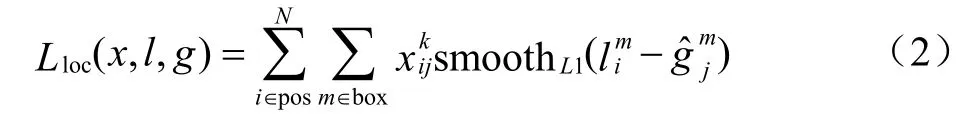

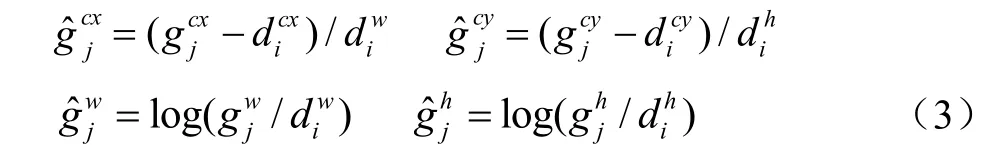

SSD物体检测框架基于前馈卷积网络,在多层特征图中产生固定大小的边界框集合和框中对象类别的置信度,假设以表示第i个默认框与类别p的第j个真实标签框相匹配,相反的不匹配则 0pijx= 。根据上述匹配策略,当时意味着有多于一个与第j个真实标签相匹配的默认框。检测框架的总体目标损失函数用式(1)中位置损失(Lloc)和置信损失(Lconf)的加权和表示。

式中c是Softmax函数对每类别的置信度,N是匹配默认框的数量,权重项α通过交叉验证设置为1。位置损失是预测框(l)和真实标签框(g)之间的平滑L1损失,可表示为

SSD的预测框和真实标签框之间的偏移回归类似于Faster R-CNN[25]方法,其中 box={cx、cy、w、h}表示预测框中心坐标及其宽高,可用平移量dicx、dicy和尺度缩放因子获取真实标签的近似回归预测框(上标m表示cx、cy、w、h),表示为

置信损失可用如式(4)表示,其中表示类别p的第i个默认框置信度,

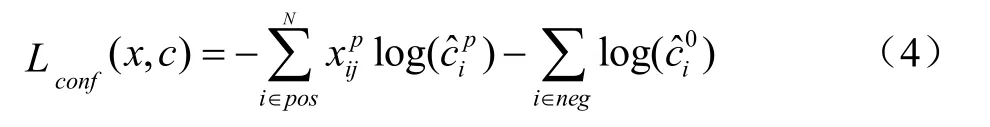

SSD框架如图1所示,使用全卷积层的VGG16作为基础网络[26]直接作用特征图预测多目标类别和外围框。由于采用了单点多框检测方法,避免如Faster R-CNN中使用的候选区域方法,权衡了检测的精度和实时性,即使对输入相对较低分辨率的图像也有很好地检测效果。

图 1所示 SSD 针对 Conv4_3、FC7、Conv8_2、Conv9_2、Conv10_2和Conv11_2特征层的每一个单元按照不同长宽比分别提取4到6个默认框,最终获取8 732个默认框,训练阶段利用式(1)为预测框做坐标偏移的回归分析,使其尽可能接近标注框。测试阶段每一个默认框都和标注框进行重叠率匹配,并按照匹配分数从高到低排序,利用极大值抑制[26]的方法,将检测结果进行约简。

2.2 改进的SSD深度学习水果检测模型

深度卷积神经网络使得图像的识别率相比传统的识别方法有了长足的进步,从 AlexNet的 8层网络到VGG的16层网络,更深的卷积网络整合了不同层次的特征。相关研究也表明可以通过增加网络层数丰富特征,Simonyan等[27]证明识别的精度随着网络深度的加深而提高,然而反向传播时梯度爆炸导致简单的堆叠卷积层并不能顺利地训练网络。有研究通过批量归一化[28]和dropout[8]技术使得有限的深层能够继续训练,但在一定的训练迭代之后出现精度的饱和导致精度下降问题依然存在。

图1 SSD检测框架Fig.1 single shot multi-boxdetector (SSD) detection model

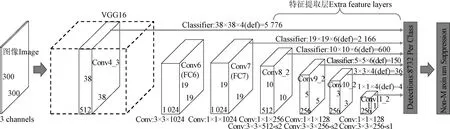

为突破网络在深层网络精度退化和网络深度上的限制,He等[29]借助恒等映射的概念,提出深度残差(ResNet)模型,利用多层网络拟合一个残差映射解决了退化问题。假设H(X)表示目标最优解映射,用堆叠的非线性层拟合另一个映射F(X)(如图2所示),可用式(5)表示。

此时原最优解映射H(X)就可以等价为F(X)+X,即图2中所示前馈网络中的快捷连接实现,快捷连接的方式可以用式(6)表示,其中X表示模块的输入向量,Y表示模块的输出向量,Wi表示权重层参数,当输入和输出维度一致时需要增加一个线性投影Ws来匹配维度。

图2 残差学习模块Fig.2 Residual learning block

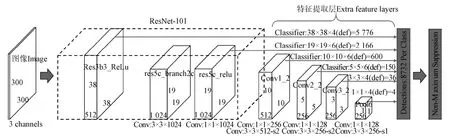

ResNet-101由如图2所示的结构相同的101个模块重复堆叠构成,该文将VGG16输入模型替换为101层残差网络ResNet-101,对经典SSD深度学习模型进行改进,改进后的检测框架如图3所示。

图3 基于ResNet-101的改进SSD检测框架Fig.3 Improved SSD detection framework based on ResNet-101

2.3 迁移学习

随机初始化权值需要花费大量的时间将模型损失值收敛于稳定值。采用Xavier初始化方法[30],则可以降低随机设置初始权值带来的网络不稳定性。Jason等[31]通过网络模型迁移试验并可视化证明底层的卷积神经网络能够学习到物体的通用特征,例如边缘、几何变化、光照变化等,高层网络能够提取出特定任务的特征细节。相比Xavier初始化方法,迁移学习能够在数据集较小的情况下快速适应新的任务。因此采用大数据集(ImageNet数据)下训练好的预训练模型,共享底层结构权值参数,然后修改模型的顶层网络结构进行微调,可以克服不同数据集之间的差异性,在新的任务中将会快速的收敛于邻域很小的损失值。本文采用在ImageNet数据集上预训练的权重模型作为SSD检测框架的初始权重模型,通过迁移学习的特征,进一步降低训练的时间和资源。

2.4 数据增强

数据增强是一种可以在不降低检测精度的情况下提高算法鲁棒性的通用做法,特定场景和实际应用中,往往很难收集满足各种条件的数据用于训练和测试,因此许多目标检测算法都采用数据增强的方式来评估所设计的算法泛化能力,常用的数据增强方法包括水平翻转、平移、裁剪和颜色抖动等[8]。本文对采集的自然环境下的图像数据进行数据增强操作以验证模型的泛化能力。

3 模型训练及结果分析

3.1 试验平台

Caffe是一款优秀的深度学习框架[32],本文试验基于该框架的模型接口部署,首先配置运行环境,根据现有的硬件设备能够支撑的能力设置检测模型的超参数,包括图像批处理大小,输入图像的维数,基础网络的深度。该文运行的试验环境和需要的软硬件设备:Linux使用Ubuntu 16.04长期支持版、GPU采用 NVIDIA TITAN X、Caffe、CPU为Intel Core i7-6700,处理频率为 3.4 GHz、CUDA 8.0版本并行计算框架配合CUDNN 5.1版本的深度神经网络加速库、Python版本为 2.7.12、内存选择为16 GB并且使用500GB的机械硬盘。

3.2 模型训练与结果分析

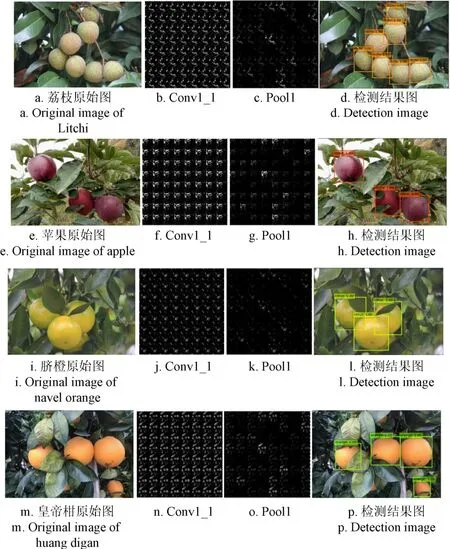

为了更好地显示卷积神经网络的运作流程,该文将特征提取的中间过程进行可视化操作,由于高层特征图的维度较低,显示特征较小,图 4所示给出了卷积过程中根据最终的权重模型得到的卷积 Conv1_1层和池化Pool1层。Conv1_1层是推理模型特征提取之后第一层,从图中可看出水果轮廓特征,证明了底层的包含大量的纹理信息,并且经过池化层之后特征轮廓未改变,进一步地降低了特征表达的维度,经过CNN的多层语义表达之后得到水果的目标区域。

图4 SSD检测过程可视化Fig.4 Visualizing of SSD detection process

3.2.1 试验设计

试验中,分析检测效果比预期低的原因主要是因为输入模型深度浅导致识别精度不高,数据集的规模小导致检测泛化性不强,在测试集中存在大量的遮挡水果图像,导致召回率低。针对以上问题,本文通过以下几组试验提升检测精度:1)将 VGG输入模型替换为ResNet-101分别进行模型识别对比;2)对原始训练集进行水平翻转进行数据增强以验证模型的泛化能力;3)对不同遮挡比例图像进行目标识别,分析模型的检测精度。

3.2.2 试验参数设置

本文试验采用随机梯度下降SGD(stochastic gradient descent)算法[33]将经典SSD深度学习框架部署在GeForce GTXTITAN X加速显卡上训练,训练集进一步预处理缩放到300×300像素以减小整个网络的参数量。

由于原始权重经过大数据集预训练,因此试验中将学习动量设为0.9,权重衰减为5×10-4,图像批处理大小为16,学习率前3×104次迭代阶段设置为10-4,后3×104次迭代设置为 3×10-5进行微调防止过拟合。24 h的训练周期包含了预处理和后处理,生成的推理模型检测每张大小为500×333像素左右的图像速度维持在0.05 s左右,训练过程的损失图和查准率-召回率曲线图如图5所示,训练损失图在较短的迭代次数内能够迅速收敛损失值,这得益于迁移学习在底层卷积层中的权重共享。此外如果使用浮点运算更高和显存更大的加速显卡,模型的收敛及检测速度将进一步提高。

图5 经典SSD模型训练损失图和检测查准率-召回率(PR)图Fig.5 Training loss map and precision-recall rate (PR)diagram of detection of classical SSD model

3.2.3 评价指标

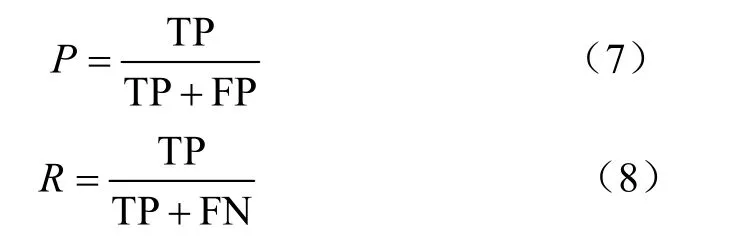

查准率P(%)表示预测的检测框中检测正确的比例,召回率R(%)表示预测框正确框在所有标注框中的比例,可以表示为

式中TP为检测到的相关数量,FP表示检测到不相关数量,FN表示未检测到不相关数量。

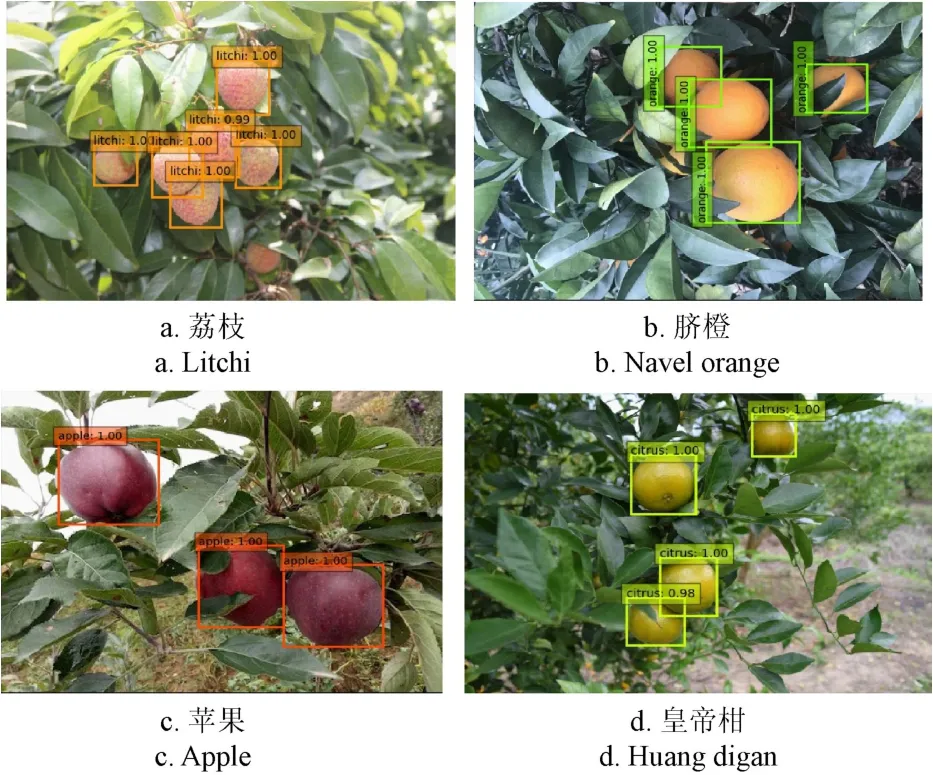

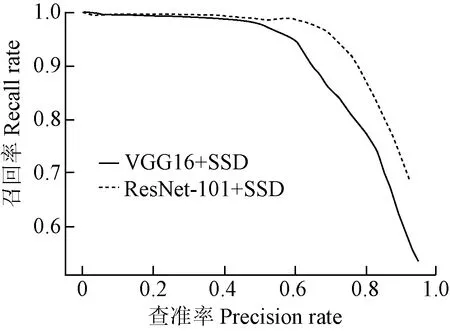

AP(average precision)是PR曲线在查准率基础上对召回率的积分,mAP(mean average precision)表示多类物体的平均AP值,是测量网络对目标物体敏感度的一种标准。mAP值越高就说明卷积神经网络的识别精确度越高,但代价是检测的速度将变慢,在图5b中显示了识别模型的PR曲线图走势为偏右上角的凸曲线,曲线在坐标轴上的积分越大表明mAP值越大,最终的mAP(平均AP值)达到86.38%,图6所示为SSD检测部分水果示例图。

3.2.4 结果分析

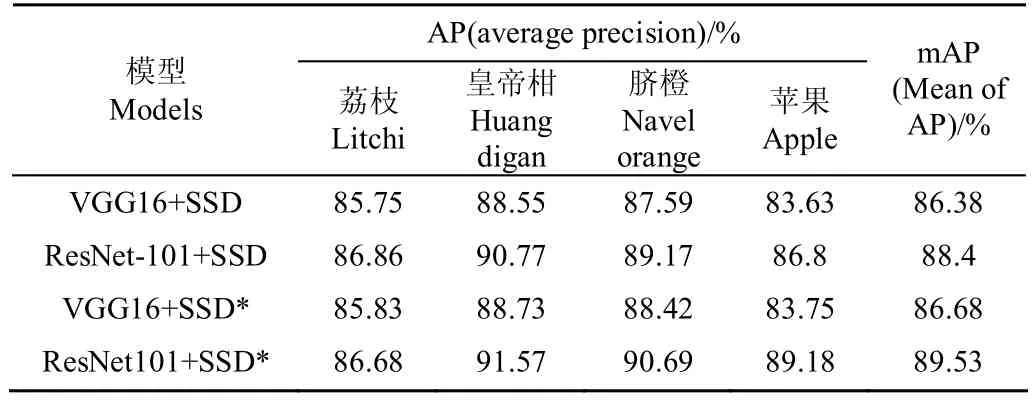

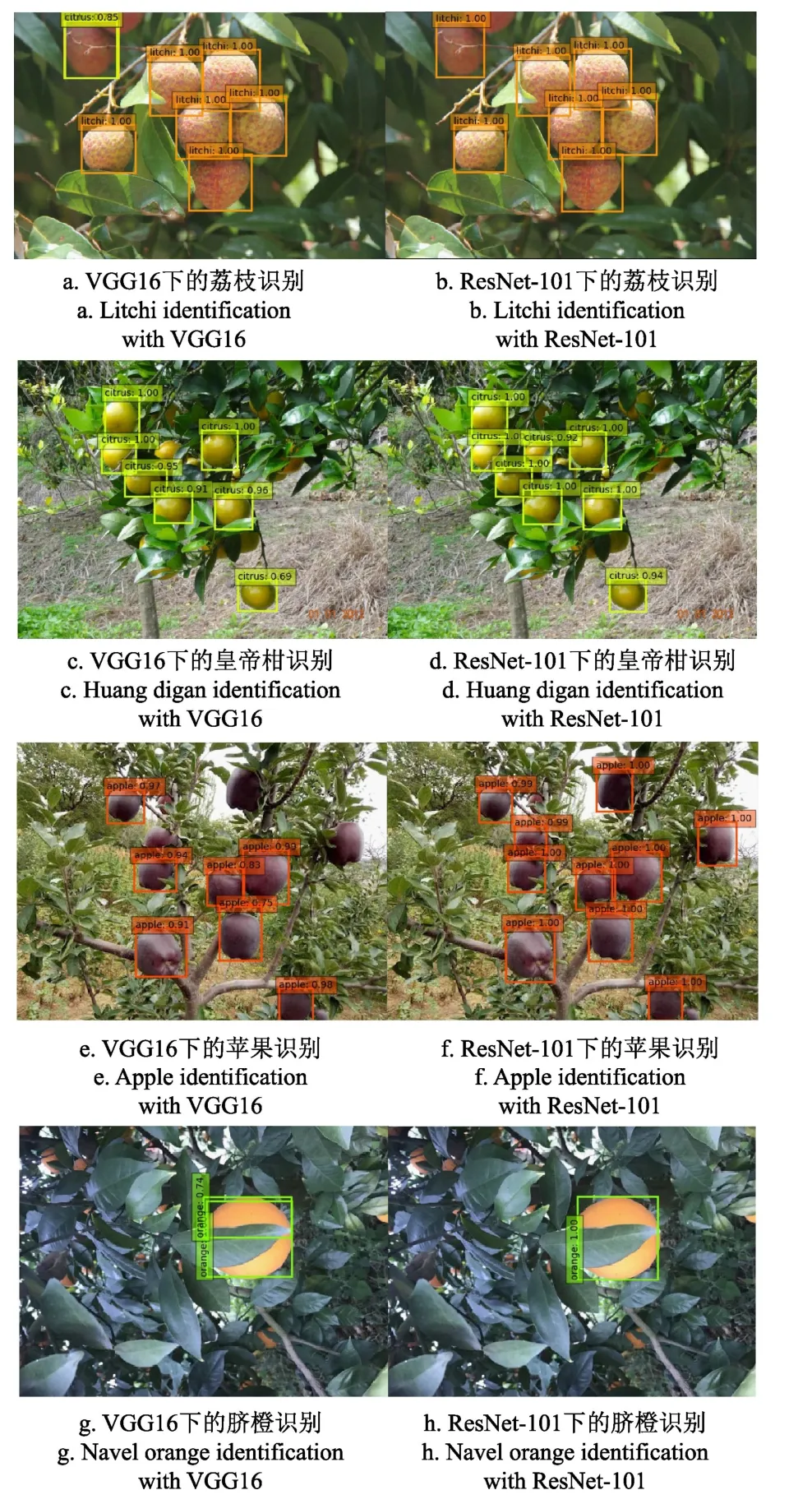

表2和图7为该文提出将101层堆叠的残差模块进行组合成的ResNet-101网络替换SSD中原始的VGG16网络后得到的对比结果。

图6 SSD检测示例图像Fig.6 Sample pictures of SSD detection

表2 不同网络SSD模型的检测平均精确度Table 2 Detection average precision of with different networks SSD model

通过试验对比分析可以看出,ResNet-101+SSD模型对各类水果的平均精度均有提升贡献,需要注意的是网络在创建冻结推理模型时丢弃了低于重叠联合比阈值0.5的检测结果,这相当于在检测器的精确召回曲线上选择一个点并且丢弃该点的一部分,这对mAP度量将会产生负面影响。

图7 基于VGG16和ResNet-101网络的SSD模型查准率-召回率对比Fig.7 Precision-recall rate of SSD models based on VGG16 and ResNet-101 networks

特征提取器的选择至关重要,因为卷积层的参数和类型的数量直接影响检测器的内存、速度和性能。图 7和图8所示分别为2种SSD模型的PR曲线和检测对比试验结果,从试验结果中可以看到,通过改变网络的深度和提取模型,该文提出的ResNet-101网络模型最终的检测结果比原始的VGG16模型检测精度更高、效果也更好,在TITAN X显卡加速下,相同的分辨率图像检测速度仅比VGG16的检测速度低0.09 s左右,足以满足水果识别检测任务。

图8 基于VGG16和ResNet-101网络的SSD模型识别对比Fig.8 Comparison of SSD model recognition based on VGG16 and ResNet-101 network

卷积神经网络自身拥有强大的表征能力,为了获得良好的检测效果,除了使用更好的模型,同时也需要海量的数据驱动模型的训练,否则可能使模型陷入过拟合的窘境。本文对图像数据进行水平翻转数据增强操作,相当于数据量增加一倍,检测结果如表2中所示。

试验发现,经过翻转数据扩充之后,2种网络的检测精度都有所增加,采用ResNet-101+SSD运用数据增强技巧将检测精度提升了1.13个百分点后平均检测精度可至89.53%,虽然精度的提升程度并不明显,但是增加了检测模型对水果图像复杂环境下的鲁棒性。

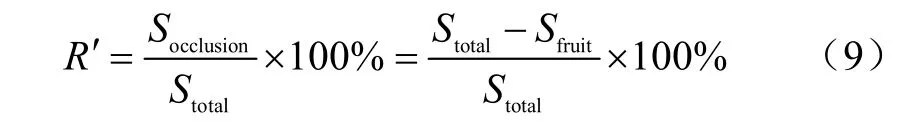

传统的水果识别算法以颜色空间为基础,首先进行复杂的特征提取预处理,再利用 SVM(support vector machine)等分类器进行分类判别将水果从背景中分割出来,然而由于树叶、枝干和果实相互遮挡,传统方法容易被环境因素干扰很难定位遮挡水果,给水果的识别检测带来了极大的困难。为了综合判别不同遮挡情况下的检测识别精确率,本试验对每类水果随机选取 100张图像进行测试,按水果图像不同的遮挡率(式(9))并给出了式(10)所示的F1值评价标准。

式中R′为遮挡率(%),Stotal为被遮挡的水果图像还原拟合为无遮挡情况下的水果图像总面积,Socclusion为被遮挡的面积,等于Stotal减去没有被遮挡的水果面积Sfruit。

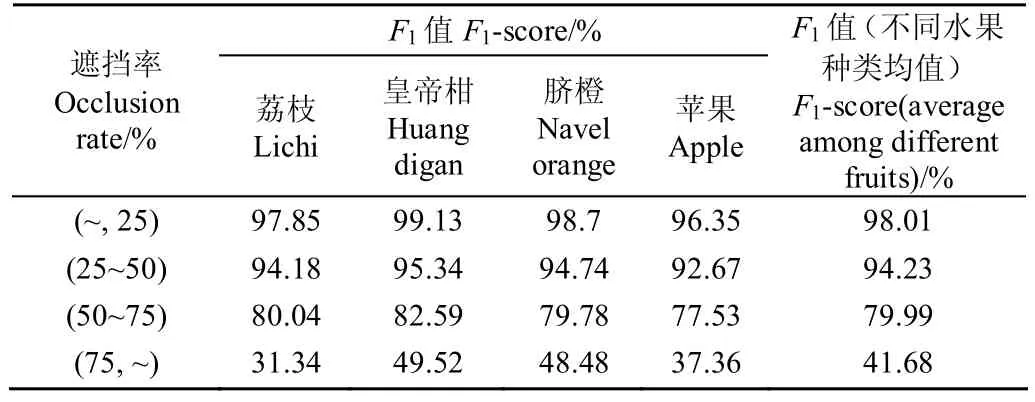

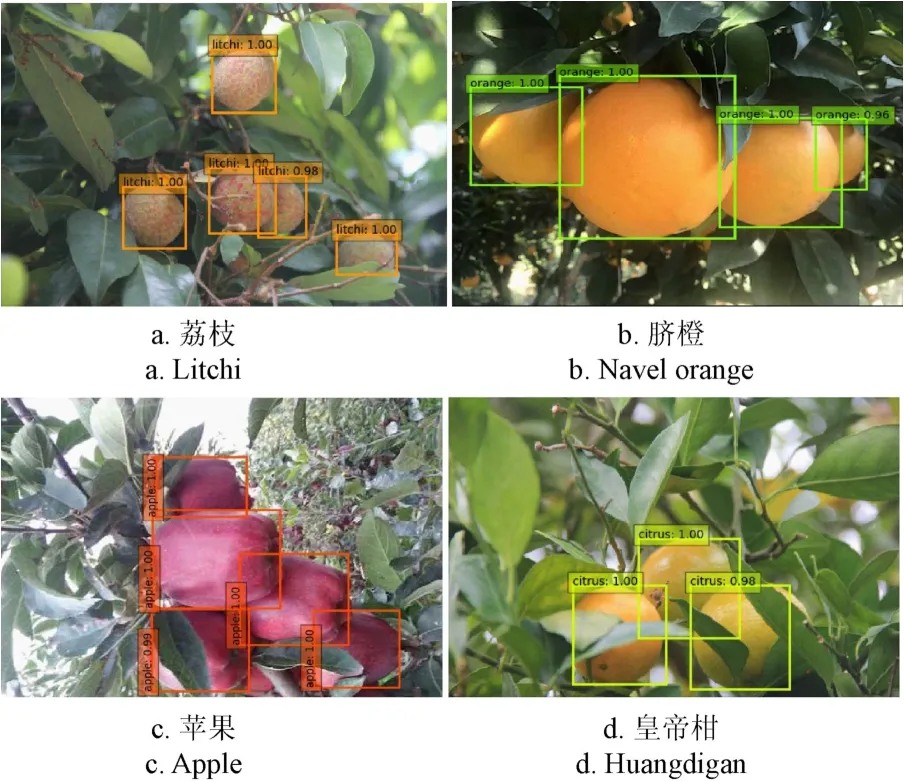

式中F1是查准率和召回率的加权平均,其值越大说明效果越好,反之越差,表3为F1值衡量检测的结果,图9为不同遮挡率下检测示例。

表3 基于ResNet-101网络不同遮挡比例的检测精度Table 3 Detection precision with different occlusion ratio based on ResNet-101 network

图9 部分遮挡检测示例图像Fig.9 Example picture of partial occlusion detection

通过图 9所示部分遮挡示例以及得到的试验数据发现,对于遮挡低于50%的情况下,4种水果的平均F1值能够达到96.12%,其中皇帝柑和脐橙由于其果实较大,遮挡因素主要是树叶和枝干,因此能够在不同遮挡比例情况下保持较高的检测识别率;但是对于荔枝这类串类水果受聚集生长的缘故,遮挡物主要是同类物体,检测框容易包含2个果实,从而导致遮挡率超过75%时单个果实的检测识别率不高,然而由于串类水果采摘时是以串为单位进行采摘的,检测框中包含 2个果实并不影响对水果的采摘,故足以满足水果自动化采摘的需要。

4 结 论

该文以苹果、荔枝、脐橙、皇帝柑 4类水果为研究对象,运用基于改进的SSD深度学习模型检测技术对这4类水果进行检测识别研究。

1)运用迁移学习的方法,将大数据集(ImageNet数据集)下的权重模型移植到多类水果检测任务,大大降低了训练的时间和资源,利用经典的SSD框架作为基本的深度学习网络检测的平均精度为86.38%。

2)采用ResNet-101替换SSD框架中的VGG16基本网络,将水果的检测精度从86.38%提高到了88.4%,运用数据增强技巧将检测精度提升了1.13个百分点后平均检测精度可至89.53%,针对遮挡率低于50%的水果检测问题,改进后的SSD深度学习模型对这4类水果的检测识别率F1值平均能够达到96.12%。

3)训练了端到端的检测模型,相比传统的识别算法,该文提出的基于改进的SSD深度学习框架的检测技术不用针对不同水果图像进行人工特征选择,就可以同时对多类水果进行检测识别,从而大大减少了工作量,提高了水果检测识别的效率。

此外基于标注框的检测技术,也可以很好地解决重叠水果的目标分割问题,从而为水果自动化采摘带来新的思路。

[1]Edan Y, Han S, Kondo N. Automation in Agriculture[M].New York: Springer Publishing Company, 2009.

[2]Ji Wei, Zhao Dean, Cheng Fengyi, et al. Automatic recognition vision system guided for apple harvesting robot[J]. Computers& Electrical Engineering, 2012, 38(5): 1186-1195.

[3]Si Yongsheng, Liu Gang, Feng Juan. Location of apples in trees using stereoscopic vision[J]. Computers and Electronics in Agriculture, 2015, 112: 68-74.

[4]Lu Jun, Nong Sang. Detecting citrus fruits and occlusion recovery under natural illumination conditions[J]. Computers and Electronics in Agriculture, 2015, 110: 121-130.

[5]Wang Chenglin, Zou Xiangjun, Tang Yunchao, et al.Localisation of litchi in an unstructured environment using binocular stereo vision[J]. Biosystems Engineering, 2016,145: 39-51.

[6]Lü Q, Cai J R, Liu B, et al. Identification of fruit and branch in natural scenes for citrus harvesting robot using machine vision and support vector machine[J]. Int J Agric&BiolEng,2014, 7(2): 115-121.

[7]Zhao Chuanyuan, Won Suk Lee, He Dongjian. Immature green citrus detection based on colour feature and sum of absolute transformed difference (SATD) using colour images in the citrus grove[J]. Computers and Electronics in Agriculture, 2016, 124: 243-253.

[8]Krizhevsky A, Sutskever I, Hinton G E. ImageNet classification with deep convolutional neural networks[C]//International Conference on Neural Information Processing Systems. Curran Associates Inc. 2012: 1097-1105.

[9]周云成,许童羽,郑伟,等. 基于深度卷积神经网络的番茄主要器官分类识别方法[J]. 农业工程学报,2017,33(15):219-226.Zhou Yuncheng, Xu Tongyu, Zheng Wei, et al. Classification and recognition approaches of tomato main organs based on DCNN[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2017,33(15): 219-226. (in Chinese with English abstract)

[10]杨国国,鲍一丹,刘子毅. 基于图像显著性分析与卷积神经网络的茶园害虫定位与识别[J].农业工程学报,2017,33(6):156-162.Yang Guoguo, Bao Yidan, Liu Ziyi. Localization and recognition of pests in tea plantation based on image saliency analysis and convolutional neural network[J]. Transactions of the Chinese Society of Agricultural Engineering(Transactions of the CSAE), 2017, 33(6): 156-162. (in Chinese with English abstract)

[11]孙俊,谭文军,毛罕平,等. 基于改进卷积神经网络的多种植物叶片病害识别[J]. 农业工程学报,2017,33(19):209-215.Sun Jun, Tan Wenjun, Mao Hanping, et al. Recognition of multiple plant leaf diseases based on improved convolutional neural network[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2017,33(19): 209-215. (in Chinese with English abstract)

[12]谭文学,赵春江,吴华瑞,等. 基于弹性动量深度学习神经网络的果体病理图像识别[J]. 农业机械学报,2015,46(1):20-25.Tan Wenxue, Zhao Chunjiang, Wu Huarui, et al. A deep learning network for recognizing fruit pathologic images based on flexible momentum[J]. Transactions of the Chinese Society for Agricultural Machinery, 2015, 46(1): 20-25. (in Chinese with English abstract)

[13]Szegedy C, Liu W, Jia Y, et al. Going deeper with convolutions[C]//IEEE Conference on Computer Vision and Pattern Recognition, 2015: 1-9.

[14]Zeiler M D, Fergus R. Visualizing and understanding convolutional networks[J]. In: Fleet D., Pajdla T., Schiele B.,Tuytelaars T. (eds) Computer Vision – ECCV 2014. ECCV 2014. Lecture Notes in Computer Science, vol 8689. Springer,Cham, 2014.

[15]Bargoti S, Underwood J P. Image segmentation for fruit detection and yield estimation in apple orchards[J].Journal of Field Robotics, 2017, 34(6): 1039-1060.

[16]傅隆生,冯亚利,ElkamilTola,等. 基于卷积神经网络的田间多簇猕猴桃图像识别方法[J]. 农业工程学报,2018,34(2):205-211.Fu Longsheng, Feng Yali, ElkamilTola, et al. Image recognition method of multi-cluster kiwifruit in field based on convolutional neural networks[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2018, 34(2): 205-211. (in Chinese with English abstract)

[17]Sa I, Ge Z, Dayoub F, et al. DeepFruits: A fruit detection system using deep neural networks[J]. Sensors, 2016, 16(8):1222.

[18]熊俊涛,刘振,汤林越,等. 自然环境下绿色柑橘视觉检测技术研究[J]. 农业机械学报,2018,49(4):45-52.Xiong Juntao, Liu Zhen, Tang Linyue, et al. Visual detection technology of green citrus under natural environment[J].Transactions of the Chinese Society for Agricultural Machinery, 2018, 49(4): 45-52. (in Chinese with English abstract)

[19]Liu Wei, Anguelov D, Erhan D, et al. SSD: Single shot multiBoxdetector[J]. European Conference on Computer Vision, 2016: 21-37.

[20]Fu Chengyang, Liu Wei, Ranga Ananth, et al. Dssd:Deconvolutional single shot detector[EB/OL]. [2017-01-23].https://arxiv.org/abs/1701.06659.

[21]Cao Guimei, Xie Xuemei, Yang Wenzhe, et al.Feature-Fused SSD: Fast detection for small objects[EB/OL].[2017-09-15]. https://arxiv.org/abs/1709.05054.

[22]Li Zuoxin, Zhou Fuqiang. FSSD: Feature Fusion Single Shot Multibox Detector[EB/OL]. [2017-12-04]. https://arxiv.org/abs/1712.00960.

[23]Chen Yunpeng, Li Jianshu, Zhou Bin, et al. Weaving multi-scale context for single shot detector[EB/OL].[2017-12-08]. https://arxiv.org/abs/1712.031497.

[24]Everingham M, Gool L, Williams C K, et al. The pascal visual object classes (voc) challenge[J]. Int. J. Comput.Vision, 2010, 88(2): 303-338.

[25]Ren S, He K, Girshick R, et al. Faster R-CNN: Towards real-time object detection with region proposal networks[C]//International Conference on Neural Information Processing Systems. MIT Press, 2015: 91-99.

[26]Neubeck A, Gool L V. Efficient non-maximum suppression[C]// International Conference on Pattern Recognition, 2006, 3: 850-855.

[27]Simonyan K, Zisserman A. Very deep convolutional networks for large-scale image recognition[EB/OL].[2014-09-04]. https://arxiv.org/abs/1712.031497.

[28]Sergey I, Christian S. Batch normalization: Accelerating deep network training by reducing internal covariate shift[EB/OL].[2018-03-02]. https://arxiv.org/abs/1502.03167.

[29]He K, Zhang X, Ren S, et al. Identity mappings in deep residual networks[J]. In: European Conference on Computer Vision. Springer International Publishing, 2016: 630-645.

[30]Glorot X, Bengio Y. Understanding the difficulty of training deep feedforward neural networks[J]. Journal of Machine Learning Research, 2010, 9: 249-256.

[31]Yosinski J, Clune J, Bengio, et al. How transferable are features in deep neural networks [J]. Proceeding NIPS'14,2014, 2: 3320-3328.

[32]Jia Yangqing, Evan Shelhamer, Jeff Donahue, et al. Caffe:Convolutional architecture for fast feature embedding[J].ACM International Conference on Multimedia, 2014: 675-678.

[33]Léon Bottou, Olivier Bousquet. Learning Using Large Datasets, Mining Massive DataSets for Security[M]. NATO ASI Workshop Series, IOS Press, Amsterdam, 2008:15‒26.