基于三维视觉的服装信息智能提取方法*

于述平

(大连艺术学院 服装系, 辽宁 大连 116600)

服装自动化生产是服装生产企业的发展趋势,在平常的服装生产场景中,服装的摆放状态通常不整洁,表面容易出现褶皱,为服装图像二维信息提取带来了困难,影响后续的服装智能化生产.智能三维图像处理技术的不断改进,为服装信息的智能提取提供了技术支持.三维图像处理是多角度视觉、多负载模型、多时间相位和多方向传感等技术的统称,用来观测大覆盖面积的事物,可做到精细信息的高强度提取[1].

目前,通过空间定位的服装信息智能提取方法有很多,文献[2]引入了光学定位技术,通过光学摄像机从服装的顶部开始进行图像拍摄,借助定位系统扫描服装图像,对扫描信息进行处理后即可提取出服装信息,这种方法随着倾斜角定位技术的兴起而被逐渐取代;文献[3]阐述了基于倾斜角定位技术的智能提取方法,比起光学定位技术,其在处理服装信息遮挡方面表现出更高的精度,但在实际使用中由于要不断变更观测角度,操作难度很大.由此可知,服装三维信息提取需要一种简易且观测精准的多角度视觉技术,欧洲一些国家曾投入大量资金用于研究符合这种要求的提取方法,如文献[4-5]使用的人工视觉和单目序列技术,但至今为止,高度可靠的服装信息智能提取方法仍十分少见.

三维视觉是空间遥感中相对成熟的技术之一,具备良好的立体观测潜力,因此,本文提出一种基于三维视觉的服装信息智能提取方法.基于三维视觉拍摄到的服装图像,其优点较为明显,主要表现为信息采集点方位清晰、背景干扰易于去除等,通过评价图像对比度视觉强弱关系进行三维图像分割,其运算量小,空间干扰低,信息提取结果准确度高.

1 智能提取方法

1.1 设计方法总体流程

基于三维视觉的服装信息智能提取方法将企业生产过程中的服装成品设为研究对象,图1为方法总体流程图.

图1 方法总体流程图Fig.1 Overall flow chart of method

通过三维视觉采集服装图像时,人为手动开启三维视觉成像系统,提取视频中含有服装结构和材质的重点帧,通过分析帧的先后顺序组成三维视觉服装图像[6].一方面对重点帧进行像素估计,获取图像背景和前景的估计结果;另一方面将图像切割成块并分析图像像素视觉的强弱关系,在切割块的基础上计算并优化三维图像的显著性.将背景估计结果和显著性计算结果相融合,并设置阈值进行结果校准,最终提取出服装信息.

1.2 基于聚类技术的三维视觉图像切割方法

基于三维视觉的图像切割方法将三维视觉图像看成一张无方向图[7],设G=(V,E),V为服装结构顶点像素集合,其内部元素为vi;E为服装边线集合,其内部元素为vj.两个结构顶点用一条边线连接,称为边线段,其关系式为(vi,vj)∈E,边线段(vi,vj)在集合E中的比重大于或等于零,比重为w,它取决于两个结构顶点之间的特征差值,可由灰度和色彩度等特征入手求取.

三维视觉图像切割块集合为S,其定义是:服装结构顶点像素集合V经由S被切割成数目不定的切割块C,C∈S,切割后三维视觉图像被转化成新的无方向图,用G*=(V,E*)表示,E*为E的子集[8].最好的切割结果是切割块中所有服装结构顶点的像素比重越小越好,服装边线比重则越大越好.三维视觉通过聚类技术把特征相似的结构顶点融合在一起,使用最小生成树构造最小比重像素树,获取顶点边线,完成三维视觉服装图像切割,得到最佳切割块集合.

聚类技术从三维视觉服装图像的最高结构顶点开始进行融合,需要应用到图像的色彩度,分别用(r1,g1,b1)和(r2,g2,b2)表示两个最高的结构顶点坐标,其间距为

(1)

在三维视觉图像中,两点之间的距离可直接用来评价块与块之间的特征差值,大致切割出图像特征区域.图2为三维数据图像皱褶区、平整区、高聚集区的聚类前像素点示例图,可以看到未经聚类技术处理之前,高聚集区的特征差值独立区过小,皱褶区的切割块之间难以分离,仅平整区的切割效果可用,这些情况不利于进行服装信息精准提取[9].

聚类技术为了改善以上不利情形,采用自适应方法计算三维视觉服装图像的像素差值,设图2切割结果中某一个切割块C的个体像素差值等于其服装边线比重最大值,也就是极大像素差值,即

Int(C)=MAXC∈G(C,E),w(C)

(2)

两个切割块C1和C2之间的像素差值等于服装结构顶点比重最小值,其表达式为

Dif(C1,C2)=MINvi∈C1,vj∈C2,w(vi,vj)

(3)

如果C1和C2之间不相邻,则有

Dif(C1,C2)=∞

(4)

式(2)、(3)中定义的像素差值需要进行匹配分析,确定切割块C1和C2是否应该融合,匹配分析函数表达式为

图2 色彩度特征切割示例图Fig.2 Cutting examples of color degree features

(5)

式中:true为“应该融合”;false为“不应该融合”;MInt(C1,C2)为利用最小生成树构造最小比重的像素树,其表达式为

MInt(C1,C2)=MIN[Int(C1)+τ(C1),

Int(C2)+τ(C2)]

(6)

由式(5)计算可得,“不应该融合”的原切割块应列队进入G*=(V,E*).

1.3 基于对比度的显著性计算

色彩度特征切割是在三维视觉服装图像RGB色彩模式上进行的,显著性则需要在Lab(颜色模型)上进行计算[10],这期间包含一个将RGB转换成Lab的坐标更替过程,切割块坐标也随之自动变化.设PK、PL为三维视觉服装图像P的像素和亮度,坐标更替函数表达式为

(7)

式中:D()为坐标距离度量;m为像素点数量.

图3为RGB同Lab的坐标转换原理图.由图3可以获取Lab坐标的取值范围,其中,L为亮度,也就是黑白单色,取值为0~100;a为红绿色彩区间,取值为-130~130;b为黄蓝色彩区间,取值同红绿色彩区间.

图3 RGB同Lab的坐标转换原理图Fig.3 Principle diagram of coordinate conversion between RGB and Lab

三维视觉服装图像的对比度定义为任意像素点Ci与其他像素点Cj的色彩度距离总和[11].由对比度定义可知,色彩度一致的像素点,其对比度显著性o(Ci)也是相同的,其表达式为

(8)

式中:n为三维视觉服装图像中色彩度总量;fi为像素点Ci色彩度的显示比重.

三维视觉服装图像的显示效果较好,色彩度总量高达上千种,使用式(8)进行计算过于浪费时间,可以通过图像平滑降低像素点对比度,对高频色彩着重定义,将低频色彩用平均色彩度聚众处理,这样色彩度总量可以降至100种以下[12].但上述过程出现的图像噪声也不容忽视,可采取计算加权平均值的方法减少图像噪声,则式(8)可转化为

(9)

基于对比度的显著性计算方法是在各个图像切割块中进行计算的,不但要进行单一像素点与其他像素点的比对,还要进行任意切割块与其他切割块的比对,这样才能提取出整个三维视觉服装图像的显著性信息.任意两个切割块Ri和Rj之间的色彩度像素距离为

(10)

式中:ni、nj为两个切割块的色彩度总量;f(Cm,i)为Ri中色彩Cm,i的显示比重;f(Cn,j)为Rj中色彩Cn,j的显示比重.

由于服装信息应从图像中间提取,因此,应增加中间区域色彩的显示比重,添加一个比重量,即

(11)

式中:|Rj|为切割块中的所有像素点;σ为比重调整参数.

根据式(10)、(11),切割块之间的显著性计算公式为

o(Ri)=w(Rj)Dr(Ri,Rj)∑w(Rj)

(12)

1.4 基于高斯函数的背景参数估计

像素估计是由于三维视觉服装图像中背景严重干扰了服装信息的提取精度而产生的去噪方法,像素估计分前景删除和背景估计.前景是要进行服装信息提取的目标区域,背景是前景的干扰信息.高斯函数定义了图像前景的像素分布规律,以此来区分前景与背景.

对服装生产视频中的事物来说,单位时间内动作变动小的最可能是服装信息提取的目标区域,由于机械设备的控制动作更加精细,每时每刻都在发生变动,服装只是机械设备的控制物体[13].高斯分布根据w/σ的比值关系对三维视觉服装图像中的像素点进行由大到小排列,利用排列规律关联背景的变动情况.排列在前端的高斯分布动作变动较大,因此是前景,设有N个前端数据,T为前景动作的阈值,删除前景便可得到背景估计结果,其表达式为

(13)

1.5 服装三维信息的智能提取

将背景估计结果和显著性计算结果融合,设置一个阈值进行服装信息提取结果校准,过程函数可表示为

(14)

式中:H为三维视觉成像系统的图像信息分布强度,一般与系统的运算速度有关,正常情况下H取值4或5;η(C)为阈值,在图像显著性被正确定义的前提下,其提取函数表达式为

(15)

其中,u为三维视觉成像系统允许的最大视觉偏差.

2 实验方法及分析

2.1 实验场景搭建

对本文提出的基于三维视觉的服装信息智能提取方法进行鲁棒性和三维填补效果的性能解析,利用倾斜角遥感法和单目序列法与本文方法进行对比,实验场景如图4所示,图右侧是一个三维视觉成像系统,左侧连接计算机进行服装信息的处理和显示.选择一段长度为2 h的连衣裙生产视频,事先建立出一个三维坐标系,以水平面为X轴,Y轴由北向南延伸,原点位于帧中点.三种服装信息智能提取方法各自使用的坐标系均由事先建立的坐标系转动形成,这样可以避免一部分实验测量误差.表1为实验程序试穿模型参数.

图4 实验场景图Fig.4 Experimental scene

身高cm体重kg胸围cm腰围cm肩宽cm臀围cm背长cm16350846839.59037

2.2 鲁棒性实验

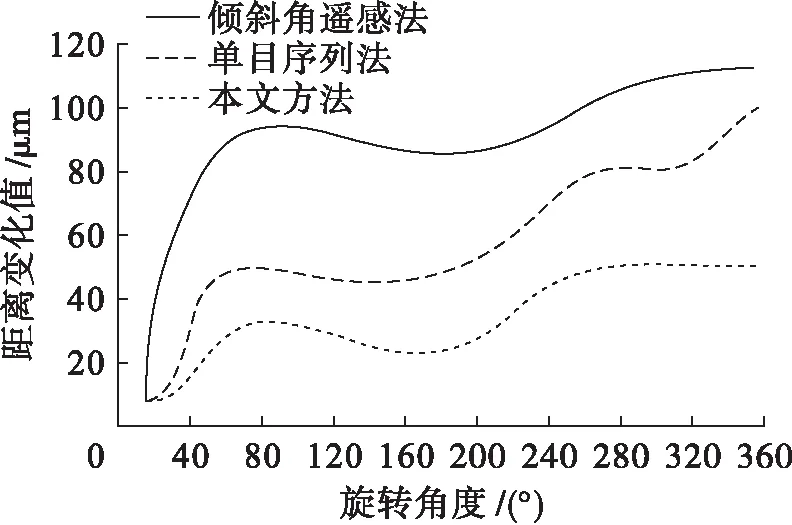

在解析服装信息智能提取方法鲁棒性的实验中,对三种方法使用的三维坐标轴进行旋转,获取服装信息提取结果的特征变化状态.当旋转Z轴和Y轴所处平面时,服装信息提取结果的特征变化将显示在X轴上,如果距离变动较大,那么相关方法则不能描述出服装信息的真实状态,表现为鲁棒性不强.

图5~7分别为特征变化显示在X轴、Y轴和Z轴上的记录曲线,所选取的旋转角度均从0°开始,至360°停止.

图5 X轴特征变化曲线Fig.5 Characteristic variation curves of X axis

图6 Y轴特征变化曲线Fig.6 Characteristic variation curves of Y axis

图7 Z轴特征变化曲线Fig.7 Characteristic variation curves of Z axis

从三个坐标轴的变化曲线中可以看到,Y轴的距离特征变化值最大,呈波动上升趋势,其次是X轴,呈波动下降趋势,Z轴呈现出的是一种近似周期性、小规模的特征变化.对于倾斜角遥感法和单目序列法来说,本文提出的三维视觉法距离特征变化值最小,鲁棒性最强.

三维坐标轴旋转会产生一定的误差,匹配度代表了服装信息智能提取方法对误差的排除程度,也是鲁棒性的一种解析指标.本文方法由于特征变化而产生的三维视觉特征匹配度为

Acc=U0/U

(16)

式中:U0为正确的特征匹配数量;U为特征总量.

计算三维视觉特征匹配度时,在各坐标轴的U0上引入旋转误差B,其表达式为

(17)

式中:M为坐标点数量;ρ为误差阶级;zc为M的高程数值;c为zc的序列.

计算出本文方法旋转三个坐标轴的三维视觉特征匹配度,并绘制成曲线图,结果如图8所示.本文方法在三个坐标轴上的匹配度受旋转误差影响不大,基本维持在0.9以上,表明其具有鲁棒性强的性能优势.

图8 本文方法匹配度曲线Fig.8 Matching degree curves of proposed method

2.3 三维填补效果实验

一般来说,将服装信息引入三维坐标系得到的三维信息结构容易因为服装材质光学性能的差异而减弱服装信息提取精度,对三维信息结构进行填补是服装信息智能提取方法必须拥有的基本性能.实验利用本文方法、倾斜角遥感法和单目序列法先对目标服装信息进行提取,获取服装信息测量特征值与目标特征值之间的间距,观察三种方法所提取信息特征点之间的密集程度,用来解析各方法的三维填补效果.

实验所用的服装信息在提取角度为30°、90°和180°时拥有结构、能量和相关性3个重要特征类型,相关提取信息结果如表2所示.

表2 服装信息特征点提取结果Tab.2 Extraction results of feature points of clothing information

将表2中目标特征值与测量特征值相减取绝对值,得到的三维填补效果解析数据如表3所示.

由表3给出的数据可知,本文方法所提取的信息特征点之间密集程度良好,表示其能够精准描述服装信息的局部特征细节,具有良好的三维填补效果.

表3 三维填补效果解析数据Tab.3 Analytic data of 3D filling effect

3 结 论

三维视觉具有像素清晰、运算量小、空间干扰度低等优点,本文研究了基于三维视觉的服装信息智能提取方法,同时应用了三维视觉成像系统、聚类技术、高斯函数、对比度、显著性等定义以及原理,通过实验解析了本文方法的性能优势.实验结果表明,在相同条件下与倾斜角遥感法和单目序列法相比,本文方法的鲁棒性更强,三维填补效果更好.