云架构技术在新华社视频技术体系中的探索与实践

文/傅新宇

以往,广电媒体多采用视音频系统与IT信息系统并行的技术架构,二者体系独立、分工明确、各自发展。而随着以虚拟化、云计算为代表的互联网技术的突飞猛进,以及传统媒体与新媒体融合发展的趋势越发明显,上述架构模式已经限制了广电媒体技术发展的空间,难以满足视频节目生产管理的灵活需求。

1.总体设计思路

1.1 利用IP化架构降低信号拓扑复杂度

广电媒体多采用SDI基带信号作为主要的视频信号台内传输方式。随着业务的发展,信号数量和带宽已经成为系统瓶颈。于是,将传统视音频系统进行IP化转型,通过IP交换网络来解决信号拓扑复杂度问题,就成为了一种直观可行的改良思路。

1.2 利用通用化设备降低成本

随着云计算的普及以及计算能力的突飞猛进,传统专业化设备的功能越来越多地被“通用设备+软件”所替代,实现在虚拟化平台或公有云平台上的部署也不再罕见。通用化设备的普及,大幅降低了设备采购成本和系统运维成本,同时提高了整个系统的兼容性和扩展性。

1.3 利用云架构整合新旧业务

传统广电媒体制播系统对安全性的要求非常高,制播网与互联网的隔离是一项非常重要的工作。新华社视频的核心业务是通讯社供稿,整体已经大幅度向互联网延伸。为了整合传统媒体业务和互联网媒体业务,新技术的采纳势在必行,而云架构就是新旧业务之间的桥梁。

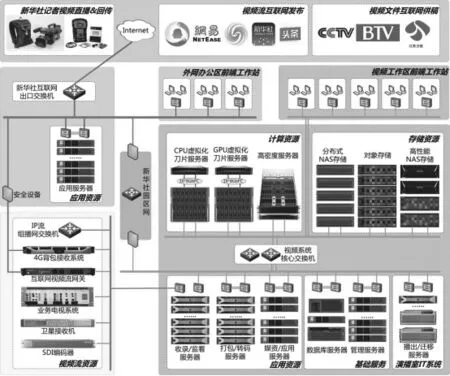

2.系统架构

新华社视频技术体系采用云架构设计,基于资源模块化思路进行规划,由基础网络、计算资源、存储资源、应用资源、基础服务资源、视频流资源等部分组成(图1)。

2.1 基础网络

各系统基于新华社整体网络规划构建,采用全以太网架构设计,交换机之间实现全万兆互联,前端实现千兆到桌面。网络设备选型均支持SDN,后期可根据需求平滑过渡到SDN网络。

图1 系统架构图

根据应用特点和业务需求,设备与应用部署在三个网络区域内,分别为绿色的视音频域网络、橙色的互联网域网络和黄色的视频组播流网络,区域间通过安全设备隔离。视音频域和互联网域之间通过新华社园区网实现业务层面的互联互通。互联网域通过新华社互联网出口交换机实现与全球互联网的通讯。

2.2 计算资源

计算资源包括CPU虚拟化刀片服务器、GPU虚拟化刀片服务器和高密度服务器,其中,刀片服务器挂载SSD固态盘光纤存储,并部署通用虚拟化软件。CPU刀片服务器为通用化应用服务提供计算资源;而GPU刀片服务器和高密度服务器则支撑轻量化非编、VDI等视频应用。

云架构计算资源的池化,大幅提高了系统的灵活性、扩展性和可靠性,同时也为系统在公有云上的部署进行了探索与实践。

2.3 存储资源

存储资源池汇聚了整个视频生产过程中的全部非结构化数据,存储设备全部基于以太网对外提供服务,并在域控服务器的支持下实现用户和资源的统一管理。分布式NAS存储采用支持横向扩展的全对称分布式架构,主要承担带宽密集型应用,比如非编网高码流数据的共享。

高性能NAS存储支撑IO密集型应用,存放热点视频、关键帧图片、低码流视频等需要快速浏览的文件,同时也作为虚拟化平台的备份数据存储而存在。

归档存储由磁带库和对象存储组成,是新华社视频媒资系统的核心,将高码流媒体数据数字化,高效便捷地实现了海量历史数据的在线共享。

2.4 应用资源

应用资源在视音频域网络和互联网域网络均有部署,其集成架构多为通用机架式服务器。视音频域多运行不适合虚拟化的专业类应用,如IP流收录和监看、视频打包与转码、媒资归档迁移等。同时,出于安全考虑,视音频域应用不能直接面对互联网提供服务,因此,部分应用就需要在新华社互联网域网络单独部署,如支撑新华社全球记者发稿的视频回传系统。

2.5 基础资源

基础资源池包含多种数据库服务器,汇聚了整个视频生产过程中的全部结构化数据,可同时为应用提供Oracle、SQL Server、MySQL等多种数据库服务。作为支撑关键业务的基础,服务器选型上采用了小型机和X86服务器两种平台异构并行的思路,同时所有相关网络和数据库服务均实现了高可用。上述设计思路使基础资源池能够高效、可靠、安全地满足应用资源池的性能要求。

视频流资源池采用了基于UDP组播的TS over IP千兆网络架构。整体基于IP地址管理,实现所有信号源的统一监看、收录和调度,简化了整个视频技术体系的信号拓扑复杂度。

信号源包括4G背包、手机、互联网视频直播流、新华社内部业务电视系统、卫星直播信号,地面专线直播信号、新华社视音频系统内SDI信号等。上述信号由各自接收设备在系统边界转换成统一格式的TS over IP流,接入IP流组播网交换机。收录和监看服务器通过双网卡分别连接视音频域网络和IP流组播网,实现信号的监看、收录和调度。这种“双网架构”既保证组播数据不会影响核心网络运行,又实现了视频信号数据的共享。

3.亮点及应用情况

3.1 轻量化非编

在传统广电媒体中,视频的主要交换方式是SDI信号,因此,主流非编工作站多采用了“工业化主机+广播级视音频板卡”的设计方式,运行于“以太网+SAN网”的双网网络架构上。非通用化的硬件设备,以及复杂的组网架构,导致系统的采购和运维成本居高不下,同时也严重制约了融合媒体生产背景下系统的灵活性。随着万兆网络的普及、NAS存储性能的提升及虚拟化技术的发展,非编“轻量化”之路已经可行。

新华社视频制作网系统前端部署瘦客户机,后端则由高密度服务器和GPU虚拟化两种方案并行提供计算资源,前后端之间通过远程图像传输软件实现操作及画面的交互。高码流数据存储在分布式NAS上,所有打包、渲染、转码工作均由应用资源池在后台完成。编辑、审片环节通过瘦客户机进行,上下载、精编和包装等环节使用系统内的有卡非编工作站完成。

高密度服务器是一套高集成度的X86架构服务器系统,集成GPU,全万兆交换,设备包含并融合了传统服务器中的计算、网络、管理、散热等各种资源,可以用适当的经济成本和空间成本提供满足业务需求的计算能力。

GPU虚拟化方案则是将显卡通过PCIe接口插到服务器刀片上,通过GPU直通或GPU虚拟化技术,将显卡资源绑定在虚拟机上,用于图形或视频编辑渲染。本次选择了业内首次实现了GPU硬件虚拟化的nVidia GRID K2图形加速卡,单个刀片服务器机框可配置32颗高性能GPU,极大地提高了应用密度。

经业务部门实际应用,无论是高密度服务器方案还是GPU虚拟化方案,轻量化非编均可以实现6轨100M高清视频的制作。日常编辑场景下,前端瘦客户机与后端计算资源之间通讯所占用的网络带宽为20~100 Mbps,对前后端网络质量的要求较低,利于前端设备的灵活选择与部署。

3.2 收录及发布IP化

轻量化非编引领的视频设备通用化是视频技术体系全IP化的先驱,但专业视音频板卡的缺失也意味着信号的收录、分发等一系列流程都必须做出相应调整。新华社采用了“IP信号+基带信号”并行的方式,分阶段完成了整个系统的IP化。IP信号通过以太网交换机进行交换,基带信号通过视音频矩阵进行交换,架构清晰,稳定可靠。目前,阶段实现的是收录及发布流程的IP化。

作为通讯社,视频的供稿及发布是其主要业务。新华社视频互联网供稿系统已稳定运行多年,并逐步替代了传统卫星供稿方式。而在视频信号的直播发布业务上,系统配备了基于IP的互联网视频流网关设备,连通互联网和IP流组播网,可在互联网上对视频流资源池的所有信号进行传输和分发,对新媒体用户进行视频信号发布。2017年全国两会和十九大报道期间,新华社进行的“部长通道”“两会发布会”和“党代表通道”直播报道,向新华社客户端、腾讯、今日头条等多家主流互联网媒体提供了高清直播信号。

结语

新华社基于云架构的视频技术体系,通过对新兴技术的探索和实践可操作性的验证,创立了一条适合自身通讯社视频业务的技术路线。基于对整体架构和业务发展的统一规划,新华社有针对性地选取了“轻量化非编”和“收录及发布IP化”等应用场合进行了实践,为视频技术系统架构的发展方向做出了积极的探索,具有重要的借鉴意义。