非真实感绘制技术的发展综述

李本佳

摘要:随着深度学习浪潮的到来,图像领域获得了革命性的突破与发展,作为图像领域的重要组成部分,图像风格迁移技术也开始了新的篇章。生成对抗网络(Generative Adversarial Networks)作为图像风格迁移的一种新技术,对该领域带来了革命性的改变。该文针对非真实感绘制领域,分别对该领域内各种具有代表性的方法进行介绍,并给出相关的实验结果。同时重点介绍了生成对抗网络以及其相关分支并给出工业界的一些相关应用,最后对非真实感绘制技术的发展趋势进行展望。

关键词:生成对抗网络;图片抽象;图片融合

中图分类号:TP3 文献标识码:A 文章编号:1009-3044(2018)35-0188-03

1 概述

图像风格迁移技术涉及图像滤波、非真实感绘制以及图像融合等多个领域,具有非常广泛的用途。作为图像风格迁移技术的重要分支,非真实感绘制技术不仅和计算机技术息息相关,还有助于提高艺术领域的水平,降低艺术创作的门槛。近几年,随着深度学习的广泛应用,图像领域迎来了一波又一波突破性的变革,作为图像领域的重要分支,非真实感绘制技术也开启了新的篇章。

2 传统非真实感绘制技术

图像作为我们日常生活中广泛使用的信息介质,具有多重功能。针对社会各界的不同需求,往往会针对图像做出各种各样的改变,然而通过人力显然是一项庞大的工程。针对这些需求,学者们提出了一系列自动或者半自动的工程来完成图像风格的转变。1990年,Saito等人[1]最早提出非真实感绘制技术,其基本思路是从3D场景的几何属性中提取数据,导入到数据缓冲区并执行图像处理操作。随着时代的前进,已经陆续开发了很多非真实感绘制技术。这些方法大多使用图像过滤或者通过数据公式对图像进行优化。在基于图像过滤的非真实感绘制技术中,最具有代表性的是2006年,Holger等人[2]等人提出的实时抽象方法,该方法使用近似各方向扩散的方法来降低低对比度区域的对比度,并且在具有高斯边缘差异的较高对比度区域中人为地增加对比度。抽象步骤是可扩展的,允许艺术或数据驱动的控制。可以选择使用软颜色量化来对抽象图像进行风格化,以产生具有良好时间相干性的类似卡通效果。同时,在基于梯度最小化的非真实感绘制技术中,最典型的方法是Xu[3]等人提出的通过L0梯度最小化的图像平滑技术来进行图像风格转换。该方法主要通过增加过渡的陡度来锐化主要边缘,同时消除了可控制程度较低的低振幅结构,并利用L0进行梯度最小化。

虽然现有的传统非真实感绘制技术具有不错的效果,但是依然具有很多缺陷。传统的非真实感绘制技术只能简单而粗略地对图片进行处理,在具体的转换风格和图片细节方面做得不够准确。

3 生成对抗网络技术

2012年,Alex等人[4]在ImageNet分类挑战赛中赢得了冠军,其使用的卷积神经网络模型迅速提升了图像识别性能,产生了重大的影响,开启了深度学习的浪潮。 2014年,Goodfellow等人[5]提出了模型对抗式的新生成模型架构,命名为生成对抗网络(Generative Adversarial Networks),该技术在图像生成、数据增强、非真实感绘制技术等多个领域均有广泛的用途。

3.1 生成对抗网络

机器学习总共包含两类模型,一种是判别模型(discrimination model),判别模型由特定的网络结构的组成,模型会通过模型进行不间断的训练来对输入的种类进行分辨。另一种是生成模型(generative model),其基本思路是通过给定输入,通过模型的训练来逼近数据的原始概率分布。

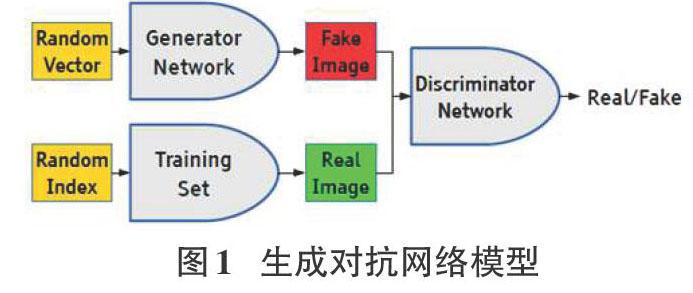

生成对抗网络采用了真实样本与生成器之间相互博弈,达到均衡的目的来训练生成网络。整个网络主要包含两个模型,一个是生成模型,另一个是判别模型。这两个模型是相辅相成的,生成器的输出反馈给判别模型,而判别器的输出再反馈到生成的模型。其具体思路是给定输入数据,设定好生成器的概率分布,通过一个噪声函数进行控制。这样就可以通过生成器将输入映射到一个模仿出的样本中,将该样本作为判别模型的输入。提取生成模型的输出和真实图像一起作为判别模型的输入,看是否满足判别器的条件,如果不满足则继续进行训练,知道满足条件为止。根据文献[5],我们可以看到整个网络结构:

通过图1所示的生成对抗网络模型,我们可以了解到生成对抗网络的工作流程。首先通过生成器产生fake image,然后将fake image和real image进行混合,并通过判别器进行判断并进行反馈。GAN的优化是real image和fake image相互博弈的问题,最终的目的是生成器的输出给判别器时很难判断是真实或者伪造的,即极大化判别器的判断能力,极小化将生成器的输出判断为伪造的概率。由于生成对抗网络包含两个网络,而其输出和输入彼此相关,因此生成对抗网络中的两个模型训练的方法是单独交替迭代训练,并相互关联。

生成对抗网络具有非常卓越的优越性。当真实数据具有不确定性时,往往不方便进行具体的计算,而传统的机器学习模型无法直接应用。但是生成对抗网络依旧可以运用,这是由于生成对抗网络引入了内部对抗的训练机制,能够逼近一下难以计算的概率分布。更为重要的,深度学习领域专家们一直积极提倡生成对抗网络在各方面的应用,甚至认为生成对抗网络是当前最有趣的贡献,其原因主要是因为生成对抗网络为无监督学习做出了巨大的贡献,为强人工智能打下了坚实的基础。

3.2 生成对抗网络改进模型

基于生成对抗网络的原理,更多关于生成对抗网络的变体以及其相关领域的技术如雨后春笋般浮现,短短几年,相关技术的论文已经到达了上百篇。特别是針对图像风格转换,出现了许多效果非常棒的模型。

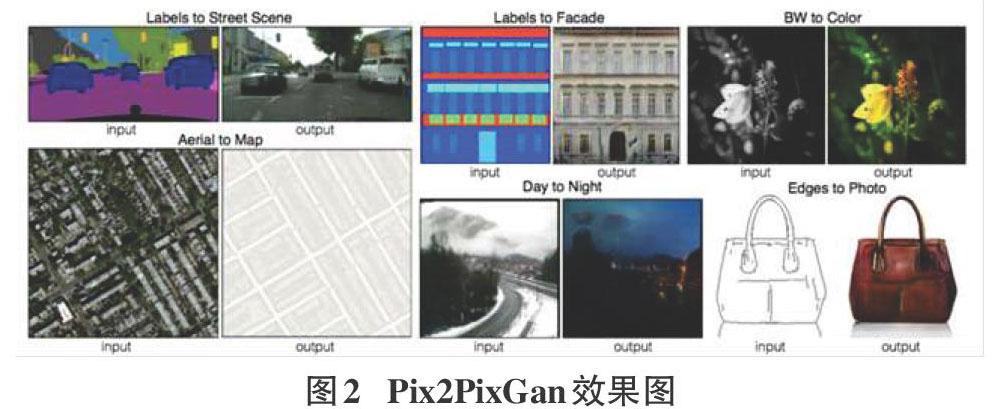

2016年,文献[6]提出了一种名为Pix2PixGan的技术。普通的生成对抗网络接收的生成器部分的输入是随机向量,输出是图像;判别器部分接收的输入是图像(生成的或是真实的),输出是对或者错[6]。基于这个原理,生成对抗网络就可以得到目标作品。但对于图像翻译任务来说,它的生成器输入显然应该是一张图x,输出当然也是一张图y。但是为了使对比更加明显,更容易转换,在新技术中提出了要求,即判别器的输入应保证生成的图像和输入图像是相互适配的。于是在新技术中,对判别器的输入部分进行了改进,使其变成一个损失函数。通过文献[6]中的实验结果,可以看出Pix2PixGan的效果图:

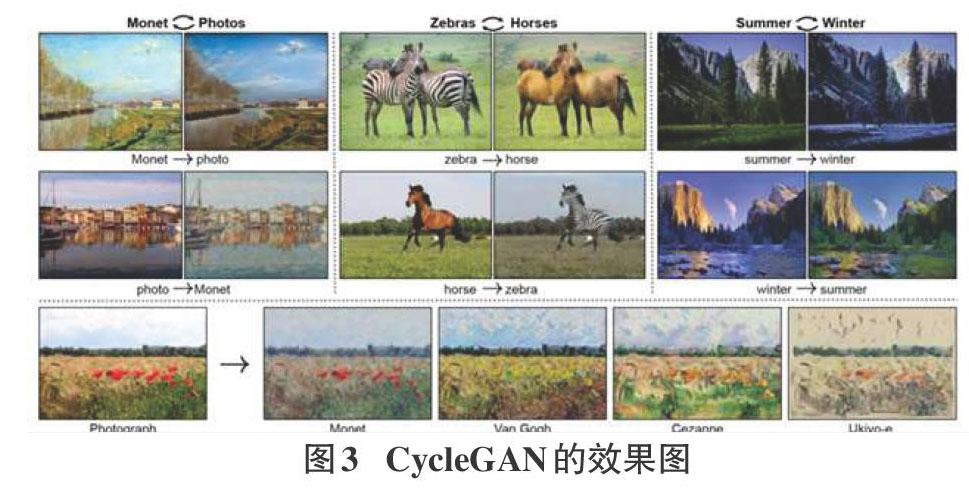

CycleGAN由两个相互连接的单向生成对抗网络。两个单向生成对抗网络共享两个生成器,然后各自带一个判别器。一个单向生成对抗网络有两个loss。由于该模型架构组成了一个环,故命名为CycleGan。CycleGan通过两个单向生成对抗网络解决了Pix2PixGan需要两个图片相同标准的不足,提高了应用的范围。CycleGan具有很优秀的效果,通过该技术可以应用到各个领域,例如男人图片变成女人图片,苹果变成橘子等等有意思的应用。通过文献[7]中的实验结果,可以看出CycleGAN的效果,如图3所示。

2018年,计算机视觉顶级会议IEEE Conference on Computer Vision and Pattern Recognition接收了一篇名为CartoonGAN[8]的论文,该论文可以自动将真实世界的照片转换为具有特定作画风格的漫画风格。该技术对于画师来说是非常有帮助的一件事:这可以为他们节省大量时间,让他们专注于更有意义和创造性的工作,风格迁移工具也可以为 Instagram 和 Photoshop 等图像编辑软件提供新功能[8]。CartoonGan在传统的生成对抗网络架构的基础上,改进了两种具体的损失函数,使该网络架构可以更好地适配出漫画所存在的细节和特质。其核心的转变主要体现在定义了一种名为?1的稀疏正则化的损失衡量标准,同时为了确保漫画边缘风格细节的质感,对图片进行增强边缘对抗的处理。通过文献[8]中的实验结果,可以看到CartoonGan的效果图以及与其他相关技术的效果对比:

4 非真实感绘制技术的应用与展望

如今,非真实感知技术已经成熟应用于工业界,带来了巨大的效益。狭义上来说,非真实感绘制技术可以使广大用户方便地将目标图片转换成各种其他风格的图片。同时,不同风格之间的转换,对于画师来说更是一项非常有利的工作,因为很多时候存在很多费时费力却又不得不做的工作。广义上来说,非真实感绘制技术还可以应用在从低分辨率图像得到高分辨率图像的转换上,场景图片和标签图片之间的相互转换,环境的色调转换,艺术品与真实图片之间的转换(油画与真实图片的转换、漫画与真实图片的转换、素描与真实图片的转换),黑白照片转换彩色照片等。

虽然深度学习技术越来越成熟,但是现有方法依然有一些缺陷不可避免。现有的模型方法大多存在较多的超参数,不同的超参数设定会导致很多不同的结果,正因为超参数的不确定性,导致很多技术复现不了很好的效果。下一步非感知绘制技术的发展应该进一步减少超参数的数量,以更加合理的参数数目来提高模型的优越性。

5 总结

本文介绍了非真实感绘制技术的发展历程,介绍了当前领先的生成对抗网络,并对其中具有代表性的方法进行了详尽的介绍和分析。非真实感绘制技术会随着时代的发展越来越被社会各界所需要,而其相关的技术也会发展得越完善。

参考文献:

[1] Saito T, Takahashi T. Comprehensible rendering of 3-D shapes[C].Conference on Computer Graphics & Interactive Techniques. ACM, 1990:197-206.

[2] Holger Winnem?ller, Olsen S C, Gooch B. Real-time video abstraction[C].AcmSiggraph. ACM, 2006:1221-1226.

[3] Xu L, Lu C, Xu Y, et al. Image smoothing via L0 gradient minimization[C].Siggraph Asia Conference. ACM, 2011:1-12.

[4] Krizhevsky A, Sutskever I, Hinton G E. ImageNet classification with deep convolutional neural networks[C]. International Conference on Neural Information Processing Systems. Curran Associates Inc. 2012:1097-1105.

[5] Goodfellow I J, Pouget-Abadie J, Mirza M, et al. Generative Adversarial Networks[J]. Advances in Neural Information Processing Systems, 2014, 3:2672-2680.

[6] Isola P, Zhu J Y, Zhou T, et al. Image-to-Image Translation with Conditional Adversarial Networks[J]. 2016:5967-5976.

[7] Kim T, Cha M, Kim H, et al. Learning to Discover Cross-Domain Relations with Generative Adversarial Networks[J].south korean intelligence information system institute of academic conference, 2017.

[8] YANG C, YU-Kun L,YONG-Jin L. CartoonGAN: Generative Adversarial Networks for Photo Cartoonization[C]. IEEE Conference on Computer Vision and Pattern Recognition,2018.

[通聯编辑:代影]