基于互信息最大化正则的生成式对抗网络

浦煜,王晓峰

(上海海事大学信息工程学院,上海 201306)

基于互信息最大化正则的生成式对抗网络

浦煜,王晓峰

(上海海事大学信息工程学院,上海 201306)

目前生成式对抗网络(GAN)面临的一大难点是模型训练过程中普遍存在着不收敛性,其最为突出的表现即“模式坍塌”现象,从而导致生成的目标对象缺乏多样性。首先从信息论角度简要解释原始GAN的理论方法,在此基础之上,提出一种基于互信息最大化的正则方法,通过最大化随机噪声变量和生成样本之间的互信息,为生成网络的目标函数提供一个上界函数,迫使生成的数据分布更加趋于真实数据分布。对MNIST手写字符数据进行的实验结果表明,引入互信息正则,有助于提升生成样本的多样性。

生成式对抗网络;模式坍塌;多样性;互信息;上界函数

0 引言

近些年来,随着深度学习技术的发展,无监督学习作为机器学习的一大分支也进步斐然。尽管在大部分情况下,有监督学习比无监督学习能获得更好的效果,但是在实际应用中,有标注的数据是相对较少的,因此,如何从海量的无标注数据中抽取高阶的数据表征是人工智能领域的核心问题。最近,以生成式对抗网络[1](Generative Adversarial Nets,GAN)为代表的深度生成模型为解决这一问题提供了新的计算框架。

生成式对抗网络的思想启发自博弈论中的零和博弈(zero-sum game),博弈双方分别由生成式模型G(generative model)和判别式模型 D(discriminative mod⁃el)充当。G通过将输入的随机噪声映射为新的样本数据,来捕捉真实训练样本的概率分布;而D本质上是一个二分类器,用于判别输入的样本数据是采样自训练集还是生成的样本集,通过交替训练D和G的参数化网络,两个模型都会得到提升,最终生成的数据分布会收敛于真实数据分布。目前,GAN已经在多项任务中展现了它们的潜力,如图像生成[2-4],超分辨率图像重建[5],3D对象生成[6]和视频预测[7]等应用。

与传统的生成模型[8-10]相比,GAN不需要真实数据的先验知识和复杂的建模过程,具有明显的优势,但是它过于自由的训练方式带来的缺点也很明显,例如训练过程不稳定,对于参数极其敏感。除此之外最为突出的问题即“模式坍塌(mode collapse)”现象:生成的数据分布无法去拟合真实分布的完整流形[11,12](仅仅生成了“子流形”)导致样本集中在少数几个模态上。为了稳定GAN的训练过程,国内外的研究者提出了一系列改进方法。在理论框架层面,Mirza和Osindero[13]等人通过引入一个数据标签向量同时作为G和D的额外输入,将纯无监督学习变成半监督学习,明显提升了训练的稳定性,虽然改进方式较为直接,但效果显著。Nowozin[14]等人从距离度量的角度出发提出并证明了GAN的优化目标可以泛化为某种f-divergence的最小化问题,为GAN的理论解释提供了新的思路。最近,DJ Im[15]等人通过同时训练多个GAN,让它们的判别模型D交替去判别其他生成模型G产生的样本,使得到的样本不易丢失模态,但计算代价过于庞大。此外,在训练技巧层面,Radford[2]等人基于深度卷积网络提出了DCGAN模型,针对GAN这种不稳定的学习方式,作者引入了步长卷积,批规范化等技术,使得训练过程更加可控,这一工程性的突破也让DCGAN成为后续研究者工作的基础框架。Salimans[16]等人提出了特征匹配、单边标签平滑(One-sided Label Smoothing)和minibatch discrimination等一系列策略来提高模型的鲁棒性,并且在半监督分类问题上取得较好的效果。

与以上工作不同的是,本文在Ferenc Huszár[17]和Yingzhen Li[18]等人的基础上从信息论角度去阐述生成对抗网络。生成模型G和鉴别模型D的相互竞争本质上可以看成标签和样本之间互信息的最小化,原始的目标函数只是最小化互信息的下界而非上界,因此我们在此基础上再次引入一个互信息正则项,最小化其上界函数,实验证明这种方法可以有效解决“模式坍塌”问题,生成更具多样性的样本。本文工作和Xi Chen[19]等人提出的InfoGAN相关,他们通过拆解GAN先验的方式,对噪声分布的隐变量加以约束,使其学习更加解构的

数据表示,从而生成的结果具有可解释性,而本文更加注重生成样本的多样性,避免模态单一化。

1 GAN的形式化描述

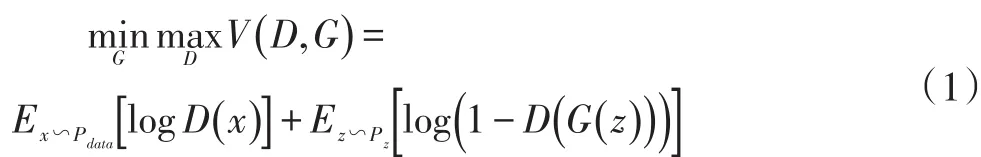

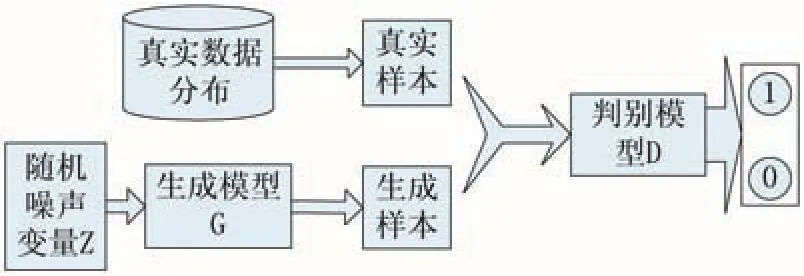

原始GAN模型的基本框架如图1所示,其主要目标是迫使判别模型D辅助生成模型G产生与真实数据分布相似的伪数据,其中G和D一般为非线性映射函数,通常由多层感知机或卷积神经网络等网络结构来形式化。给定随机噪声变量z服从简单分布Pz(z)(常为均匀分布或高斯分布),生成模型G通过将z映射为G(z)隐式地定义了一个生成分布Pg来拟合真实样本分布Pdata。判别模型D作为一个二分类器,分别以真实样本x和生成样本G(z)作为输入,以一个标量值作为概率输出,表示D对于当前输入是真实数据还是生成的伪数据的置信度,以此来判断G生成数据的好坏。当输入为真实训练样本x∽pdata时,D(x)期望输出高概率(判断为真实样本),当输入为生成样本G(z)时,D(G(z) )期望输出低概率(判断为生成样本),而对于G来说要尽可能使D(G(z) )输出高概率(误判为真实样本),让D无法区分真实数据和生成数据。两个模型交替训练,从而形成竞争与对抗。整个优化过程可以视为一个极小极大博弈,表达式如下:

然而,在实际训练过程中,(1)式中D(G(z))在初始时值很小,导致log(1 -D(G(z) ) )的梯度趋向于饱和状态,所以为了避免梯度消失的情况,本文采用(2)式去优化G。

图1 GAN模型结构图

2 基于互信息最大化正则的GAN

2.1 GAN的信息论解释

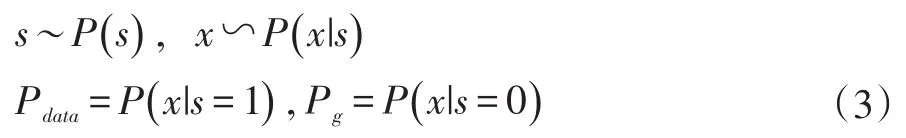

令s∈{0 ,1}表示样本标签,当s=1时,以真实样本作为判别模型D的输入,反之s=0时,以生成模型G生成的样本作为D的输入。用数学语言描述如(3)所示:

其中P(s)为s的先验,由于取值的等可能性,服从参数为0.5的伯努利分布;x表示输入的样本。从第一节可知GAN的理想目标是使生成样本的分布Pg与真实数据的分布Pdata相一致,即D判断输入样本的真假与标签信息s无关。在信息论中,互信息可以衡量两个随机变量之间的相关性。对于给定的两个随机变量X和Y,它们之间的互信息如(4)式所示:

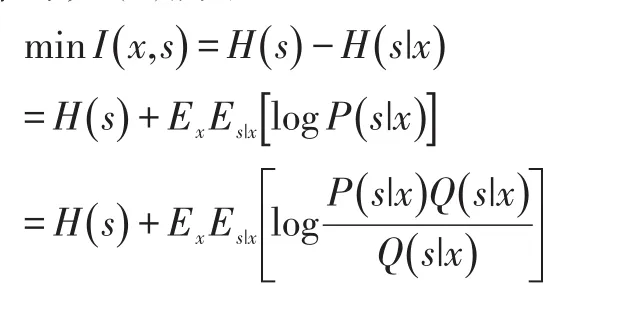

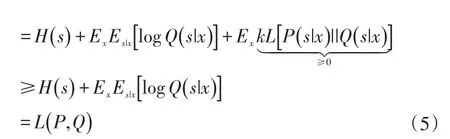

其中,H()表示随机变量的熵值。当X和Y的相关性越强,它们之间的互信息就越大。为此可以通过最小化样本标签变量s和样本变量x的互信息来消除其之间的相关性。由于P(x|s)是未知的,无法直接计算,根据变分推断[20]的理论得到互信息的下界函数,具体推导如(5)所示:

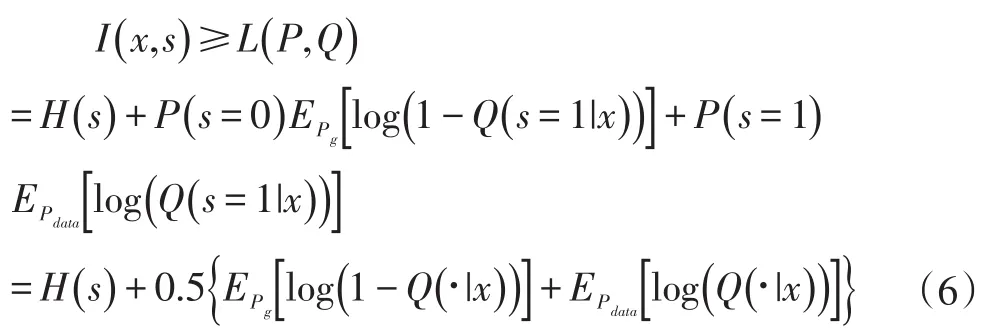

由此得到互信息I(x,s)的下界L(P,Q)。其中,Q(s|x)为引入的参数分布,可以视为对s后验分布P(s|x)的近似,当两者相一致时,kL距离为零,L(P,Q)取得最大值。进一步地,若将辅助分布Q(s|x)视为一个判别模型网络,(5)式可以展开成(6)式:

其中,由于s的分布已知,H(s)则为固定值。很明显(6)式的第二项即是GAN最小化的目标函数(见(1)式)。换句话说,GAN实际上最小化的是互信息的下界函数而非互信息本身,显然这会带来一定偏差,因为相比下界最小化上界函数可以获得更加紧的界,以至于模型能更好地收敛到稳定点。

2.2 引入互信息最大化正则

为了抵消上述优化目标带来的不稳定因素,本文方法受InfoGAN[19]的启发,引入一个额外的互信息损失函数作为正则项。在朴素的GAN模型中,生成模型G的输入是一个连续的噪声分布z,由于缺少约束,G将会以高度纠缠的方式将若干个不同的输入z映射到相同的生成样本G(z),导致G(z)仅仅依赖于z的少数维度,从而生成的分布只是真实数据分布的“子分布”。为此,我们利用互信息来约束z,让I(z,G(z) )最大,使z的每一个维度都尽可能与G(z)产生特定的对应关系,迫使G(z)生成的分布更加趋近于真实分布。而Info⁃GAN认为生成模型G的输入应由噪声分布z和一组隐变量c组成,通过最大化隐变量c与生成数据的互信息,使得控制c的变化,能生成可解释的图像特征。

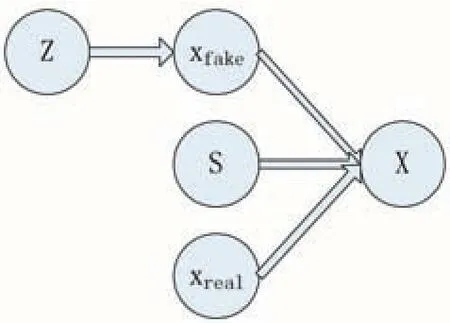

图2所示的是GAN的概率图模型。其中,z是随机噪声变量满足简单的连续分布,s是样本标签,xreal是真实的数据样本,xfake是生成的样本,x表示鉴别器D的输入样本,其值取决于标签s,当s=1时,x即为真实样本,当s=0时,x则为生成的样本。由上文可知,需要最大化z和G()z的互信息。

图2 GAN概率图模型

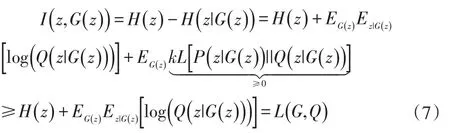

同样的,由于z的后验P(z|G(z) )无法计算,所以I(z,G(z) )很难直接最大化,根据变分推断的理论,可以得到其下界函数如(7)式所示:

其中,Q(z|G(z))可视为P(z|G(z))的近似后验。由2.1节可知GAN的理想目标是最小化I(x,s),则引入最大化正则后的目标函数可以表达成(8)式:

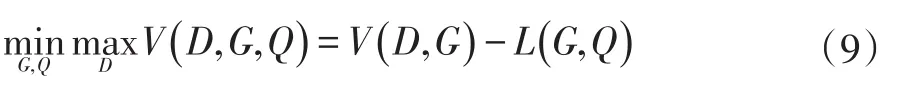

当优化(8)式的第一项,实质上是最小化其互信息的下界,而优化其第二项时,由于有负号,最大化其下界等同于最小化其上界,结合(1)(5)(6)(7)(8)式,本文方法实际优化的目标如(9)所示:

具体的算法描述如下:

输入:随机噪声分布Pz(z);真实样本;判别器D的迭代次数k(默认为1),学习率l1;生成器G的学习率l2;采样维度m。

输出:D的网络参数w,G的网络参数θ。

Step0:初始化:w0,θ0。

Step1:whileθ未收敛 do

Step2:D :Forj=0,1,2,…,kdo

Step3: 从随机噪声分布Pz(z)中采样m个噪声样本

Step4: 从真实数据分布Pdata中采样m个数据样本

Step5:

Step6:w←w+l1∙Adam( )w,dw

Step7: end for

Step8: G:从随机噪声分布Pz()z中采样m个噪声样本

Step9:

Step10:θ←θ-l2∙Adam( )θ,dθ

Step11:end while

3 实验及结果分析

本文实验在Ubuntu 14.04平台上由Tensorflow 0.10编程实现,处理器为Intel Core i5-6300HQ,2.9GHz四核CPU,内存为4G,显卡为GTX960,显存为4G。

为了验证本文算法的可行性,实验在公开数据集MNIST上进行。MNIST[21]是一个手写数字数据库,内容包含0-9的阿拉伯数字,它有60000个训练样本图像和10000个测试样本图像。数据集经过了统一的标准化处理,每个字符图像由28×28的像素构成。

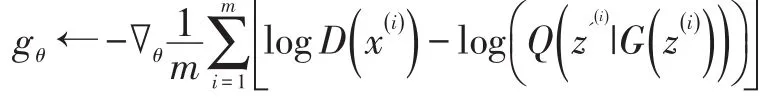

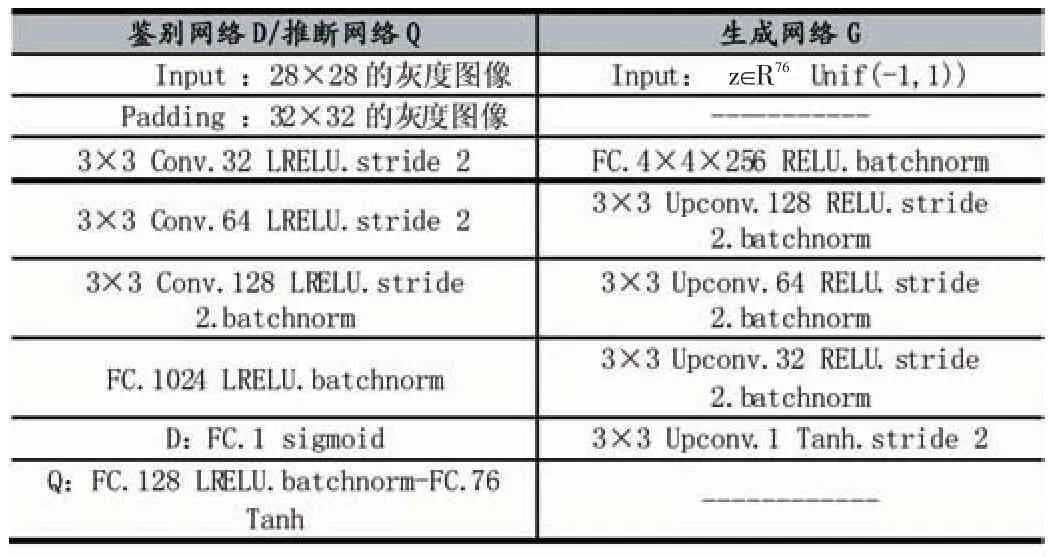

在实际实验中,为了减少计算代价,引入的额外参数分布Q可以形式化为一个多层神经网络,让Q与鉴别网络D共享大部分卷积层,仅在最后输出层,以全连接层取代sigmoid层。由于GAN网络难以训练,本实验的基础网络架构采用DCGAN模型去稳定训练,具体参数设置如表1和表2所示。通过与标准GAN模型在MNIST上生成的图像作对比,得出试验结果如图3所示。

表1 网络参数设置

表2 网络超参数设置

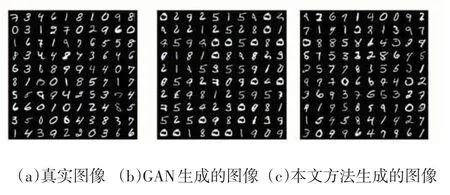

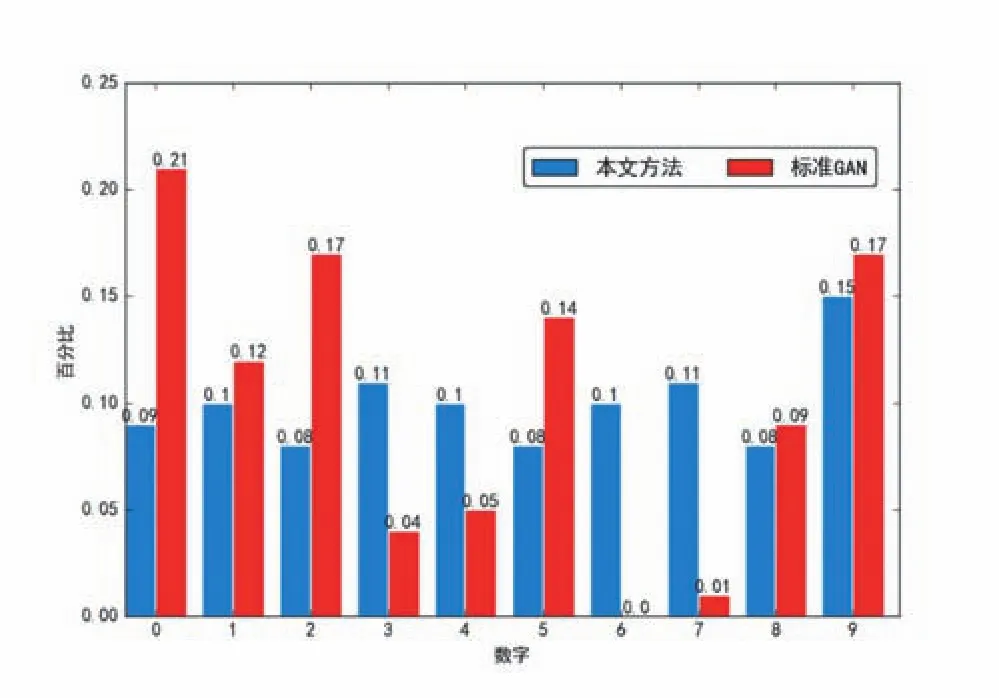

从图 3 可以看出,与(a)相比,(b)和(c)生成的图像质量差别不大,较为明显的是,(b)中生成的数字重复较多并且同一数字形态相似性较大表现出来更为“规整”,而反观(c)中生成的数字形状各异与真实图像更为贴近。为了形式化表现生成数字的多样性,将(b)和(c)中生成的数字个数加以统计,得到图4的生成数字分布对比图。从图4可以看出,标准GAN模型生成的图像中,数字“0”的个数占比最高约为21%,而数字“6”的占比却为0%。这表明生成器生成的样本差异性较小,出现了较多的重复样本,导致了样本多样性的丢失。而采用本文方法生成的数字分布较为均衡,有效的解决了“模式坍塌”的问题。

图3 真实图像、GAN生成图像和本文方法生成图像的对比

图4 标准GAN和本文方法生成数字分布对比图

4 结语

GAN作为无监督生成模型一个强有力的算法框架,已经受到越来越多的广泛关注。相对于传统的生成模型,GAN引入了网络对抗训练的机制,去逼近难以计算的概率分布,避免了对真实数据似然性的依赖。然而由于GAN训练过程难以收敛,导致在拟合真实数据分布的过程中常常出现模式的丢失或多个模式趋于同一模式的现象,从而生成的样本缺乏多样性。为此,本文受互信息理论的启发,在InfoGAN的基础上提出了基于互信息最大化的正则方法,弥补了原始GAN优化目标的误差,实验结果表明,所提算法在生成的图像质量不降低的前提下,样本多样性也更为丰富。下一步将深入研究生成器目标函数对GAN训练的影响,提出更为直观和稳定的优化目标。

[1]Ian Goodfellow,Jean Pouget-Abadie,Mehdi Mirza,Bing Xu,David Warde-Farley,Sherjil Ozair,Aaron Courville,and Yoshua Bengio.Generative adversarial nets.Advances in Neural Information Processing Systems.2014.2672–2680.

[2]Alec Radford,Luke Metz,Soumith Chintala.Unsupervised Representation Learning with Deep Convolutional Generative Adversarial Networks.arXiv Preprint arXiv:1511.06434,2015.

[3]Odena,Augustus,Christopher Olah,and Jonathon Shlens.Conditional Image Synthesis With Auxiliary Classifier GANs.arXiv Preprint arXiv:1610.09585,2016.

[4]Reed,S.,Akata,Z.,Yan,X.,Logeswaran,L.,Schiele,B.,&Lee,H.Generative Adversarial Text to Image Synthesis.arXiv Preprint arXiv:1605.05396,2016

[5]Christian Ledig,Lucas Theis,Ferenc Huszar,Jose Caballero,Andrew Aitken,Alykhan Tejani,Johannes Totz,Zehan Wang,Wenzhe Shi.Photo-Realistic Single Image Super-Resolution Using a Generative Adversarial Network.arXiv Preprint arXiv:1609.04802,2016.

[6]Jiajun Wu,Chengkai Zhang,Tianfan Xue,William T Freeman,Joshua B Tenenbaum.Learning a Probabilistic Latent Space of Object Shapes Via 3d Generative-Adversarial Modeling.In Neural Information Processing Systems(NIPS),2016.

[7]Michael Mathieu,Camille Couprie,Yann LeCun.Deep Multi-Scale Video Prediction Beyond Mean Square Error.arXiv Preprint arXiv:1511.05440,2015.

[8]Bengio,Y.,Thibodeau-Laufer,E.,Yosinski,J.Deep Generative Stochastic Networks Trainable by Backprop.International Conference on Machine Learning,2014.

[9]Hinton,G.E.,Osindero,S.,The,Y.A Fast Learning Algorithm for Deep Belief Nets.Neural Computation,2006,18,1527-1554.

[10]Salakhutdinov,R.and Hinton,G.E.Deep Boltzmann machines.In AISTATS,2009,448-455.

[11]Tong Che,Yanran Li,Athul Paul Jacob,et al.Mode Regularized Generative Adversarial Networks.International Conference on Learning Representations,2017.

[12]Hariharan Narayanan and Sanjoy Mitter.Sample Complexity of Testing the Manifold Hypothesis.In Advances In Neural Information Processing Systems,2010.23,1786-1794.

[13]Mehdi Mirza and Simon Osindero.Conditional Generative Adversarial Nets.arXiv Preprint arXiv:1411.1784,2014.

[14]Sebastian Nowozin,Botond Cseke,Ryota Tomioka.f-gan:Training Generative Neural Samplers Using Variational Divergence Minimization.arXiv Preprint arXiv:1606.00709,2016.

[15]Daniel Jiwoong Im,He Ma,Chris Dongjoo Kim,Graham Taylor.Generative Adversarial Parallelization.arXiv Preprint arXiv:1612.04021,2016.

[16]Tim Salimans,Ian Goodfellow,Wojciech Zaremba,Vicki Cheung,Alec Radford,Xi Chen.Improved Techniques for Training Gans.arXiv Preprint arXiv:1606.03498,2016.

[17]Ferenc Huszar.InfoGAN:using the Variational Bound on Mutual Information(twice).http://www.inference.vc/infogan-variationalbound-on-mutual-information-twice/,2016.

[18]Yingzhen Li.GANs,Mutual Information,and Possibly Algorithm Selection.http://www.yingzhenli.net/home/blog/?p=421.

[19]Chen,Xi,et al.Infogan:Interpretable Representation Learning by Information Maximizing Generative Adversarial Nets.arXiv Preprint arXiv:1606.03657,2016.

[20]D.Barber and F.V.Agakov.The IM Algorithm:A Variational Approach to Information Maximization.In Conference on Neural Information Processing Systems,2003.

[21]LeCun,Y.,Bottou,L.,Bengio,Y.,Haffner,P.Gradient-Based Learning Applied to Document Recognition.Proceedings of the IEEE,1998,86(11),2278-2324.

[22]Diederik P.Kingma and Jimmy Ba.Adam:A Method for Stochastic Optimization.arXiv Preprint arXiv:1412.6980,2014.

Abstract:Currently,one of the great difficulty of Generation adversarial nets(GAN)is the prevalence of non-convergence in the training dynamics of model,and its most prominent manifestation is the mode collapse phenomenon,which leads to the lack of diversity of the target object.First explains the theoretical method of the original GAN from the perspective of information theory.On this basis,proposes a regular method based on maximization of the mutual information.By maximizing the mutual information between the noise source and the generated sam⁃ples,it provides an upper bound function of the objective that forces the produced data distribution to converge more toward the real data distribution.The experimental results of MNIST data show that the maximization of the mutual information introduced is useful to increase the diversity of samples.

Keywords:Generative Adversarial Nets;Mode Collapse;Diversity;Mutual Information;Upper Bound Function

Generative Adversarial Nets Based on Mutual Information Maximization Regularity

PU Yu,WANG Xiao-Feng

(College of Information Engineering,Shanghai Maritime University,Shanghai 201306)

1007-1423(2017)26-0057-06

10.3969/j.issn.1007-1423.2017.26.015

浦煜(1992-),男,安徽合肥人,硕士研究生,研究方向为深度学习、数据挖掘

王晓峰(1958-),男,辽宁灯塔人,工学博士,教授,研究方向为人工智能及其在交通信息与控制工程中的应用、数据挖掘与知识发现

2017-06-02

2017-09-10