关系挖掘驱动的视频描述自动生成

黄毅 鲍秉坤 徐常胜

摘要 视频的自动描述任务是计算机视觉领域的一个热点问题.视频描述语句的生成过程需要自然语言处理的知识,并且能够满足输入(视频帧序列)和输出(文本词序列)的长度可变.为此本文结合了最近机器翻译领域取得的进展,设计了基于编码-解码框架的双层LSTM模型.在实验过程中,本文基于构建深度学习框架时重要的表示学习思想,利用卷积神经网络(CNN)提取视频帧的特征向量作为序列转换模型的输入,并比较了不同特征提取方法下对双层LSTM视频描述模型的影响.实验结果表明,本文的模型具有学习序列知识并转化为文本表示的能力.关键词

视频描述;LSTM模型;表示学习;特征嵌入

中图分类号 TP391.41;TP183

文献标志码 A

0 引言

随着社会网络和在线内容分享服务的迅猛发展,互联网上积累了大量的图像、视频等视觉数据.据统计,每分钟上传YouTube视频分享网站的视频长度达到100 h,而上传至Flickr图片分享网站的图片更是多达百万幅.如果能充分理解如此庞大丰富的互联网视觉数据,它们就是一个高价值的信息库,可以进一步为社会服务.然而,为了应对如此大量的视觉信息的收集、分类和处理工作,仅仅依靠人工方法是不够的.这时进行视觉数据的内容理解方面的研究工作就显得尤为重要.

视觉数据的内容理解在计算机视觉和多媒体应用领域已有广泛的研究,包括目标分类、检测和图像描述等.其中视觉数据的描述是近几年新兴的研究方向,主要研究如何自动生成对图片或视频片段的描述性文字,准确表达其所传达的内容.其在人机交互、基于内容的视频搜索、帮助视觉障礙者理解视觉内容等方面都有重要的应用.传统的图像描述方法[1]习惯将其划为2个子问题:首先使用图片分类技术,提取图像特征,识别图像中实体、行为和场景;然后再结合从文本语料库挖掘出的统计特征,估计最有可能的主语、动词、宾语和地点的语法结构,最后生成图像的文本描述.用手工设计的语法、根据所识别的内容生成相当有限的描述性句子.这样的方法更多的是关注图像里面有什么,然后总是重复使用描述模型在训练时使用的语句,而对于图像中的物体与物体之间、物体和环境之间的关联及意义并不能给出满意的描述.

显然对图像的自动描述需要更加高级的智能形态.计算机不仅需要识别出图像中的物体,同时必须更加深入理解视觉数据中物体之间以及物体和环境之间的关系,甚至包括一些抽象的属性.图像自动描述研究的突破得益于近年来计算机视觉和自然语言处理领域取得的进步.2012年,深度卷积神经网络(Deep Convolutional Neural Network,DCNN)在ImageNet对象识别挑战赛中首先获得成功[2].紧接着在2014年,机器翻译研究获得了巨大的进展,Cho等[3]研究人员利用一种特殊的循环神经网络——长短期记忆模型(Long Short-Term Memory,LSTM)将源语言的句子编码为一个具有丰富语义知识的向量,然后将这个语意向量作为解码LSTM的起始隐藏状态,最后生成目标语言的句子.2015年,Google Brain团队的Vinyals等[4]从上述研究中获得了启发,利用CNN提取出具有高层语义知识的图片特征,然后将其作为语言生成模型LSTM的输入,生成文本序列.在遇见全新场景时,这个模型能够基于图片中物体和环境之间的交互关系,自动生成准确的图像描述,并且使用的自然语言非常流畅.此后,该团队发现对视觉模型和语言生成模型进行端到端的联合训练有利于相互提升效果[5],图片自动描述模型可以生成更精确、更细节化的句子.

而对于开放领域的视频描述,其难点不仅在于难以确定视频中的突出内容,而且很难适当地根据视频前后关系进行事件描述.视频描述模型应允许对可变长度输入序列进行处理,并提供可变长度输出.微软亚洲研究院所提出的方法[6]将二维视觉上的卷积神经网络和三维的动态卷积神经网络结合,并且增加了一种用于探索视觉内容与句子语义之间关系的联合嵌入模型.文献[7-9]都构建了双层LSTM的语言生成模型,对视频序列帧编码和文字解码进行联合学习.它们都可以捕捉长期依赖性,能够如同描述静态图片一样很好地描述动态视频.

1 LSTM视频描述模型

1.1 序列到序列框架

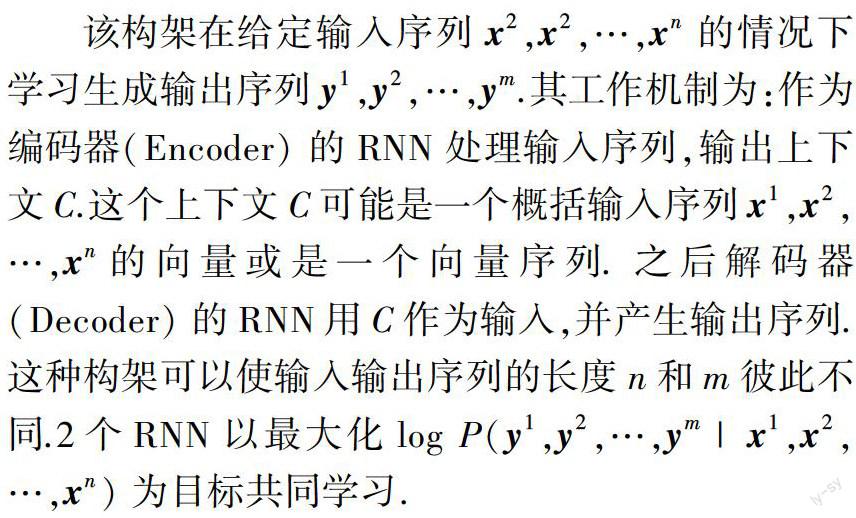

在例如机器翻译、视频描述等许多应用场景中,需要将不同长度的输入序列映射到不同长度的输出序列.用于映射可变长度序列到另一可变长度序列最简单的RNN架构最初由Cho等[3]提出,之后被使用到机器翻译中,获得了当时最好的结果.研究人员把这种构架称作编码-解码或序列到序列构架.

1.2 长短期记忆模型

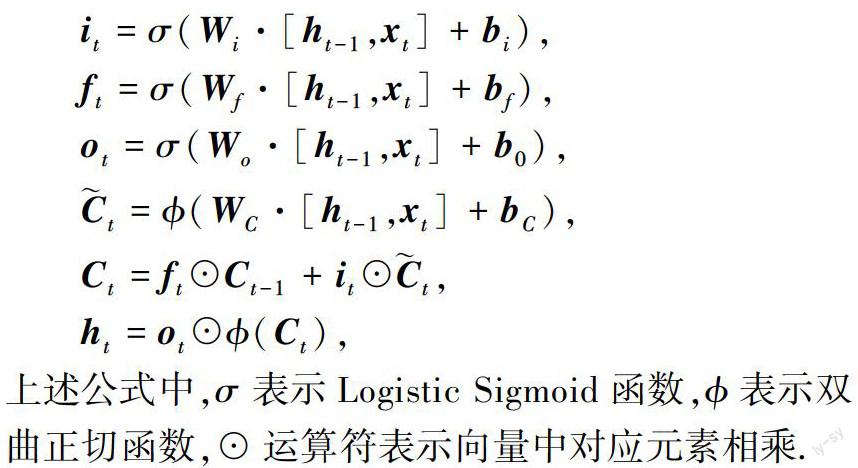

在进行从输入序列到输出序列的映射时,能够很好地利用序列前后之间的关系是循环神经网络(RNN)的一个重要优点.然而在实际操作过程中,标准的RNN结构承载长期信息的能力非常有限.给定输入对后续时间步上的隐藏层及输出层的影响,会随着网络的循环而发生指数级的衰减,最后导致网络“忘记”了最早学习到的信息.这种情况在机器学习领域被称作梯度消失(Vanishing Gradient).为了解决这个问题,Hochreiter等[10]引入自循环的巧妙构思,提出了长短期记忆(Long Short-Term Memory,LSTM)模型.

LSTM网络相比简单的循环构架更容易学习长期依赖,其允许网络在较长持续时间内积累信息.一旦中间某些信息被使用,让神经网络选择将其遗忘的做法确实取得了更好的效果.LSTM已经在极具挑战性的序列处理任务上已经取得了最先进的水平[11].

1.3 基于双层LSTM的序列转换模型

在视频描述任务中,需要处理视频的序列帧,然后输出对应的描述语句.序列到序列的深度学习框架可以很好地满足这个要求.本文使用一个对时间结构比较敏感的双层LSTM模型:首先将视频序列帧逐一编码,逐步建立能够有效地编码视频潜在对象、活动和场景的LSTM隐层语义表示.一旦读取了视频的所有帧,该模型就会逐词生成一个句子.对于帧的编码和词的解码,都利用平行语料库共同进行学习.这使得该模型具有以下特点:

1) 能够处理不同的输入帧数量;

2) 能够学习和使用视频的时间结构;

3) 能够学习语言模型生成自然语言句子.

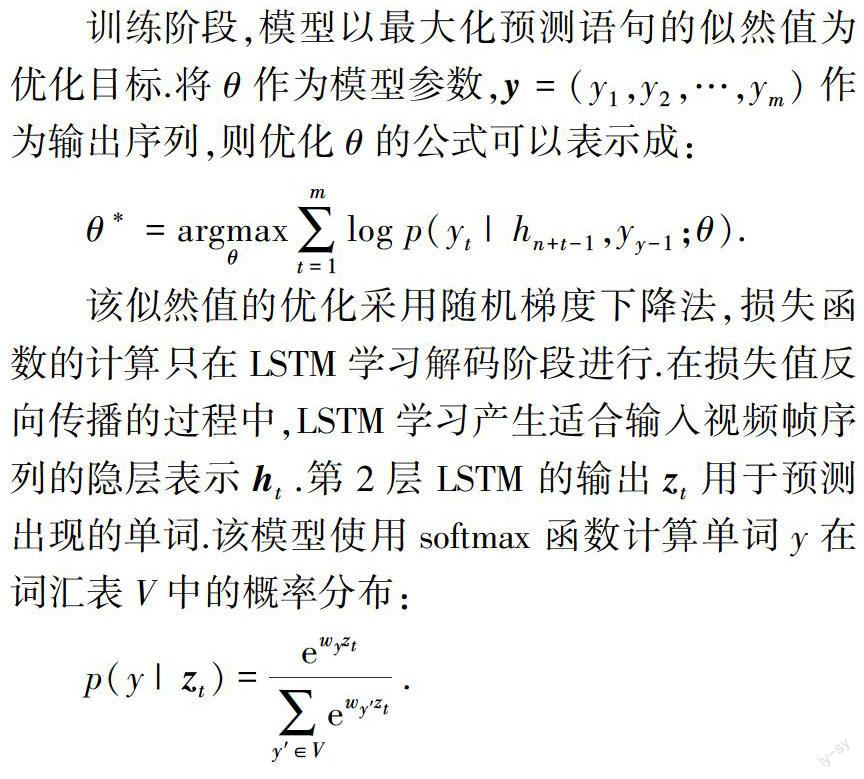

LSTM模型在时间上的展开如图2所示.对于2个LSTM,隐层的单元数都设置为1 000.第1层LSTM的隐层ht作为第2层LSTM的输入xt.在这个模型结构中,第1层LSTM用于处理视频输入帧序列,第2层LSTM用于输出单词序列.在前几个时间步中,第1层LSTM接受序列帧并编码,同时第2层LSTM接收第1层LSTM的隐层ht,然后将其与零向量连接后进行编码.这段时间,2个LSTM进行编码不进行损失计算.在视频所有帧都被作为输入后,第2层LSTM接收语句开始标签

3.3 实验过程

本文使用CAFFE(Convolutional Architecture for Fast Feature Embedding)框架搭建深度神经网络模型[18],并对神经网络进行训练和测试.

.

其中,从高维映射到低维的连接权重与双层LSTM网络共同训练.在整个训练过程中,综合考虑训练的显存消耗和模型处理视频的长度的能力,我们将双层LSTM视频描述模型展开成80个时间步长,训练批量设置为32.在视频帧序列输入结束后,使用0填充后续的输入.在切分视频时,每隔10帧提取一个样本,对于切分后的MSVD数据集中的视频,都可以在80个时间步长内编码完成并解码输出词序列.

3.4 结果分析

如表2所示的是视频描述模型在MSVD数据集上的实验结果.其中第1行是文献[9]中利用VGGNet提取视频特征训练LSTM描述模型的实验结果.本文使用基于ResNet-152的特征提取和ResNet-152+BC-DNN的连接特征,在MSVD数据集上进行视频描述实验.

基于ResNet-152的视频特征提取在METEOR指标上从VGGNet的29.0提高到了30.9,CIDER指标上比VGGNet略有下降.因为ResNet-152相比VGGNet对图像中对象特征有更丰富的表示,在关注描述相关性的METEOR指标下,模型效果明显提高.但是对象关系特征没有提高,使关注描述结果与人为描述相似性的CIDER成绩下降.

在ResNet-152特征中嵌入BC-DNN提取的关系特征后,视频描述模型在METEOR和CIDER上的表现都比VGGNet情况有了提高,尤其是在关注与人为描述相似性下的CIDER得分从50.8提高到了56.2.但是在描述相关性评价的METEOR上比单纯使用ResNet-152时的得分略有下降.

表3所示是3种不同特征表示方法下描述结果的例子.相比另外2种表示,ResNet+BC-DNN情况下的描述结果突出了视频中对象之间的关系.例如表3

中第1行,ResNet+BC-DNN特征识别出了人与车之间不是简单的骑行关系,而是人在车上做特技.

4 结束语

为视频中的事件生成自然语言描述具有多种实际应用.近年来,研究者们对静态图像和视频描述的兴趣日益激增.为了使用自然语言自动描述更广泛的普通视频,需要实现语言和视觉语意更深层次的整合.视频自动描述技术应该具备识别值得描述的突出事件的能力,并且应该能够适当地描述具有大量不同动作、对象、场景和其他属性的各种视频內容.基于深度神经网络的视频描述模型在这个方向上迈出了重要的一步.

本文使用序列到序列建模的方法构建视频模型描述,模型首先在编码阶段按顺序读取视频帧,然后解码按序生成文字.该模型允许处理可变长度的输入和输出,同时可以对时间结构建模.它将视频视为一种“语言”,并采用机器翻译的方法将视频翻译成文本,能够直接从视频和句子对中学习值得描述的显著对象.文本的模型在MSVD数据集上的实验获得了较好的表现.基于ResNet-152的视频特征使视频表示出更丰富的内容,描述结果的相关性更好.基于ResNet-152+BC-DNN的特征提取在视频表示中加入了关系特征,很大地提高了描述结果与人为描述的相似性.

参考文献

References

[1] Thomason J,Venugopalan S,Guadarrama S,et al.Integrating language and vision to generate natural language descriptions of videos in the wild[C]∥International Conference on Computational Linguistics,2014:1218-1227

[2] Krizhevsky A,Sutskever I,Hinton G E.ImageNet classification with deep convolutional neural networks[C]∥International Conference on Neural Information Processing Systems,2012:1097-1105

[3] Cho K,Merrienboer B V,Gulcehre C,et al.Learning phrase representations using RNN encoder-decoder for statistical machine translation[J].arXiv e-print,2014,arXiv:1406.1078

[4] Vinyals O,Toshev A,Bengio S,et al.Show and tell:A neural image caption generator[J].arXiv e-print,2014,arXiv:1411.4555

[5] Vinyals O,Toshev A,Bengio S,et al.Show and tell:Lessons learned from the 2015 MSCOCO image captioning challenge[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2017,39(4):652-663

[6] Pan Y W,Mei T,Yao T,et al.Jointly modeling embedding and translation to bridge video and language[C]∥IEEE Conference on Computer Vision and Pattern Recognition,2016:4594-4602

[7] Donahue J,Hendricks L A,Rohrbach M,et al.Long-term recurrent convolutional networks for visual recognition and description[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2016,39(4):677-691

[8] Venugopalan S,Xu H,Donahue J,et al.Translating videos to natural language using deep recurrent neural networks[J].arXiv e-print,2015,arXiv:1412.4729

[9] Venugopalan S,Rohrbach M,Donahue J,et al.Sequence to sequence:Video to text[C]∥IEEE International Conference on Computer Vision,2015:4534-4542

[10] Hochreiter S,Schmidhuber J.Long short-term memory[J].Neural Computation,1997,9(8):1735-1780

[11] Sutskever I,Vinyals O,Le Q V.Sequence to sequence learning with neural networks[J].arXiv e-print,2014,arXiv:1409.3215

[12] Zhou B L,Khosla A,Lapedriza A,et al.Object detectors emerge in deep scene CNNs[J].arXiv e-print,2015, arXiv:1412.6856

[13] Nian F D,Bao B K,Li T,et al.Multi-modal knowledge representation learning via webly-supervised relationships mining[C]∥ACM International Conference on Multimedia,2017(accepted)

[14] Chen D L,Dolan W B.Collecting highly parallel data for paraphrase evaluation[C]∥Meeting of the Association for Computational Linguistics:Human Language Technologies,2011:190-200

[15] Denkowski M,Lavie A.Meteor universal:Language specific translation evaluation for any target language[C]∥Workshop on Statistical Machine Translation,2014:376-380

[16] Vedantam R,Zitnick C L,Parikh D.CIDEr:Consensus-based image description evaluation[J].IEEE Conference on Computer Vision and Pattern Recognition,2015:4566-4575

[17] Elliott D,Keller F.Comparing automatic evaluation measures for image description[C]∥Meeting of the Association for Computational Linguistics,2013:452-457

[18] Jia Y Q,Shelhamer,Donahue J,et al.Caffe:Convolutional architecture for fast feature embedding[J].arXiv e-print,2014,arXiv:1408.5093

[19] He K M,Zhang X Y,Ren S Q,et al.Deep residual learning for image recognition[J].arXiv e-print,2015,arXiv:1512.03385