基于图像配准的无人机目标精确定位算法

杨 帅,程 红,李 婷,赵 鹤

基于图像配准的无人机目标精确定位算法

杨 帅1,程 红2,李 婷3,赵 鹤4

(1.78102 部队,四川 成都 610036;2.空军航空大学,吉林 长春 130022;3.94701 部队,安徽 安庆 246000;4.93787 部队,北京 100071)

为了满足“察打一体化”无人机精确打击目标的要求,针对现有目标定位算法的准确率低、实时性差的特点,本文提出了一种基于图像配准的无人机目标精确定位算法。该算法主要分为两个阶段:特征点检测阶段和目标精确定位阶段。首先采用基于侧抑制竞争的特征点检测算法,实现局部图像中目标特征点的检测工作;然后利用图像局部信息的配准算法,完成目标所处的局部区域图像的精确配准工作,最终实现了目标的高精度定位。实验结果显示该算法的定位精度可以达到0.21m,能够满足精确作战时的目标情报保障需求。

无人机侦察图像;目标定位;特征点检测;侧抑制竞争;图像配准

0 引言

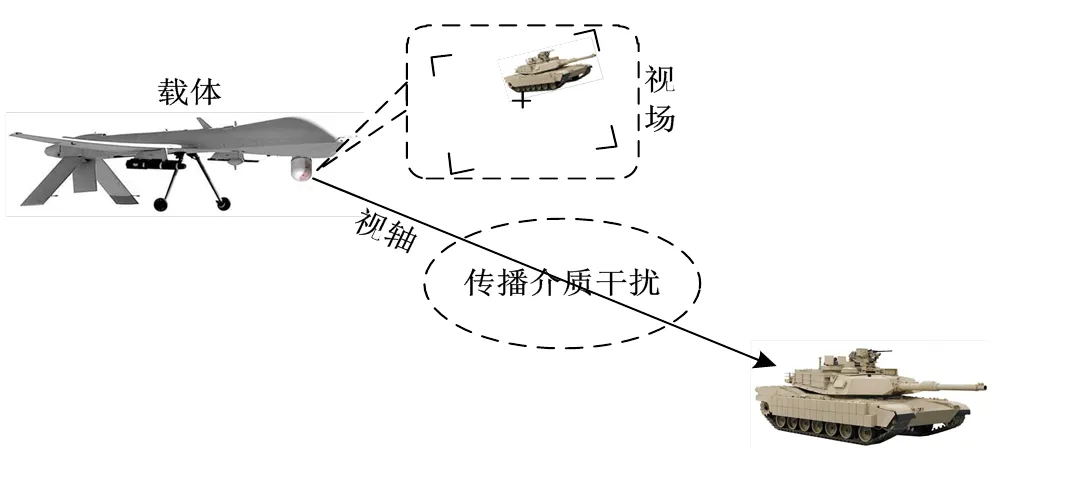

近些年来,无人机(Unmanned Aerial Vehi-cle)在侦察作战中的应用越来越广泛,相对有人飞机,无人机既能承担同样的侦察作战任务,又能避免人身伤亡情况的出现。而且随着“察打一体化”无人机装备部队,作为无人机目标打击的前期工作,目标定位的重要性日益突出[1]。图1为无人机执行目标侦察任务时的示意图。因此研究无人机侦察图像目标的定位技术,对于提高信息化战争中的目标精确打击能力具有非常重要的意义[2]。

无人机侦察目标定位是指利用摄影测量、图像处理和信息处理等技术,通过对无人机侦察获得的图像进行处理与分析,最终得到目标的精确三维坐标[3]。国内外一些学者从不同的角度对图像配准定位进行研究和分析。文献[4]论述了基于特征点相似度的配准定位,保证了算法在视点变化时,依旧能够完成前视图像的准确配准定位工作。文献[5]在提出改进SIFT算法的基础上进行精确配准,为无人机目标定位提供了一种可行和有效的手段。文献[6]将SIFT配准算法应用到SAR图像的配准定位领域,切实有效地降低了对实时图像的苛刻要求,提高了该技术的应用范围。文献[7]以SIFT算法为基础,结合KD-Treed搜索策略,提高了图像的配准效率,保证了无人机定位的实时性;文献[8]通过降低SIFT描述符的维数和引入聚类算法,减少配准时间满足了图像定位的时效性要求,为无人机实验奠定了理论技术基础。综上所述,当前利用无人机侦察图像进行目标定位的精度和时效性仍需提高。

针对当前图像配准的无人机目标定位算法的缺点,本文提出了一种基于图像配准的无人机目标精确定位算法,在采用侧抑制竞争理论实现对目标特征点检测的基础上,利用局部图像配准算法完成对目标的精确定位。该算法的限制条件少,应用范围广泛,并且可靠性强、准确率高。图1为无人机目标侦察定位示意图。

图1 无人机侦察目标定位示意图

1 基于侧抑制竞争的特征点检测算法

考虑到目标所处的局部区域图像内的特征信息可能较少,并且存在光照条件以及图像纹理等不确定性的灰度变化,给鲁棒的特征检测带来了一定的困难。常用的SIFT算法中的DoG算子对灰度变换敏感,局部范围内很难提取到数量足够多、鲁棒性好的斑点[9];Harris算法存在参数不易选取的问题,场景自适应能力不强[10];FAST算法中的灰度比较阈值不易选取,算法性能受图像不确定性灰度变化的影响较大[11]。针对局部图像可能存在的实际情况以及SIFT、FAST以及Harris算法的不足,本文提出了一种基于侧抑制竞争思想的特征点检测算法,在局部区域图像内能够较好地克服图像灰度变化的影响,检测到数量足够多的点特征用于后续的图像配准工作[12]。

算法具体流程图如图2所示,主要分为3个步骤:侧抑制竞争增强图像、筛选关键点、极值比较。

1)侧抑制竞争增强图像

侧抑制现象[13-14]最早由生物学家Hartline等人在对鲎的视觉系统的长期研究之后提出,即视网膜上的每个视神经细胞对它周围的视神经细胞的输出具有抑制特性。李言俊等人[15]在数字图像处理中引入了侧抑制竞争的概念,提出了一种基于侧抑制竞争网络的图像处理方法,当图像的灰度发生较大变化时,该方法仍能有效增强图像,具有很强的抗灰度变化的能力,实现简单,实时性好。

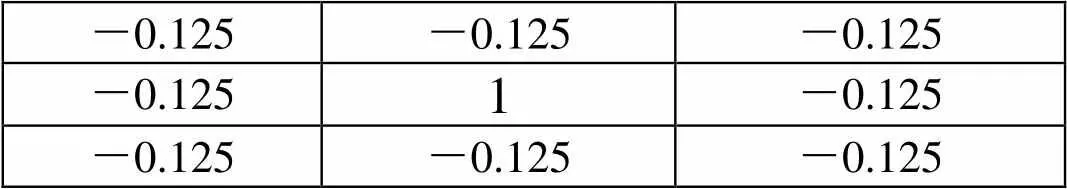

本文选择3×3网络的抑制竞争函数,以图像中的某个像素点0(,)为例,中心点权值为00,其余点权值为,则侧抑制竞争函数[16]为:

依据侧抑制竞争的原理,00=1,=-0.125,则3×3网络的侧抑制竞争系数[17],如图3所示。

将图3的系数带入式(1)可得像素点0(,)的侧抑制竞争函数(,),依据此函数完成对图像的增强处理,增强后的图像为(,)。

图2 特征点检测流程图

-0.125-0.125-0.125 -0.1251-0.125 -0.125-0.125-0.125

2)筛选关键点

采用高斯函数对图像(,)进行平滑处理,降低噪声的影响;然后计算图像(,)的标准差作为门限,将大于门限的点作为候选亮特征点,将小于阈值的点作为候选暗特征点,完成关键点的筛选。

3)极值比较

在图像(,)中,将候选亮特征点的像素值与周围8个方向上的相邻点的像素值进行比较,如果为局部极大值,则将其作为亮特征点(bright point);将候选暗特征点的像素值与周围8个方向上的相邻点的像素值进行比较,如果为局部极小值,则将其作为暗特征点(dark point)。

至此,完成图像中特征点的检测工作,得到两个特征点集:亮特征点和暗特征点。

2 基于局部图像配准的目标精确定位算法

2.1 算法的基本原理

基本原理:为了实现目标的精确定位,首先在基准图像和配准图像中以目标为中心截取目标局部区域图像作为新的基准图像和待配准图像,再利用基于侧抑制竞争的特征点检测算法检测图像中的亮特征点和暗特征点并统一采用SIFT特征描述符进行特征描述,然后利用特征匹配策略匹配两幅图像中同类性质的点特征,合并匹配点对集计算出图像变换模型,最后重新解算出目标的地理位置,完成图像目标的精确定位工作[18]。

2.2 算法的具体步骤

本文配准定位算法的具体流程如图4所示,主要包括:图像裁剪、特征点检测、特征描述、特征匹配、计算图像变换模型、目标定位6个步骤。

Step 1:图像裁剪:对待配准图像进行小波变换[19-20],进行适当层级的分解降低特征搜索空间,提高配准算法的实时性和降低数据量和计算量。之后分别在基准图像和进行小波处理过的配准图像中,以目标为中心截取相同尺寸的局部区域图像作为新的基准图像和待配准图像。

Step 2:特征点检测:利用基于侧抑制竞争的特征点检测算法分别检测新的基准图像和待配准图像中的亮特征点和暗特征点。

Step 3:SIFT特征描述:利用性能良好的SIFT特征描述符描述图像中的点特征,点特征的主方向设为0°。

Step 4:特征匹配:采用最近邻特征匹配策略,分别匹配两幅图像中的亮特征点和暗特征点,再合并得到的两个匹配点对集,得到新的匹配点对集。

Step 5:计算图像变换模型:利用最小二乘法计算出两幅新的配准图像之间的投影变换模型。

Step 6:目标定位:利用投影变换模型计算出目标在基准图像中的位置,进而得到目标的真实地理位置,由此实现目标的精确定位。

图4 基于局部图像配准的目标精确定位算法流程图

3 实验结果与分析

为了验证本文方法的有效性,在主频3.40GHz、i3处理器、内存4GB的平台上,在Matlab2014a的环境下进行了仿真实验并进行了实验结果分析。

3.1 实验图像及数据的确定

在基准图像和全局粗配准图像中以目标点为中心截取目标局部区域图像作为新的基准图像和待配准图像。

考虑到对算法实时性与局部图像特征信息量的要求,以及本文研究采用的基准图像的分辨率约为0.44m,本文分别在基准图像与粗配准图像以目标点为中心截取实际范围为100m×100m的地面区域,由此计算出的新的基准图像和待配准图像的分别率227×227,图像尺寸大小和场景收容范围均较为合适,同时,计算出目标点在待配准图像中的坐标(144,144)。

图5为裁剪出的两幅新的配准图像,虽然图像的整体场景与结构大致相同,但是两者之间的纹理、灰度差别较大,仔细观察对比两幅图像,两者在空间位置上的差别虽然很小,但确实存在。

图5 新的配准图像

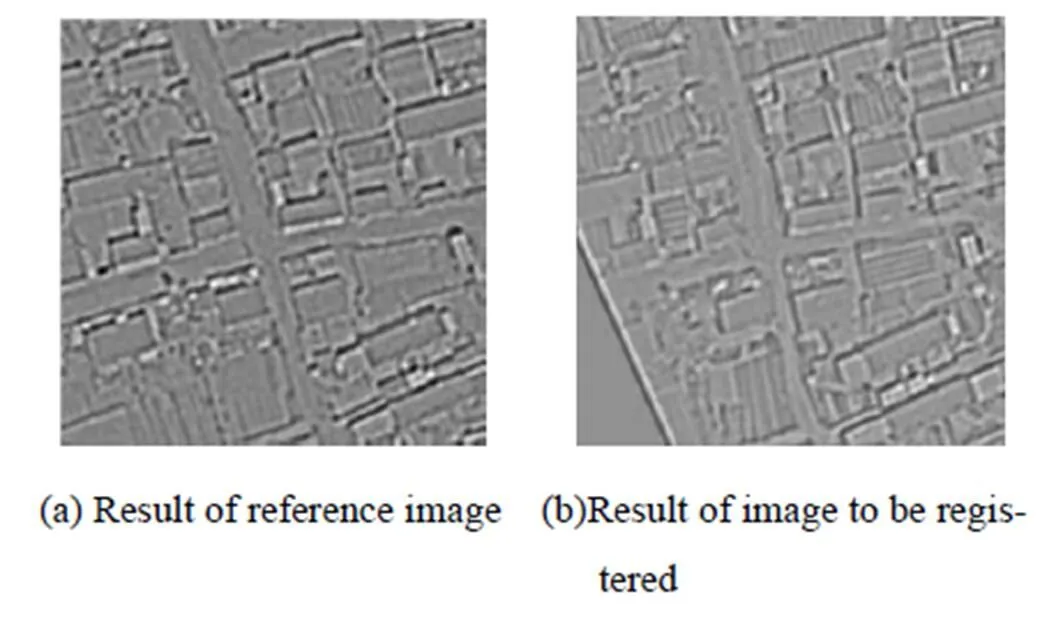

3.2 侧抑制增强图像及特征点检测实验

图6所示为侧抑制竞争增强后的基准图像和待配准图像,从图中可以看出经过侧抑制增强之后,图像的灰度差异得到了降低,图像边缘等细节部分得到了增强。

图6 侧抑制竞争图像增强结果图

图7所示为基于侧抑制竞争的特征点检测算法在基准图像和待配准图像中的特征点检测结果,其中,“o”点表示亮特征点,“*”点表示暗特征点。

3.3 算法匹配性能及配准精度的对比实验

本文将SIFT算法、Harris+SIFT算法、FAST+SIFT算法以及本文配准算法共4种算法进行了对比实验。

1)算法匹配性能对比分析

图8所示为各个算法的匹配结果图像,可以明显看出本文配准算法得到的匹配点对数量要远远超过其余3种算法,有利于提高后续图像配准的精度。

图7 特征点检测结果

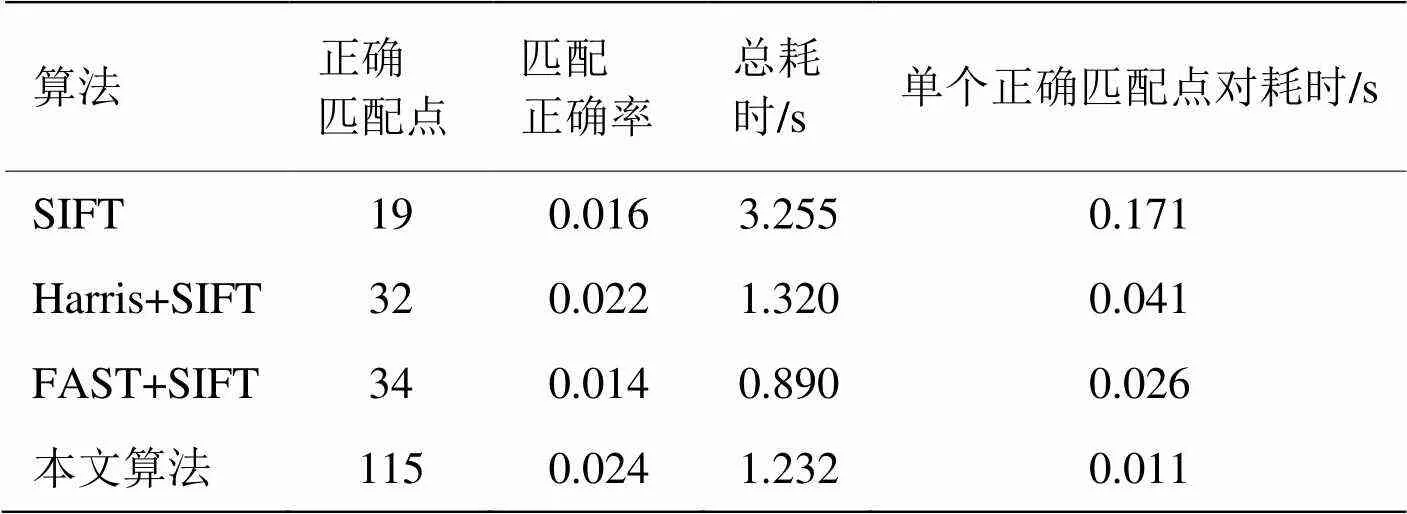

为了客观地评价各个算法的匹配性能,采用正确匹配点对、匹配正确率、总耗时以及单个正确匹配点对耗时4个评价指标进行定量对比分析。

通过观察表1,可以看出本文算法耗时1.232s,时效性较好,仅仅比FAST算法慢,但其余各项指标均属于最优,尤其算法得到的正确匹配点对数量大大超过了其余3种算法,对于后续提高图像配准精度和目标定位精度有很大的作用。

2)算法配准精度对比分析

图9所示为在本文配准算法下局部航空图像的配准结果。

图8 各个算法的匹配结果

表1 匹配结果数据对照表

图9 目标所处局部区域图像配准结果

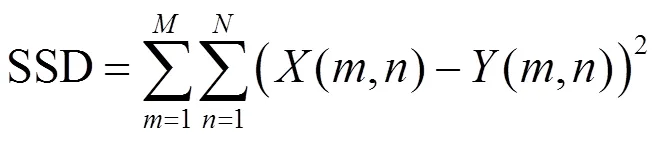

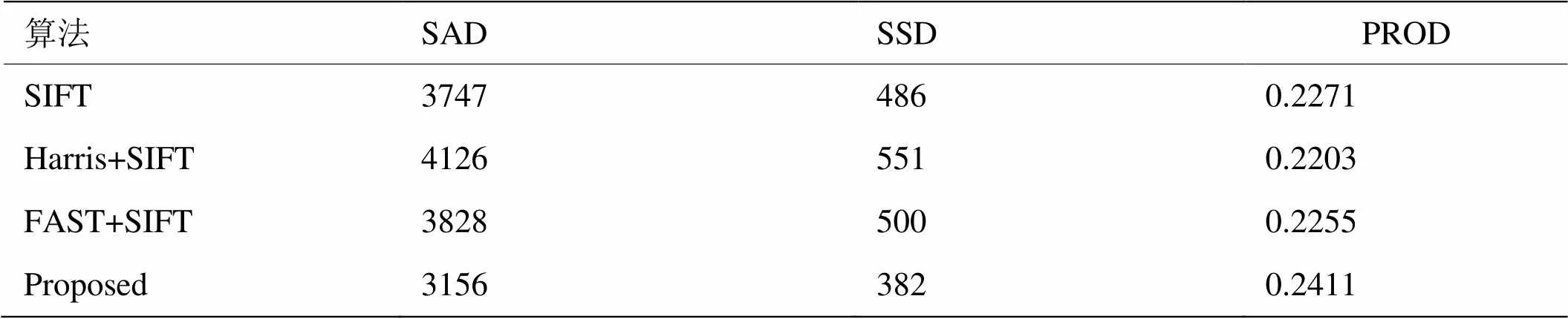

为了对比分析各个算法的配准精度,采用绝对差度量(SAD)、平方差度量(SSD)以及积相关度量(PROD)3个评价指标来进行定量分析,各指标定义[21]如下:

式中:(,)为基准图像;(,)为待配准图像精配准后的图像;、为图像的行列数。为了消除光照变化对配准精度计算的影响,实验时均对图像(,)、(,)进行了侧抑制增强和归一化处理。在3个评价指标中,SAD或SSD的值越小,表明两幅图像的相似度越高;PROD的值越大,表明两幅图像的相似度越高。表2为常见算法配准精度对比情况。

表2 配准精度对比

由表2中的各项指标对比可以看出,本文算法的图像配准精度要优于其余3种算法,通常图像配准精度越高,后续的目标定位精度也越高。

3.4 目标定位精度分析

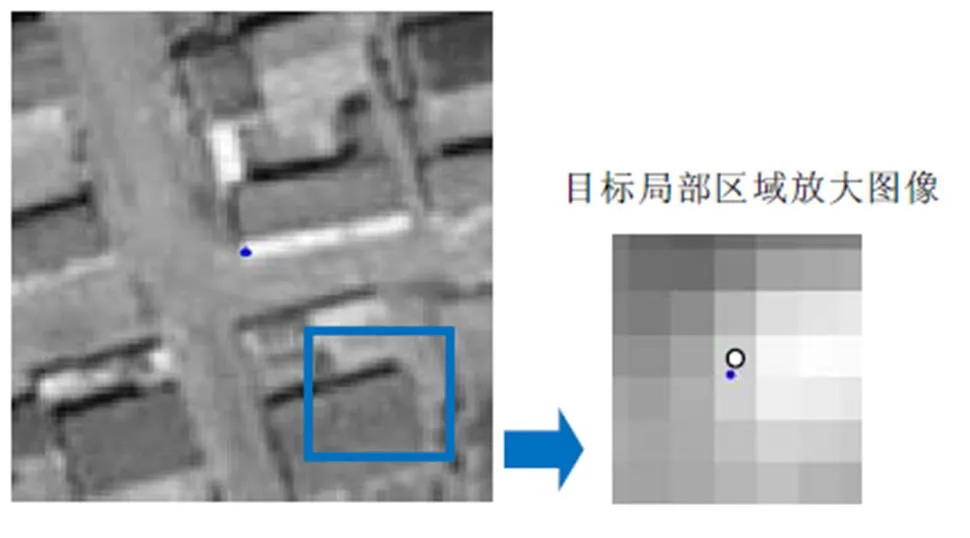

目标精确定位的结果如图10所示,图中实心小圆点表示局部图像配准后确定的目标在基准图像中的位置,空心圆“o”表示目标在基准图像中的真实位置,图10右侧为目标局部区域的放大图像。

图10 目标精确定位结果

从图10中可以看出本文算法的定位结果达到了亚像素级,精确定位后目标在基准图像中的坐标为(743.46,646.89),经纬度坐标约为(122.4791°, 42.7036°),而目标的真实坐标为(743, 647),两者之间的位移量为(-0.46, 0.11),实际地面距离相差约为0.21m,由此可知在本文算法精确定位目标之后,目标的定位精度达到了米级,可以满足精确作战时的目标情报保障需求。

4 结论

针对现有目标定位算法存在的缺陷,本文提出了一种基于图像匹配的无人机目标精确定位方法。该方法充分考虑了目标局部区域图像中的特征信息存在较大非线性灰度变换的情况,首先采用基于侧抑制增强的特征点的检测算法进行特征点的提取,然后采用局部图像的精确配准算法实现目标的定位,结果表明本文的算法能够克服灰度变化的影响,检测到足够多的点特征,并且能够较好地完成局部图像的配准任务,获得较高的图像配准精度,从而实现了目标的高精度定位,最终证明了本文算法的有效性和可行性。

由于本文选取的实验图像是地面信息丰富的航空图像,当面对信息匮乏的航空图像(如农田、沙漠、野外地区等),此时本文提出的算法成功率会很低,如何实现此类地区航空图像中目标的准确定位是下一步研究的一个方向。

[1] 王方玉. 美国无人机的光电载荷与发展分析[J]. 激光与红外, 2008, 38(4): 311-314.

WANG F Y. Electric-optic load and development analysis of the american UAV[J]., 2008, 38(4): 311-314.

[2] 汪林彪, 郑垣模. 信息化推进精确作战的发展[J]. 国防科技, 2010 (4): 56-59.

WANG L B, ZHENG Y M. Development of precision engagement pushed by information[J]., 2010(4): 56-59.

[3] 都基焱, 段连飞, 黄国满. 无人机电视侦察目标定位原理[M]. 合肥: 中国科学技术大学出版社, 2013.

DU J Y, DUAN L F, HUANG G M.[M]. Hefei: University of Science and Technology of China Press, 2013.

[4] 鲁统伟. 前视目标图像匹配定位技术研究[D]. 武汉: 华中科技大学, 2009.

LU Tongwei. Study on Forward-looking Object Image Matching and Localization[D].Wuhan: Huazhong University of Science&Technology, 2009.

[5] 胡海洋, 李海林. 基于图像匹配的无人机目标定位方法[J]. 舰船电子工程, 2013, 32(12): 49-51.

HU Haiyang, LI Hailin. A Target location method for UAV based on image registration[J]., 2012(12): 49-52.

[6] 唐波, 张辉, 刘彦. 基于 SAR景象不变特征点的匹配定位技术研究[J]. 航天控制, 2012(2): 10-19.

TANG Bo, ZHANG Hui, LIU Yan. The research of SAR image match guide method based on SIFT[J]., 2012 (2): 10-19.

[7] 马园, 吴爱国, 杜春燕. 基于视觉的无人机飞行过程定位算法研究[J]. 电光与控制, 2013, 20(11): 42-46.

MA Yuan, WU Aiguo, DU Chunyan. Vision based localization algorithm for unmanned aerial vehicles in flight[J]., 2013(12): 42-46.

[8] 吴爱国, 马园, 杜春燕. 无人机飞行过程中图像定位算法研究[J]. 计算机应用与软件, 2015, 4: 041.

WU Aiguo, MA Yuan, DU Chunyan. Research on image localization on algorithm for unmanned aerial vehicles in fight[J]., 2015(4): 165-170.

[9] 杨新锋, 滕书华, 夏东. 基于空间变换迭代的SIFT特征图像匹配算法[J]. 红外与激光工程, 2013, 42(12):3496-3501.

YANG X F, TENG S H, XIA D. SIFT matching algorithm with geometry constraint[J]., 2013, 42(12): 3496-3501.

[10] Wilhelm Burger, Mark J. Burge.—[M]// Principles of Digital Image Processing. Springer London, 2013: 229-296.

[11] Miksik O, Mikolajczyk K. Evaluation of local detectors and descriptors for fast feature matching[C]/(), 2012: 2681-2684.

[12] 王志强, 程红, 杨桄, 等. 全局图像配准的目标快速定位方法[J]. 红外与激光工程, 2015, 44(S): 225-229.

WANG Z Q, CHENG H, YANG G, LI C, WU D. Fast target location method of global image registration[J]., 2015, 44(S): 225-229.

[13] 福岛邦彦. 视觉生理与仿生学[M]. 马万禄, 译. 北京: 科学出版社, 1980:231-244.

FUKUSHIMA. V[M]. MA W L, translated. Beijing: Science Press, 1980: 231-244.

[14] 周理, 高山, 毕笃彦,等. 基于视觉侧抑制机理的强鲁棒性图像分割方法[J]. 中南大学学报: 自然科学版, 2013,44(5): 1910-1917.

ZHOU L,GAO S, BI D Y, et al. A strongly robust algorithm of image segmentation based onvisual lateral inhibition[J].:, 2013,44(5): 1910-1917.

[15] 王蜂, 陈鹰, 李言俊. 一种扩展边缘特征的图像定位方法[J]. 西北工业大学学报, 1999, 17(2): 322-326.

WANG F, LI Y J, CHEN Y. A new and better way of extracting digital image edge[J]., 1999, 17(2): 322-326.

[16] 李言俊, 张科. 景象匹配与目标识别技术[M]. 西安: 西北工业大学出版社, 2009: 175-181.

LI Y J, ZHANG K.[M]. Xi'an: Northwestern Polytechnical University, 2009: 175-181.

[17] 陈卫兵, 束慧. 快速边缘匹配算法研究[J]. 计算机工程与设计, 2004, 25(1): 130-132.

CHEN W B, SHU H. Research on fast edge matching algorithm[J]., 2004, 25(1): 130-132.

[18] Gauglitz S, Höllerer T, Turk M. Evaluation of interest point detectors and feature descriptors for visual tracking[J]., 2011, 94(3): 335-360.

[19] 李龙龙. 结合小波变换和SIFT算法的遥感图像快速配准算法[D]. 哈尔滨: 哈尔滨工业大学, 2013.

LI L L. Remote Sensing Image Fast Registration Algorithm Combined with Wavelet Transform and SIFT Algorithm[D]. Harbin : Harbin Institute of Technology, 2013.

[20] 范瑾瑾, 胡良梅, 凌虎. 改进的基于小波变换的图像配准方法[J]. 计算机工程, 2010, 36(5): 212-214.

FAN J J, HU L M, LING H. Improved approach for image registration based on wavelet transform [J]., 2010, 36(5): 212-214.

[21] 刘宝生, 闫莉萍, 周东华. 几种经典相似性度量的比较研究[J]. 计算机应用研究, 2006, 23(11): 1-3.

LIU B S, YAN L P, ZHOU D H. Comparison of some classical similarity measures[J]., 2006, 23(11): 1-3.

UAV Reconnaissance Images Accurate Targeting MethodBased on Image Registration

YANG Shuai1,CHENG Hong2,LI Ting3,ZHAO He4

(1.78102,610036,; 2.,130022,;3.94701,246000,; 4.93787,100071,)

In order to meet the needs of the integrated reconnaissance/strike UAV precision attack, and to overcome low accuracy and worse real-time performance of these existing target localization algorithms, this paper proposes a UAV accurate positioning algorithm based on image registration, which consists of two parts: feature point detection and target accurate positioning. First, the feature point detection algorithm based on lateral inhibition competition is used to detect the local image feature points; and then the image registration algorithm of local information is applied to complete the work of local image precise registration, ultimately achieving the goal of high-precision positioning of the targets. The experiments show that the positioning accuracy of this algorithm can reach 0.21m, which can meet the target information security needs during combat.

UAV reconnaissance image,target orientation,feature point detection,lateral inhibition competition,image registration

TP391

A

1001-8891(2017)06-0529-06

2016-08-04;

2016-12-20.

杨帅(1992-),男,硕士研究生,主要研究领域为无人机目标定位技术。

国家自然科学基金(61301233)。