基于显著性和SURF的家居服务机器人物体识别算法

薛翠红,齐立萍,孙 昊,杨 鹏

(1.天津理工大学 聋人工学院,天津 300384;2.河北工业大学 控制科学与工程学院,天津 300130;3. 河北农业大学 理工学院,河北 沧州 061100)

基于显著性和SURF的家居服务机器人物体识别算法

薛翠红1,2,齐立萍2,3,孙 昊2,杨 鹏2

(1.天津理工大学 聋人工学院,天津 300384;2.河北工业大学 控制科学与工程学院,天津 300130;3. 河北农业大学 理工学院,河北 沧州 061100)

物体识别是家居服务机器人的主要问题之一,考虑到家居非结构化环境下物体识别的复杂性,将不依赖图像分割的局部特征作为关键特征。针对传统SURF算法运算量大的问题,模拟生物视觉功能,提出了一种基于显著性区域指导的局部特征算法。首先采用视觉选择性注意机制提取图像显著区域,然后提取显性物体区域SURF特征,最后完成与目标图像的特征点匹配,实现场景中目标物体的识别。实验证明,和传统SURF算法相比,改进算法速度得到有效提高,同时识别率提高了约10%。关键词: 物体识别;家居服务机器人;SURF特征;视觉选择性注意机制

1 物体识别算法

随着老龄化问题的日益严重,对家居服务机器人的需求也越来越迫切[1]。良好的物体识别能力是家居服务机器人实现智能作业的前提,也是机器视觉领域的研究热点[2]。

在国内外,许多科研工作者在物体识别方面做了大量研究。基于词袋法(Bags of Words,BoW)[3-4]的目标识别主要包括构建码本、在线物体识别两个步骤,其性能良好,受到了广泛关注,但是该方法更侧重于进行物体种类识别,而家居服务机器人主要完成对物体个体的识别。文献[5]利用建模方式对物体进行识别,工作复杂度较高。文献[6]采用基于局部SIFT特征[7]进行物体识别,由于SIFT特征向量维数很高,以致后续计算量极大,导致识别速度过慢。

目前,虽然已经涌现出大量的物体识别方法,但是考虑到家居环境的非结构化、物体种类的繁多、物体不同姿态的任意摆放、多个物体间的相互接触与遮挡、机器人运动带来的图像模糊性,以及实时性要求等都为机器人的物体感知带来了诸多困难[8]。传统的特征提取方法一般都将目标作为一个整体,然后提取不变矩、傅里叶描绘子等整体特征。该方法受到图像分割精度的严重制约,尤其对于家居条件下非结构化环境,当不规则物体以任意位姿存在于背景中时,由于图像结构及其内部特征的复杂性与多样性,将物体完整地分割出来是一项非常具有挑战性的工作,而局部特征不依赖图像分割。另外,局部特征良好的尺度不变性、旋转不变性、抗噪性能良好、受光照影响小等优点[9],非常适用于家居环境下三维物体识别。SURF[10]算法是在SIFT算法的基础上发展而来,它不仅继承了SIFT算法的平移、缩放、亮度、旋转不变性等优点,而且克服了SIFT算法特征提取匹配速度较慢的缺点。由于SURF特征的以上优点,非常适用于家居服务机器人物体识别领域。但是,SURF算法虽然在速度上比SIFT算法有很大提升,但是仍然无法满足家居服务机器人的实时性要求。

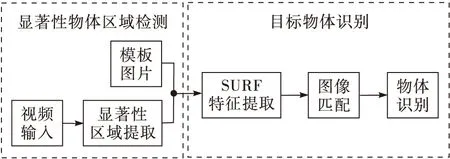

本文为加快家居服务机器人物体识别速度,并提高其可靠性,结合视觉注意方法[11-12],首先,依据背景先验得到显著性物体区域,之后,对显著性物体区域进行SURF特征检测,在完成初匹配的基础上通过RANSAC算法[13]提纯匹配对,最终实现场景中目标物体的识别。本文家居服务机器人物体识别算法框图如图1所示。

图1 家居服务机器人物体识别框图

2 基于背景先验的显著性区域提取

在实际的图像中,待识别物体仅仅占据一小部分空间,大部分区域是背景。根据视觉注意机制可知,人类的视觉系统只会处理图像中的一部分区域,也就是说图像中只有部分区域是人类感兴趣的区域,称这部分区域为显著性区域。为了提高模型性能,引入视觉注意模型,先提取显著性区域,然后再在显著性区域中提取特征。目前,显著性提取中最常用的算法还是基于显著性优先,即直接计算像素或超像素的显著值[14-16]。与之前的显著性检测方法不同,基于背景的显著性检测方法计算的是目标区域和背景的差异性。人眼在观察物体时,只能良好感知视角前方的物体,通过脖子和眼球的转动,使物体出现于视线正前方,同样,对于家居服务机器人而言,也可以通过摄像机云台的转动,使物体出现在机器人视野中间。因此,本文基于背景优先进行显著性区域提取。

微软的Wei[17]等几位学者在2012年提出图像的四周是背景的概率非常大并且通常是连通的。立足于这个假设,首先在图像中提取背景区域,当得到背景区域后,通过计算目标区域和背景的相似性程度来判断该图像块是属于背景还是属于物体,对比度大的就是前景目标,对比度小的就是相对背景。

对于输入图像,建立其带权无向图G={V,E}。其中V包含全部图像块和虚拟背景顶点,V={Pi}∪{B}。E中包含有两种类型的边,一种边是相邻图像块间的内部边,另外一种是用于连接边界上图像块与背景顶点的边界边。

(1)

式中:Pi是图像块;B是虚拟的背景节点;wt(Pi,Pi+1)代表两个像素块之间的距离。

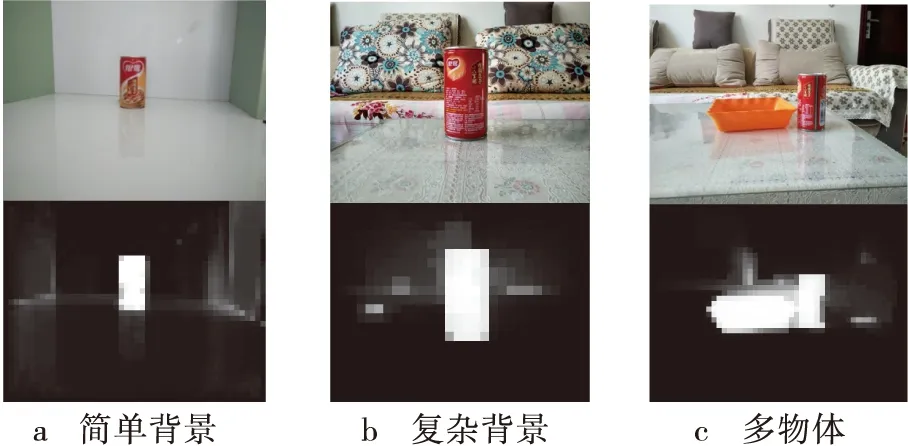

为了验证显著性区域提取的有效性,在家居环境下进行实验。实验结果如图2所示。

图2 显著性区域检测

图2中第一行是原图,第二行是显著性检测图,由图2a可知,在背景比较简单的情况下,可以很好地检测并高亮前景物体,抑制背景区域,从而直接确定物体位置,完成物体定位。由图2b可知,在家居环境复杂纹理背景下,仍然可以高亮易拉罐,抑制了具有复杂纹理的花纹背景,可以完整地提取出物体区域,直接完成物体定位。由图2c可知,当存在多个物体时,同时高亮水果筐与易拉罐,可以同时检测出多个物体。由以上实验结果可知,通过基于背景先验的显著性物体区域提取,可以很好地获得物体区域。

3 基于显著性区域指导的SURF识别 算法

根据传统SURF算法运算量大的特点,采用上节算法提取出显著性物体区域,然后针对此区域进行SURF特征提取和RANSAC提纯匹配对完成物体识别,有效降低了特征提取面积区域,提高了运算速度。

3.1 SURF特征提取

3.1.1 特征点的检测

SURF算法利用Hession矩阵来完成特征点检测。对于图像I上一点P(x,y),在尺度σ的Hessian矩阵H(P,σ),定义为

(2)

为了提升算法效率,选择盒式滤波器代替高斯滤波器。盒式滤波器成块状结构,对于每一块区域内的权值都是相同的,因而,在计算图像与滤波器在某一点处的卷积就可以转化成计算原图像在该点处的积分,利用积分图像可以大大加快卷积计算,基于积分图的快速计算,可以得到全新的Hessian矩阵,即

(3)

快速Hessian矩阵的行列式为

det(Happrox)=DxxDyy-(wDxy)2

(4)

式中:w为调节参数,用来平衡近似值与准确值之间的误差,其取值与尺度σ有关,计算方法为

(5)

为了保证尺度不变性,需要不断扩大滤波模板的尺寸,得到Hessian矩阵行列式的响应函数,通过非极大值抑制得到不同尺度的特征点。

3.1.2 特征点描述

特征点描述过程可分为两步:第一步是确定主方向。在半径为6s的圆形邻域中,以特征点为中心,以π/3为张角,采用扇形滑动窗口累积计算Haar小波在x,y方向的响应值,最终得到矢量Fw=(mw,θw),有

(6)

(7)

式中:w代表滑动窗口;dx、dy分别为滑动窗口中任一点在x、y方向的响应值;mw,θw分别为响应矢量的幅值和幅角。不断旋转扇形窗口,得到的长度最大的矢量对应的方向为主方向。

第二步是形成特征矢量。需要在主方向上构造边长为20s的正方形区域,并将该正方形划分为4×4个子区域,在每个子区域内都通过Haar模板计算响应值,最后统计响应值得到特征矢量,即

(8)

把16矩形子区域的向量描述子连接起来,即得到SURF特征向量。SURF算法的特征点最终由一个64维的特征向量描述。

3.2 RANSAC匹配识别

在实际SURF特征匹配中会存在误匹配。因此本文在完成初匹配的情况下要进一步对匹配对进行提纯。

本文使用投影变换模型,主要实现步骤如下:

1)从预匹配点对中随机选取4组建立方程组,估计变换矩阵M的参数。

2)计算剩余的匹配点经过M变换后与相对应的匹配点间的距离,若距离小于某一阈值,则该点为内点,否则为外点。

3)经过多次迭代,找出内点最多的变换矩阵,在该变换下,去除误差较大的错误匹配对。完成物体的匹配识别。

3.3 算法分析

根据SURF算法可知,SURF特征提取阶段计算量大,占据了大部分的系统资源。图像面积越大,细节特征越丰富,局部特征的数量则越多,特征提取和特征匹配的计算量也就越大。要满足家居服务机器人识别物体的实时性要求,可以通过减少局部特征的数量来提高SURF算法效率。

传统的减少局部特征的思路是调整阈值,通过改变阈值大小来控制特征数量的多少。这种方法可以提高SURF算法速度,但是因为是全局性调整阈值,对于重要特征点和非重要特征点一起过滤,实际上,图像不同区域对物体识别的重要程度有很大差异,因此,传统的阈值调整在去除非重要特征点的同时往往会过滤掉大量的重要特征点,从而影响算法的准确率。

与传统阈值调整方法不同,显著性检测在去除大量非重要特征点的同时可以有效保留重要特征。因此可以依据显著性区域提取算法去掉大部分背景,缩小检测图像面积,从而可以过滤掉大量不重要的特征点,则可以有效的减少SURF算法的运算量,同时提高物体识别准确率。

4 实验结果与分析

4.1 实验平台

家居服务机器人平台如图3所示,其主要结构如下:底盘左右两端各配置一个驱动轮,前端配置一个万向轮;计算部件采用ARK-3500无风扇嵌入式

工控机,其处理器为Intel Core i7-3610QE 2.3 GHz,内存可达16 Gbyte。视觉传感器采用FMVU-03MTC-CS,基于Visual Studio 2010进行开发。

图3 机器人平台

4.2 物体识别实验

设置对比试验,将本文改进算法与传统算法进行对比。在室内场景下,基于家居服务机器人进行场景视频的采集,在复杂程度不同的背景下进行对比试验。图像分辨率为640×480。实验分别选取了家居环境下常见物体易拉罐、洗洁精作为测试物体,实验结果分别如图4所示。

图4 家居服务机器人识别效果图

图4中,第一行组图像为显著性区域提取效果图,从图中可以看出,该方法可以很好地抑制背景图像,高亮显著性区域,得到图像的感兴趣部分,符合人类视觉认知模型。第二行图像为识别效果图,可知无论在简单背景还是复杂背景下,该算法都可以很好地识别物体,证明该算法具有良好的适用性。

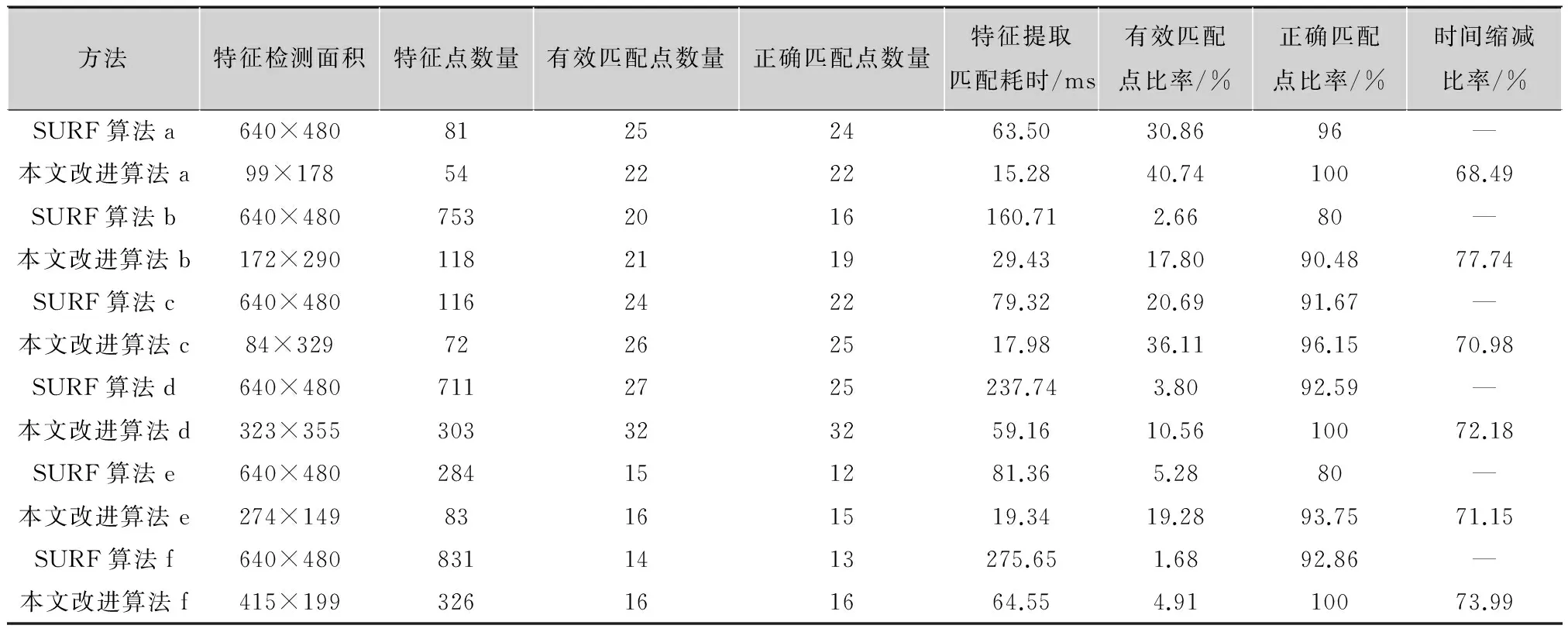

表1对图4中图片的特征数量、有效匹配点数量、正确匹配点数量等指标进行统计。

有效匹配点是指场景图片特征点中,可以成功与模板图片特征点进行匹配的部分。正确匹配点指场景图片特征点中,与模板图片特征点成功匹配并且正确匹配的部分。采用文献[18]中的评价标准来判断匹配点是否正确,对于两个正确匹配的特征点,应该满足以下条件:1)二者邻域交叠误差小于0.4;2)通过映射后的特征点之间的Euclidean距离小于6。 定义图片特征数量为n,有效匹配点数量为ne,正确匹配点数量为nc。

有效匹配点比率为

(9)

表1 实验结果列表

方法特征检测面积特征点数量有效匹配点数量正确匹配点数量特征提取匹配耗时/ms有效匹配点比率/%正确匹配点比率/%时间缩减比率/%SURF算法a640×48081252463.5030.8696—本文改进算法a99×17854222215.2840.7410068.49SURF算法b640×4807532016160.712.6680—本文改进算法b172×290118211929.4317.8090.4877.74SURF算法c640×480116242279.3220.6991.67—本文改进算法c84×32972262517.9836.1196.1570.98SURF算法d640×4807112725237.743.8092.59—本文改进算法d323×355303323259.1610.5610072.18SURF算法e640×480284151281.365.2880—本文改进算法e274×14983161519.3419.2893.7571.15SURF算法f640×4808311413275.651.6892.86—本文改进算法f415×199326161664.554.9110073.99

正确匹配点比率为

(10)

其中:有效匹配点比率可用来表示在进行特征点匹配时,从图片所有特征点中找到有效匹配点的概率。找到匹配点的概率越高,则说明对无效特征点操作相对越少。正确匹配比率用来反映在有效匹配点中正确的比例,用来表示误检的概率,比例越高,误检的概率越低。

定义原始图片特征提取匹配用时为td,显著性处理用时为ts,显著性处理后特征提取匹配用时为tsd。

则时间缩减比率为

(11)

通过表1可以看出,基于显著性指导的SURF算法相比于直接使用SURF算法,不仅使需要进行SURF特征检测的面积大幅度减少,而且特征点数量也大幅度降低,从而使特征提取匹配时间明显缩短,而显著性检测算法本身耗时仅为几毫秒,图4a、图4b、图4c、图4d、图4e、图4f这6幅图片显著性提取耗时分别为:4.73 ms,6.34 ms,5.04 ms,6.97 ms,4.13 ms,7.15 ms。通过式(11)计算,最后得到了良好的时间缩减比率。经过显著性处理后,有效匹配点数量不但不会明显减少,甚至出现了增多的情况,证明显著性提取效果较好。在显著性处理后,有效匹配点比率有较大提升,正确匹配比率也有所提高,说明经过显著性处理后可以去除非显著性区域特征点的干扰,并且所提取特征点对待识别物体具有较高的表征能力,可以与目标模板中特征点进行良好匹配,从而可以提高SURF算法识别的准确率。

为验证算法的适用性,选取家居环境中5种常见物体进行大量测试实验,其中毛绒玩具的纹理相对比较简单,如图5所示。

图5 测试物体

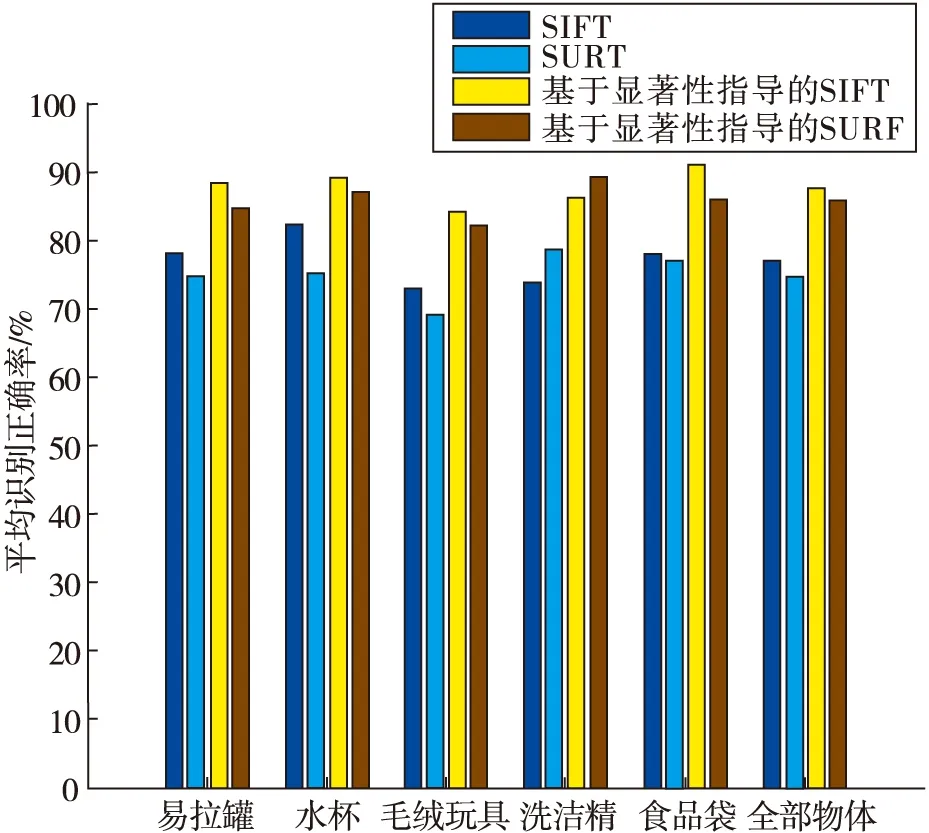

本文从识别率和算法耗时两个方面,比较SIFT算法、SURF算法、基于显著性指导的SIFT算法、基于显著性指导SURF方法的识别性能。

1)识别率比较

由于并不存在适用于本论文研究内容的数据库。所以基于家居服务机器人在不同场景下进行场景视频的采集,视频分辨率大小为640×480。在光照变化、物体遮挡、运动模糊、视角变化、尺度变化等各种场景下拍摄了多组视频序列进行测试。为了进行定量分析,记录了200幅简单背景下易拉罐图像、200幅复杂背景下易拉罐图像、200幅简单背景下水杯图像、200幅复杂背景下水杯图像、200幅简单背景下毛绒玩具图像、200幅复杂背景下毛绒玩具图像、200幅简单背景下洗洁精图像、200幅复杂背景下洗洁精图像、200幅简单背景下食品袋图像、200幅复杂背景下食品袋图像的识别情况与耗时情况,其中每一幅图像的背景均不同,经统计得到的识别率见表2。

表2 识别率对比

样本识别率/%传统SIFT方法传统SURF方法基于显著性指导的SIFT方法基于显著性指导的SURF方法简单背景易拉罐87.58292.590复杂背景易拉罐68.56783.579易拉罐总样本7874.58884.5简单背景水杯918394.588复杂背景水杯73.5678486水杯总样本82.257589.2587简单背景毛绒玩具8478.58784.5复杂背景毛绒玩具61.5598179.5毛绒玩具总样本72.7568.758482简单背景洗洁精8490.589.594.5复杂背景洗洁精6366.582.584洗洁精总样本73.578.58689.25简单背景食品袋87849489复杂背景食品袋6869.58882.5食品袋总样本77.576.759185.75

由表2可知,无论在复杂背景下还是简单背景下,基于显著性指导的SIFT和SURF算法比直接使用SIFT和SURF具有更高的识别率,尤其对于复杂背景图片提升效果更明显。此外,相对于传统的SIFT和SURF算法,背景复杂程度对本文改进算法识别率的影响更小,证明了基于显著性指导的SIFT和SURF物体识别比直接使用SIFT和SURF具有更好的稳定性。

图6更直观地显示了SIFT算法、SURF算法、基于显著性指导的SIFT算法、基于显著性指导的SURF算法的平均识别率对比情况。由图6可直观地看出,基于显著区域指导的物体识别算法是有效的。在显著图上提取特征点,极大地消除了复杂背景对特征提取的干扰,减少了错误匹配对,在进行显著性区域提取后,无论是基于SIFT特征还是SURF特征,5种物体的识别率均有了显著性提高。统计全部物体的平均识别率,基于显著性指导的SIFT算法的平均识别率最高,为87.45%,基于显著性指导的SURF算法的平均识别率为85.5%,与基于显著性指导的SIFT算法相比相差不大,传统SURF算法的平均识别率为74.7%,可知,本文改进的SURF算法相比传统SURF算法提高了约10%。

图6 物体识别率比较

2)算法耗时比较

本文从最大耗时、最小耗时、平均耗时3个方面对4种算法进行比较,结果如表3所示。由表3可知,经过显著性指导的SIFT算法和基于显著性指导的SURF算法相比传统SIFT算法和SURF算法,最大耗时、最小耗时和平均耗时均明显减少。其中,基于显著性指导的SURF算法平均耗时最小,这是由于经过显著性处理以后特征点检测面积和特征点数目同时减少,特征提取和匹配的时间极大缩短,而显著性提取过程耗时仅为几毫秒,因此,本节改进算法可以有效提高识别速度,提高算法效率。

表3 不同算法耗时比较

方法最大耗时/ms最小耗时/ms平均耗时/msSIFT算法1175.94197.82579.43SURF算法373.0550.34151.34基于显著性指导的SIFT算法235.0752.39139.75基于显著性指导的SURF算法83.7114.1537.25

从识别率角度考虑,虽然基于显著性指导的SURF算法要略低于基于显著性指导的SIFT算法,但是时间效率要比基于显著性指导的SIFT算法高很多,综合考虑家居服务机器人对识别率实时性的要求,基于显著性指导的SURF算法具有更好的适用性。

5 结论

本文提出了基于显著性区域指导的机器人物体识别算法。对含有目标物体的图像,通过视觉注意机制选择图像中显著区域,然后提取显著性区域SURF特征,经过图像匹配完成物体识别。基于家居服务机器人平台从识别率和算法耗时两个方面对本文改进算法进行测试。实验证明,与传统SURF算法相比,基于显著性区域指导的识别算法在识别率和实时性方面均有一定提高。

[1] XU Q, NG J S L, TAN O Y, et al. Needs and attitudes of Singaporeans towards home service robots: a multi-generational perspective[J]. Universal access in the information society, 2015,14(4): 477-486.

[2] KEHOE B, MATSUKAWA A, CANDIDO S, et al. Cloud-based robot grasping with the google object recognition engine[C]//Proc. 2013 IEEE International Conference on Robotics and Automation. Karlsruhe: IEEE, 2013: 4263-4270.

[3] CSURKA C, DANCE C R, FAN L X, et al. Visual categorization with bags of keypoints [C]// Proc. 8th ECCV Workshop on Statistical Learning in Computer Vision. Czech Republic: Springer, 2004: 1-22.

[4] LAZEBNIK S, SCHMID C, PONCE J. Beyond bags of features: spatial pyramid matching for recognizing natural scene categories [C]//Proc. 19th IEEE Conference on Computer Vision and Pattern Recognition, New York :IEEE, 2006: 2169-2178.

[5] CHEN Y, JI Z C, HUA C J. 3-D model matching based on distributed estimation algorithm[C]//Proc. 2009 Chinese Control and Decision Conference. Guilin: IEEE, 2009: 5036-5067.

[6] COLLET A, MARTINEZ M, SRINIVASA S S. The MOPED framework: object recognition and pose estimation for manipulation[J]. International journal of robotics research, 2011, 30(10): 1284-1306.

[7] LOWE D G. Distinctive image features from scale-invariant keypoints[J]. International journal of computer vision, 2004, 60(2):91-110.

[8] 杨扬. 基于机器视觉的服务机器人智能抓取研究[D].上海:上海交通大学, 2014.

[9] 吴月凤, 何小海, 张峰,等. SURF算法和RANSAC算法相结合的台标检测与识别[J]. 电视技术, 2014, 38(13):191-195.

[10] BAY H, ESS A, TUYTELAARS T, et al. Speeded-up robust features (SURF)[J]. Computer vision and image understanding, 2008, 110(3):346-359.

[11] Liu G H, Yang J Y, Li Z Y. Content-based image retrieval using computational visual attention model[J]. Pattern recognition, 2015, 48(8): 2554-2566.

[12] DESIMONE R, DUNCAN J. Neural mechanisms of selective visual attention[J].Annual reviews of neuro science, 1995(18):193-222.

[13] FISCHLER M A, BOLLES R C. Random sample consensus: a paradigm for model fitting with applications to image analysis and automated cartography[J]. Communications of the ACM, 1981, 24(6): 381-395.

[14] HOU X, ZHANG L. Saliency detection: a spectral residual approach[C]//Proc. IEEE Conference on Computer Vision and Pattern Recognition. Minneapolis: IEEE, 2007: 1-8.

[15] KIM J S, SIM J Y, KIM C S. Multiscale saliency detection using random walk with restart[J]. IEEE transactions on circuits and systems for video technology, 2014, 24(2): 198-210.

[16] PERAZZI F, KRAHENBÜHL P, PRITCH Y, et al. Saliency filters: contrast based filtering for salient region detection[C]//Proc. 2012 IEEE Conference on Computer Vision and Pattern Recognition, Providence. RI: IEEE, 2012: 733-740.

[17] WEI Y C, WEN F, ZHU W J. Geodesic saliency using back ground priors[C]//Proc. 12th European Conference on Computer Vision 2012. Berlin Heidelberg: Springer, 2012: 29-42.

[18] HUANG C R, CHEN C S, CHUNG P C. Contrast context histogram——an efficient discriminating local descriptor for object recognition and image matching[J]. Pattern recognition, 2008, 41(10):3071-3077.

薛翠红(1980— ),女,博士,讲师,主研图像处理、模式识别、机器人视觉;

齐立萍(1991— ),女,硕士生,主研智能机器人控制、模式识别;

孙 昊(1984— ),博士,副教授,主研机器人智能控制;

杨 鹏(1960— ),教授,博士生导师,主研智能机器人、模式识别、康复辅具。

责任编辑:薛 京

Object recognition algorithm based on saliency and SURF for home service robot

XUE Cuihong1,2, QI Liping2,3, SUN Hao2, YANG Peng2

(1.TechnicalCollegefortheDeaf,TianjinUniversityofTechnology,Tianjin300384,China2.SchoolofControlScienceandEngineering,HebeiUniversityofTechnology,Tianjin300130,China;3.CollegeofScienceandTechnology,AgriculturalUniversityofHebei,HebeiCangzhou061100,China)

Object recognition is one of the main problems of the home service robot. In view of the complexity of the object recognition in the indoor non-structural environment,local feature is selected as key features,which doesn’t dependent on image segmentation. To reduce the computation of the SURF algorithm, a local feature algorithm based on saliency region guidance is proposed. First of all, salient region is extracted from the image based on visual selective attention mechanism. Then, invariant SURF feature is extracted from the salient region. Finally, by matching the feature points, the recognition of target object in the scene is realized. Experimental results show that the speed is effectively improved compared with the traditional SURF algorithm, and the recognition rate is improved about 10 percent.

object recognition; home service robot; SURF features; visual selective attention mechanism

薛翠红,齐立萍,孙昊,等.基于显著性和SURF的家居服务机器人物体识别算法[J]. 电视技术,2017,41(2):54-60. XUE C H, QI L P, SUN H, et al.Object recognition algorithm based on saliency and SURF for home service robot[J]. Video engineering,2017,41(2):54-60.

TN911.73

A

10.16280/j.videoe.2017.02.012

国家自然科学基金项目(61305101;61503118);河北省自然科学基金项目(F2014202121;F2015202239);天津科技计划项目(14RCGFGX00846)

2016-05-18