简易交互式视频目标跟踪技术研究

梁 硕,陈金勇,吴金亮

(1.中国电子科技集团公司 航天信息应用技术重点实验室,河北 石家庄050081; 2.中国电子科技集团公司第五十四研究所,河北 石家庄050081)

简易交互式视频目标跟踪技术研究

梁 硕1,2,陈金勇1,2,吴金亮2

(1.中国电子科技集团公司 航天信息应用技术重点实验室,河北 石家庄050081; 2.中国电子科技集团公司第五十四研究所,河北 石家庄050081)

针对视频目标跟踪中背景干扰和跟踪持续性差的问题,提出了一种简易交互式视频目标跟踪的方法。依据用户提供的初始跟踪窗口,对目标范围进行自动优化,有效地避免了背景信息对跟踪的干扰。针对跟踪偏离目标的情况,结合用户对目标区域的粗定位,利用特征匹配方法快速获取精确的目标位置及范围。实验结果表明,提出的算法有效地剔除了背景信息的干扰,提高了跟踪的准确性,结合简易人工交互信息,实现了跟踪的连贯性和时效性。

视频目标跟踪;简易交互;目标范围优化;特征匹配

0 引言

视频目标跟踪在视频监控、航空侦查等方面有着非常重要的作用,是当前计算机视觉中一个非常具有挑战性的热点问题。视频目标跟踪问题就是在视频初始帧中给定目标的位置和范围之后,对目标进行特征提取,使得跟踪器能够在后续帧中与目标特征进行匹配,找到目标的位置,通过每一帧中成功的跟踪结果来更新跟踪器。

经过了几十年尤其是近10年的发展,视频目标跟踪取得了非常重要的成就。Avidan[1]提出基于支持向量机[2](SVM)的跟踪方法,通过求解使得目标与背景具有最大差异的候选目标这一优化问题,实现对目标的跟踪。Dalal等[3]提出了基于HOG特征的行人检测算法,将图像的梯度方向直方图和支持向量机相结合,在行人检测方面获得了良好的效果。Hare等[4]采用基于核函数[5]的 SVM分类器,实现了精度比较高的跟踪,但是跟踪的速度很慢。Zhang等[6]利用压缩感知[7]的知识,将正负样本通过尺度变换,对样本量进行扩充,然后将这个多尺度的样本空间的样本通过稀疏矩阵投影到低维空间中,既保证了样本准确度,又提高了效率。Kalal等[8]提出Tracking Learning Detection(TLD)算法,通过在线结构约束正负样本,可以对目标进行长时间的跟踪。Henriques等[9]在相关滤波器[10]作为跟踪器的基础上,加入了快速傅里叶变换,提出了 Kernelized Correlation Filters(KCF)算法,将时域的卷积计算变换到频域的乘积运算,大大提高了跟踪的速度。除此之外,基于贝叶斯理论[11]的跟踪方法和基于均值漂移[12]的跟踪方法都能在一定程度上对目标进行跟踪。

当前跟踪算法在没有背景信息干扰的情况具有非常良好的跟踪效果,并且能够实现实时跟踪。但在背景比较复杂的情况下,因为对目标框选得不够精确,背景干扰信息的加入极易造成跟踪的失败。目前的跟踪算法对严重遮挡的情况,无法进行有效处理,需要用户重新框选目标,重新进行跟踪,严重影响了跟踪的连续性和时效性。本文算法可以有效避免背景信息的干扰,并且在跟踪偏离目标后,用户只需要对目标区域进行简单点击,算法会自动匹配目标位置和范围,继续对该目标进行跟踪,实现跟踪的持续性。

1 视频目标跟踪框架

视频目标跟踪基本框架主要包含表观特征描述和跟踪算法2个方面。表观特征描述主要是通过相应的目标表观特征描述方法将目标相对稳定的统计特性或某些不变特性提取出来。在对目标的表观特征进行提取之后,选择合适的跟踪算法对目标进行跟踪。

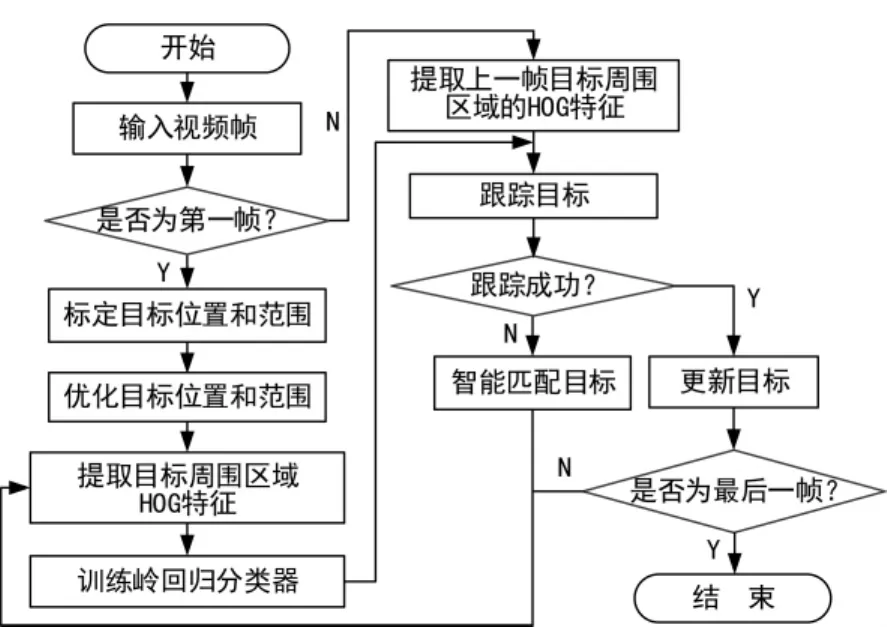

本文在视频目标跟踪基本框架基础上,增加目标范围优化,减少背景信息的干扰;添加智能目标匹配,处理跟踪失败情况,如图1所示。

图1 本文采取的视频目标跟踪流程

2 目标范围的优化计算

在对目标应用跟踪算法之前,需要人为给定目标的位置和范围,由于被跟踪目标的几何形状是未知的,因此给定的初始目标区域中总会包含部分背景信息,如图2所示。初始帧中的误差会随着跟踪的进程而逐步扩大,影响跟踪效果。尤其当目标遇到遮挡,跟踪极易失败。

图2 初始帧中人为标记的跟踪窗口

本文算法在初始帧中对目标范围做一些优化,自动地将目标特征提取的范围缩小至目标的几何范围,不包含任何背景信息,在跟踪开始阶段就消除背景的干扰。

对视频中目标范围的优化可以看成能量最小化问题,通过能量最小化函数,实现目标范围的优化。Rother等[13]提出了 grabcut分割算法,能够对图像进行有效分割。Tang等[14]在 grabcut的基础上,对算法进行了优化,具有更快的速度。本文基于Tang等[14]提出的算法对目标范围进行优化。

初始化目标区域可以表示为像素点的集合z= {z1,z2,z3…zn},每一个像素点对应一个标记a= {a1,a2,a3…an},an∈ { 0 ,1},其中an值为0表示背景,1表示前景即目标。在初始目标区域中,背景区域和前景区域分别对应一个高斯混合模型(GMM),每个GMM对应由K个高斯模型混合而成,每个像素有一个kn(kn∈ { 1 ,K }),参数来自前景还是背景取决于an的值。所选择的能量函数为:

E(a,k,θ,z)=U(a,k,θ,z)+V(a,z),

数据项U定义为:

D(an,kn,θ,zn)=-logp(zn|an,kn,θ)-logπ(an,kn)。

式中,p(·)表示高斯概率分布;π(·)表示混合权重系数。平滑项 V可用 RGB空间的欧几里德距离求:

式中,C为相邻像素对。在初始目标区域中,矩形框之内的区域为未知区域Tu,矩形框外的区域为背景区域Tb,基于此初始化GMM,对Tu进行迭代,求出目标区域Tf,如图3所示。

图3 初始帧中提取特征时只对深色区域提取特征

3 智能匹配目标

视频目标跟踪中,一旦出现目标跟丢的情况,即跟踪失败,无法达到长时间跟踪的效果。本文为了解决无法长时间跟踪的问题,设计实现简易交互,通过图像配准算法,来智能重新捕获目标进行跟踪。

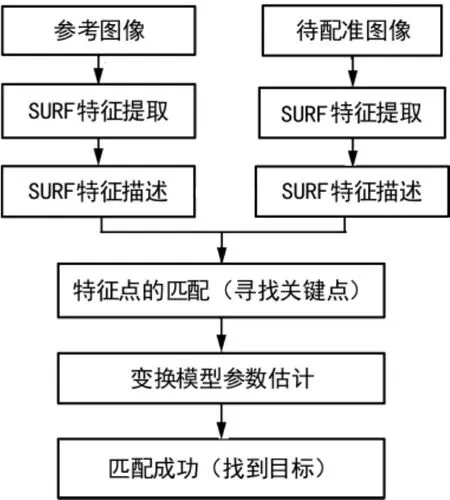

在出现目标跟丢的情况,只需用户在目标区域内点击一下,通过图像配准来智能匹配目标。SIFT[15]和SURF[1 6]特征都具有尺度不变性和旋转不变的特点,对光照变化和仿射透视变换具有部分不变性。但SURF特征的速度更快,本文采用该特征来实现图像配准,具体流程如图4所示。

图4 图像配准流程

SURF使用了近似的Hessian矩阵检测关键点,并使用积分图像大幅减少了运算。在特定点检测阶段,用不同大小的方框滤波与原始图像做卷积,形成图像金字塔,易于并行。特征点的位置确定以后,为保持特征点的旋转不变性,需要给每个特征点确定一个主方向,特征点邻近圆域内,计算 x和y方向上的Haar小波响应极值表示。以特征点为中心,选取一边垂直于主方向、边长为 20像素的正方形区域,划分成4*4子域,每个子域计算5*5个区域用相对主方向的水平和垂直的子区域,每一子区域用8方向的 Haar小波响应之和∑dx,∑dy,以及响应的绝对值之和∑|dx|,∑|dy|来表示,形成4*4*4=64维描述向量。特征检测结果如图5所示。目标的脸部以及腿部可以检测到许多特征点,基于此参考图像图5(a)和待配准图像图 5 (b)可以和目标模板进行配准。

图5 SURF特征检测结果

4 实验结果

为了验证算法的有效性,本文在KCF跟踪算法中增加了目标范围优化算法与智能匹配目标算法,与KCF算法进行比较。算法运行环境为 Intel Core i7-3770,CPU 3.40 GHz,RAM3.47 GB的PC机,基于C++和Opencv实现,视频分辨率为480*640,能够做到实时处理,图6展示了算法对比实验的结果。

图6 实验结果

图6(a)为KCF算法(细线条矩形框)与加入优化目标范围之后的算法(粗线条矩形框),分别为视频第206、246、254、265帧。图6(b)为长时间跟踪之后的KCF算法(细线条矩形框)和加入智能目标匹配之后的算法(粗线条矩形框),分别为第 878、905、911、915帧。由图6(a)可以看出,在没有任何遮挡的情况下,KCF算法和本文算法都能对行人目标进行准确跟踪(第206帧)。当有物体遮挡目标时,如果不对目标范围进行优化,跟踪就会发生偏离,并且无法找回目标重新进行跟踪(图6(a)中细线条矩形框),而采用本文算法对目标范围进行优化之后,在面对遮挡的情况下仍然能够取得良好的跟踪效果(图6 (a)中粗线条矩形框)。当对目标进行长时间的跟踪之后,由于误差的累积,KCF算法和本文目标范围优化的算法均会发生不同程度跟丢目标的现象(图6 (b)中第878帧和第905帧)。当出现跟丢目标的现象时,通过智能匹配目标的算法,只要用鼠标点击目标附近区域,则会自动对目标进行匹配,找回目标继续跟踪(图6(b)中粗线条矩形框)。

5 结束语

本文提出了一种简易交互式视频目标跟踪算法,该算法在不需要复杂人机交互的情况下能够完成对视频目标的跟踪。首先,在视频目标跟踪的初始阶段对目标的范围进行优化,将目标区域缩小到了仅包含目标的范围,减少了背景信息的干扰,有效区分了目标和背景的特性,提高了跟踪的稳定性。然后,在视频目标跟踪过程中,当出现丢失目标的现象时,借由对目标的粗定位,智能对目标进行匹配,使得丢失目标之后能够自动重新获取目标继续跟踪,提高了跟踪的连续性。经过实验验证,本文提出的算法极大地提高了视频目标跟踪的鲁棒性,更有利于对目标进行长时间稳定地跟踪。

[1] AVIDAN S.Support Vector Tracking[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2004,26(8):1 064-1 072.

[2] RAMANAN D,MCALLESTER D,FELZENSZWALB P,et al.A Discriminatively Trained,Multiscale,Deformable Part Model[C]∥ IEEE Conference on Computer Vision and Pattern Recognition,2008:1-8.

[3] DALAL N,TRIGGS B.Histograms of Oriented Gradients for Human Detection[C]∥IEEE Conference on Computer Vision and Pattern Recognition,2005:886-893.

[4] HARE S,SAFFARI A,TORR P.Struck:Structured Output Tracking with Kernels[C]∥IEEE International Conference on Computer Vision,2011:263-270.

[5] 尹传环.结构化数据核函数的研究[D].北京:北京交通大学,2008.

[6] ZHANG K,ZHANG L,YANG M H.Real-time Compressive Tracking[C]∥European Conference on ComputerVision,2012:866-879.

[7] 侯 猛,李 斌,孙学斌,等.基于簇的块稀疏压缩感知的60 GHz信道估计[J].无线电通信技术,2012,38(6):32-34.

[8] KALAL Z, MIKOLAJCZYK K, MATAS J. Tracking Learning Detection[J].IEEE Transactiongs on Pattern Analysis And Machine Intelligence,2012,34(7):1 409-1 422.

[9] HENRIQUES J F,CASEIRO R,MARTINS P,et al.High-Speed Tracking with Kernelized Correlation Filters[J].IEEE Transactiongs on Pattern Analysis and Machine Intelligence,2015,37(3):583-596.

[10]DAVID S,BOLME J,BRUCE A,et al.Visual Object Tracking Using Adaptive Correlation Filters[C]∥ IEEE Conference on Computer Vision and Pattern Recognition,2010:2 544-2 550.

[11]宋骊平.被动多传感器目标跟踪方法研究[D].西安:西安电子科技大学,2008.

[12]张 瑞.粒子滤波和均值漂移相结合目标跟踪算法[J].无线电通信技术,2011,37(2):29-31.

[13]ROTHER C,KOLMOGOROVV,BLAKEA.GrabCut Interactive Foreground Extraction Using Iterated Graph cut[J].Proceedings of ACM SIGGRAPH,2004,23(3): 309-314.

[14]TANG M,GORELICK L,VEKSLER O,et al.GrabCut in One Cut[C]∥ IEEE InternationalConference on Computer Vision,2013:1 769-1 776.

[15]LOWE D G.Distinctive Image Features from Scaleinvariant Keypoints[J].International Journal of Computer Vision,2004,60(2):91-110.

[16]BAY H,ESS A,TUYTELAARS T,et al.Surf:Speeded up Robust Features[J].Computer Vision and Image Understanding,110(3):346-359.

An Easy Interactive Video Object Tracking Method

LIANG Shuo1,2,CHEN Jin-yong1,2,WU Jin-liang2

(1.Key Laboratory of Aerospace Information Applications of CETC,Shijiazhuang Hebei 050081,China; 2.The 54th Research Institute of CETC,Shijiazhuang Hebei 050081,China)

To overcome the problem of background interference and poorly persistent tracking in video object tracking,an easy interactive method is proposed.Using the initialized bounding box of the object given by the user,the extent of the bounding box is automatically optimized to avoid the interference of background information.For the drifting problem,the proposed method makes use of the coarse location given by the user and feature matching to regain the location and extent of the object.The experiment results show that the proposed method eliminates the interference of background information and improves the accuracy of tracking.With the easy interactive information,the proposed method realizes coherence and timeliness of tracking.

video object tracking;easy interaction;object extent optimization;feature matching

TP391.4

A

1003-3106(2017)02-0048-04

10.3969/j.issn.1003-3106.2017.02.12

梁 硕,陈金勇,吴金亮.简易交互式视频目标跟踪技术研究[J].无线电工程,2017,47(2):48-51.

2016-11-18

海洋公益性科研专项基金资助项目(201505002)。

梁 硕男,(1991—),硕士研究生。主要研究方向:视频图像处理。

陈金勇男,(1970—),研究员,博士生导师。主要研究方向:航天地面应用、电子信息系统。