融合小波变换及SIFT算法的去抖动运动目标检测

葛鹤银, 孙建红, 林 楠, 吴 凡

(南京理工大学 电子工程与光电技术学院, 江苏 南京 210094)

融合小波变换及SIFT算法的去抖动运动目标检测

葛鹤银, 孙建红, 林 楠, 吴 凡

(南京理工大学 电子工程与光电技术学院, 江苏 南京 210094)

采集视频信息时因摄像机抖动造成图像不稳定,将给后期运动目标检测带来严重的误检测问题。针对此问题提出一种融合小波变换及自适应SIFT算法的运动补偿方案。首先引入基于阈值的小波变换对图像进行去噪,然后设计变步长迭代准则自适应地搜索匹配的SIFT特征点,保证了高配准精度的特征点对的获取,通过对比当前帧与参考帧匹配特征点的偏移量估计抖动参数,再利用改进的高斯混合模型对运动补偿后的视频帧进行运动目标检测。实验结果表明,与同类方法相比,能够获取具有更高配准度和稳定性的匹配特征点对以有效地估计抖动参数,具有良好的去抖动效果和较高的运动目标检测精度。

尺度不变特征变换; 小波变换; 去抖动; 运动目标检测

0 引 言

在视频监控领域,运动目标检测作为后续对运动物体归类、跟踪和识别的基础,具有重要的意义,其基本要求是准确、快速地将已知视频序列中的运动目标从场景中提取出来。然而受外界因素,尤其是自然因素的影响,安装于户外的监控摄像机无法保证绝对静止,风吹、震动等都将导致其抖动或移动,由此产生的视频序列图像帧背景的跳跃性变化将对运动目标检测的准确性造成诸多不利影响[1-2]。为此,研究一套检测精度高、鲁棒性好的去抖动的运动目标检测算法是本文的重点。

目前视频去抖动方法主要分为3类:光流法、块运动估计法和特征法。光流法主要根据光流信息,运动分析获得图像全局运动参数来补偿原始序列。文献[3]整合相邻帧的光流来估计每个像素往同一方向运动的距离,但需要计算每一像素的瞬时光流场,实时性差,光流法固有的孔径问题也会影响检测效果。块运动估计法是根据视频序列中时间上相关信息估计场景或目标的运动向量场。文献[4]提出一种基于运动矢量的抖动估计和校正方案,利用块估计方法计算运动矢量,有良好的去抖动效果,但进行全局变换时会引入前面累积的误差,限制了去抖动的效果。特征法在提取每帧图像的特征点的基础上,对相邻帧进行特征匹配,根据匹配结果计算全局运动参数,该方法很大程度上取决于特征匹配的精度。

尺度不变特征变换(Scale Invariant Feature Transform,SIFT)[5]是由Lowe提出和完善总结的一种经典的图像特征提取与描述的算法,广泛应用于图像匹配领域。该算法检测到的关键点对旋转、尺度缩放、亮度变化具有不变性,对视角变化、仿射变换、噪声也具有一定程度的稳定性。近年来,不少学者提出了诸多基于SIFT的改进算法如SURF、PCA-SIFT、F-SIFT等[6-8]。传统的SIFT匹配算法存在耗时较长,易引入误匹配的问题。本文首先引入二维Mallat快速小波变换算法对视频图像帧进行分解,将低于阈值的高频系数置零,再重建图像,以提高图像匹配的精度和速率。由于在相机抖动或自然环境变化的情况下图像位置的微小偏移不会改变其局部特征,故接着在SIFT算法的基础上设计变步长迭代算法搜索当前帧与参考帧之间的最佳匹配特征点,通过对比匹配点对的位置偏移估计视频帧的抖动参数,再进行运动补偿校正抖动的图像帧。最后采用小波变换与高斯混合模型相结合的运动目标检测算法[9]。该方案可有效抑制抖动造成的检测误差,分割出精度较高的运动目标。

1 融合小波变换及自适应SIFT算法的匹配方案

1.1 改进的快速小波算法

Mallat快速小波算法根据相邻尺度离散小波变换(DWT)系数间的规律性,利用双通道、子带编码迭代地自底向上建立小波变换,实现DWT的高效分析与计算[10]。采用小波滤波器对图像数据进行反复低通和高通滤波迭代,更大尺度上实现高通和低通分量的分离。二维情况下,DWT需要1个二维尺度函数φ(x,y)和3个二维基本小波ψH(x,y) ,ψV(x,y)和ψD(x,y)。利用尺度函数和小波函数的正交性得到尺度系数:

(1)

(2)

(3)

对图像进行二维小波变换,分解后的每一层按分辨率从高到低自底向上叠放,对应了图像金字塔结构。小波变换中分解、重构的级数越多,划分的频带越细,越有利于编码。然而,级数的增加会导致级联的滤波器增多,信号的移位变大,而伴随着每一次分解、重构的延拓,边界失真亦愈加严重。文献[11]指出,小波变换进行多层分解时,二层以上低频部分的能量会急剧减少,匹配点的数量也非常少。本文选用二尺度分解在确保精度的前提下有利于保证小波变换的实时性。同时针对图像在小波变换域的能量主要集中在低频部分、大部分噪声主要集中于高频部分中幅值较小的系数的特点,采用基于阈值的小波变换,将高频子图中低于阈值的高频系数置零,高于阈值的系数保留,再与低频子图一起进行重构[12]。该方法能够既保留图像的细节,又达到了抑制噪声的目的,有利于减少弱匹配点,提高特征匹配的准确性和鲁棒性。

1.2 自适应SIFT算法

尺度不变特征变换(STFT)是图像匹配领域的经典算法,流程主要包括尺度空间极值点检测、关键点定位、方向确定、关键点描述符生成和特征匹配。本文意在原始STFT算法的基础上提出改进,以获取精度高,实时性强的匹配特征点。

SIFT匹配算法采用欧氏距离度量两幅图像的相似度,利用优先K-D树近似BBF搜索算法处理128维的特征向量,获取每个特征点的两最近邻特征点。为了排除因图像遮挡和背景混乱而产生的无匹配关系的关键点,采用比较最近邻距离与次近邻距离的方法:在模板图像中取一特征点,利用欧式距离区别最近邻特征点和次近邻特征点,若最近邻特征点欧式距离除以次近邻特征点欧式距离小于某一比例阈值,则接受为一对正确匹配点。

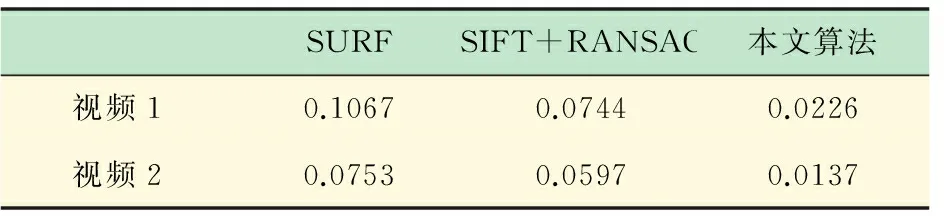

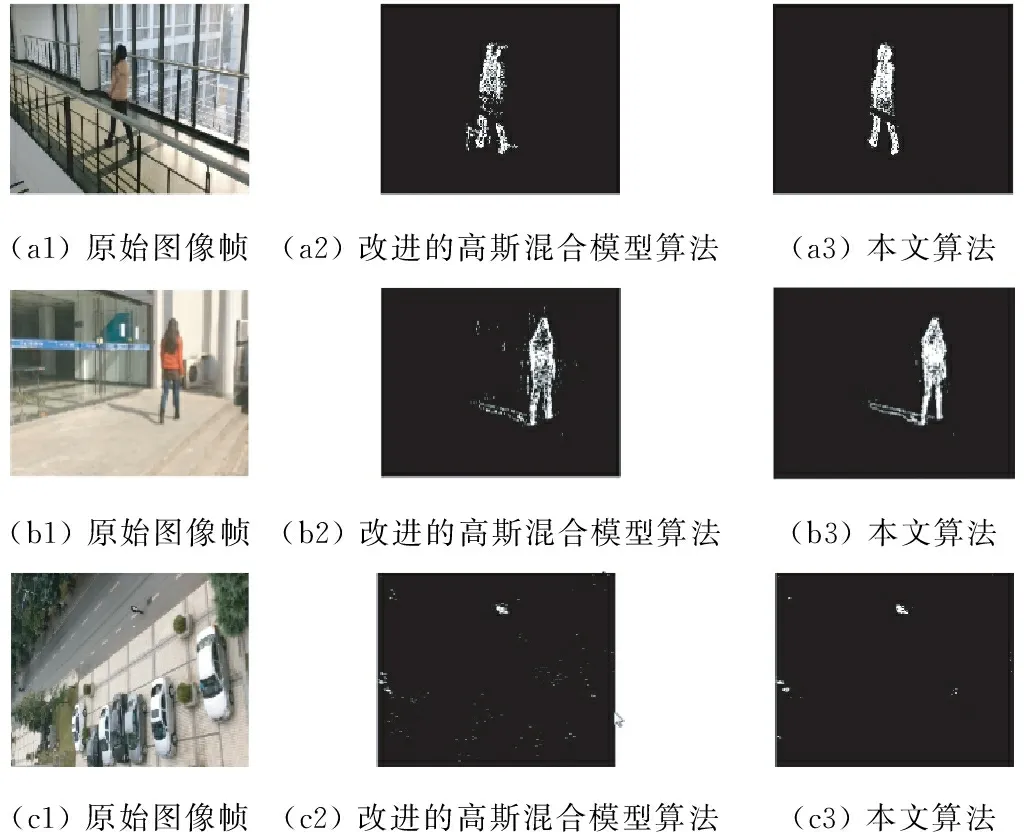

本文提出一种变步长迭代准则自适应地设定阈值,以取得具有高匹配率的特征点。取t1时刻当前帧图像I1某一关键点A,利用优先K-D树近似BBF搜索算法处理t2时刻当前帧图像I2的128维的特征向量,获取每个特征点的两最近邻特征点B和C,则A与B、A与C之间的欧氏距离分别为dAB和dAC,设dAB R=dAB/dAC (4) 对比例阈值R进行迭代求取匹配对集V,R取值较高时,相似的距离可能使V中包含大量的误匹配,故起初设定的阈值要较小。文献[3]中比例阈值为0.8时,可以去除约90%的误匹配对,但以丢失约5%的正确匹配对为代价;若设定比例阈值大于0.8,误匹配对数会急剧上升,包含大量匹配信息的两幅图像不仅降低了算法的实时性,还使得携带的误匹配影响了抖动参数的估计;若比例阈值小于0.8,正确匹配对数量加速流失,误匹配对数量缓慢减少,但最近邻特征点B相对于次近邻特征点C离特征点A更近,最近邻特征点更加稳定。 由于提取的匹配特征点对将用于估计视频图像的抖动参数,故应尽可能保证匹配点对不包含误匹配。本文通过自适应方法迭代搜索最佳阈值,在设计迭代搜索匹配点对过程中要合理设置阈值,应确保匹配对的个数适中,若少于100个将使得后期对抖动做运动补偿时输入参数不足,太多则会引入部分误匹配,给抖动参数估计引入误差。为了保证提取到的匹配特征点对达到要求,搜索过程细分为粗搜索和精确搜索。 设初始比例阈值为R0,为保证初始时刻匹配对的精确性,R0取值应较小,以减少误匹配对。当初始匹配对个数为n0,视频帧图像大小为M×N时,匹配对个数n范围在100~MN/200。因此若迭代过程中匹配对个数小于100,则需适当增加比例阈值R;当n大于MN/200时,则需适当减小R。本文采用变步长迭代,以Th为界,当比例阈值R>Th时,为精确搜索,采用小步长迭代;否则为粗搜索,采用大步长迭代。迭代步长分别为β=0.01,5β=0.05,迭代次数k不超过50次。自适应阈值迭代过程如图1所示。 图1 自适应阈值迭代过程 对比例阈值R进行缩放迭代,得到匹配对数为n的匹配对集V。然后利用匹配对集V计算两幅视频帧之间的对应关系。本算法利用自适应迭代实现最优搜索,得到的匹配点抑制了误匹配,稳定性高。 1.3 稳定匹配点的获取 获取稳定的匹配特征点对抖动参数的估计意义重大。由变步长迭代准则获取的阈值不同,对匹配点搜索的影响也较大。不同的阈值对匹配点的影响如表1所示。视频1为户外太阳光照射有阴影的视频;视频2是室内有光照变化的视频。 表1 视频1、2的特征点数与匹配点数 分别采用SURF算法、SIFT与RANSAC结合的算法和本文小波变换与自适应SIFT结合的算法对视频1、2进行特征点匹配运算,结果如图2和图3所示。 图2 视频1的第15和127帧的匹配结果 图3 视频2的第20和172帧的匹配结果 视频拍摄未采用固定脚架,图像帧之间因抖动会存在位置上的偏移。从图2、3可以看出,SURF算法存在较多的误匹配。视频1实验中,由于拍摄抖动,第127帧右下角拍摄到了第15帧中没有的场景,而SIFT+RANSAC算法却将其与第15帧的右下角进行了特征匹配,显然存在较大误差。本文算法去除了大部分的误匹配,且数量明显少于其他两种算法。由表2可以看出,本文算法的误匹配率明显低于其他两类算法,在去除大部分误匹配的同时保留了稳定的匹配对。 表2 3种算法的误匹配率比较 (5) 本文采用文献[9]将小波变换和高斯混合模型相结合的目标检测算法。高斯混合背景模型针对每一个像素建立分布模型,并实时更新模型参数,但相邻像素间的颜色信息是无相关性的,且各像素的高斯模型相互独立,单一判断方法容易造成运动目标的误检测[13-14]。结合Mallat小波提取图像的纹理信息[15],将亮度与纹理信息赋予不同的权值组成新的特征向量来更新高斯背景参数,经小波分解后的纹理信息得到增强,而且高斯混合模型能够很好地拟合背景颜色信息的变化,两者相结合可以提高背景和目标颜色相近以及复杂背景环境下的目标分割精度。该目标检测算法可以改善传统高斯混合模型存在较多误分割的现象,并且当目标与背景相接近时,仍能较好地分割运动目标。结合前期的去抖动处理算法,本算法针对稳定性欠佳的视频图像有较好的运动目标检测效果。 本文的运动目标检测方案主要针对视频抖动问题,亦可用于自然环境下的运动目标分割。为验证本文的算法,采用Matlab R2014a编写实现相关算法。分别采用3段视频对算法进行验证。视频1的拍摄环境为室内光照微变的场景,视频2为室外太阳光照射有阴影的场景,视频3则为有风吹树叶摆动的复杂场景,3类视频均在拍摄过程引入了人为抖动,视频分辨率为480×640。图4为分别采用改进的高斯混合模型和本文算法对3段视频进行运动目标检测实验结果。 图4 实验结果 由图4可以看出,改进的高斯混合模型算法虽结合了图像的纹理信息作为颜色信息的补偿,取得了较好的检测效果,但由于拍摄过程中的抖动,造成的背景偏移,使得部分背景尤其是运动目标周围的背景会被误检测为前景。同时,图像的偏移也会造成原本的目标检测结果存在虚影现象。又如图 4(c1)中,自然环境下风树叶产生的抖动易造成背景误判为前景,故在检测结果中这些误差的对应位置都可见较密集的噪点。应用本文算法,可以利用运动补偿来校正视频图像因抖动而引入的偏移,抑制目标检测的误差,从而较好地分割出目标对象。 最后,采用IEEE Change Detection Workshop (CDW)评价检测标准来定量地进行客观评价分析。定义TP为检测到的正确的目标点数,FP为错误目标点数,FN为错误背景点数,TN为正确背景点数。评价内容包括: Re(Recall)=TP/(TP+FN); Sp (Specificity) : TN/(TN + FP); FPR (False Positive Rate) : FP/(FP + TN); FNR (False Negative Rate) : FN/(TP + FN); PWC (Percentage of Wrong Classifications) : 100 * (FN + FP)/(TP + FN + FP + TN); Precision : TP/(TP + FP); F-Measure: (2 * Precision * Recall)/(Precision + Recall)。 对实验采用的三段视频分别统计上述参数值并取平均值,结果如表3所示。 在错判率和误判率方面,本算法的相关参数指标均较小,正确检测率和精度也较高。可以看出本算法与改进的高斯混合模型对比具有明显的先进性,故采用本文提出的方案对抖动视频序列进行运动目标检测具有理想的效果。 表3 评价参数比较 针对视频序列抖动引起的运动目标误检测的问题,提出了一种融合小波变换及自适应SIFT算法的检测方案。采用本算法,在拍摄过程存在抖动的视频中亦可检测到匹配精度高,稳定性强的特征点对。同时,通过对比匹配特征点之间的位置偏移来估计视频序列的抖动参数,以及通过运动补偿来校正发生偏移的图像。最后,利用改进的高斯混合模型算法来分割运动目标。实验结果表明,通过引入小波变换,同时设计变步长迭代准则自适应获取匹配特征点对,使得本文设计的去抖动方案能够有效的抑制抖动误差,提高了运动目标的检测精度。 [1] Brahme Y B, Kulkarni P S. An implementation of moving object detection, tracking and counting objects for traffic surveillance system[C]∥International Conference on Computational Intelligence and Communication Systems, Gwalior, India, 2011: 143-148. [2] Robert Fergus, Barun Singh, Aaron Hertzmann, Sam T. Roweis, William T. Freeman. Removing camera shake from a single photograph[J]. ACM Transactions on Graphics,2006,25(3): 787-794. [3] Tian Ying-li, Hampapur A. Robust salient motion detection with complex background for real-time video surveillance[C]∥Proceedings of IEEE Workshop on Motion and Video Computing, Breckenridge, CO, United states, 2005, (2): 30-35. [4] 宋 利,周源华,周 军. 基于运动矢量的视频去抖动算法[J]. 上海交通大学学报, 2004,38(S1):63-66,72. [5] Lowe D G. Distinctive image features from scale-invariant keypoints[J]. International Journal Computer Vision, 2004, 60(2):91-110. [6] Bay H, Ess A. Speeded-up robust features (SURF)[J]. International Journal on Computer Vision and Image Understanding, 2008, 110(3):346-359. [7] Ke Y, Sukthankar R. PCA-SIFT: a more distinctive representation for local image descriptors[J]. Proceedings of IEEE Computer Society Conference on Computer Vision and Pattern Recognition, 2004,2(2): 506-513. [8] Wan-Lei Zhao, Chong-Wah Ngo, Flip-Invariant SIFT for Copy and Object Detection[J]. IEEE Transactions Image Processing, 2013, 22(3), 980-991. [9] 蔡 念,陈世文,郭文婷. 融合高斯混合模型和小波变换的运动目标检测[J]. 中国图象图形学报, 2011, 16(9): 1716-1721. [10] Mallat S. A theory for multiresolution signal decomposition: the wavelet representation [J], IEEE Transactions on Pattern Analysis and Machine Intelligence, 1989, 11(7): 674-693. [11] VIOLA P, JONES M. Rapid object detection using boosted cascade of simple features[C]. IEEE Computer Society Conference, Computer Vision and Pattern Recognition, 2001(1):511-518. [12] 马 宁,周则明,罗立民. 基于方向小波变换的自适应图像去噪方法[J].计算机工程, 2012, 38(14): 184-186. [13] 崔文频,沈继忠. 基于改进高斯混合模型的运动物体的图像检测[J]. 光电工程, 2010, 37(4): 118-124. [14] PENG Suo, WANG Yan-jiang. An improved adaptive background modeling algorithm based on Gaussian mixture model [C] //Proceedings of ICSP2008. Beijing: IEEE Press, 2008:1426-1439. [15] Liyuan Li, Leung M K H. Integrating intensity and texture differences for robust change detection[J]. IEEE Transactions Image Processing,2002,11(2): 105-112. A Moving Target Detection Approach to Remove Jitter by Fusing Wavelet Transform and SIFT Algorithm GEHe-yin,SUNJian-hong,LINNan,WUFan (School of Electronic and Optical Engineering, Nanjing University of Science and Technology, Nanjing 210094, China) Unstable video images caused by camera jittering will lead to inaccurate or error detection results. Aiming at this problem, a motion compensation scheme is proposed by combining wavelet transform and adaptive SIFT algorithm. First, the wavelet transform based on threshold is applied to remove noise of the image, the iterative criterion of variable step is established to adaptively search the matched SIFT key points, the match of features obtained is much more precisely. Then the jitter parameter is estimated by analyzing offset of these matched points. Finally, the Gaussian mixture models combined with wavelet transform are employed to detect moving target. Compared with the similar algorithm, the proposed method can obtain more precise and stable matched feature points such that the effective estimation of jitter parameters is assured. It can solve the jitter effectively and detect the moving target precisely and efficiently. scale invariant feature transform (SIFT); wavelet transform; remove jitter; moving target detection 2015-07-05 江苏省产学研联合创新基金(BY2014004) 葛鹤银(1990- ),女,江苏盐城人,硕士在读,主要研究方向为计算机视觉与模式识别。 Tel.:15720612865; E-mail: lycheery@126.com 孙建红(1966- ),女,江苏张家港人,副教授,主要从事电路与系统的研究与教学。 Tel.:025-84303086; E-mail: sunjh@njust.edu.cn TP 391.4 A 1006-7167(2016)02-0119-05

2 抖动校正与运动目标检测

3 实验结果及分析

4 结 语