基于CSIFT特性的无人机影像匹配

耿娟, 何成龙, 刘宪鑫

(1.西南交通大学轨道交通工程遥感联合研究中心,成都 610031;

2.西南交通大学地球与工程学院,成都 610031)

基于CSIFT特性的无人机影像匹配

耿娟1, 何成龙2, 刘宪鑫2

(1.西南交通大学轨道交通工程遥感联合研究中心,成都610031;

2.西南交通大学地球与工程学院,成都610031)

摘要:随着无人机(unmanned aerial vehicle,UAV)平台技术的发展,越来越多的应用行业和研究领域开始使用UAV影像数据。不同于现有的摄影测量结合像控点的UAV影像匹配方法,提出一种新的UAV影像匹配方法。该方法采用彩色尺度不变特征转换(color scale-invariant feature transform,CSIFT)算法,利用彩色信息的空间不变特性提取基准影像与待匹配影像的特征匹配点对; 并采用单应性矩阵与随机抽样一致性(random sample consensus,RANSAC)算法对匹配结果进行提纯,得到最终匹配结果。仿真实验表明,该方法可在保证实验过程鲁棒性的同时,与传统的尺度不变特征转换(color scale-invariant feature transform,SIFT)方法相比,将匹配准确率从70%提高到了88%,而且大大减少了特征点对的数量,缩短了处理时间,提高了UAV影像匹配效率。

关键词:无人机影像; CSIFT特征; 特征匹配点; 单应性矩阵; 随机抽样一致性(RANSAC)

0引言

随着科技发展的不断推进,遥感技术正越来越多地深入各行各业,并得到充分的应用。同时,遥感技术自身也在逐步发展,其中尤以无人机(unmanned aerial vehicle,UAV)技术比较突出。因其快速、便捷与费用低等优点,越来越多的生产应用单位愿意选择UAV作为遥感影像数据的获取方式。但是,不同于传统大飞机平台的稳定与卫星影像较强的刚性特征,UAV平台受自身配重轻、抗风能力弱的影响,获取数据时存在一系列不稳定因素,使获取的影像数据容易产生复杂的几何变形; 另一方面,由于UAV影像尺寸较小,在需要覆盖大范围区域的影像时,就会涉及到多景UAV影像的匹配和拼接问题。UAV影像的匹配与拼接一般可分为4个步骤: 影像预处理、影像配准、影像坐标系映射和影像融合。目前,较多的研究集中在影像配准方面。影像配准的核心工作是找出相邻2景影像中的重叠区域,并确定这2景影像的变换关系。现有对UAV影像匹配和拼接的研究比较多,主要分为2类: ①利用传统摄影测量技术,通过最终的正射影像图进行匹配和拼接。虽然结合地面控制点、利用严格的摄影测量方法有非常成熟的工作流程,但这种方法按摄影测量原理,需要高精度的控制点坐标和稳定的UAV飞行姿态参数,其处理结果虽然精度高,但费时费力,无法体现UAV快速获取数据的优点。②在无控制点的前提下,针对影像本身特征进行匹配和拼接。基于影像特征的方法主要利用影像的显著特征(如特征角点或关键点、轮廓信息和其他一些不变矩)估计2景或多景影像之间的变换关系。这种方法的关键技术在于提取影像的特征点或特征轮廓[1],主要包括基于频率域和空间域的配准与加权融合[2-3]。其中,基于频率域的影像配准算法(如Fourier-Mellin算法)可以很好地解决UAV影像的平移、旋转和缩放问题,但对影像的尺度和重合度要求较高[4]; 基于空间域的配准算法(如尺度不变特征转换(scale-invariant feature transform,SIFT)算法)拼接后的结果影像质量很高,但在搜索特征点时采用固定尺寸核,处理时间长且效率不高[5]。而结合Harris 算子和区域相关系数(local area correlation coefficient,LACC)、利用金字塔多层匹配的多约束条件配准算法,则复杂度高且效率低[6]。因此,鉴于SIFT算法效率不高,且需要提前将现有的UAV彩色影像转为灰度影像进行匹配拼接处理的问题,本文拟采用彩色尺度不变特征转换(color scale-invariant feature transform,CSIFT)算法,在保证影像颜色信息不变的前提下提取基准影像与待匹配影像的特征匹配点对,并采用单应性矩阵与随机抽样一致性(random sample consensus,RANSAC)算法对匹配结果进行提纯。研究中进行的仿真实验证明,与传统的SIFT算法相比,本文方法可实现更高精度、更高效率的UAV影像匹配。

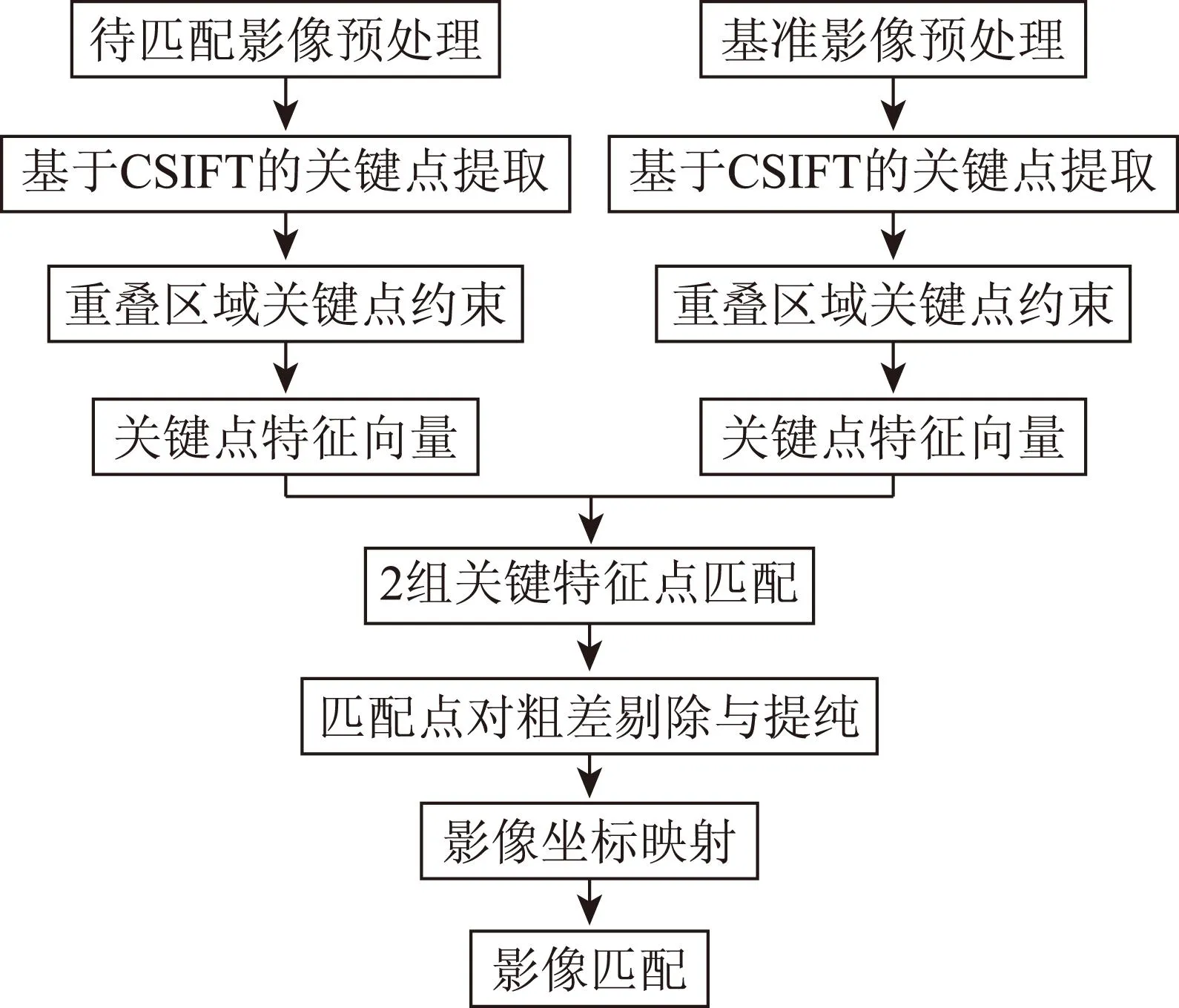

1UAV影像匹配

本文首先基于彩色信息空间不变特性的CSIFT方法和在重叠区域通过对特征点的约束实现对UAV影像匹配点对的提取,以解决传统的SIFT算子运算时间长且需将彩色UAV影像灰度化的问题; 然后利用单应性矩阵与RANSAC算法对匹配点对进行粗差剔除与提纯; 最后利用最终的匹配点对计算基准影像与待匹配影像之间的坐标映射参数,实现UAV影像的匹配(图1)。

图1 UAV影像匹配技术流程

2SIFT特征匹配

SIFT是一种基于尺度空间特性,对图像缩放、旋转以及仿射变换保持不变性的图像局部特征描述算子。其核心的尺度空间函数为高斯函数与影像函数的卷积,即

L(x,y,σ)=G(x,y,σ)*I(x,y) ,

(1)

(2)

式中: (x,y)为影像的像素位置;σ为尺度空间因子;G(x,y,σ)为高斯函数;I(x,y)为影像函数;L(x,y,σ)为尺度空间函数; * 为卷积运算符。

SIFT算子的匹配操作流程如图2所示。

图2 SIFT算子匹配操作流程

首先获取图像的尺度空间,在该空间进行极值检测,初步确定特征点的位置与尺度; 然后利用特征点邻域像素的梯度大小与方向确定该特征点的方向; 由上一步中得到的特征点邻域像素的梯度信息计算128维的特征向量; 完成特征向量计算后进行匹配,逐一比较各个特征点的特征向量,如果满足一定的条件,则确认完成一个点对的匹配。

3CSIFT影像配准

本文采用CSIFT配准算法提取基准影像与待配准影像的匹配点。通过研究发现,SIFT算子具有尺度、旋转、仿射、视角和光照的不变性,对目标的运动、遮挡、噪声等因素也有较好的匹配性,可用于提取稳定的多个匹配点对。但在实际运算时,SIFT算子需要处理大量的数据,无法实现UAV影像的实时快速匹配与拼接[7]; 而且在应用SIFT算法时需要先将彩色影像转换为灰度影像,不利于对UAV影像的直接处理; 所以,本文采用CSIFT算法提取特征点[8]。通过实验还发现,SIFT算子因计算量很大,容易产生错误匹配点对; 若结合重叠区域范围分别对提取出的特征点进行约束,则可剔除部分一定不会匹配成功的特征点,不仅能为下一步的匹配工作减少计算时间,而且能提高计算结果的准确率。因此,本文采用结合CSIFT算子与重叠区域范围约束的方法来提取匹配点对。

3.1匹配点对提取

3.1.1颜色不变量计算

物体的光谱辐射模型为

E(λ,x)=i(λ,x)R∞(λ,x) ,

(3)

式中:λ为波长; x为二维矢量,表示观测位置;i(λ,x)为在各波长上保持不变而随位置变化的光谱强度;R∞(λ,x)为材料反射率。

颜色不变量C表示物体的反射特性,与视点、表面方位、光照方向和光照强度无关,即

(4)

式中: Eλ为E(λ,x)相对于λ的一阶偏导数;Eλλ为E(λ,x)相对于λ的二阶偏导数。

采用高斯颜色模型作为表示光谱信息和局部影像结构的一般模型,用于计算RGB彩色空间的不变量。计算光谱分量时,可近似于人类视觉系统的CIE1964XYZ,通过RGB→XYZ和XYZ→高斯颜色模型的2次线性变换,得到用RGB表示的高斯颜色模型[9],即

(5)

3.1.2关键特征点提取

Lowe等于[10-11]1999年提出SIFT配准算法,并在 2004年进行了完善和总结。CSIFT算法在SIFT算法的基础上,利用颜色不变量代替原来的影像信息[8]; 其主要任务是进行尺度空间极值点检测,初步确定关键特征点的位置和所在尺度。1景影像的尺度空间可被定义为L(x,y,σ)函数,为尺度变化的高斯函数G(x,y,σ)与影像颜色不变量C(x,y)的卷积,即

L(x,y,σ)=G(x,y,σ)*C(x,y) ,

(6)

(7)

式中: (x,y)为影像的像素位置;σ为尺度空间因子; *为卷积运算符。

在影像平面空间和高斯差分(difference-of-Gaussian,DOG)尺度空间中检测局部极值点作为关键特征点。DOG算子定义为2个相邻尺度的高斯核的差分D(x,y,σ),即

D(x,y,σ)=[G(x,y,kσ)-G(x,y,σ)]*C(x,y)=L(x,y,kσ)-L(x,y,σ) ,

(8)

式中:k为差分运算中的固定系数;C(x,y)为影像颜色不变量函数。

当某点在DOG尺度空间本层及其上下2层中是最大值或最小值时,就认为该点为影像在该尺度下的一个关键特征点。从式(1)(2)(6)和(7)可以看出,CSIFT算法利用影像颜色不变量函数C(x,y)代替了SIFT算法中的影像函数I(x,y)。因此,DOG算子(式(8))中用C(x,y)代替了I(x,y)。

3.1.3关键特征点约束

利用CSIFT提取关键特征点是针对整景影像来实现的。从UAV影像匹配的角度考虑,其中有很多是势必无法匹配成功的关键点。因此,在匹配之前要对这些关键点进行正确率约束,以便节省匹配处理的时间,提高匹配结果的准确率。CSIFT算法是基于SIFT算法改进的,而SIFT算法在运算过程中记录了全部关键点坐标,故本文采用基于UAV的POS数据确定影像重叠区域的约束方法进行关键特征点约束。

假设POS数据中基准影像的中心地理平面坐标为(x01,y01),待匹配影像的坐标为(x02,y02),结合飞行航高h与镜头焦距f可以计算出2景影像中心的坐标偏移量,即

Sx=(x02-x01)f/h, Sy=(y02-y01)f/h 。

(9)

因为2景影像的像素大小a×b与影像尺寸p保持一致,设基准影像的中心点为坐标原点,X方向为飞行方向,Y方向为垂直飞行的方向,按照4个象限依次排列,沿着UAV飞行方向,基准影像中重叠区域的4个角点的像素坐标为

待匹配影像中重叠区域的4个角点的像素坐标为

3.1.4关键特征点匹配

提取出关键特征点后,要计算各关键点的梯度向量并进行匹配。

1)精确确定关键点梯度方向分布特征,为每个关键点指定方向参数,使算子具备旋转不变性。关键点(x,y)处的梯度模值m(x,y)和方向θ(x,y)为

(10)

θ(x,y)=arctan{[L(x, y+1)-L(x, y-1)]/[L(x+1, y)-L(x-1, y)]} 。

(11)

2)生成关键点的特征向量。将坐标轴旋转为关键点的方向,保证旋转不变性; 然后以关键点为中心取8×8的窗口, 利用式(10)和(11)计算每个4像素×4像素小块影像中8个方向的梯度方向直方图,用每个梯度方向的累加值形成一个种子点。为了增强匹配的稳健性,对每个关键点使用4像素×4像素共16个种子点来描述,这样对于一个关键点就可以产生128个数据(即128维的CSIFT特征向量)。

3)生成2景影像关键点的特征向量后,进行关键特征点匹配。采用特征向量的欧式距离作为2景影像中关键点的相似性判定准则,当此距离小于某阈值时则认定得到满足准则的匹配点对。

3.2匹配点对稳健估计

3.2.1误差点对剔除

(12)

(13)

利用式(12)和(13),带入10对以上的匹配点坐标,采取最小二乘原理方法求解; 设定阈值,剔除不满足提取点误差高斯分布规则的匹配点。评价精度的指标Sn为H的平均几何匹配误差,即

(14)

式中D为匹配点对之间的像素距离。

3.2.2匹配点对提纯

利用RANSAC检验算法对经过初步剔除误差的匹配点对进行提纯。其基本思想是进行参数估计时,首先针对具体问题设计出一个目标函数; 然后迭代估计该函数的参考值,利用这些初始值把全部数据分为内点(满足估计参数的点)和外点(不满足估计参数的点)2部分; 最后反过来用内点重新计算和估计该函数的参数[13]。上述方法可以最大限度地减少噪声与外点的影响,进一步得到精确的匹配点。

1)计算n对匹配点对的RMSE,即

(15)

(16)

2)以1个像素尺寸的大小为阈值,若RMSE大于阈值,则删除(△xi,△yi)最大的匹配点对; 然后反复迭代直至RMSE小于阈值,最终获得m对特征匹配点。

4坐标系统映射变换

目前常用的空间变换模型主要有平移变换、刚性变换、仿射变换以及投影变换等[14]。用矩阵的形式描述上述关系模型(8参数模型)[15]为

(17)

式中:m2为水平方向位移;m5为垂直方向位移;m0,m1,m3和m4分别表示尺度和旋转量;m6与m7分别表示水平与垂直方向的变形量; (x′,y′)为变换后的点位坐标; (x,y)为变换前的点位坐标; M为8参数模型矩阵。

根据各参数的意义及不同变换模型的特点对矩阵M作相应简化,即可得到各变换模型的参数矩阵。本文针对UAV影像,设定UAV平台获取影像数据时没有明显的航高变化(即只考虑待匹配影像的平移和旋转),则有

(18)

式中: (△x,△y)为平移参数;θ为旋转角。采用最小二乘方法求得参数

(ATA)Θ=ATB ,

(19)

其中

(20)

5实验结果与分析

5.1实验数据

本次实验采用拍摄于四川省什邡市的UAV影像(图3)及其POS数据(表1)。

图3 什邡市UAV影像

参数基准影像待匹配影像纬度/(°)31.112831.1139经度/(°)104.2024104.2014高度/m1555.701554.80滚动/(°)0.08-0.14俯仰/(°)0.070.03偏航/(°)320.05319.82

影像采集相机为Canon EOS 5D Mark II; 飞行高度1 636 m,飞行覆盖范围25 km2; 影像大小为5 616像素×3 744像素,影像的地面分辨率达到cm级。此次仿真实验基于Matlab语言实现。

5.2实验过程与结果分析

对经过预处理的实验数据,利用式(1)—(8),分别采用CSIFT和SIFT算子处理,得到2种情况下基准影像与待匹配影像的关键特征点(图4和图5)。

(a) 基准影像 (b) 待匹配影像

图4关键特征点CSIFT提取结果

Fig.4Result of CSIFT key points extracted by CSIFT

(a) 基准影像 (b) 待匹配影像

图5关键特征点SIFT提取结果

Fig.5Result of key points extracted by SIFT

从图4和图5可以看出,用CSIFT算法计算出的2景影像的关键特征点分布密度比用SIFT算法计算出的关键特征点密度高。

根据式(9)分别计算出基准影像中重叠区域的4个角点的像素坐标: (1 683,2 246),(-926,2 246),(-926,-2 246)和(1 683,-2 246)以及待匹配影像中重叠区域的4个角点的像素坐标: (926,2 246),(-1 683,2 246),(1 683,-2 246)和(926,-2 246),通过约束得到关键点提取结果(图6)。

(a) 基准影像 (b) 待匹配影像

图6CSIFT提取关键点重叠区约束后结果

Fig.6Restrained result of key points extracted by

CSIFT in overlay area

从图6可以看出,经过重叠区范围的约束后,关键点数量有所减少。经过计算,基准影像的关键点个数减少为715,待匹配影像的关键点个数减少为907。

然后利用式(10)和(11)进一步计算2景影像中各点的梯度向量并进行匹配。利用式(12)—(16)进行匹配点对的稳健估计计算后,最终关键点匹配结果为191对(图7)。

图7 CSIFT算子关键点匹配结果

通过匹配点对按式(17)—(20)进行计算,确定基准影像与待匹配影像之间的映射关系,最终得到匹配融合影像(图8)。

图8 CSIFT算法影像匹配结果

与图8相比,在经过特征点提取与匹配后, SIFT算法在大量的特征点基础上生成了大量的匹配点对,同时也存在着大量的误匹配点对(图9)。

图9 SIFT算子关键点匹配结果

然后直接进行误差点对剔除,并融合生成结果影像(图10)。

图10 SIFT算法影像匹配结果

采用SIFT与CSIFT算法,针对2景相同的UAV影像进行对比,详细内容如表2所示。

表2 SIFT 与 CSIFT算法比较

上述的2景影像匹配拼接的实验证明,本文提出的CSIFT方法比传统的SIFT方法在精度提高的基础上,运算效率也大大提高。图11示出采用CSIFT方法拼接的8景UAV影像的匹配和拼接结果,整个处理过程耗时202 s。从图11可以看出,CSIFT方法在进行多景无人机影像拼接时的结果很好(比如道路和规则形状地物的拼接处看不出拼接缝)。可见采用本文提出的方法可以大大提高UAV影像的匹配准确率并减少匹配过程耗用时间。

图11 CSIFT方法多景影像匹配拼接结果

6结论

本文利用CSIFT算法对无人机(UAV)影像的基准影像与待匹配影像分别进行特征点的提取来完成影像的配准镶嵌,并且通过仿真实验证明了方法的有效性,保证了结果的鲁棒性。得出如下结论:

1)本文方法的前提是UAV影像空间位置具有相对良好的空间姿态,以便在特征点匹配前对提取结果进行区域约束,快速选定重叠工作区域。

2)误差点剔除准则的选择会引起运算量增加,在一定程度上影响程序的运行效率,特别是在阈值的选择中,需要结合实时的影像质量选定初值。

3)本文的处理过程仅针对数字图像,结合相应的算法改进,为UAV影像的快速拼接提供了一种思路,但并未考虑实际地形对UAV影像的影响(特别是在实现正射成图方面)。

参考文献(References):

[1]张永军.无人驾驶飞艇低空遥感影像的几何处理[J].武汉大学学报:信息科学版,2009,34(3):284-288.

Zhang Y J.Geometric processing of low altitude remote sensing images captured by unmanned airship[J].Geomatics and Information Science of Wuhan University,2009,34(3):284-288.

[2]苏俊英.SIFT特征匹配无人飞艇多光谱影像拼接[J].应用科学学报,2010,28(6):616-620.

Su J Y.Mosaicing of multiple spectrum images acquired from unmanned airship with SIFT feature matching[J].Journal of Applied Sciences,2010,28(6):616-620.

[3]狄颖辰,陈云坪,陈莹莹,等.无人机影像拼接算法综述[J].计算机应用,2011,31(1):170-174.

Di Y C,Chen Y P,Chen Y Y,et al.Survey on image mosaic algorithm of unmanned aerial vehicle[J].Journal of Computer Applications,2011,31(1):170-174.

[4]王斌,王伟锋.一种基于局部灰度匹配的无人机图像拼接算法[J].中国石油大学学报:自然科学版,2009,33(2):169-173.

Wang B,Wang W F.Unmanned aerial vehicle image mosaic algorithm based on local gray fitting[J].Journal of China University of Petroleum:Edition of Natural Science,2009,33(2):169-173.

[5]白廷柱,侯喜报.基于SIFT算子的图像匹配算法研究[J].北京理工大学学报,2013,33(6):622-627.

Bai T Z,Hou X B.An improved image matching algorithm based on SIFT[J].Transactions of Beijing Institute of Technology,2013,33(6):622-627.

[6]唐敏,李永树,鲁恒.无人机影像的同名点匹配[J].光电工程,2012,39(3):19-24.

Tang M,Li Y S,Lu H.Correspondence points matching of UAV images[J].Opto-Electronic Engineering,2012,39(3):19-24.

[7]刘立,彭复员,赵坤,等.采用简化SIFT算法实现快速图像匹配[J].红外与激光工程,2008,37(1):181-184.

Liu L,Peng F Y,Zhao K,et al.Simplified SIFT algorithm for fast image matching[J].Infrared and Laser Engineering,2008,37(1):181-184.

[8]吴寅初,马戎.基于彩色信息的尺度不变特征变换图像特征点提取与匹配[J].计算机应用,2011,31(4):1024-1026.

Wu Y C,Ma R.Image feature extraction and matching of color-based scale-invariant feature transform[J].Journal of Computer Applications,2011,31(4):1024-1026.

[9]Geusebroek J M,van den Boomgaard R,Smeulders A W M,et al.Color invariance[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2001,23(12):1338-1350.

[10]Brown M,Lowe D G.Invariant features from interest point groups[C]//Proceedings of the British Machine Vision Conference.Cardiff,UK:[s.n.],2002:656-665.

[11]Lowe D G.Distinctive image features from scale-invariant keypoints[J].International Journal of Computer Vision,2004,60(2):91-110.

[12]王金泉,李钦富.基于单应性矩阵的SAR图像配准技术研究[J].中国电子科学研究院学报,2009,3(6):657-660.

Wang J Q,Li Q F.Research on SAR image registration based on homograph matrix[J].Journal of CAEIT,2009,3(6):657-660.

[13]Fischler M A,Bolles R C.Random sample consensus:A paradigm for model fitting with applications to image analysis and automated cartography[J].Communications of the ACM,1981,24(6):381-395.

[14]Szeliski R.Video mosaics for virtual environments[J].IEEE Computer Graphics and Applications,1996,16(2):22-30.

[15]王娟,师军,吴宪祥.图像拼接技术综述[J].计算机应用研究,2008,25(7):1940-1943.

Wang J,Shi J,Wu X X.Survey of image mosaics techniques[J].Application Research of Computers,2008,25(7):1940-1943.

(责任编辑: 刘心季)

UAV image matching based on CSIFT feature

GENG Juan1, HE Chenglong2, LIU Xianxin2

(1.JointRemoteSensingResearchCentreforRailTransitProject,SouthwestJiaotongUniversity,Chengdu610031,China;2.FacultyofEarthandEngineering,SouthwestJiaotongUniversity,Chengdu610031,China)

Abstract:With the development of the unmanned aerial vehicle(UAV)technique, currently UAV data have been gradually used in application and research fields. Differing from the current UAV matching method that integrates Photogrammetry and Image control points, the novel method presented in this paper is based on the color scale-invariant feature transform (CSIFT) feature to collect the key match points in the reference image and the image to be matched, followed by using the random sample consensus algorithm (RANSAC)method to extract the match points for the final matching result. The authors use an example to verify the feasibility and the validity of the method. Compared with the SIFT method, the accuracy could be increased from 70% to 88%, and the algorithm proposed in this paper can not only guarantee the matching result but also produce less matching points and use less working time.

Keywords:UAV image; CSIFT feature; feature matching point; homography matrix; random sample consensus(RANSAC)

作者简介:第一 耿娟(1985-),女,硕士,主要从事摄影测量与遥感应用方面的研究。Email: gengjuan8519@gmail.com。

中图法分类号:TP 751.1

文献标志码:A

文章编号:1001-070X(2016)01-0093-08

基金项目:国家重点基础项目(973项目)“高分辨率遥感影像的信息度量与质量改善”(编号: 2012CB719901)、国家高技术研究发展计划(863计划)项目“多尺度遥感数据按需快速处理与定量遥感产品生成关键技术”(编号: 2012AA12A304)和国家自然科学基金项目“地震灾区基于遥感信息的交通设施损毁快速评估”(编号: 50848053) 共同资助。

收稿日期:2014-09-15;

修订日期:2014-11-29

doi:10.6046/gtzyyg.2016.01.14

引用格式: 耿娟,何成龙,刘宪鑫.基于CSIFT特性的无人机影像匹配[J].国土资源遥感,2016,28(1):93-100.(Geng J,He C L,Liu X X.UAV image matching based on CSIFT feature[J].Remote Sensing for Land and Resources,2016,28(1):93-100.)