西红柿采摘机器人视觉系统的研究

郭凯敏,崔天时,张 桢,郭志强,朱铁欣,谢学刚

(东北农业大学,哈尔滨 150030)

西红柿采摘机器人视觉系统的研究

郭凯敏,崔天时,张桢,郭志强,朱铁欣,谢学刚

(东北农业大学,哈尔滨150030)

摘要:针对果实采摘机器人果实识别率低的问题,设计了一组用于西红柿识别和定位的双目立体视觉系统,为机器人的采摘作业提供更有利的条件。为此,采用Bumblebee双目立体视觉系统,基于成熟果实与植株颜色特征的差异进行图像分割,来识别成熟的西红柿;在完成相机标定、特征点提取和特征点匹配的基础上,通过三维空间定位获取果实的三维坐标。实验结果表明:该系统果实识别的整个过程平均耗时150ms,对成熟西红柿的识别率达到99%,测试误差在10mm以内,能够较好地满足西红柿采摘工作的要求。

关键词:农业机器人;双目立体视觉;相机标定;特征点提取;特征点匹配;三维重建;定位

0引言

机器视觉系统是采摘机器人实现准确采摘的首要条件,研究具有视觉功能的果实采摘机器人,在提高农业生产力方面具有极大的应用价值和现实意义。在机器人视觉的研究方面,国内外都有很多的研究成果;但受到计算机视觉理论、相机标定方法及图像处理的算法等方面的限制,机器视觉在农业方面的应用还有很大局限,距离现实应用还有很大差距。由于农田实际作业环境的复杂多变,导致果实的识别率和采摘成功率也不是十分理想。

为此,采用Bumblebee双目立体视觉系统,通过对成熟西红柿与周围环境颜色特征的分布进行统计与分析,确定适用于成熟西红柿目标分割的颜色因子;选取适合的颜色因子对成熟西红柿识别,确定有效的采摘点,计算果实的空间定位。

1识别与定位系统建立

1.1 工作原理

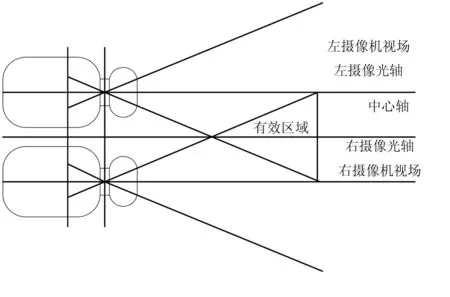

双目立体视觉的物体定位原理是基于视差,也就是从两个视点对同一物体进行观察,获取不同的感知图像,建立几何模型;然后通过几何模型的关系运算,获取图像像素间的坐标偏差,从而得到物体的三维坐标。这个过程与人类的立体感知过程相似。研究采用的Bumblebee视觉系统符合平行式立体视觉模型,如图1 所示。

图1 平行式立体视觉模型

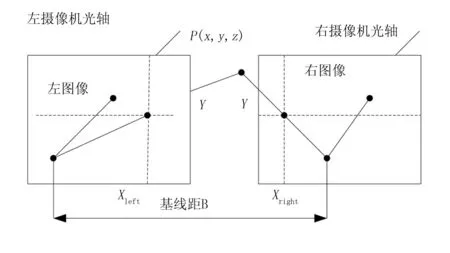

该系统由两台光轴平行并且垂直于基线的CCD摄像头right和left组成,焦距均为f,构建以左目坐标为基准的三维坐标系,如图2所示。

图2 双目立体定位原理

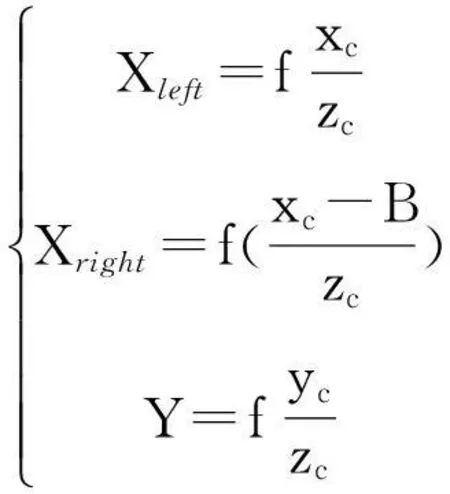

基线距B为两摄像头的投影中心连线的距离,假如两摄像头在同时看到空间物体的同一个标志点P(xc,yc,zc),分别在左右两个摄像头上获取了点P的图像,图像坐标分别为Pleft=(Xleft,Yleft)和Pright=(Xright,Yright)。假如两摄像头获取的图像处在同一个水平面上,则标志点P的图像坐标Y相同,也就是Yleft=Yright=Y。因此,可以通过三角关系变换得

(1)

视差的计算公式为

Disparity=Xleft-Xright

(2)

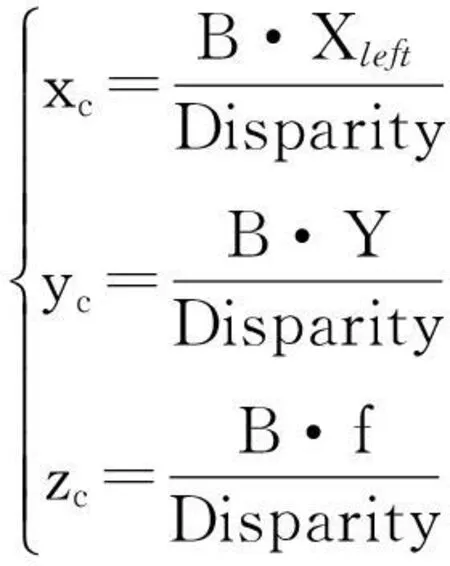

因此,标志点P在以左相机为基准点的坐标系下的三维空间坐标的计算式为

(3)

由此可知:左摄像头像面上的一点只要能在右摄像头像面上找到对应点(即匹配点),就可以计算出该点的空间坐标。然而,这种方法是针对点对点的运算,如果要运用到实际环境中,还需要进行更复杂的处理变换。

1.2 软硬件结构

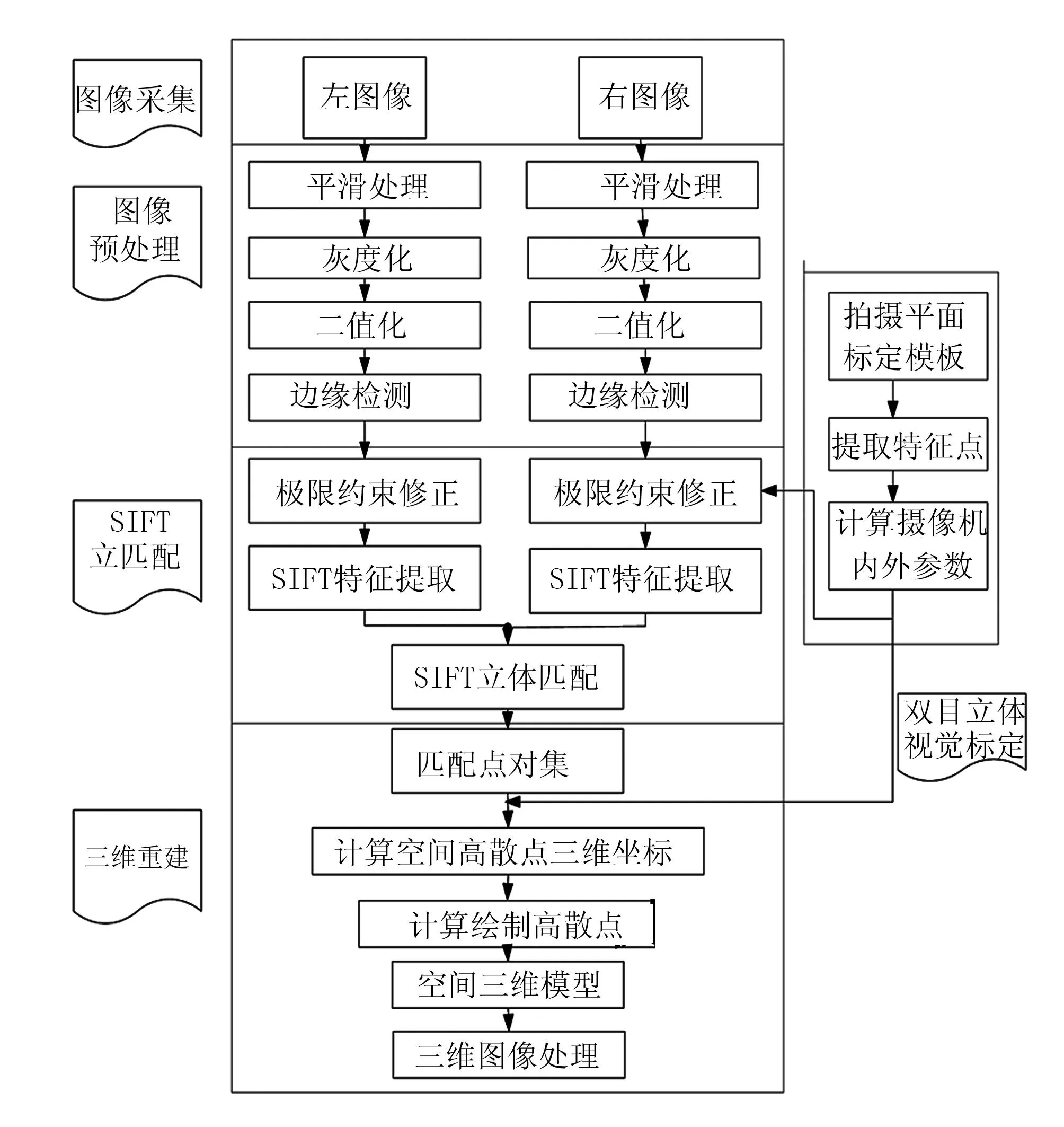

采用VC++6.0编程软件,设计西红柿采摘机器人的操作界面,包括图像采集、图像预处理、摄像头标定、特征点提取与匹配及三维重建等5部分。计算机视觉的首要条件是获取数字图像。为获取数字图像,在机器人视觉中,常用的设备是CCD摄像头和视频采集卡。本文采用的双目立体视觉系统是由Sony公司生产的彩色CCD双目摄像机、PC机和1394视频采集卡组成的系统,连接方式如图3所示。

图3 双目立体视觉系统

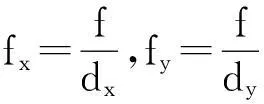

立体摄像机参数为:CCD的尺寸:l/3inch(即CCD对角线的长度,为6mm);摄像机大小为160×40×50mm;两摄像机的基线距B为12cm;采集图像的像素为640×480;帧率为30Hz;焦距为6mm。其工作流程如图4所示。

图4 系统工作流程图

1.3 摄像头标定

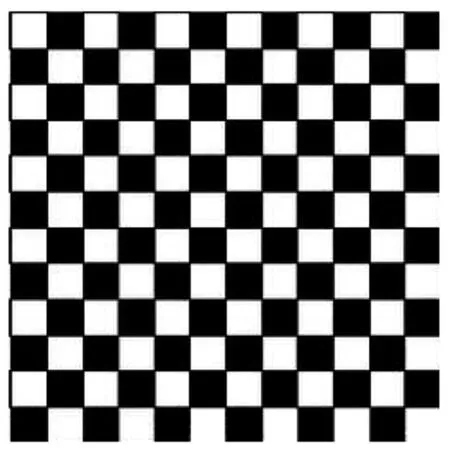

摄像头的标定是为了获取摄像头的内外参数,以实现对目标的准确定位,计算出目标在实际空间中的位置信息。这需要建立识别后的左右匹配的特征点的三维坐标与图像坐标之间的几何关系。这个几何关系由摄像头内外参数决定,也就是由摄像头成像的几何模型决定,获取内外参数的过程就是摄像头的标定。采用张正友棋盘标定法,如图5所示。

图5 张正友棋盘标定模板

此方法标定模板与传统标定和自标定方法相比具有设备简单、操作方便、精度高及鲁棒性好等优点。

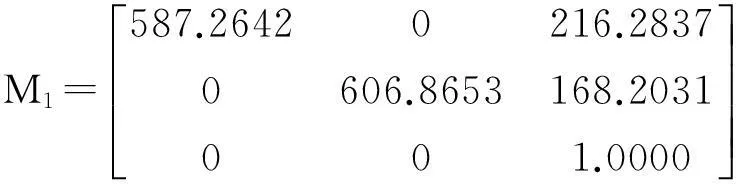

用此法获取的内外参数矩阵为

其径向畸变系数k1=-0.7321,k2=0.7562。

2识别与定位

2.1 图像采集

Bumblebee双目摄像头通过1394视频采集卡与PC机相连的设备采集到的是数字图像,CCD摄像机和视频采集卡在PC机的控制下完成图像的输入及数字化工作。CCD摄像机先将局部视场内的光学图像信号转换成相应的电信号,该电信号带有图像空间信息,再与同步信号整合成完整的视频信号,通过同轴电缆传输给图像采集卡;视频信号经过图像采集卡上的A/D转换器转换成图像数据,存放在帧存储器,以供计算机进行其他处理操作。

2.2 图像预处理

在机器人视觉理论框架中,第1步就是对二维图像预处理。其目的是使目标图像与背景图像分离,突出目标图像的视觉效果,将图像转化为一种更适合机器分析处理的形式。

目标图像的边缘是图像特征的一个重要部分,包含原始图像中的很多有用的信息,往往通过一条简单的轮廓线就能把物体识别出来。因此,图像的边缘轮廓特征提取在机器人视觉中占有很重要的地位。双目视觉图像预处理方法主要涉及到图像预处理、图像分割、边缘检测和特征提取等。

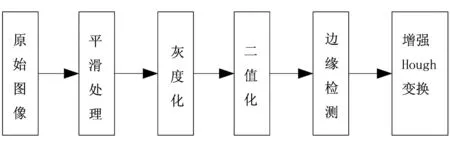

因此,采用了增强型的Hough变换的特征提取方法,预处理过程如图6所示。

图6 图像预处理过程

2.2.1平滑处理

采用中值滤波的方法对原始图像进行平滑处理,目的是为了消除图像中存在的噪声干扰,尽可能地提高图像质量。中值滤波是一种非线性处理技术,主要作用是让与周围像素灰度值差较大的像素修改为与周围像素值接近的值,从而消除孤立的噪声点,有效地抑制图像中的噪声。

2.2.2灰度化

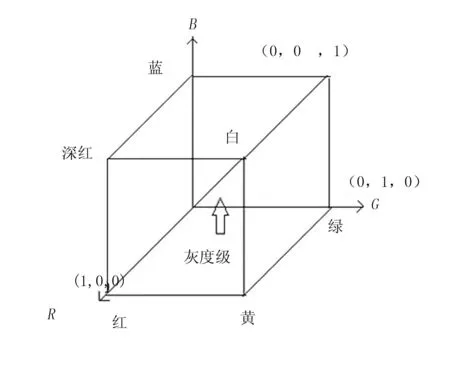

RGB的颜色标准,分别代表红、绿、蓝3个通道的颜色,也称为三基色,其他颜色由这3种颜色混合而成,是目前运用最广泛的颜色系统之一。

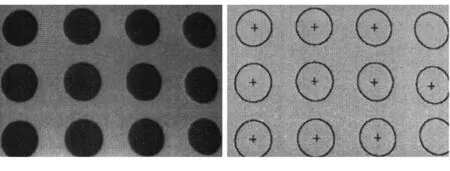

RGB颜色模型中,原点(0,0,0)对应黑色,顶点(1,1,1)对应白色,在坐标轴上的3个顶点表示RGB三基色,如图7所示。规定R、G、B取值的区间均为[0,255],当三色都为255时为白色,都为0时为黑色,三色数值相同时为无色彩的灰度色,白色与黑色的连线即表示灰度级。

用g(i,j)表示点(i,j)处的灰度值,R(i,j)、G(i,j)、B(i,j)分别表示该点的三基色色值。

图7 RGB颜色模型

灰度化的公式为

g(i,j)=0.299R(i,j)+0.587G(i,j)+

0.114(i,j)+0.5

2.2.3二值化

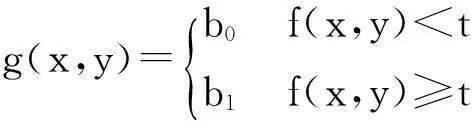

很多情况下,进行图像分析、特征提取和模式识别前,要对图像进行预处理,目的是为了分离目标和背景在不同灰度等级范围的图像。采用图像阈值分割法,可以极大地压缩数据,简化分析和处理的步骤,是一种最常用、最简单的图像分割方法。

图像阈值化的方法是对图像按照灰度级,对像素集合进行区域划分,每个区域对应图像上一个现实景物,各个区域内部具有属性一致性,而且相邻区域同样有这种属性一致性。

阈值化分割法是设定合适的阈值,将图像像素点进行区域区分。设原始图像为f(x,y),以一定的准则在f(x,y)中找出合适灰度值,作为阈值t,对图像进行分割,获取的图像g(x,y)为

若取b0=0(黑)、b1=1(白),即为图像二值化。

2.2.4边缘检测

通过图像像素和空域微分算子的卷积可以完成边缘的检测,采用的算子为Canny算子。与传统的算子相比,该算子检测出的边缘与实际边缘距离误差最小,效果好。

Canny算子的基本思路是先对需处理的图像进行平滑处理,对此选择Gauss滤波器,之后采用“非极值抑制”的处理,就可以得到所需的边缘图像。

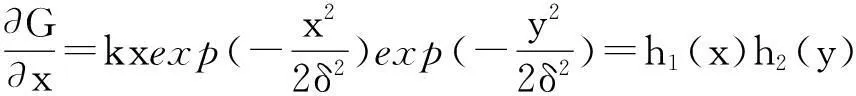

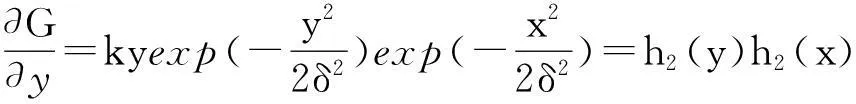

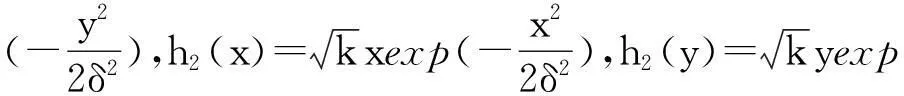

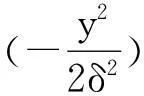

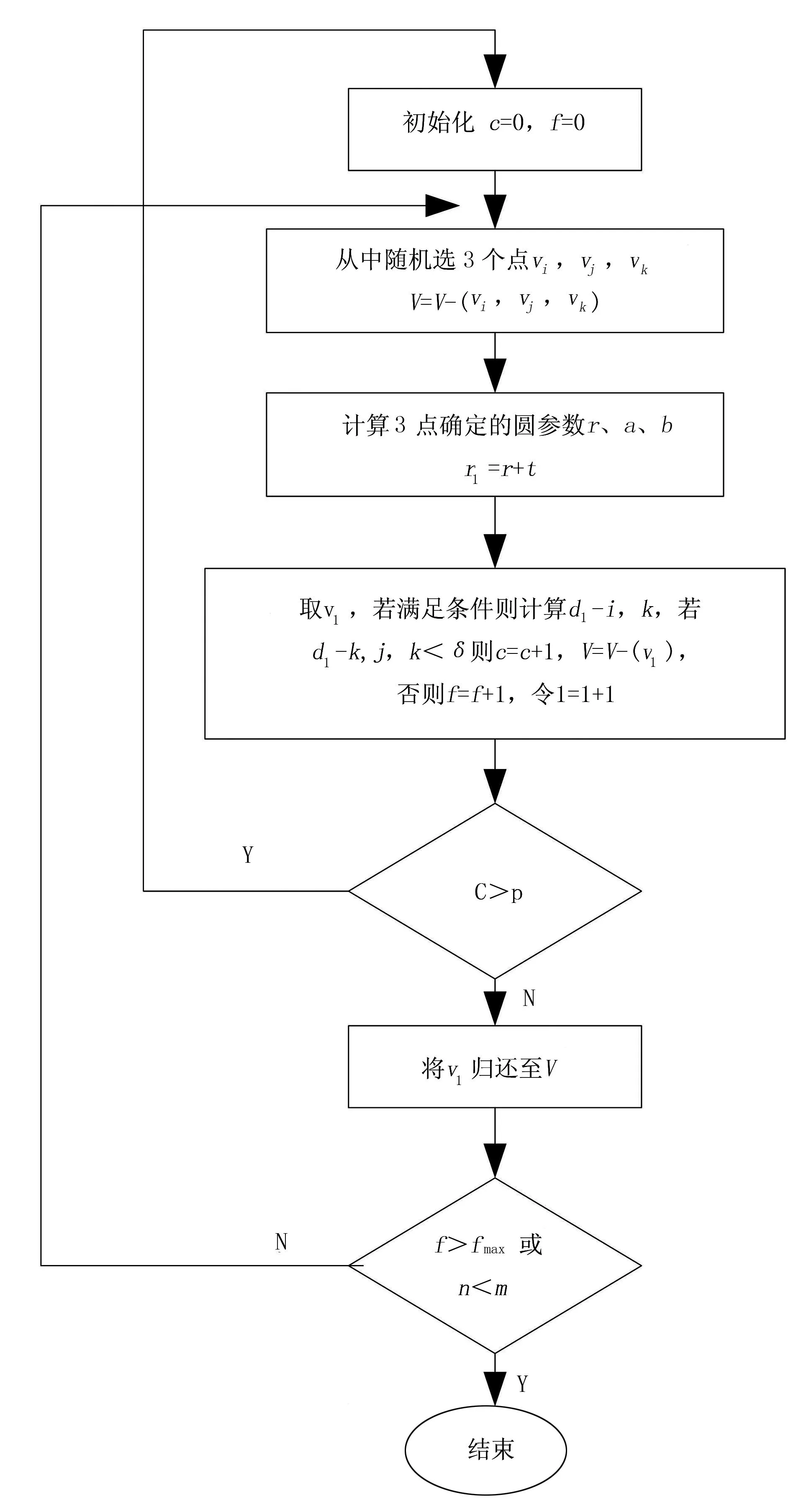

在运用Canny算子进行边缘检测时,通常需要对高斯函数进行分解处理,可以把二维的高斯函数分解为两个行列滤波器,从而提高运算速度。假设高斯函数为

(4)

分别求在x方向和y方向的导数为

(5)

(6)

将式(5)、式(6)与图像f(x,y)卷积,输出为

(7)

(8)

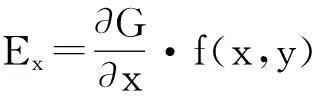

2.2.5增强型的Hough变换的特征提取

Circle Hough Transform(CHT)是特征提取常用的一种经典方法,可利用三维空间参数提取圆。这种方法灵活简单,具有很强的抗干扰能力;但同时也有缺点,如计算量大及对存储空间要求较高等。另外,在处理复杂图像信息时,通常会引入一些无用的累计计算,降低了算法性能。因此,提出一种增强型的Hough变换算法,算法原理如图8所示。

图8 增强型Hough变换流程图

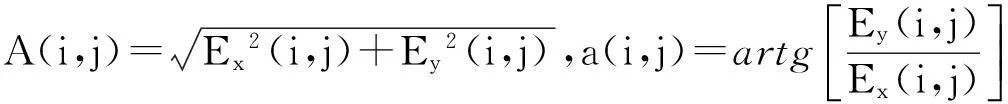

其中,vi=(xi,yi)为存储至集合V中的边缘点,计数器为记为c,失败的次数设为f,集合中元素最少个数为m,边缘厚度设为t,真实圆的阈值为p、n在V中的个数。提取圆心结果如图9所示。

图9 摄像机提取圆心结果

2.3 特征点提取与立体匹配

在图像特征点匹配的确定方面,利用SIFT(Scale Invariant Feature Transform)算子进行图像特征点匹配具有很高的可靠性,该算子提取的特征点同时具有很强的稳定性。

可以通过高斯差分算子建立尺度空间,假如二维高斯函数定义为

(9)

其中,δ代表了高斯正态分布的方差。而尺度空间的定义为

L(x,y,δ)=G(x,y,δ)·I(x,y)

(10)

两个不同尺度的高斯核的差分DoG可以定义为

D(x,y,δ)=D[(x,y,kδ)-G(x,y,δ)]·I(x,y)

=L(x,y,δ)-L(x,y,δ)

应用SIFT算子进行特征点提取,需在DoG尺度空间和图像二维平面空间中同时检测局部极值作为特征点。特征点确定以后,要使其旋转不变形,就要计算其领域像素的梯度方向分布特性,并且为每个特征点指定方向参数。

特征点提取以后,取一个8×8的窗口,以特征点像素中心,对窗口中求每个像素的梯度。然而,梯度值又易引起特征点间的误匹配的现象,需重新将该窗口分成4部分,每个部分就有1个4×4的小窗口生成,每个窗口确定一个2×2的种子点,每个种子点有8个方向向量信息。这个种子点作为特征点标识符,如果两个特征点标识符小于设定数值,那么这两个特征就相互匹配。

确定两个匹配点后,可以利用两个匹配点的像素坐标,由式(3)计算出该物体的空间坐标。

3实验研究

采用符合平行双目立体视觉模型的双目视觉系统,进行成熟西红柿空间位置的计算。针对实验室单个西红柿的环境,该视觉软件系统采用VC++6.0编程,采用面向对象的语言C++进行程序设计的方法。

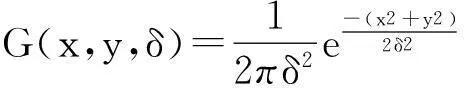

确定两个匹配点后,可以利用两个匹配点的像素坐标,由式(3)计算出该物体的空间坐标。软件界面如图10所示。

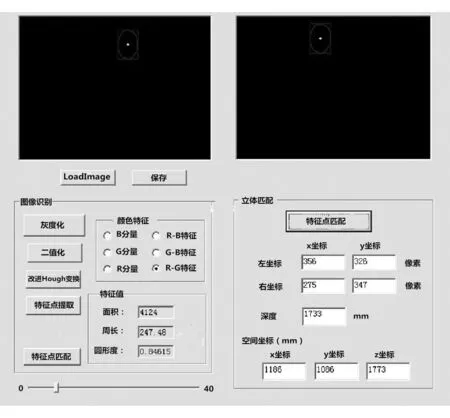

由双目视觉系统测得的数据和激光传感器测距获得的数据相比较获得误差,如表1所示。

图10 软件界面

序号左匹配点右匹配点三维坐标距离误差/%1(265,250)(234,248)(-106,98,1256)2.202(290,250)(259,250)(120,82,1249)2.253(200,200)(170,197)(-83,79,1246)2.30

4结论

利用Bumblebee双目立体视觉系统,分析了成熟西红柿的颜色特征模型,提出一种增强的Hough变换,可有效地分割西红柿与背景。对识别后的果实进行定位,识别率可达到99%。同时,建立了一种目标定位误差分析机制,可有效地对系统定位的准确性进行判断。

参考文献:

[1]周天娟.基于机器视觉的草莓采摘机器人技术研究[D].北京:中国农业大学,2007.

[2]周俊,程嘉煜.基于机器视觉的农业机器人运动障碍目标检测[J].农业机械学报,2011,42(8):154-158.

[3]韩云生.基于双目立体视觉的移动机器人目标定位[D].无锡:江南大学,2009.

[4]张凯良,杨丽,张铁中.草莓采摘位置机器视觉与激光辅助定位方法[J].农业机械学报,2010,41(4):151- 156.

[5]Naoshi Kondo, Koki Yata, Michihisa Iida, et al. Development of an end-effector for a tomato cluster harvesting robot [J].Engineering in Agriculture,Environment and Food, 2010,3(1):20-24.

[6]兰海滨,王平,赵保军.基于色调空间的彩色图像匹配算法[J].计算机应用研究,2009(3):1174-1176.

[7]Xiong J,Zou X, Zou H, et al. Design and research of camera calibration system in binocular stereo vision[J].Key Engineering Materials,2011,460-461:219-224.

[8]Milan Sonka, Vaclav Hlavac, Roger Boyler.图像处理、分析与机器视觉[M].艾海舟,译.北京:清华大学出版社,2011.

Abstract ID:1003-188X(2016)12-0217-EA

Research on Tomato-harvesting Robot Visual System

Guo Kaimin, Cui Tianshi, Zhang Zhen, Guo Zhiqiang, Zhu Tiexin, Xie Xuegang

(Northeast Agricultural University, Harbin 150030, China)

Abstract:Aimed at the problem of low recognition rate of fruit picking robots,design a set of binocular stereo vision system is used to identify and locate tomato,provide more favorable conditions of picking robot operation.The Bumblebee binocular stereo vision system,the identification of visual system is developed through the difference between the color characteristics of ripe tomatoes and plant. after camera calibration, feature point extraction and feature points matching,the space coordinates is obtained through 3D reconstruction.The experiment results show that the identification rate of the vision system can reach 99%,and identification average time is about 0.15s,the absolute error of distance-measuring can be controlled within 10mm.It can meet the needs of practical work very well.

Key words:agricultural robot; binocular stereo vision; camera calibration; feature point extraction; feature points matching; 3dreconstruction; location

中图分类号:S225.92;TP242

文献标识码:A

文章编号:1003-188X(2016)12-0217-05

作者简介:郭凯敏(1988-),男,河南周口人,硕士研究生,(E-mail)1035436878@qq.com。通讯作者:崔天时(1967-),男,哈尔滨人,副教授,硕士生导师,博士。

基金项目:国家“863计划”项目(810028)

收稿日期:2015-11-20