支持RDMA的高速网络对大数据与云计算平台效率的影响

支持RDMA的高速网络对大数据与云计算平台效率的影响

刘通

(迈络思中国分公司,北京 100080)

摘 要大数据逐渐成为电信业实现业务分析与创新无可替代的技术手段。云计算平台在电信行业的实施也成为不可逆转的事实。如何部署高效、高性价比的大数据与云计算平台是行业用户面临的共同挑战。本文中探讨的支持RDMA技术的高性能网络在性能、效率、易管理性、可扩展性等多维度为构建高效大数据与云计算平台提供关键技术支撑。

关键词RDMA;InfiniBand;软件定义;Hadoop;VXLAN

移动互联正在持续取代传统通信模式,更多的数据流量通过日益增加的智能终端、移动设备在3G/4G网络上快速产生,移动互联甚至正在悄悄改变着运营商的业务收入格局。通过对用户行为的准确分析来快速决策出更具价值的移动业务是运营商亟需落实的变革。随着大数据平台在电信业从实验阶段走向实际应用,大数据分析平台的效率成为逐渐凸显的新挑战。

云计算平台正在逐步取代传统数据中心,为企业提供更灵活、更高投资回报率的IT系统。云计算平台承载的应用类型逐渐覆盖整个数据中心的所有业务。应用多样化、用户高密度、数据量不断攀升等特点对云计算平台提出更多的挑战。

究竟什么样的网络是构建高效大数据与云计算的基础,需要从多个方面来考虑。下文将结合技术概念、实测结果、成功案例进行具体探讨。

1 高性能网络核心技术

1.1 高速网络评价标准

谈到网络的性能,通常最直观的技术参数就是网络带宽,网络带宽固然是性能核心指标之一,但是数据中心往往关心的是应用程序实际需要的带宽,以及如何将网络的理论带宽充分发挥出来。所以一个真正的高性能网络不应该仅仅提供理论高带宽值,更重要的是如何让应用程序能够充分利用带宽。评价网络性能的另外一个重要指标就是网络延迟。这一指标也是很多IT人员经常忽略的。影响到数据分析时效性与云计算应用响应时间的关键技术就是网络延迟。网络有效带宽与通信低延迟的实现离不开先进的网络芯片及其对高效网络协议的支持。

1.2 支持RDMA技术的高速网络

处理高速增长的数据,提供实时数据分析,为云用户提供高速平台等都对网络的有效带宽与延迟提出前所未有的需求。如今数据中心中的吉比特以太网正在迅速被10吉比特、40吉比特以太网、InfiniBand网络所取代。其中同为工业标准的InfiniBand网络以最高带宽(100 Gbit/s)与最低延迟(小于0.7μs)一直雄踞高速网络榜首。10吉比特以太网以及40吉比特以太网虽然带宽较10吉比特以太网有数倍提升,但网络延迟却不是很理想。

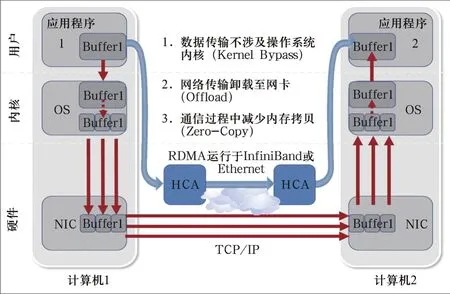

InfiniBand以独特的性能优势被高性能计算领域广泛采用。其中远端内存直接访问技术(RDMA)为InfiniBand带来传统TCP/IP完全无法实现的高速数据传输特性。通过硬件支持RDMA技术才能将应用程序在网络上的性能瓶颈真正消除。TCP/IP由网络层的IP协议和传输层的TCP协议组成。协议采用了4层的层级结构(网络接口层、网络层、传输层、应用层),每一层都呼叫它的下一层所提供的协议来完成自己的需求。如图1所示,应用程序需要传输数据时,需要经过多次缓存拷贝,同时需要内核介入来完成协议处理。因此传统的TCP/IP技术在处理数据传输的过程中需要占用大量的服务器资源,以致于TCP传输效率低下。

RDMA操作使应用可以从一个远程应用的内存中读数据或向这个内存写数据。RDMA操作用于读写操作的远程虚拟内存地址包含在RDMA消息中传送,远程应用程序要做的只是在其本地网卡中注册相应的内存缓冲区。远程节点的CPU在整个RDMA操作中并不提供服务,因此没有带来任何负载。通过类型值(键值)的使用,一个应用程序能够在远程应用程序对它进行随机访问的情况下保护它的内存。

高效的RDMA特性也是如今越来越多的企业应用开始采用InfiniBand网络的原因之一。Oracle、IBM DB2、Microsoft SQL Server、Hadoop、Teradata、SAP等都宣布成功支持InfiniBand RDMA技术。在移动运营商,也有众多采用InfiniBand网络的成功案例。

值得一提的是RDMA不再是InfiniBand独享的技术,最新的以太网也开始纷纷设计支持RDMA通信技术。其中iWARP (Intel为代表)与RoCE (Mellanox为代表)是最为主流的以太网对RDMA技术的实现。iWARP是软件模拟实现RDMA,而RoCE是类似于InfiniBand的硬件支持RDMA技术,其对网卡芯片处理能力有更高要求,也因此RoCE能够提供更高性能。虽然两种技术都尚未达到InfiniBand的性能,但支持RDMA的以太网的确为数据中心提供了传统以太网无法想象的应用性能。

2 电信大数据平台面临的效率挑战

Hadoop依然是当前电信大数据应用平台的主流,其高可扩展性的系统平台由标准X86服务器组成。如今更快的CPU、SSD闪存、更快内存使得每台服务器的处理能力日益增强。加之数据量的爆炸性增长、决策层对数据时效性的要求,IT管理员自然而然的想到网络应该由吉比特以太网提升到10吉比特以太网,从而实现高效平衡系统。毋庸置疑这是网络升级的关键起因之一。然而简单从吉比特以太网升级到10吉比特以太网并不能完全解决大数据系统的效率问题。

图1 TCP/IP 与RDMA的工作原理对比

升级网络的最终目的是要对Hadoop软件平台性能提升发挥不可替代的作用。因此分析Hadoop应用的网络通信瓶颈至关重要。Hadoop模块中设计密集通信的包括MapReduce以及HDFS。MapReduce中的Shuffle环节有大量数据交换在数据节点间产生 (如图2所示)。

Hadoop的HDFS文件系统是所有上层应用的基础,所有数据除了本数据源之外还要通过网络复制2个备份。因此数据写的过程涉及大量网络流量。当然分析时的数据读取也同样涉及网络流量。Hadoop数据分析需要频繁数据读写,HDFS很容易成为性能瓶颈。

为了实现Hadoop性能突破,不能仅仅依靠吉比特以太网到10吉比特以太网的升级,应该同时考虑在Hadoop软件通信层面的革新。

RDMA技术已经被Hadoop软件用来降低网络通信的消耗,其中MapReduce与HDFS都已经有RDMA移植的开源软件插件。只有支持RDMA的网络才能发挥Hadoop通信层的移植带来的好处,实现性能进一步提升。

测试数据显示,支持RDMA技术的10吉比特以太网会为Hadoop性能带来相对于不支持RDMA的10吉比特以太网性能的翻倍提升。

除了Hadoop平台,传统数据库Oracle、内存式数据库SAP Hana、Spark(RDMA版开发中)、MPP数据库等都可以受益于RDMA网络。

3 高性能网络对云计算平台影响

电信行业的云平台具有规模巨大、业务复杂的特点。开放高效的云平台组成技术是未来电信云的发展趋势。SDN无疑是重要因素之一。除了SDN,效率与可扩展性也是云计算环境越来越无法忽视的要素。云计算中的网络效率离不开网络虚拟化。高效网络需具备高效网络虚拟化技术。通过网卡芯片内嵌交换机(eSwitch)与SR-IOV的支持,虚拟网卡的数据流可以绕开Hypervisor从而实现接近于物理网卡的网络性能,同时大幅降低虚拟网络对CPU资源的消耗。

在大型云计算环境中,覆盖型网络VXLAN/NVGRE也是必不可缺的技术,传统VXLAN、NVGRE通过云管理软件实现该项功能,网络性能相较没有使用VXLAN时会大幅下降,然而先进的网卡可以将VXLAN/NVGRE功能卸载到网卡硬件完成,实现CPU资源的释放和网络性能的优化。如图3所示,硬件实现VXLAN功能的Mellanox以太网网卡为虚拟机带来的网络带宽是软件VXLAN的5倍。如果不具备硬件VXLAN技术,同样是10吉比特以太网或40吉比特以太网网卡,其有效网络资源将无法得到实际应用。

云计算环境中的云存储同样可以借助RDMA技术实现高速存储。现在越来越多的文件系统与存储开始支持RDMA。Ceph的RDMA版本在开发中,

图2 Hadoop MapReduce数据交互

图3 VXLAN 硬件卸载对网络带宽影响

Research on big data and cloud efficiency with high performance interconnect

LIU Tong

(Beijing Mellanox Technologies Co., Ltd., Beijing 100080, China)

Abstract Big data analytic is becoming the irreplaceable technology to perform business analysis and innovation in telecom. The trend of moving from traditional data center to cloud computing in telecom industry is also becoming irreversible. How to deploy effi cient big data and cloud platform with good price/performance is a big challenge. Research in this article will demonstrate RDMA enabled high performance interconnects brings high performance, effi ciency, manageability, scalability to build effi cient big data and cloud platform.

Keywords RDMA; Infi niBand; SDN; Hadoop; VXLAN GlusterFS、GPFS、Lustre都已支持RDMA。同时重点存储厂商也有一系列存储产品支持RDMA技术如EMC、Netapp、IBM、Seagate、华为、曙光、浪潮等。通过RDMA技术可以实现FC与TCP无法实现的存储高吞吐量与高IOPs。

由于Mellanox网络对SDN、SR-IOV、VXLAN卸载、RDMA,以及完整云平台生态链的支持,大型云计算中心如微软Azure、IBM Softlayer、Salesforce等通过Mellanox InfinniBad或以太网构建最高性价比的云平台。国内也已经有多家电信运营商采用Mellanox网络构建大数据与云计算平台。

4 总结

网络带宽是网络性能的重要指标,但不能仅仅依靠带宽来评定网络性能的优劣。如何将网络性能高效性映射到应用性能,需要网络芯片具备更先进的技术如高效通信协议RDMA,更多硬件卸载功能如SR-IOV与VXLAN Offload从而实现CPU资源的释放、系统高可扩展性,以及应用性能最大化。

收稿日期:2015-01-06

文章编号1008-5599(2015)02-0074-04

文献标识码A

中图分类号TN915