PC的尽头还有多远

蓝色

如今的PC以及电子计算机体系是建立在现代半导体技术的基础之上,这一领域在过去的几十年间曾经多次遇到发展的瓶颈,而且也不止一次的被宣布已经濒临崩溃的边缘,但我们的确很少量化地去思考PC以及电子计算机体系究竟将会在何时终结的问题。

也许您正驾驶着坦克驰骋在二战中的著名战场,也许您正在用Office软件处理日常工作,无论您正在用电脑上做着什么,总有着一群数之不尽的微小电子无时不刻地在你的电脑中跑来跑去,在某个不经意的瞬间,您有没有考虑过这样的问题——我们的PC会不会在哪天走到发展的尽头呢?

没有什么东西是永远存在的,谁都有走向终点的一天,我们和PC都不会例外。如今的PC以及电子计算机体系是建立在现代半导体技术的基础之上,这一领域在过去的几十年间曾经多次遇到发展的瓶颈,而且也不止一次的被宣布已经濒临崩溃的边缘,但我们的确很少量化地去思考PC以及电子计算机体系究竟将会在何时终结的问题。

我们的PC乃至整个电子计算机体系距离终点还有多远?有没有谁能充当电子计算机以及PC的继任者?在那之前我们都能做些什么呢?

1nm之下就是命运

视界之外(对于此时的观测者来说,光锥之外的宇宙是没有意义的)是命运,这是物理学的一句名言,它阐明的是一个观点,即:视界之外的事物,看不见,但不能当它不存在。将这句话说得通俗点,也可以延伸为“我们目视所及之外的未知只能交给命运来决定”,用这句话来形容PC以及电子计算机的极限是相当合适的。

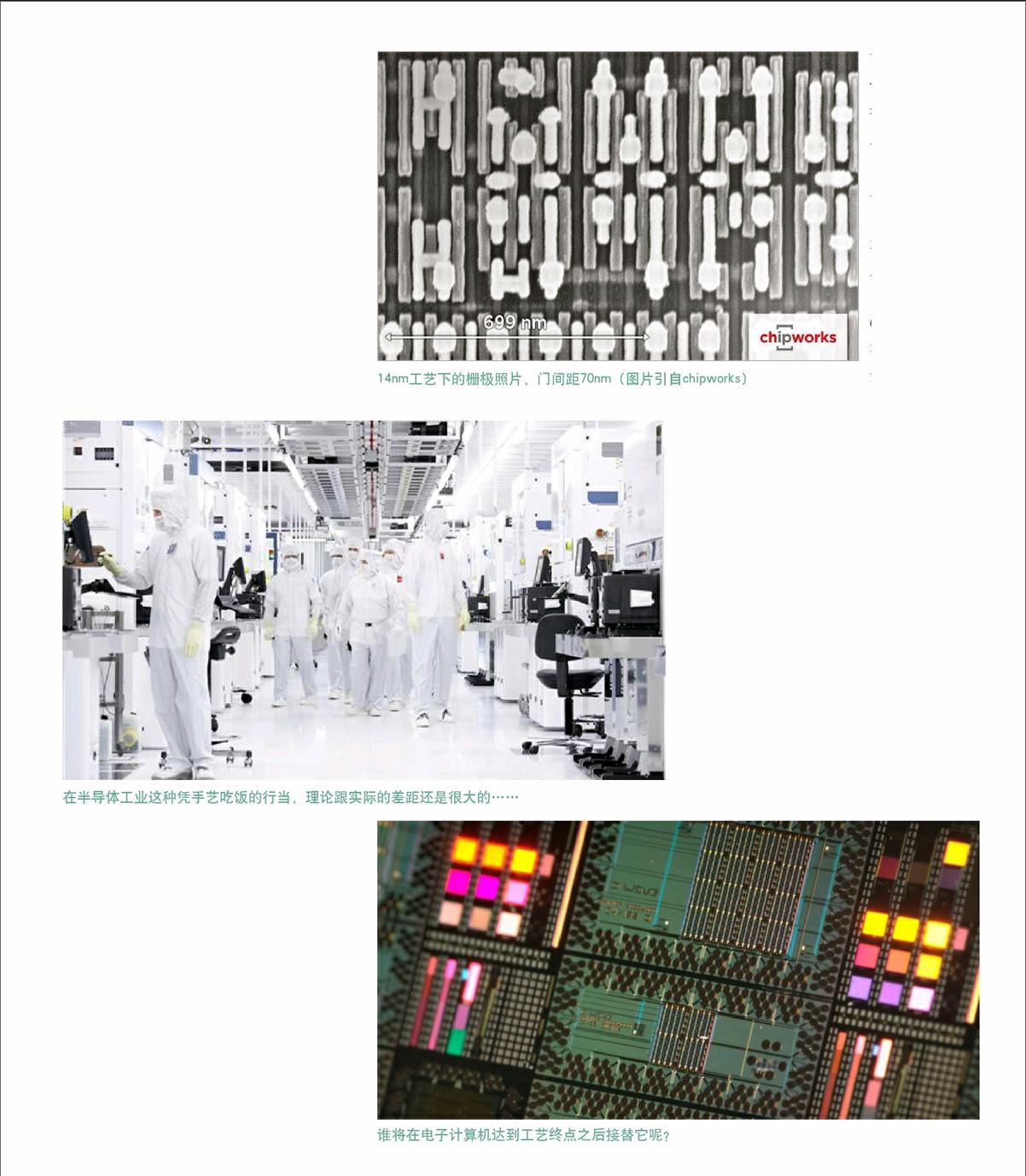

其实PC的理论极限距离我们还很遥远,即便是在距今“远古”的上世纪八十年代,可预期的并可以通过模型在实验室中实现(基于光刻技术)的电子元件的几何尺寸也可以达到几个埃(0.x纳米)。如果以今天的技术来衡量,我们甚至可以把元件的尺寸做到原子级,但是理论上能够实现并不代表在工业级的场合能够造得出来。半导体工业毕竟是一门把技术转变成消费品和财富的手艺,它始终要遵从可制造性原则的限制,能够在实验室当中实现与能够造出来卖钱/使用完全是两个层次的概念,当前技术范畴下的电子计算机在可制造性方面还是存在极限的。当工艺触及到这一极限而又无法突破时,电子计算机的终点也就到了。

PC/电子计算机的极限源自多个层面,包括但不限于光刻反应速率、刻线宽深比、光刻稳定性、EoT(等效氧化物曾厚度)极限、基底隧穿以及栅极减薄隧穿,还有由此一系列问题所带来的下游效应等等,这里涉及了太多物理学(同时包括宏观物理学和量子物理学)、物理化学、材料学以及反应工程学方面的知识,说多了枯燥乏味,所以我们不再继续深入讨论,而是根据综合信息直接给出目前所能够规划到的半导体工艺极限——1nm。

在线宽低于1nm时,目前及可见未来的技术均无法突破可制造性问题以及物理表达形式层面的极限,芯片可以被制造出来,但它的运行状态以及良品率完全无法得到有意义的保证,因为这一尺度下,量子效应会更明显地反映出观察者的存在和干扰,我们甚至无法知道一颗有故障的芯片究竟是哪里坏了又为什么坏了,无论收集问题还是解决问题都无从谈起。1nm工艺就是当前半导体工艺的光锥和视界。现在没有人知道1nm之后的半导体工业会发生什么,所以1nm就是当前技术环境下PC以及电子计算机的“命运”,无论CPU、显卡、内存还是硬盘都无法回避。

1nm工艺距离现在还有多少时间呢?粗略算下来,在不考虑半代工艺的前提下,半导体工业还有14/10/7/5/3以及2nm工艺总计6代的可发展余地,按照当前节奏来看起码还应该有144至216个月左右的周期(考虑到工艺下探难度的提升以及需求放缓导致的增速放缓,我们将工艺升级周期从摩尔定律周期模糊处理至24~36个月)。换句话说,如果这一极限在18年内得不到被突破,甚至是连具有可行性的解决模型都没有出现的话,电子计算机以及基于电子计算机技术的现有形态PC就算是发展到头了。

那么在这之后呢?总不能就停滞不前了吧,我们觉得应该不会。人类在一般情况下都不会在遇到难以逾越的障碍时选择回避并静待消亡,人们总能找到解决问题的其他突破口,更何况计算能力是现代以及未来人类文明不可或缺的组成部分,任其消亡无疑意味着人类文明的消亡,所以尽管还有几十年的时间,但电子计算机的继任者们已经在路上了,这些继任者包括但不限于如下这些各位也许已经耳熟能详的家伙——量子计算机,光子/光电子计算机和DNA计算机。

“纠缠”,25年之后的希望

电子计算机最“科幻”、最具希望、最被公众所期待同时也是最难以被理解的继任者,毫无疑问的当属量子计算机。顾名思义,量子计算机基于量子以及量子比特作为运算基础,使用粒子的纠缠态、退相干过程或者隧穿效应等量子效应来完成运算,能够达到常规电子门电路无法达到的运算速度和并行度。不过,有鉴于纠缠态以及退相干过程与宏观及日常经验认知之间巨大的差异,我们不打算在此用太多笔墨去解释这两种现象,跟量子力学一样,量子计算机以及量子比特也属于“根本就不是要让常人明白”的那种存在。

虽然原理难以被理解,但量子计算机的发展速度相对其他方案而言完全称得上“火力全开”,这种新的计算模式已经有了许多接近具备解决实际问题能力的原型机,比如Google斥数千万美元巨资分别购买的两台基于量子计算原理的实验性超级电脑——D-wave以及D-wave 2,虽然这两台量子计算机基于量子退火(亦即隧穿效应,一种能够让粒子隔空瞬移的现象)而非纠缠态量子门电路(令粒子处于相干纠缠态的逻辑门电路结构),但Google仍宣称这两台量子计算机在经过充分优化之后在解决自然解优化问题(该问题对于AI、大数据高效检索以及图像识别等领域有重要意义)时拥有数千倍于传统电子计算机的性能。而采用传统意义上的量子门电路解决方案,则拥有比D-wave系列更快的运算速度以及更大的应用广度。

尽管量子计算机的发展迅速并且前景诱人,但眼下就激动着畅想关于量子PC的未来还为时尚早,毕竟它距离真正实现还有相当遥远的距离并且困难重重。

量子计算过程并非基于二进制,这与现行的电子计算机计算体系有着巨大冲突,而且量子计算并不能进行现实意义上的逻辑运算,它仅能利用纠缠态完成运算然后输出同样处于纠缠态的结果,这些结果处在无法操作的状态,需要复杂的转换过程才能变成具有实际意义的结果。这无疑会带来大量的重建协议工作,所以目前量子计算还仅用于加解密以及部分数学问题等特殊且极具针对性的领域,并不具备进行实际的通用计算或者与现有电子计算体系融合的能力(D-wave系列已经算是一次朝这个方向的尝试了)。

另外,量子计算的民用化也存在相当现实的障碍,比如说为了抑制热噪声以及粒子热振动对维持纠缠态的影响,大部分量子计算机的原型都需要超导级低温的协助,以可接受的成本和形式在家中或者办公桌上实现这一环境(持续稳定的保持零下200度)绝不是一件容易的事。那么,若是未来的技术无法在常温环境下构筑量子门电路的话,预测量子计算机PC化无异于痴人说梦。

所以说,我们也不知道量子PC什么时候才能出现,思考它是否会替代当前的PC也没有什么意义。我们真正需要的,是把量子计算机甚至量子计算机集群同云体系结合在一起。基于云环境的量子计算机体系,即中央超级处理器集群和单纯呈现节点相结合的环境在理论和技术上都相对容易实现,我们只需要在超级计算机层面实现可用型的量子计算机,然后以此来构筑云端计算能力,而那些超低恒温环境等烦人的问题就扔给集群解决,最后,在每个用户手中发一个类似平板电脑一样的终端就大功告成了。

如果市场环境(主要是构筑云所需的带宽环境)能够接受,同时量子计算在技术、协议以及编程环境等领域均发展稳定且可以正常提速的话,我们认为这样的远景在25至35年之后可以实现,如果人类在退相干领域取得决定性的技术突破并伴有重大需求刺激,这一进度最快可以提前到15年左右。取个平均的话,也许20至25年之后,您就能捧着一个小窗口畅快的享受量子计算带来的“一股神秘的速度”了。

上帝说,要有光

当然,我们不能在一棵树上吊死,量子计算体系虽然诱人且具备一定的可实现性,但只探索一种发展方向显然是不够的,更何况量子计算还存在特别基础的“与现有计算体系相容难度极大”的问题。所以人们也搞了些相对简单的玩法,那就是光子计算机以及光电子计算机。

光子/光电子计算机并没有量子计算机那么“玄幻”,它所基于的理论基础是相当简单自然的光学和光电效应。光子计算机使用光子来替代电子完成运算及操作过程,除了需要发光元件(激光器)以及对应的光导纤维作为“导线”之外,它并没有提出太多过分的技术要求,所以曾经一度被认为是最有希望替代电子计算机的全新计算方式。

光子拥有相对论范围内最快的速度,本身没有质量,与自身及其他物质的相互作用远低于电子,所以光子/光电子计算机的能耗低,避免了电子在速度、传输能量损失以及工作发热等层面的束缚,信号传输及处理快,具备先天的并行传输/存储信息能力,而且可处理的数据类型相当广泛,对现有的二进制体系相对友好,如果基于光电转换/光电开关,那么现有计算协议可在相当程度上予以保留。

这一切看上去的确很美,相对于量子计算也更容易实现,不过,我们必须很抱歉的告诉您,光子计算机未必能比量子计算机更早实现。光子计算机较低的“理论难度”并不意味着同样较低的“实现难度”,人类虽然已经拥有了数百年(我们以牛顿开始分光处理并系统研究光学起计)成熟的操作和控制光线的历史,但在微观领域完成同样的事却并不容易。在半导体层面实现小尺寸可用光学元件,尤其是可以在常规环境下稳定使用的光栅开关仍存在困难,技术瓶颈相当明显。而如果使用光电转换将光信号转化回电信号加以处理,协议复杂不说,接口部分的速度还难以提升,所以光电子的运算速度起码在现在看来没什么优势可言。

天堂入口还是地狱之门

如此看来,量子计算机和光子/光电子计算机都不是短时间以内能够实现的替代方案,那么DNA计算机呢?

DNA计算机与生俱来就有很多耀眼的特质,它天生高度并行,能耗极低,体积超小,协议重建难度介乎于量子计算机与光子计算机之间,运算模式与神经系统最为接近,运算结果可以和特定生化过程同步完成并直接将运算结果呈现为实验结果,在解决可以充分网格化的非顺序问题时有独特优势。基于DNA/RNA分子及基因编码序列,以生化过程完成计算的DNA计算机虽然距离传统意义上的“计算机”最遥远,但却拥有令人难以拒绝的种种优势。只需要一滴水大小的溶液,其中成百上千亿的DNA分子就能超快速的搞定各种难解的数学问题,如果用它来打造超强PC,那岂不是相当美好的未来图景?

但令人遗憾的是,DNA计算机别说做成“一滴水大小的PC”了,就是做成字面意义上的“计算机”都还是不可能的任务。

与量子和光子计算相比,DNA计算的起步最晚而且完成度也最低,几乎还没有真正意义上的计算原型机,绝大部分所谓的DNA计算模型都还只是试管里或者显微玻片上的一抹溶液。与前两者相同的是,DNA计算现阶段的应用范围同样狭窄,它只能被用来解决特定的数学问题而非通用计算问题,其结果表达形式也相当复杂,需要重建的协议仍旧极多,甚至连最基本的IO接口都难以构筑,对二进制体系的友好程度无法量化判明。

另外,DNA计算对环境的要求甚至远超需要超低温制冷的量子计算机,它要求绝对纯净的环境,即便是试管上最小的污渍也会给计算过程带来毁灭性的影响。DNA计算基本上还处在理论阶段,距离实用还有相当遥远的距离。

不仅如此,DNA计算还存在层级甚高的非技术性问题——将庞大的计算能力、有序性以及逻辑性赋予理论上拥有自我复制以及形成生命潜力的存在形式,这无疑是个极端危险的决定么,DNA本来就是生命的基础,地球上所有生命形式都是构筑在DNA/RNA分子的生化行为之上的,如果肆意改变DNA/RNA的编码体系,让DNA/RNA具备了庞大且有序的运算能力,甚至是自反馈性以及目的性,一旦触发某个方向上的耗散系统的自组织现象,甚至由此而产生了AI或者类似AI的有序自主存在形式,其结果可能是不堪设想的。

计算机如果因为强大的运算能力而产生了AI,那也不过是机械或者某些有争议的智慧体而已,如果DNA运算体系产生了AI,其产物就很可能是所谓的“新的智慧生命”了。

不可否认,DNA计算的特性造就了其无可替代的价值,未来的医学、生化以及生物学研究将会越来越多的从其中获益,诸如拓扑学、任务的无损拆解及网格化还有神经系统模型的研究也能由DNA计算模型中得到帮助,但DNA计算应该存在不可逾越的红线——不要触及实际的通用运算任务,不要形成系统性的计算体系,更不要拿它来替代电子计算机。

在终点前寻找新的起点

一个难懂而且起码要等上2、30年的时间,另一个难实现而且还不知道什么时候可以被实现,最后一个更难实现而且干脆就不要被实现的好,如此看来,似乎每一条前进的道路都是荆棘密布、难以前行。当然,本文的目的也不是探索可行的方案,而只是着重于展示PC/电子计算机时代的极限以及“后PC时代”的继任者风貌,虽然可以相对轻松的知晓终点何在,但从继任者的角度上看,PC发展进入死胡同之后的未来图景并不令人乐观。

毋庸置疑,如果电子计算机体系寿终正寝,整个产业以及我们的生活都将会随之发生巨变。无论用哪种技术手段接替,届时要更换的都将不仅仅是设备,还有几乎所有内、外部协议和应用环境,这不仅是技术的问题,同时也是产业、消费者甚至社会环境的大问题。除了成本堪称天文数字,对整个人类的文明也将会产生未知且深远的影响。

如此看来,我们今天所面对的这三位在现阶段的表现似乎都难以尽如人意,除非有重大的产业级乃至社会级的变革加以刺激,否则电子计算机的极限很有可能会先于备选接替者们到来,无论是量子计算机,光子/光电子计算机,还是“禁忌级”的DNA计算机恐怕是都跟不上节奏了。即时,迎接我们的,将很有可能会是无奈的停滞不前。

工艺的极限是存在的,如果无法突破原有极限,同时又没有新的方向或继任者,在现有环境下继续进行技术改进并寻求新的解决方案就成了必要的手段,比如说出现在当前GPU业界的“向逻辑结构而非工艺要效率”的设计思路无疑是有益的尝试。如果能在相同工艺环境下通过优化逻辑结构设计来提升硬件架构的性能功耗比,我们就有了更晚触及工艺极限的正当理由。当然,由于逻辑门电路的基本结构已经几无优化余地,对其宏观组合方式的优化并不能让我们永远回避性能滞涨的问题,最后回到向频率要性能的路上是唯一的结局。但对于打着摩尔定律的旗号向终点发足狂奔的整个PC及电子计算机业界而言,这种尝试无疑会提供更多宝贵的时间来为我们缓冲。

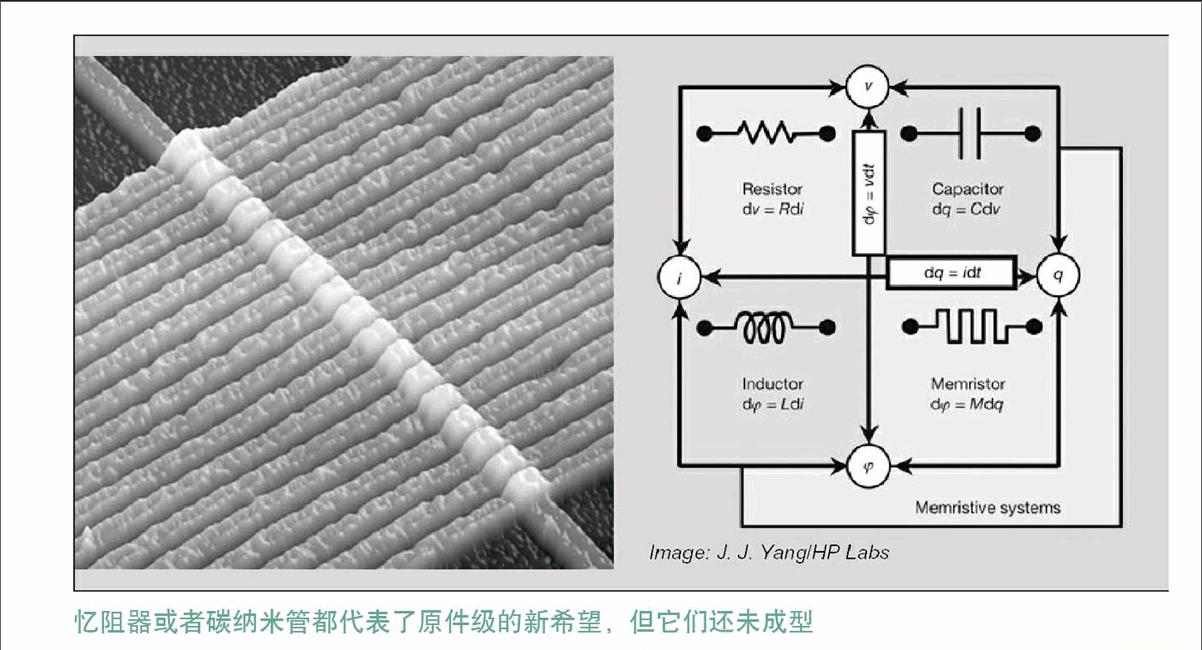

包括忆阻器以及碳纳米管在内的一系列新元件也许是PC潜在的元件级技术希望,这其中尤其以忆阻器最为引人瞩目,作为新近发现的第四基本元件,忆阻器断电之后状态信息不丢失的特性给PC以及电子计算机体系带来了新的希望,它甚至被誉为“晶体管和现有数字逻辑电路的替代者”。但是忆阻器本身的研究进展刚刚起步,大部分细节以及专利均掌握在惠普手中,而且并没有表现出能够让我们通过1nm关卡的趋势,还有没有其他可行性更高的方案来充当备份呢?

我们注意到,基于超大规模集群和高带宽低延迟通讯协议的云计算/云应用环境也是未来之一,它能改变现有PC的存在形式,将“采购本地运算能力”变成“采购超大规模运算能力当中的一部分”,这等于把PC的运算极限从单台/本地级别大幅提升到集群规模,将受迫于工艺极限的单节点硬件性能的瓶颈转嫁给集群,因此,理论上可以让个人/单节点运算能力大幅提升到完全满足任何需求的地步。如果云技术能够充分实践化,PC或者说接近我们现在意义上的个人PC节点的极限起码可以再推后10年左右,尽管在那之后增长仍将会停止,但这段缓冲期无疑是宝贵的。而且云体系的建立,本身也与量子计算机及量子计算的民用普及条件不谋而合。

总之,以今天的眼光来看,在可遇见的未来,对于PC以及电子计算机发展到尽头这件事儿,我们大概还有15至20年可以安心等待的时间,在这段时间里,就让我们擦亮双眼仔细把握每一次关键性的技术进步吧。□