信息论教学中熵的一种引入方法

常祖领

摘 要 熵是信息论中的一个最基本的概念,只有接受了熵的意义,学生们才有可能理解信息论中的其它概念和理论。因此在信息论教学中熵的引入是最基本和最重要的一步。通过多年信息论教学,笔者总结出一种引入熵的方法,这个方法更加直观和系统,使这个概念更容易被学生理解和接受。

关键词 信息论 熵 公理化方法

中图分类号:G424 文献标识码:A DOI:10.16400/j.cnki.kjdkx.2015.06.053

One Introduction Method of Entropy in Teaching Information Theory

CHANG Zuling

(School of Mathematics and Statistics, Zhengzhou University, Zhengzhou, He'nan 450001)

Abstract Entropy is the most elementary concept in information theory and students can understand the concepts and theories in information theory only if they accepted meaning of entropy. So introducing entropy is the most elementary and important step in the course in information theory. Through years of teaching information theory, I summarize one more intuitive and systematic method to introduce entropy which makes students can understand and accept entropy more easily.

Key words information theory; entropy; axiomatic approach

在信息论这门课程中,“熵”(Entropy)是一个非常重要的概念。“熵”首先出现于热力学第二定律中,是仙农在1948年他的开创性论文“通信中的数学原理”①中,把这个概念借用于信息论中来表示信息量的多少。通过熵,我们可以把信息进行量化,从而把使用丰富的数学工具来分析信息变成了可能,从而奠定了现代信息论的基础。②在信息论的教学中,如何引入熵这个基本概念,就是一个非常重要的问题。如果引入得不好,则学生对熵不理解,无法接受这个概念,从而影响进一步的信息论教学效果。

在多种信息论教材中,引入熵的方法多种多样,大概可以归结为三种,一种是直接给出熵的定义而不加推导引入;③一种是先考虑变量各个取值的自信息,然后再求期望推出熵的定义;④一种是先分析性质,再通过证明推出熵的定义。⑤在多年的信息论教学中,笔者综合了各种方法的优点,总结出一种新的引入熵的方法,这种方法更加直观和系统,可以让学生容易接受,教学效果良好,现与从事信息论教学的各位同仁们交流分享。

我们在这里详细介绍引入熵的各个步骤,力求清晰明了:

第一步:定义信源。

在引入熵之前我们定义信源。详细说明信源是产生信息的源头,其间可以通过举例来说明。为了研究方便,对信源建立数学模型。我们用随机变量表示信源并只考虑离散型随机变量。令表示离散型随机变量, ={,,…,}表示的取值字母表。的概率质量函数( )为:() = { = },,或者 = { = },。

第二步:定义信息。

然后我们提出信息的概念。因为随机变量的取值是依对应的概率相应出现的,所以在随机变量的值出现之前,我们一般不能确定它的确切取值,因此随机变量有不确定性。例如:在抛掷硬币时,我们不知道结果是正面或是反面;从袋子中取球时,我们不知道会取中那个;买彩票时,我们不能确定会不会中奖,等等。当随机变量的值确定之后,不确定性消失,等价于从中获得一些信息。在这种意义下,我们把随机变量的信息与随机变量的不确定性等价起来,我们称随机变量的信息指的就是随机变量的不确定性。这里我们一定要让学生理解随机变量的不确定性即信息这一点。

第三步:提出信息的度量。

有了信息的概念,自然就会产生这样的问题:随机变量的信息(不确定性)该如何度量?我们该如何判断随机变量的信息(不确定性)的大小?显然,随机变量的不确定性由随机变量的概率分布决定。但用概率分布来表示不确定性非常麻烦,例如可能不同的概率分布会具有同样的信息。最重要的是概率分布不能量化,因此我们需要考虑信息的表示问题。

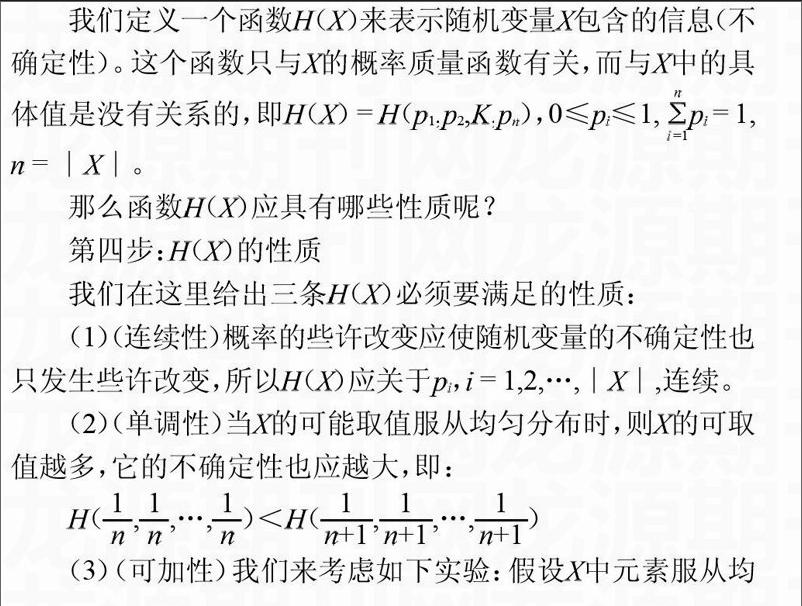

我们定义一个函数()来表示随机变量包含的信息(不确定性)。这个函数只与的概率质量函数有关,而与中的具体值是没有关系的,即() = (,,,),0≤≤1, = 1, = ∣∣。

那么函数()应具有哪些性质呢?

第四步:()的性质

我们在这里给出三条()必须要满足的性质:

(1)(连续性)概率的些许改变应使随机变量的不确定性也只发生些许改变,所以()应关于, = 1,2,…,∣∣,连续。

(2)(单调性)当的可能取值服从均匀分布时,则的可取值越多,它的不确定性也应越大,即:

(,,…,)<(,,…,)

(3)(可加性)我们来考虑如下实验:假设中元素服从均匀分布时,把其中元素分成一些不交集合。

,,,,∣∣= , = = ∣∣

首先以对应于集合大小的相应概率选取一个集合,即()= ,然后再等概地从被选集合中选取一个元素。因为endprint

我们有() = (∣)() = = 。

这说明以我们上面定义的方式选取中元素的概率与直接以等概选取中元素的概率是一样的,所以这两种不同的方式所蕴含的信息也是一样多的。

例如,一个袋子中有个不同颜色的球,则直接从袋子中取球的概率是等概的。如果先把球分装到各个小袋中,再把这些小袋装入大袋。选取时先从大袋中取一个小袋,然后再从小袋中取一个球,这时取各个球的概率仍为等概,所以这两种方式所包含的信息是一样多的。又例如:100个学生,编号为00~99,随机从中选取一个编号,或先随机选取编号第一位后,再随机选取编号第二位。它们的不确定性是一样的。

第一种方式的不确定性(信息)为:(,,…,)

在第二种方式中,选取集合,,…,的不确定性为:(,,…,,)。选定一个集合后,再从集合中选取元素这个过程也有不确定性,这个过程的平均不确定性为:

()€祝ù又醒∪≡氐牟蝗范ㄐ裕?

= (,,…,)

所以我们有

(,,…,,) = (,,…,) + (,,…,)

综上,我们所定义的用来衡量随机变量的不确定性(所蕴含的信息)的函数()应具备如下性质:

(1)(连续性)(,,…)对所有概率密度函数,,,,0≤≤1, = 1是连续的;

(2)(单调性)(,,…,)<(,,…,)对所有正整数都成立;

(3)(可加性)对于正整数,…,, =

(,,…,) = (,,…,) + (,,…,)

下面我们将证明性质(1)—(3)唯一定义了一个函数()。

第五步:根据性质推导熵的形式。

在这里我们用定理的方式确定唯一的熵函数。

定理:一个函数()满足以上性质(1)—(3),当且仅当它有如下形式:

(,,…) = 或() = ()

其中>1作为对数的底,且令00 = 0。

这个定理的证明较长,在这里就不列出了。教学中证明过程也可以省略,只需要让学生知道上面三条性质唯一决定了熵的形式即可。在我们的教学中也是省略的,因为以前给出详细证明时,学生有时会产生信息论很难很复杂的想法,从而有退缩心理。

第六步:熵的定义。

至此我们就可以顺理成章地给出熵的定义了。

定义:一个离散型随机变量的熵()定义为:

() = () () = ( = ∣∣,>1)

当 = 2时,() = () ()熵的单位为比特()。

给出定义,然后再给出一些解释,包括熵的单位,熵的由来,熵的意义等,这样就使得学生对熵有一个系统的了解,为以后的教学奠定较好的基础。

在这里我们给出的引入熵的方法其实是一种数学中常用的方法:公理化方法。为了推导出熵这个概念,我们先从熵函数应具备的基本性质入手,然后再寻找具有要求性质的函数,因为该函数唯一,所以这个函数就是我们唯一的选择。我们可以利用这点来保证熵的定义的合理性。

通过上面的步骤,我们逐步推导出熵的定义,并在推导过程中我们又对熵的性质做了分析,使得学生更容易接受熵的概念,并对熵有较全面的了解。经过实际的教学检验,这种引入熵的方法效果较好,学生对熵的理解比较深入,并会让学生对信息论产生兴趣。

注释

①②C. E. Shannon, “A Mathematical Theory of Communication”(通信中的数学原理)[J].The Bell System Technical Journal,vol. 379-423, 623-656, July, October, 1948.

③ T. M. Cover, J. A. Thomas, 信息论基础(第二版) [M].阮吉寿,张华,译.机械工业出版社,2008.

④ 叶中行.信息论基础(第二版)[M].高等教育出版社,2007.

⑤ S. Roman, Coding and Information Theory (信息论与编码理论)[M].Springer New York,1992.endprint