基于多尺度纹理特征的最小二乘法深度信息估计方法

牛连丁 陈婷婷 张立志

摘 要:由于二维图像三维化技术重建三维场景可以低成本、高效率地提供三维显示资源,使得该技术成为图像处理领域重要的研究课题。深度线索的提取是重建三维场景的重要研究内容之一。为了更好的描述纹理特征与场景深度之间的关系,提出了一种基于多尺度纹理特征的最小二乘深度信息估计方法。通过构建多尺度模型、纹理滤波的方法捕捉头像的多尺度纹理梯度、纹理变化等特征作为训练样本;并进行训练,得到纹理线索与场景深度间的关系参量;最后用该参量来估计待测样本的深度。实验结果表明,该方法对场景深度信息的估计具有较好的效果。

关键词:多尺度纹理,最小二乘方法,深度估计

中图分类号:TP391 文献标识号:A

The Least-square Depth Information Estimation Method based on Multi-scale Texture Features

NIU Lianding1, CHEN Tingting 2, ZHANG Lizhi2

(1 Network and Educational Technology Center, Harbin University of Commerce, Harbin 150028, China;2 Department of Computer and Information Engineering, Harbin University of Commerce, Harbin 150028, China)

Abstract: With the advantage of low cost and high efficiency for 3D display market, the technique of 3D scene reconstruction from 2D scene image has been the main research contents in the field of image processing. For the 3D reconstruction, the extraction of depth cues is one of the most important contents. Therefore, the paper proposes a least-square depth estimation method based on multi-scale texture features, which can better describe the relationship between the texture features and the scene depth. By using the methods of constructing multi-scale model and texture filtering, the paper captures the features of the texture gradient and texture variations as the training sample sets, and then trains these samples to get the relationship parameters between texture cues and scene depth, which can finally be applied to estimate the depth of the test sample sets. The experimental results show that the proposed method performs well in scene depth information extraction.

Keywords: Multi-scale Texture; Least-square; Depth Estimation; Texture Feature

0 引言

由于三维影像可以带给受众更加逼真的临场感,在各领域中都得到了广泛的应用[1],市场潜力巨大。然而,三维视频制作成本高、技术难度大、现实周期长等问题,限制了资源的供应,无法满足市场需求。为了解决这一矛盾,通过获取二维影像的深度信息,并利用该信息将现有二维影像三维化处理获得三维影像,成为解决三维显示内容不足的一个重要手段。该方案不但可以降低制作成本,缩短制作周期,还能够充分利用现有的影像资源避免资源浪费。自2003年,德国Christoph Fehn提出了基于深度图绘制DIBR(Depth-Image-based Rendering)[2]的三维图像生成方式后,深度信息即已提取成为实现二维影像三维化的关键技术之一。

场景深度信息是指在空间上场景对象与图像物理成像焦平面的实际距离。二维场景图像的纹理变化、纹理梯度、颜色都能给人们提供良好的深度感知。通过比较一纹理区域在不同尺度下的位置、大小、方向,估算出纹理区域的相对位置关系,进而得到相应纹理区域的场景深度。Knorr等提出了利用图像纹理梯度线索来提取深度的方法[3]实现深度估计。对于室外场景的转换得到了较好的重建质量,但由于线索单一,对室内场景图像效果较差。Malic,Saxena[4-5]等人,根据景物对象在不同深度上存在着纹理及阴影差异,通过建立马尔科夫随机场模型,监督学习方法训练参数,从而估计图片场景深度。Derpanis等人则从时空方向能量对动态纹理进行描述[6],提出利用方向滤波器的能量响应对视频进行处理,按照不同的等级对运动的形式进行定向分析。

基于对纹理特征的研究及优化算法的总结,提出了一种基于多尺度纹理特征的最小二乘深度估计方法。该方法采用了纹理滤波器分别对图像的纹理梯度、纹理渐变、颜色进行滤波,用以捕捉图像不同尺度的纹理能量作为特征,通过训练得到纹理线索与场景深度间的关系参量,并利用该关系参量来估计特测试样本的深度。

1多尺度纹理特征提取

二维图像是三维场景在二维平面上的投影。在投影过程中丢失了大量的三维信息,其中不仅包括深度信息,还包括真实物体的形状等几何信息。只有充分挖掘二维图像中残留的信息,才能重构三维场景。因此,通过构建多尺度模型,捕捉多尺度纹理特征实现二维图像的深度信息估计。

在研究中,以宏块为基本处理单位,通过计算图像中的所有宏块的深度值,获得整幅图像的深度信息。首先,将图像划分成固定大小的宏块;然后,对于任一宏块构建多尺度模型;最后采用滤波器模板对该多尺度模型中的每个宏块进行卷积,进而求得该宏块的多尺度纹理特征。

1.1多尺度模型构建

单目二维场景图像的局部特征并不能够完全正确地反映场景对象中某一宏块的深度值,因此需要引入与之相邻的局部特征或全局特征才能正确估计图像的深度信息。因此,为了获得更多图像本质特征,引入了尺度空间的思想[7-8]。构建如图1所示的多尺度空间模型,采用多尺度分析法获得二维场景的本质特征。

图1 多尺度模型

Fig.1 the multi-scale model

在观察物体时,随着物体和观察者之间的距离不断地变化,视网膜感知到的图像信息也是不断变化的,通过综合分析这些不同的视觉信息可以获得被观察物体的本质特征。多尺度空间分析思想是根据人眼观察事物的这一特点,在图像信息处理过程中引入一个尺度参数(如物体和观察者之间的距离),通过不断变化尺度参数获得在不同尺度下的图像信息,然后综合分析这些信息深入地挖掘图像的本质特征。多尺度空间分析方法对于深度特征提取具有重大意义。如图1中,A0、B0、C0分别是三个尺度下的图像宏块。对于宏块A0,仅通过其本身特征来推断其深度信息是不可能的。而B0、C0提供了不同尺度下的图像特征,通过综合分析这些全局信息可以更好地推断出宏块A0的深度信息。

在对图像中景物深度信息判断过程中,发现相邻宏块的特征对目标宏块的深度估计也具有很大贡献,可以约束相邻宏块之间深度的依赖关系。因此,将宏块A0、B0、C0的上、下、左、右四个相邻宏块包含在多尺度模型中。这样不仅可以将与目标宏块直接相邻的宏块的特征引入深度判断,而且还可以将较远的宏块的特征引入深度判断。

最终构建了宏块A0的多尺度模型,共计5宏块/尺度×3尺度=15个宏块。

1.2 纹理特征提取

纹理是一种反映图像中同质现象的视觉特征,体现了物体表面共有的内在属性,包含了物体表面结构组织排列的重要信息以及其与周围的联系[9]。在图像的分析中将描述这种灰度变化规律的数字特征称为图像的纹理特征。

纹理的变化在人眼视觉感知深度的过程中扮演着重要的角色[10]。图像纹理线索作为深度提取的主要因子之一,在人眼视觉深度感知过程中发挥着关键性的功能主导作用。随着深度的变化,图像纹理在视觉中的变化是很明显的。纹理分析方法广泛应用于视频图像恢复、图像增强、三维立体视频制作等。因此,采用Laws滤波器以及纹理梯度滤波器滤波的方式获得纹理特征。

由于Laws滤波器[11]检测均值(Level)、边缘(Edge)、斑点(Spot)等诸多信息简单有效,至今为止仍被广泛用于分割与模式识别等领域。本文采用3阶Laws模板(如图2所示)对图像的灰度通道进行滤波,以获得图像的灰度纹理变化信息;采用图2中第一个模板对图像的两个色度通道滤波,以获得色度通道的纹理变化信息。

图2 Laws模板

Fig.2 the Laws Mask

纹理梯度侦测器是用于检测图像纹理方向的一组滤波器模板。图3中给出的是间隔为30°方向侦测器,将0~180°的空间划分成6个方向,考虑到纹理方向不存在正向与反向之分,可以通过这组侦测器将纹理分析具体归结到6个方向上来处理。

图3 纹理梯度滤波器模板

Fig.3 the mask of texture gradient filtering

将上述9+2+6=17个滤波器 ( )与图像宏块 卷积并求其能量。式(1) 中,k=1时为绝对能量,k=2时为平方能量和。这样,每一个宏块获得34维特征向量。

(1)

再将多尺度空间模型与纹理特征提取方法相结合。即采用式1所示的方法,对于每个目标宏块i所建立的多尺度模型中的15个宏块,进行纹理变化、纹理梯度等特征的提取,最终获得34×15=510维可以反映其深度信息的特征。利用这些特征,采用模式识别的概率模型来估计场景对象深度。

2 基本算法模型

模式识别起源于二十世纪二十年代,随着计算机的出现和人工智能的兴起,在六十年代发展成为一门重要的学科,并广泛应用于代数、矩阵论、概率论等其他领域。模式识别是研究图像或各种物理对象的分类与描述的实用性科学,是将每一具体事物正确地归入某一类别。可以说,模式识别是模式空间经过特征空间变换到类别空间的一个实现过程。

将深度估计引入模式识别,即把深度估计问题归为模式识别问题,深度即是离散的拟要识别的模式类。对训练样本集和待估计的测试样本集内图像分别进行特征的提取;以贝叶斯原理为基础建立分类器进行分类决策模型;然后,根据最小二乘方法训练模型参数,使得基于这种分类决策对被识别对象进行分类所造成的误差要尽量趋小;最后,利用所得模型参数完成深度估计,生成待估计测试样本的深度图。

2.1 基于模式识别方法的深度模型

利用模式识别分类方法,对已有的真实深度图像和二维场景图像进行监督训练,在本实验中参考Saxena的数学模型方法,将训练样本图像分成 个宏块单元,选取三个尺度的纹理能量作为训练样本集的纹理特征,并将训练样本同一行的纹理特征进行相关组合,构成特征矢量,研究样本集中场景图像深度与纹理能量之间的关系模型,模型数学表达如式(2)所示[12]:

(2)

这种算法是针对宏块的深度值属于每一类进行决策。式中 是归一化常数; 是宏块 的特征矢量; 是宏块 的真实深度值。 表示真实深度的方差,用来衡量深度对于纹理能量特征的不确定性。大多相片是由水平安装的相机拍摄,每行具有不同的布局。因此,对不同行 采用不同的参数( , )。针对同一图像中不同行场景布局的不同,所需训练的行参数也不尽相同,并用 来表示每一行的参数矩阵, 的估计是通过 的极大似然函数来获得。将其他参数看成已知,则 的最大似然估计即为求解线性最小二乘问题的真实结果。

2.2 基于最小二乘的参量估计

最小二乘法是一种数学优化技术,通过最小化误差的平方和来寻找数据的最佳匹配函数,进而简便求得未知数据,并使得这些计算数据与实际数据之间的误差平方和达到最小值。

利用最小二乘法的思想,根据估计深度值与真实深度值之差的平方最小来估计最优参数矢量 ,满足式(2)中概率最大的估计深度值即为二维场景图像在三维场景中的最适深度。式(2)中, 表示满足二维图像宏块的深度值取值概率,因此通过确定式中 的最大值,就可确定该宏块最有可能的深度值。同时,又根据指数基本性质,可知若使得 取最大值,则需要满足式(2)中 的取值为最小,并且式中 ,因此,就要使其中 取值达到最小,此处可令:

(3)

那么满足关系式 取值为最小,即需使:

(4)

根据矩阵的基本性质,利用最小二乘方法,对式(4)求导可得:

(5)

为满足式(4)中 取最小值,令 ,则:

(6)

从而得出二维场景图像的纹理特征与深度之间的关系参量:

(7)

2.3 深度估计

由式(7)得知,参数矩阵 与纹理特征 有着直接的关系。如前所述,每个宏块的纹理特征 都是510×1维特征向量,参数矩阵 则为1×510的特征矩阵。在进行深度估计时,可以认为深度 是宏块 的纹理特征矩阵的非线性组合。这样,参数矩阵 就是不同的权值组合,每一权值就是其相应的纹理特征对深度的影响程度,进而得到深度值如式(8)所示:

(8)

3 实验结果与分析

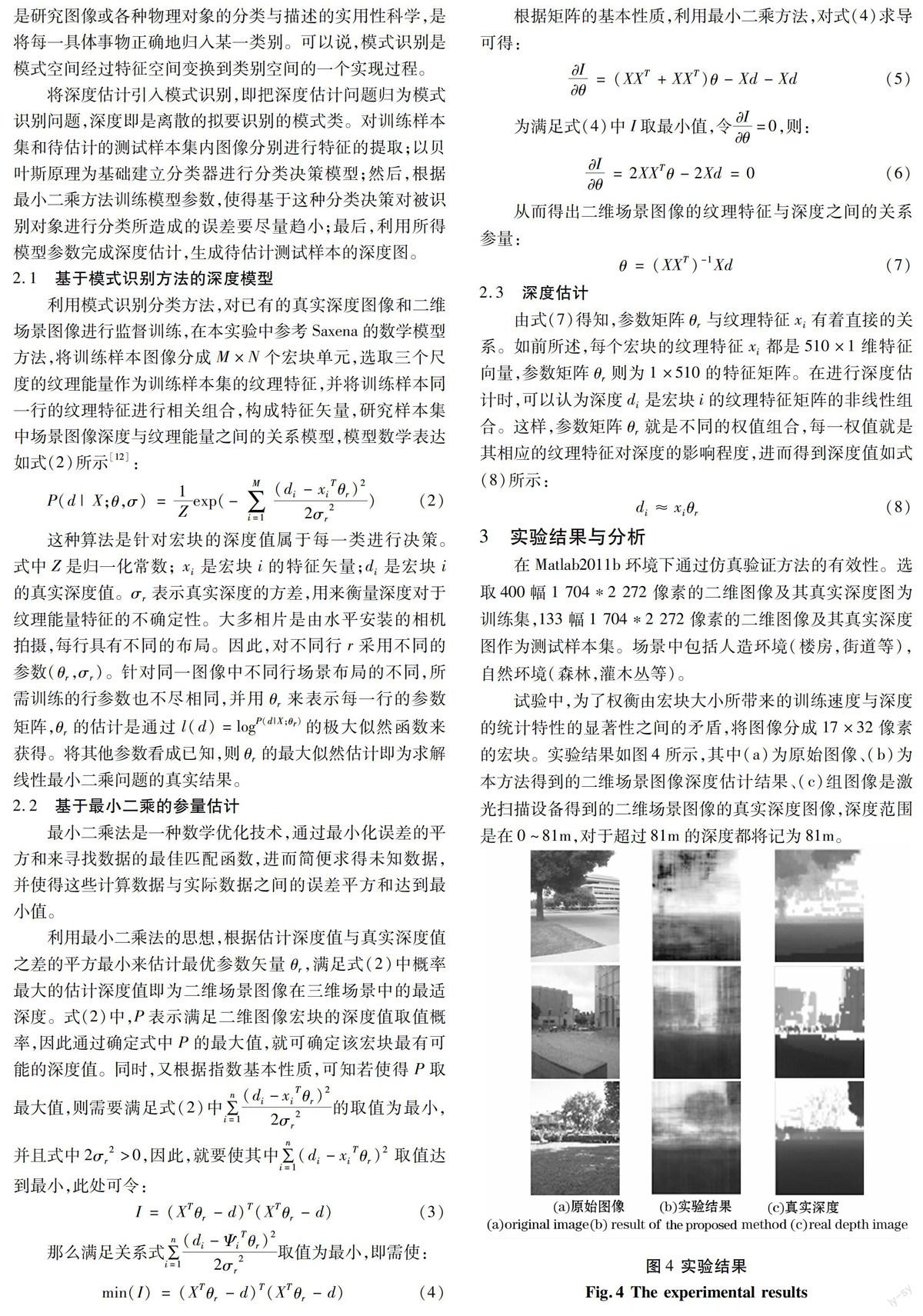

在Matlab2011b环境下通过仿真验证方法的有效性。选取400幅1 704*2 272像素的二维图像及其真实深度图为训练集,133幅1 704*2 272像素的二维图像及其真实深度图作为测试样本集。场景中包括人造环境(楼房,街道等),自然环境(森林,灌木丛等)。

试验中,为了权衡由宏块大小所带来的训练速度与深度的统计特性的显著性之间的矛盾,将图像分成17×32像素的宏块。实验结果如图4所示,其中(a)为原始图像、(b)为本方法得到的二维场景图像深度估计结果、(c)组图像是激光扫描设备得到的二维场景图像的真实深度图像,深度范围是在0~81m,对于超过81m的深度都将记为81m。

(a)原始图像 (b)实验结果 (c)真实深度

(a) original image (b) result of our method (c) real depth image

图4 实验结果

Fig.4 The experimental results

4 结束语

本文中,提出了一种基于多尺度纹理特征的最小二乘深度信息估计方法。该方法通过建立多尺度模型、采用了纹理滤波器对图像的纹理梯度、纹理渐变、颜色进行滤波,捕捉图像不同尺度的纹理能量作为特征, 并通过训练得到纹理线索与场景深度间的关系参量,该关系参量可用来估计特测试样本的深度。

实验结果表明,该方法可以获得较好的深度信息提取效果,且对场景结构及空间布局要求较低。但对于纹理轮廓不明显,深度值高度接近的图像,很难得到一个理想的深度图。因此,在未来的研究中将重点解决这个问题。首先,在深度特征提取方面,可以尝试使用其他特征,并且可尝试结合其他特征不同的特点,分配不同的权重。其次,在模式识别方法模型方面,可以尝试更好的方法来研究特征和深度信息之间的关系,建立不同的更加有效的模型。

参考文献

[1] KARSCH K,LIU C, KAN S B Kan, Depth extraction from video using non-parametric sampling [C] // Computer Vision, Florence: ECCV, 2012: 775-788.

[2] FEHN C. A 3D-TV approach using Depth-Image-Based Rendering (DIBR) [C]// Proceedings of Visualization, Imaging and Image Processing, Benalmadena: [s. n.] 2003:482-487.

[3] KNORR, IMRE S, OZKALAYCI E, et al. A modular scheme for 2D/3D conversion of TV broadcast [C] 3DPVT 2006, North Carolina: IEEE Computer Society,2006: 703-710.

[4] MALIK J, ROSENHOLTZ R. computing local surface orientation and shape from texture for curved surface[J]. Intermation Journal of Computer Vision, 1997, 23(2):149-168.

[5] SAXENA A, SCHULTE J, NG A Y. Depth estimation using monocular and stereo cues [C]// 20th Int'l Joint Conf. Artificial Intelligence, Hyderabad: IJCAI, 2007.

[6] DERPANIS K G, WILDES R P. Dynamic texture recognition based on distributions of spacetime oriented structure [C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition (CVPR), California : CVPR 2010,2010(6):191-198..

[7] WITKIN A. Scale-space filtering [C]// Proc 8th Int Joint Conf Artificial Intell, Karlsruhe: [s.n.], 1983: 1019-1021.

[8] 孙剑, 徐宗本. 计算机视觉中的尺度空间方法[J] . 工程数学学报, 2005.22(6):951-960.

[9] HARALICK R M. Statistical and structural approaches to texture[J]. Proceedings of the IEEE, 1979, 67(5) :786-804.

[10] Gibson. The ecological approach to visual perception [M]. London: Lawrence Erlbaum Associates, 1986.

[11] E. R. Davies. Laws Texture Energy in TEXTURE. Machine vision: Theory, Algorithms, Practicalities[M]. 3th edition.Morgan Kaufman, 2005:756-799.

[12] SAXENA A, SUN M, NG A Y. Learning 3-D scene structure from a single still image [J]. IEEE Trans. Pattern Analysis and Machine Intelligence (PAMI), 2009, 31(5): 824-840.