红外和可见光图像互补融合的运动目标检测方法

叶 华,朱明旱,王日兴

红外和可见光图像互补融合的运动目标检测方法

叶 华1,2,朱明旱1,王日兴1

(1. 湖南文理学院电气与信息工程学院,湖南 常德 415000;2. 中南大学信息科学与工程学院,湖南 长沙 410083)

可见光和红外图像具有互补特性,融合可产生更好的召回率,但现有方法融合后总会导致精度下降。这项研究提出了一种在特征级进行融合检测行人目标的方法:①提取前景目标特征的极大稳定极值区域Maximally Stable Extremal Regions(MSERs),计算红外图像MSERs稠密度和相似度特性,并根据此特性分类MSERs。②搜索匹配可见光图像中的相似MSERs区域,定位前景目标。③融合提取红外与可见光图像中的相似匹配MSERs区域,完成运动目标轮廓提取。该方法融合可见光图像信息,能有效滤除背景物,辅助定位在红外图像中检测的前景目标,并补充仅利用红外图像提取前景目标的缺失部分。已使用公共数据库对该方法进行测试,并与早期融合方法进行比较,能获得更好的召回率,同时融合后准确率不会下降。不需要对背景建模,因此比以往算法计算上更高效,更简单,单帧检测的效果也能达到实时处理要求。

极大稳定极值区域;互补融合;辅助定位;行人检测

0 引言

产生彩色或灰度图像的可见光照相机在光照条件较差时需要外部照明,而红外线照相机全天可以产生红外光谱图像,但它们缺乏质地和颜色等细节信息。由于可见光、红外摄像机具有互补性,一起使用可以提高对象检测的性能。红外图像中目标的可见性的关键因素为目标和环境之间的温度差别,即该行人或目标会比背景[1-8]更亮。然而,这种现象并不会出现在所有情况中。如一些热点出现在背景中,在红外图像中则无法检测到目标,这可能会增加错误警报,使目标的检测劣化。视觉图像也有具体问题,如视觉图像中光照变化、阴影以及夜间能见度差引起的对象检测性能差的问题。红外图像和可见光图像配准融合,可使图像信息更加明显和易于理解[8-11]。因此,如何融合这些域减少以上的影响是我们研究的主要问题。

红外图像的前景检测精度很高[4-5],背景减除结合多种融合策略检测提取前景目标是当前在红外图像中检测运动目标的主要方法[1-5],文献[3]利用无运动对象的初始帧的集合产生纯背景图像,并在此背景中检测运动前景目标,检测精度高,但不适合实际背景变化大的应用。通常视觉图像中背景信息的细节表达方面表现优良,但对目标信息的表达不够突出,运动前景检测的性能较差,精度很低。融合两个域图像的时候,由于结合了两个域的互补信息,召回率可大幅度提高,但精度(检测准确率)会下降,因为融合图像对比度较低。在文献[1]中,同时在两个域执行背景建模和前景预测,融合目标轮廓并迭代更新。在只使用红外图像时精确度和召回率较高,分别为0.939和0.645,仅使用可见光图像则分别是0.498和0.233。当融合这些领域时,相比只使用红外图像时精度跌至0.916,然而,召回率提高到0.722。这是由于背景杂波的干扰,导致融合图像对比度降低。很显然,融合的优点是增加了召回率,如果融合方法适当,这种增加相当可观。以上方法不能依靠单帧检测获得处理结果,而是通过多帧的处理或者在多模态图像序列中积累信息,需要处理的数据量大,不适于实时处理。

在本研究中,利用运动目标区域连通特性,有效地结合视觉和红外图像的互补灰度信息,充分利用可见光图像补充前景目标细节轮廓的功能,并辅助定位运动目标的检测,融合后召回率显著增加,同时精度不会下降。不需要对背景建模,单帧检测的效果也能达到实时处理要求。

1 极大稳定极值区域MSERs算法

Matas 等人[6]提出MSERs区域特征提取算法,所有像素的强度均小于或大于区域周围的像素值的区域为极大稳定极值区域。MSER算法使用BINSORT算法对像素灰度进行快速排序。从0~255,逐渐变化阈值大小,将像素强度小于阈值的像素点忽略不计,像素强度大于或者等于阈值的像素点记录下来,其中相邻接的点形成极值区域。使用Union-Find算法搜索极值区域,记录相连区域的列表和面积。在连续增加或者减小阈值过程中,经过好几个阈值变化而区域大小没有变化的极值区域就是最稳定极值区域MSERs。其中,BINSORT算法的复杂度为(),Union-Find算法的计算复杂度为(lg(lg())),为灰度值[8]。王永明以重复性和匹配分数两个指标对区域检测算子作了评估实验,实验证明,在区域检测算子中,MSER检测器最稳定,效果最理想[7],可以满足一些实时应用需求。

2 基于互补融合的行人检测系统

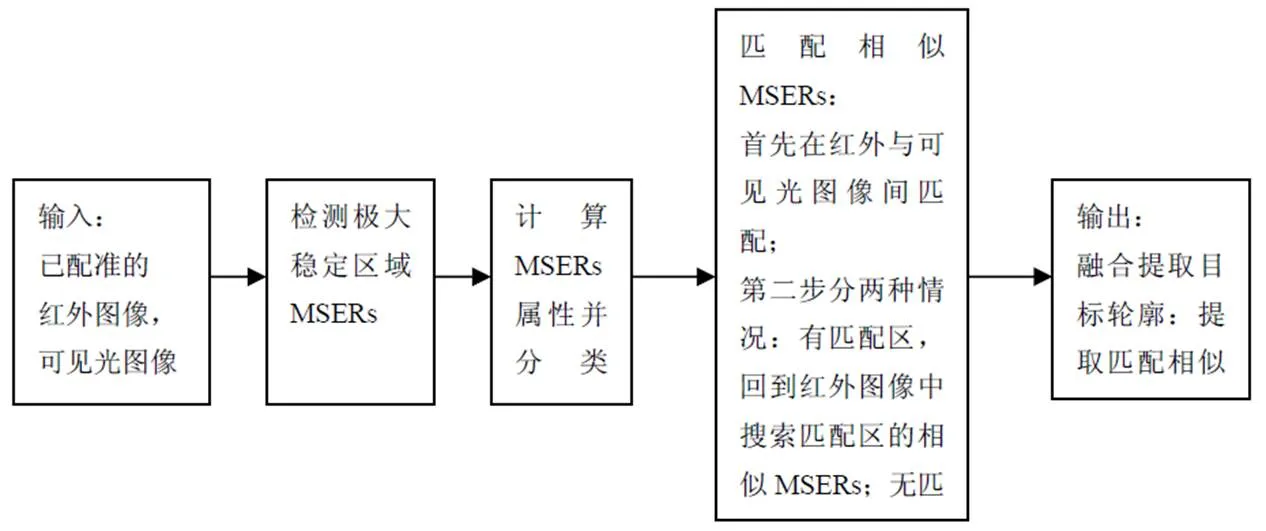

基于互补融合的行人检测系统框架构成如图1。

图1 算法流程

Fig.1 Procedure of proposed method

步骤如下:

输入:已配准的红外图像和可见光图像。

输出:融合检测的目标轮廓。

步骤1:在红外图像和可见光图像中检测极大稳定区域MSERs,并椭圆拟合检测到的MSERs区域,椭圆的中心c为MSERs的重心,反映MSERs的位置,椭圆的长轴方向代表MSERs区域的方向,结合长半轴和短半轴一起表示MSERs区域的形状。

步骤2:定义MSERs区域稠密度函数和前景目标所在的MSERs区域相似度函数。计算MSERs属性依据以上两个度量指标将MSERs分类。

步骤3:在红外与可见光图像间搜索匹配MSERs相似区域,可滤除背景物,筛出前景目标,补充在红外图像中未检测完整的前景目标区域;红外图像内的相似区域检测,可检测出在红外与可见光图像间搜索过程中产生的误滤除前景目标。

步骤4:可见光图像与红外图像匹配MSERs区域融合,融合规则基于两图像的灰度值。

2.1 检测拟合极大稳定区域MSERs

对MSERs区域拟合以便于描述区域特性。采用区域仿射不变椭圆拟合的方法计算MSER区域,椭圆能有效地反映区域的位置、尺寸和方向。椭圆的中心c为MSERs的重心,反映MSERs的位置,椭圆的两个轴为MSERs通过重心在长轴短轴方向分别达极值的二阶中心矩。椭圆的长轴方向代表MSERs区域的方向,结合长半轴和短半轴一起表示MSERs区域的形状。

2.2 计算拟合MSERs区域属性并分类

按像素亮度可划分MSERs为MSERs+和MSERs-[6-7]。因此在红外和可见光图像中,MSERs区域首先划分为两大类。在红外图像中,前景目标往往是较亮的区域。如果在某一个区域范围内检测到多个MSERs+或者MSERs-区域,那这个区域像素强度较周围区域区分度高。可定义前景目标所在的MSERs区域稠密度函数,满足稠密度条件的MSERs可作为我们的候选目标区域。需要检测的前景目标是现实世界的一类物体,有自身固有的特性,因此可定义前景目标所在的MSERs区域相似度函数。依据稠密度和相似度两个度量指标将MSERs+或者MSERs-再分类。

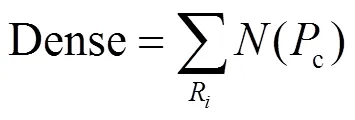

稠密度Dense:以MSERs区域R内包含质心c的个数来表征,定义如下:

相似度Similarity:以MSERs区域a、b拟合的椭圆形状相似度来表征,应用韦氏距离计算相似度[9]。k表示两区域a、b间参数的比率(参数可设定为椭圆两个半轴长、和扁率),定义如下:k=max{|a-b|/(+b),|a-b|/(+a)},=1, 2, 3,为避免分母为0,设置为1。

d=gmoid (k)=(1-exp(-k))/(1+exp(-k)),=1, 2, 3,则d∈[0, 1)。

Similarity值越接近1,两区域越相似。

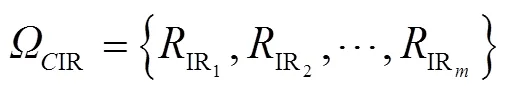

设定0为稠密度Dense阈值,相似度Similarity阈值为0,建立分类MSERs的稠密区域集合,={1,2,…,…,},表示包括类MSERs区域,Dense()≥0,Similarity()≥0。其中,={1,2,…,R}表示第类MSERs稠密区域的集合,包含个MSERs区域,记录MSERs区域质心位置、形状参数。

2.3 相似MSERs搜索

2.3.1 红外与可见光图像间区域匹配

2.3.2 红外与可见光图像内的相似区域检测

2)红外与可见光图像间不存在匹配MSERs区域(可见光图像中前景目标淹没于背景中),则在红外图像IR内检测所有MSERs类别IR,记录稠密度最高MaxDense(IR)且相似度最大MaxSimilarity(IR)的一类MSERs区域IR,标记此类MSERs集合的所有区域IR。红外图像内的相似区域检测可补充在两图间匹配区域过程中误剔除的前景目标区域。

2.4 融合提取目标

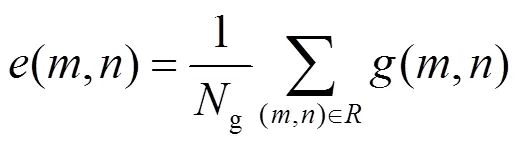

式中:g表示区域中像素点的个数,(,)是区域内像素点对应的灰度值。最终融合匹配MSERs区域后的目标区域F表示如下:

式中:IR(,)表示在红外图像中匹配的MSERs区域,V(,)表示在可见光图像中匹配的MSERs区域。两图间无匹配MSERs区域时,或者IR(,)属于一类MSERs区域IR,则直接获取红外图像中标记的MSERs区域IR(,)输出。

3 实验结果

我们提出的方法框架是,首先,分别提取两个域的MSERs。在来自两个域的显著构造中提取特征。然后融合两个域的映射信息自适应定位前景区域,将背景MSERs区域从提取的MSERs中清除。完成了前景定位之后,它被用来提取来自两个域的前景轮廓。当光环效应越明显时,所提出的方法对轮廓提取更好。可立即获得轮廓信息,需要执行任何进一步的后处理,例如清除错误的轮廓或将丢失轮廓部分补充完整。

如图2,第一行左图为红外图像的MSERs检测图,第一行右图为可见光图像的MSERs检测图,第二行左图为红外图像的稠密MSERs检测图,第二行右图为可见光图像的匹配相似MSERs检测图。

第一行左图红外图像中满足稠密度和相似度的密集MSERs区域为7个,在第二行左图中用文字标出7个区域为1,2,3,4,5,6,7。经过2.3节步骤,在红外和可见光图像中搜索相似MSERs的操作中,在可见光图像中检测这7个MSERs区域的匹配区域,得到3个MSERs区域,标注为~4,~6,~7,其分别与4,6,7匹配,因此4,6,7作为检测到的匹配相似区域保留,而1,2,3,5被滤除,其中5是需要的前景目标,但遭到误滤除。接着执行2.4节的步骤,在红外图像内检测相似区域的操作后,5作为4,6,7的相似区域可以被准确检测出来。至此,所有的行人目标被准确检测得出。

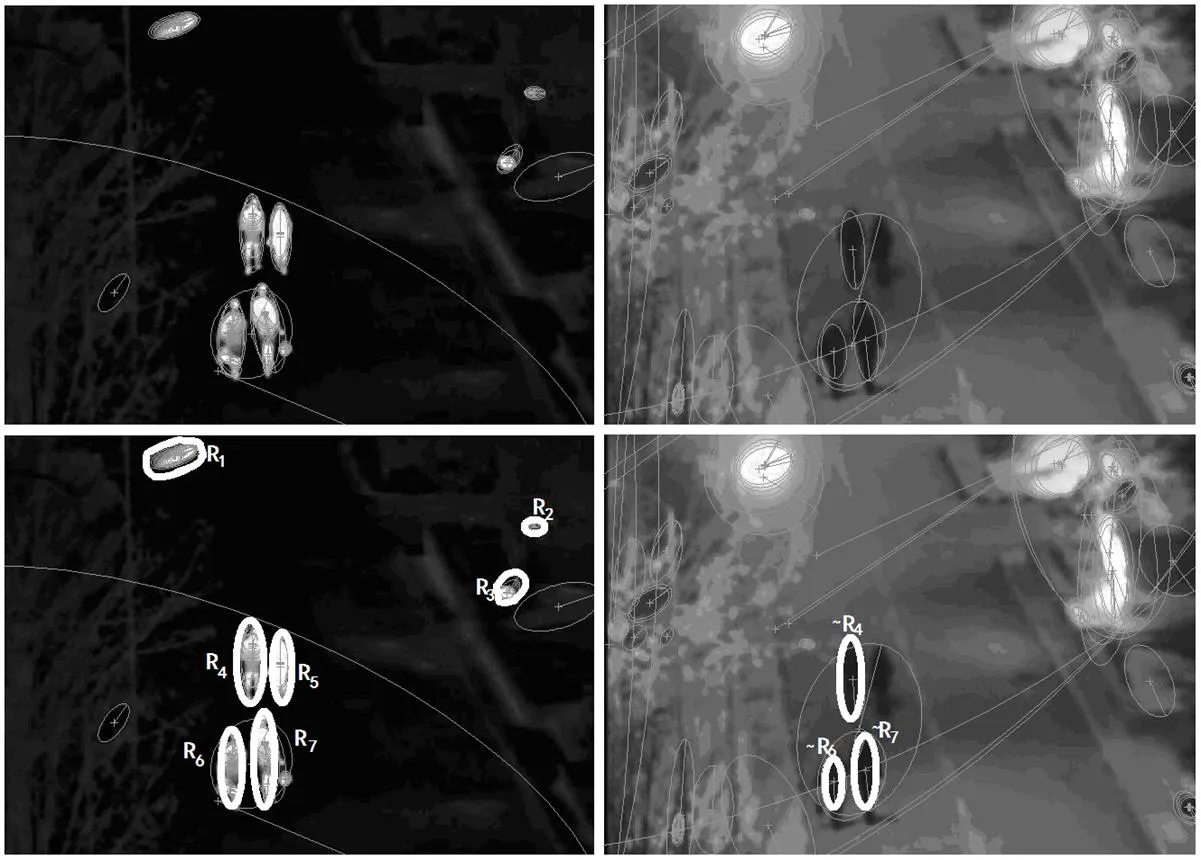

图3中(a),(b),(c),(d)中第一列为文献[1]创建的数据集图像,其中第一行为可见光图像,第二行为红外图像。

第二列为本文方法提取的行人轮廓,其中第一行为单独使用可见光图像的行人轮廓,第二行为融合的行人轮廓。

第三列为文献[1]提取的行人轮廓,其中第一行为单独使用可见光图像的行人轮廓,第二行为融合的行人轮廓。

图2 融合检测的过程

Fig.2 Comparision detecting procedure

图3 在文献[1]创建的数据集中融合检测的行人轮廓结果图

图3给出了应用我们的方法与文献[1]方法的目标检测结果比较图。图3(a)为在文献[1]创建的数据第2段视频的第973帧图像,图3(b)为在文献[1]创建的数据第4段视频的第1834帧图像,图3(c)为在文献[1]创建的数据第6段视频的第1857帧图像,图3(d)为OSU第3段视频的第1326帧图像。我们的方法得出的行人轮廓与文献[1]的比较,轮廓较完整准确,少噪声污染。我们检测提取的结果判别性强,如果被用于进一步的研究比如行人行为的分类和识别,将保障这些研究性能的提升。

我们的方法被应用到OSU数据库中,其结果在表1中列出,并与Ulusoy[1]和Davis[2]在相同的数据集给出的结果相比。表1给出对应于我们所提出的方法的准确率和召回率,和文献[1]、文献[2],以及文献[2]中只有红外域被使用的方法的准确率和召回率。在所有OSU数据库的视频序列检测结果中,我们的方法的召回率数值较高,精度也较高。其他文献的融合方法增加了召回率,但精度总是小于只使用红外线数据时,这是原有融合研究算法的预期结果。我们创建的方法在提高召回率的同时,精度基本没有降低,这意味着我们检测到的像素更多的是实际物体的像素。

4 算法复杂度分析

可见光与红外图像尺寸一致,均设为一个×维矩阵,其中与分别表示图像的高和宽,算法中第一步检测拟合极大稳定区域MSERs执行像素点排序和极值区域的提取,复杂度为()和(lg(lg()))。第二步计算拟合MSERs区域属性并分类,执行稠密度Dense和相似度Similarity计算,复杂度不超过第一步的复杂度。第三和第四步搜索相似MSERs和融合提取目标,执行少于次的比较就可以计算出,复杂度可以忽略。因此,本文算法的时间复杂度为4×()。文献[1]需执行背景建模与减除,算法复杂度约为“2×()+6×()+()”,其中、为图像尺寸,、为滤波处理核的大小。由于本文算法不需要对背景建模,可显著提高计算效率。

5 结束语

针对同一场景红外与可见光图像间前景目标的融合特征难以完全提取和正确提取的问题,提出了基于红外与可见光图像互补信息的融合特征提取以及检测行人的方法。该方法主要包括4个步骤:①提取红外与可见光图像中的极大稳定区域(MSERs);②对特征区域进行属性计算并分类MSERs;③匹配相似极大稳定区域(MSERs);④定位前景目标区域,输出检测目标。

图2与图3实例表明,当一个物体的温度是类似的周围区域中,从红外图像中检测某类对象变得越来越困难。在这些情况下,如果对象和背景的颜色是不相似的,则可见光图像是可用的,可见光谱图像可以提供许多线索,用来辅助定位对象以及完成缺失对象的部分。如图2第二行左图,在红外图像中6不包含行人的腰腹部,图2第二行右图,在可见光图像中6包含行人的完整轮廓,因为行人像素与背景道路像素相比明显不同。

表1 在OSU数据库获得的召回率和精度

本文提出的方法只应用于人体检测,在此仅提供行人数据集。由于这种方法未设定任何特定的参数以检测人体,因此,它可以应用到检测其他的对象。我们的方法不需要尝试许多预处理例如背景估计与建模,单帧图像即可检测运动目标,因而它在计算上更高效。在未来,该方法可被应用于检测和识别各类事物,比如进行人体行为识别。

[1] Ulusoy I. New method for the fusion of complementary information from infrared and visual images for object detection[J], 2011, 5(1): 36-48.

[2] Davis J, Sharma V. Background-subtraction using contour-based fusion of infrared and visible imagery[J], 2007, 106(2-3): 162-182.

[3] Aparna Akula. Adaptive contour-based statistical background subtraction method for moving target detection in infrared video sequences[J], 2014, 63: 103-109.

[4] 陈钱. 红外图像处理技术现状及发展趋势[J]. 红外技术, 2013, 35(6): 311-318.

CHEN Qian. The Status and development trend of infrared image processing technology [J]., 2013, 35(6): 311-318.

[5] 王宇庆, 王索建. 红外与可见光融合图像的质量评价[J]. 中国光学, 2014, 7(3): 396-401.

WANG Yu-qing, WANG Suo-jian. Quality assessment method of IR and visible fusion image[J]., 2014, 7(3): 396-401.

[6] 杨扬, 戴明, 周箩鱼. 基于NSUDCT的红外与可见光图像融合[J]. 红外与激光工程, 2014, 43(3): 961-966.

Yang Yang, Dai Ming, Zhou Luoyu. Fusion of infrared and visible images based on NSUDCT[J]., 2014, 43(3): 961-966.

[7] 王永明, 王贵锦. 图像局部不变性特征与描述[M]. 北京: 国防工业出版社, 2010: 173-178.

Wang Yongming, Wang Gui Jing.[M]. Beijing: National Defend Industy Press, 2010: 173-178.

[8] 廉蔺, 李国辉, 王海涛, 等. 基于MSER的红外与可见光图像关联特征提取算法[J]. 电子与信息学报,2011, 33(7): 1625-1631.

Lian Lin, Li Guohui, Wang Haitao, et al. Corresponding feature extraction algorithm between infrared and visible images using MSER[J]., 2011, 33(7): 1625-1631.

[9] 郭永彩, 谭勇, 高潮. 基于水平集的热红外运动人体目标分割算法[J].红外与毫米波学报, 2014, 33(1): 106-116.

GUO Yongcai, TAN Yong, Gao Cha. Level set based segmentation of moving humans in thermal infrared sequences[J]., 2014, 33(1):106-116.

[10] Chen Jie, Zhao Guoying, Mikko Salo, et al. Automatic dynamic texture segmentation using local descriptors and optical flow[J]., 2013, 22(1): 326-339.

[11] Suman Tewary. Hybrid multi-resolution detection of moving targets in infrared imagery[J], 2014, 63: 173-183.

Fusion of Complementary Information from Infrared and Visual Images for Moving Object Detection

YE Hua1,2,ZHU Ming-han1,WANG Ri-xing1

(1.,415000,;2.,,418300,)

Visual and infrared cameras have complementary characteristics, and the detection performance can be improved by fusing visible and infrared images. The fusion of visible and infrared images can improve recall rate, which means more foreground pixels are correctly detected. But the existing fusion methods always lead accuracy dropped. A method extracting information about the two complementary fused domains to detect pedestrians is proposed: ①Extract foreground features firstly: extract Maximally Stable Extremal Regions(MSERs) from visible and infrared images, calculate dense degree and similarity characteristics of MSERs in the infrared image, and then classify MSERs based on these features. ②Locate foreground targets: search all categories of MSERs in the infrared images to match visible images, and extract similar matched MSERs areas in which include pedestrian contour. ③Merge and output pedestrian contours extracted from similar match MSERs areas. The fusion of infrared and visible information can effectively filter out the background object, locate the foreground objects and replenish the missing part of the foreground object extracted only in infrared images. The method proposed has been tested in a common database and compared with the early fusion methods, which can improve the recall rate, does not drop the precision rate after the fusion, and no need for background modeling. It also can compute more efficiently and easier than previous calculations.

maximally stable extremal regions(MSERs),fuse complementary information,assisted positioning,pedestrian detection

TP29

A

1001-8891(2015)08-0648-07

2014-10-10;

2015-01-18 .

叶华(1977-),女(汉),湖南省常德市人,讲师,博士研究生,主要研究方向为基于视觉认知的人体行为识别、红外图像中人体目标分割。E-mail:yehuawuhan@163.com。

国家自然科学基金,编号:11347132。