3D视频系统的研究与发展

李春华,付 丽

(河北科技大学信息科学与工程学院,河北石家庄 050018)

1 研究背景

视频处理、传输与显示技术经历了从黑白到彩色,从模拟到数字,从标清到高清的历次变革之后,正在向三维视频 (three-dimensional video,3DV)系统演进[1]。3DV系统将视觉感知扩展到第三维场景深度,藉此增强视觉逼真感,使观众体验到身临其境的沉浸感[2]。以《阿凡达》为代表的立体电影的巨大成功预示着3DV技术大众化应用的广阔前景,3DV将通过3D蓝光DVD、Internet和3D广播等传播方式进入家庭。

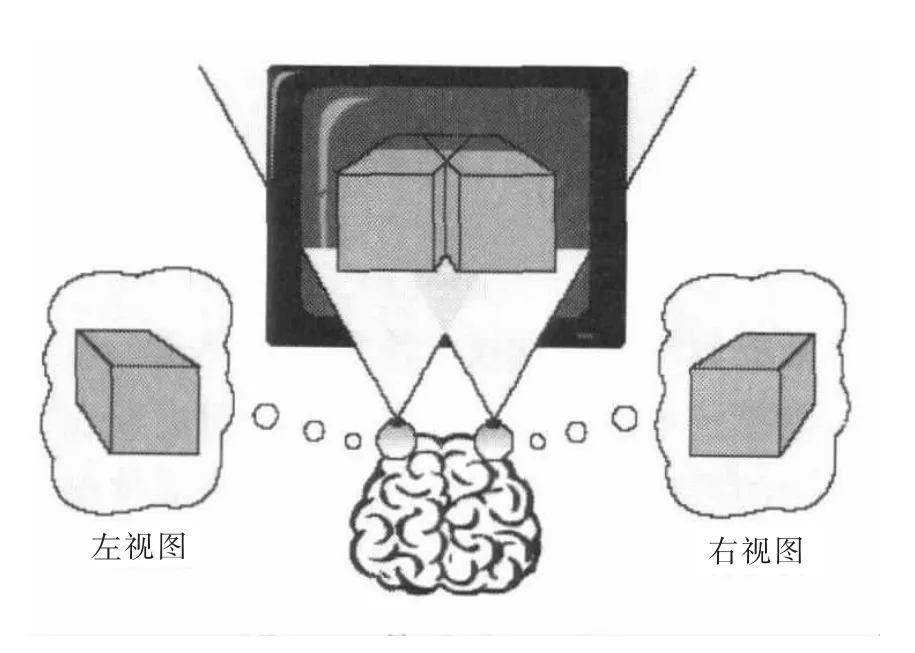

三维视频是一种具有提供感知三维场景深度功能的视频媒体形式。人类基于“视差创造立体”的原理感知自然深度[3],两只眼睛从稍有不同的角度看到的物体存在细微差别,大脑融合双眼立体图像对产生立体视觉感知,如图1所示。用2个间隔视距的摄像机拍摄同一场景,就可以将这一生理过程仿生实现。每个摄像机捕获到与人眼位置相对应的视场景,如果显示系统能够保证每只眼睛只看到对应的视,就可以刺激人眼产生深度视错觉,形成立体视感。

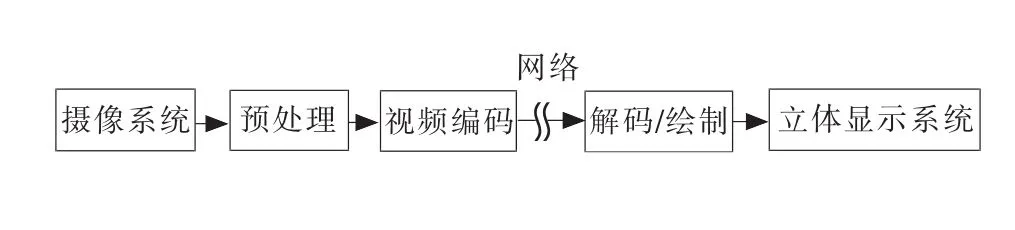

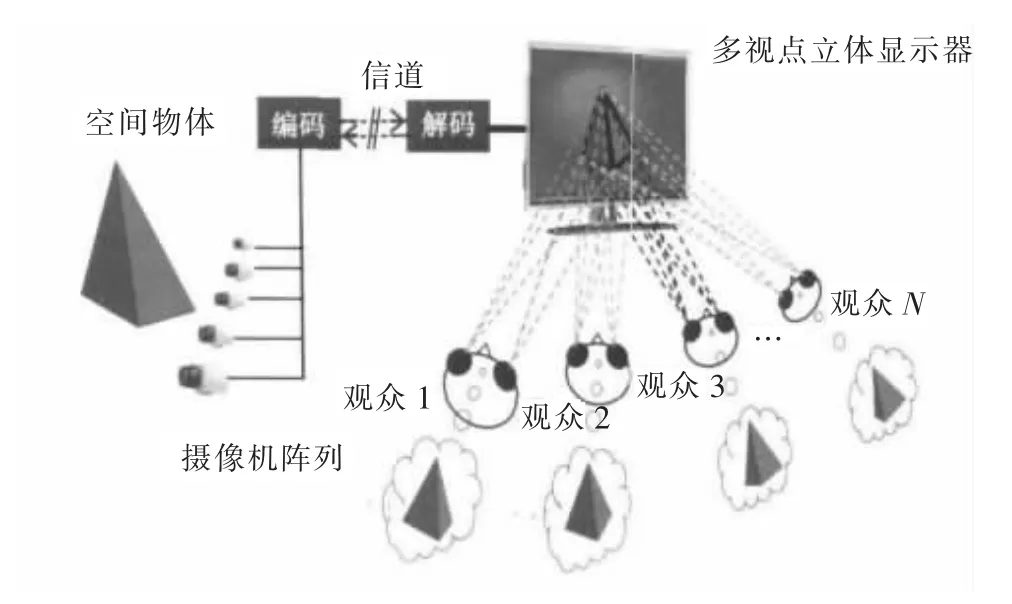

在摄像机和显示器之间加入传输处理、编码解码和虚拟绘制等环节,就构成了三维视频系统,如图2所示。

2 3DV研究发展

图1 视差创造立体原理Fig.1 Principle of disparity creating stereo vision

图2 三维视频系统Fig.2 Three-dimension video system

早在黑白电视时代,人们就开始了立体视频的探索研究,如双信道偏光分像立体电视技术。它用2个摄像机同步拍摄左右视视频,借助2个独立的信道进行视频传输。电视机屏幕左右2部分分别安装极化方向正交的偏光板,用正交偏振光区分显示左右视视频。观众佩戴偏光眼镜欣赏立体电视节目。偏光眼镜能够滤除与其正交的偏振光承载的另一视的视频,使每只眼睛只能看到单一的视频,进而刺激大脑产生立体感觉。这种立体视频系统存在的问题是当头部微斜时,偏振眼镜无法完全滤掉与之正交的偏振光,导致一只眼睛可以看到另一只眼睛的影像,使人产生眩晕感。20世纪50年代,随着彩色电视技术日渐成熟,立体视频开始采用“互补分色立体电视技术”。它在拍摄同一场景的2部摄像机镜头前端加装滤光镜,使拍摄的左右视视频在色度上相互区分。显示时,在彩色电视机的屏幕上把左右视视频叠加播放,观众佩戴滤光眼镜欣赏立体电视节目。它的优点是与二维电视机具有良好的兼容性,但是存在的问题也不少,如:彩色信息损失大、“串色”现象干扰严重、左右眼的入射光谱不一致引发视觉疲劳等。后来出现了快门眼镜和头盔显示器。快门眼镜三维视频系统用固定的场频控制显示器和液晶眼镜协调工作,左、右两视交替送入左右眼,让大脑误认为双眼同时观看影像。快门系统要求显示器具有较高的刷新频率,否则会产生闪烁感。头盔显示器将人对外界的视觉、听觉封闭起来,用2个平面显示器分别为左、右呈现具有双目视差的不同图像。这种方式只能让一个观众观赏,立体视角小,影响观看自由度,而且价格昂贵、设备质量较大。

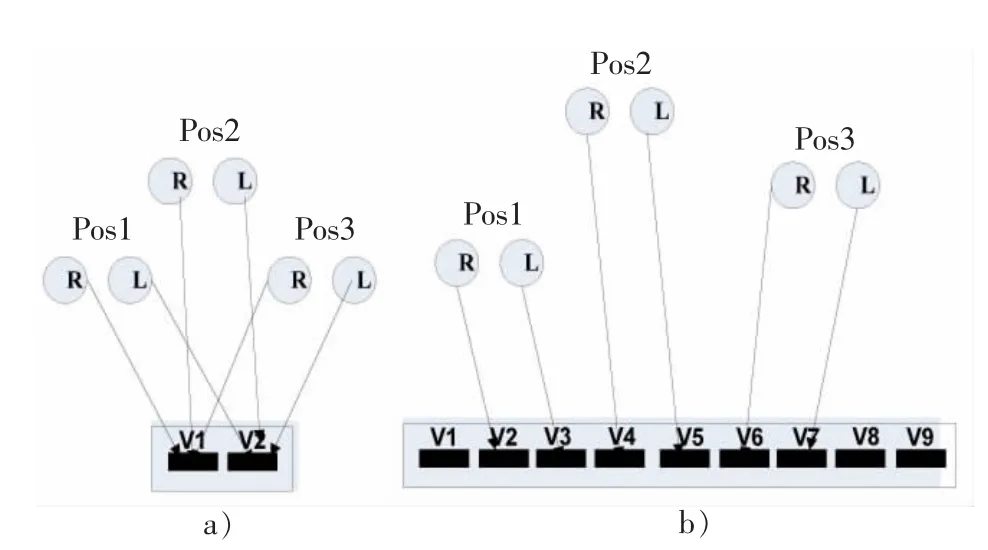

佩戴各类立体眼镜观看立体视频图像的方式会降低图像亮度,容易产生疲劳感和不适感,立体视频系统的推广应用受到严重制约。于是,人们开始转向追求一种直接由裸眼观赏立体影视的方式,三维立体电视(3DTV)应运而生。3DTV采用自由立体显示器,它通过改造屏幕将两眼的可视画面交错分离,观众不需要佩戴任何辅助工具就可以直接观看显示器播放的立体视频。双视的立体视频系统只呈现给观众一个观看视向,观众在不同位置所观看到的立体场景是相同的,如图3a)所示。双视的裸眼立体显示器存在立体视角窄,不适合多人同时观看的缺点。后来又出现了适合多用户同时观看的多视视频/自由视频立体视频系统,如图3b)所示。

图3 立体视频观看方式Fig.3 Stereoscopic video viewing mode

如图4所示,在多视点立体显示器上显示多视视频,显示器同时显示多个立体视频对,向观众提供多个观看视向,用户在不同位置能看到相应的立体视频对。多视视频系统扩展了观众欣赏立体视频的视角范围,而且居于不同位置的观众可以从不同视角观看视频中的场景。与人眼跟踪技术配合,它还可以实现景随人动的临场效果[4]。

图4 多视点立体显示器Fig.4 Multiview stereoscopic display

在多视视频系统基础上发展起来的自由视点电视系统(FTV,free-viewpoint TV system),能够通过虚拟视点绘制技术来生成真实摄像机之间任意视角的画面,观赏视角更大,立体感更为真实,被认为是未来3DTV技术的发展方向[5]。

国内外对于自由视点视频的研究从20世纪90年代已经开始,但真正形成气候的是2002年MPEG组织提出了“3DAV意向征集”,向全世界征集实现3DAV的方案及核心实验[6-9]。按照MPEG组织的进程安排,自由视点视频分为2个阶段进行,其中第1个阶段是多视点视频编解码,第2阶段则是自由视点生成和自由视点视频的标准化,近10年的研究进程如图5所示。2006年之后,MPEG明显加快了3DAV的步伐。ISO/IEC MPEG和ITUTVCEG联合组成的JVT(joint video team)小组也将多视点视频编码MVC作为其H.264的一部分,此后推出的多视点视频编解码参考软件JMVC(joint multi-view video coding),进一步的标准化草案亦已于2009年基本完成[10],并将研究的重点开始转移到自由视点视频。

图5 自由视点视频标准化进程时间表Fig.5 Free viewpoint video standardization process timetable

2010年,3D成为各彩电厂商的主打卖点之一,包括三星、LG、索尼、夏普等外资品牌,以及创维、长虹、康佳、海尔、TCL等民族品牌均发布了具备3D功能的电视新品。甚至连为平板电视输送视频信号的蓝光碟机、游戏机、高清播放机等产品均相继配备了3D播放功能。目前,欧美日韩等国已经开始进行3D试广播,包括2010年法国网球公开赛、FIFA世界杯等重大体育赛事也选取了部分场次进行3D转播。真正开播3D电视频道必须有相应的广播标准。目前各国都在研发相应的标准,尚未形成统一的播出标准。就中国而言,眼下已经在部分地区展开3D电视节目的播出试点。因此,加强3D内容建设,加快相关标准制定的步伐将有利于推动3DV系统应用普及。

3 3DV系统

3DV系统由3D内容获取、编码、传输、解码合成和显示5部分组成,如图6所示[1]。按照3D视频获取方法的不同,分为双目3DV系统、多视3DV系统和2D转3D系统。

1)基于双目的3DV系统

双目3DV系统是传统的立体视频系统,由光轴相距视距(65mm)的2个平行摄像机获取左、右视视频,经立体视频压缩编码后传输到接收端,解码复原后送入立体显示器上显示。

2)基于多视的3DV系统

多视3DV系统用N个(N>3)摄像机组成的摄像机阵列同步拍摄3D场景,对获取的视频先进性进行多视视频校正和亮度/色度补偿等预处理后,再进行多视视频压缩编码传送到接收端。

3)2D转3D的3DV系统

由于目前直接拍摄3D节目成本较高,3D节目来源的另一重要途径是将2D高清晰度视频节目通过2D转3D处理和后期制作形成多视视频。

由于目前所有的家庭几乎都已有了播放二维视频图像的电视机,未来的双目或多视立体视频系统应特别强调后向兼容性。鉴于此,在立体视频和多视视频编码中,基本视(双目视频或多视视频中作为参考视的1个视)都建议沿用二维视频的编码标准(如H.264/AVC),提供给标准的2D显示器播放。这样接收二维视频图像的电视机虽然无法播放立体视频,但是能够正常接收立体视频信号,将其中的基本视视频当做二维视频播放。

图6 3DV系统构成Fig.6 3DV system components

4 3D视频技术链分析

4.1 获取

目前大多数的3D广播系统采用双视立体电视系统,3D场景的拍摄一般会采用双摄像机(stereo camera),分别拍摄左眼和右眼视频,拍摄的同时还需记录摄像机参数。在后期制作借助这些参数来改变3D图像的水平视差,调整场景空间深度。这种双摄像机有两种类型,一种是平行摄像机,2个摄像机的镜头光轴相互平行;另一种是会聚摄像机,2个摄像机镜头光轴成内八字形,交会到前方某一点。虽然使用会聚摄像机更符合实际情况,但是它会造成垂直视差,引起观众的不适感,还会引入深度平面弯曲(depth plane curvature)和梯形失真(keystone distortion)[11]。在实际操作时,为了有效避免几何畸变,大多选用平行摄像机。必须使用会聚摄像机时,应将会聚角度尽可能调小,否则,就需要进行几何校正。

还有一种3D摄像机,如3DV研发的zcam摄像机,在拍摄记录RGB视频的同时,记录下画面相应的深度信息。在显示之前,用这路RGB图像与深度信息绘制重构出左眼视觉画面和右眼视觉画面。这种拍摄方法的缺点是遮挡部分的图像无法正确重构,显示立体画面存在失真现象。

对于多视3DV系统,拍摄手法可以分为静态场景拍摄和动态场景拍摄。静态场景拍摄时,可以用一台摄像机按照预定路径拍摄整个场景的多个画面。然后根据摄像机拍摄的位置和几何信息对获取的图像进行综合,最终得到立体图像。动态场景拍摄时,多采用摄像机阵列,用多个摄像机同步拍摄。为了便于后期多视视频校正处理,需要预先对摄像机进行标定[12]。

4.2 3D视频后处理

1838年,WHEATSTONE发明了立体镜,揭开了视差引起立体视的奥秘[3]。人眼通过实体镜观看2个略有差别的2D图像,产生立体感。1960年JULESZ用计算机设计了随机点立体图对(random dot stereo grams,RDS),发现仅仅视差没有单眼线索也能引起立体感,证实立体视觉发生是在形状识别之前,在视觉信息加工机制研究中产生了突破性进展[13]。1982年 MARR依据 WHEATSTONE的视差原理提出了视觉的3D重建理论,将视觉看作是一种能够用计算机进行信息处理的过程。他证实只要找出立体图对中两图的对应点,测出它们的视差,就可以求出深度,用计算的方法重建该物体,使立体视觉研究上升到从未有过的高度[14]。根据MARR重建理论,拍摄时视差与深度满足如下关系:d=B×f/z,z为深度,f为焦距,B为摄像机基线。显示时,感知深度z′与显示视差d′满足如下关系:z′=r×d′/(e-d),r是观看距离,e为双目视差。

虽然立体的基本原理相当简单,但是不适当的立体很容易造成坏的用户体验,这是因为来自3D显示的深度印象是人类视觉系统的一种虚构。因此,3D内容的制作是一项需要考虑感觉、显示性能,以及心理因素的复杂综合技术。通过后期制作把采集的3D视频转换成与特定应用场合要求相符的数据表达形式。

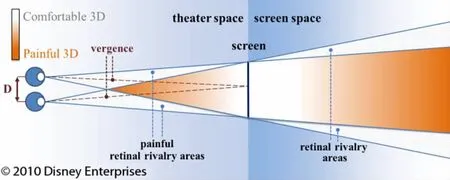

为了让观众舒适地观看3D内容,必须保证立体场景位于人眼立体舒适感知区域内。人眼立体感知舒适度视域分布如图7所示。人眼观赏图中的亮区域中的3D景物,感觉很舒适。而图中较暗区域中的3D景物则会引发双目竞争、重影等不舒服的体验。例如,强调鬼影等重叠场景时使用近处的双目竞争区;表现下雨等快速下落的物体时使用远处的双目竞争区;让物体远离屏幕以制造引人入胜的效果时使用大深度。

相比于实际的3D世界,显示3D内容应严格限制可用的深度量。通常,导演很少使用深度全范围。即使在使用全深度展示令人震撼场景时,也会在深度受限期间给观众留出充足的时间来松弛视觉系统。因此,深度估算和过渡设计是3D制作期间需要缜密计划的工作。

图7 人眼立体感知舒适度视域分布Fig.7 Illustration of the stereoscopic comfort zone

立体摄影的任务是将整个真实的世界代入成为舒适区域的虚拟空间之内。欲达到此目的,需要调节摄像机基线和会聚参数。摄像机基线控制总体深度范围或视差的大小,即物体的深度容量;会聚控制绝对视差,即相对于屏幕的物体位置。会聚控制可以通过移动彼此相关的视来实现。通常用平行摄像机完成摄制,在后期制作中加上所希望的会聚。但是只改变深度,而不改变物体的水平和垂直尺寸,会产生所谓的“大小效应”,影响人对物体大小的感知。这样,实际应用中会聚量调整受到限制。进一步讲,过大的未按比例缩放的视差位移,可能造成超过的视差范围,产生迫使眼睛发散等不舒适的感觉。因此,除场景深度过渡通常采用重会聚方式实现外,诸如聚焦平面和视差范围调整都借助调整基线参数实现。

当观看条件,如屏幕尺寸和观看距离等要素发生变化时,必须变更内容的表示,对视差范围进行调整。观看距离增大时,深度延伸感随之增强,但是屏幕上水平和垂直延伸量保持不变。此时,可根据屏幕尺寸和观看距离使用虚拟视内插重新绘制3D场景,使3D印象自适应于观看距离。拍摄真实立体内容的情况下,立体摄像机的基线在数据采集时就确定下来,后期制作中无法真实改变,只能通过虚拟视内插来调整基线,并由此实现深度的变化。

4.3 编码

三维视频的表示格式分为2大类:纯视频格式和深度增强格式。纯视频格式只包括摄像机阵列拍摄的多视纹理视频。深度增强格式不仅包括摄像机阵列拍摄的多视纹理视频,还包括与之对应的深度视频。这两类三维视频由于具有不同的特点而采用不同的编码方法。

4.3.1 纯视频格式三维视频编码方法

最早的纯视频格式三维视频方法是Simulcast方法,它针对双通道立体视频编码提出,采用对左右视的视频独立压缩编码,视间相关性没有得到利用,因此编码效率较低[15]。之后,MPEG-2Multiview Profile针对这一问题作出改进,综合利用视间交叉相关性和视内部的时空相关性来提高立体视频编码效率[16-17]。近来,H.264/AVC中又增加了立体补充增强信息(Stereo supplemental enhancement information,Stereo SEI)和帧组合补充增强信息(frame packing arrangement SEI)[18]。根据 Stereo SEI,在编码前将左右视视频交错排列,然后采用场间预测技术来消除视间冗余,在解码端通过反交错还原立体视频。它的好处在于与H.264编解码器兼容,使用时无需改变编码器硬件结构。2009年7月,国际运动图像专家组(moving picture expert group,MPEG)又颁布了 MPEG-4AVC Stereo High Profile[19],提高逐行和隔行扫描的双通道立体视频编码效率。

为了最大限度地提高多视点视频的压缩率,2009年1月,国际联合视频小组(joint video team,JVT)发布了MVC标准[20],采用基于分层B帧(hierarchical B pictures,HBP)的视间-时间金字塔型预测结构进一步降低码流速率[21-23]。2009年12月推出的三维立体视频蓝光碟就是采用MVC标准来进行编码的。MVC标准定义的多视点视频编码方式,支持随机访问功能,在目前来讲,编码效率最高。同时,它保证了H.264/AVC的后向兼容性,多视视频的基本视(主视)采用与H.264/AVC单路视频相同的编码结构和方式。

由于纯视频格式每个视点都是由固定位置的摄像机拍摄获得的,场景的深度信息不能根据显示设备的类型和尺寸来调整,三维视频的景深效果不具备尺度伸缩性。并且,由于解码端输出的视点数量有限,它无法提供自由视点视频的“环视”效果[10]。为了使用数目较少的视,实现3D环视效果,必须采用新型高效的3D视频数据格式。

4.3.2 深度增强格式三维视频编码方法

深度增强格式三维视频由多视纹理视频和多视深度视频组成。所谓深度视频即为深度图序列,深度图是一个与纹理图像大小相同的灰度图像,其像素值表示像素点对应的景物距离摄像机的远近。深度增强格式中的视频视数一般少于纯视频格式中的视频视数,在解码端利用视点合成技术生成所需要显示的虚拟视点[24]。深度增强三维视频形式多样,如单路视频及其深度序列、多视点视频及其深度序列,以及分层深度视频等[25-26]。采用深度增强三维视频格式,只需要传输有限个角度的单目视频及其深度序列,就能获得扩展性非常强的三维立体显示效果,关键技术是高效的深度估计和视点合成[27-29]。深度序列可以由深度摄像机直接获取或采用深度估计算法得到[30],解码器根据不同显示设备的参数和用户的观看需求对视频进行解码及视点合成等后处理[31-34]。

目前,支持立体显示的深度增强三维视频种类繁多,没有统一的国际标准。为了适应不同类型不同尺寸的立体显示设备(如电影院、家用电视、移动设备等)[35],有必要确定一种国际通用的深度增强三维视频格式,使其支持高质量的自由视点视频应用,适应多种观看方式(如二维高清电视、立体显示效果、自由视点电视等)。MPEG专门为三维视频编码技术研究发布了一系列测试序列,并于2011年4月发布了国际三维视频标准(3DV/FTV)的提案[36],面向全球各大科研机构征集三维视频编码技术的实现方案。

5 结 论

正如2D电视经历了黑白电视/彩色电视/数字电视/高清电视这4个从初级到高级的发展阶段一样,3DTV也将会经历双目戴立体眼镜观看/双目裸眼观看/多视裸眼观看/多视加深度裸眼观看等阶段。虽然目前国外已开播、国内试播的双目戴立体眼镜的3DTV,这只是3DV系统发展的初级阶段,发展到真正满足临场感需求的高级3DV系统阶段,预计还需经过10~20年的历程。

/References:

[1]张兆杨,安 平,张之江,等.二维和三维视频处理及立体显示技术[M].北京:科学出版社,2010.ZHANG Zhaoyang,AN Ping,ZHANG Zhijiang,et al.2Dand 3DVideo Processing and Three-Dimensional Display Technology[M].Beijing:Science Press,2010.

[2]BENZIE P,WASTON J,SURMAN P,et al.A survey of 3DTV displays,techniques and technologies[J].IEEE Transactions on Circuits and Systems for Video Technology,2007,17(11):1 647-1 658.

[3]WHEATSTONE C.On some remarkable,and hitherto unobserved,phenomena of binocular vision[J].Philosoph Transactions,1838,128:371-394.

[4]FUSIELLO A,TRUCCO E,VERRI A.A compact algorithm for rectification of stereo pairs[J].Machine Vision and Applications,2000(12):16-22.

[5]汪 洋,王元庆.多用户自由立体显示技术[J].液晶与显示,2009,24(3):434-437.WANG Yang,WANG Yuanqing.Auto-stereoscopic display for multi-users[J].Chinese Journal of Liquid and Display,2009,24(3):434-437.

[6]ISO/IEC JTC1/SC29/WG11,N5169:Description of Exploration Experiments in 3DAV[S].

[7]ISO/IEC JTC1/SC29/WG11,N5558:Report on Status of 3DAV Exploration Pattaya[S].

[8]ISO/IEC JTC1/SC291WG11,N5678:Report on 3DAV Exploration Trondheim Norway[S].

[9]ISO/IEC JTC1/SC29/WG11,N6051:Call for Comments on 3DAV[S].

[10]TANIMOTO M.Overview of FTV (free-virepoint television)[J].Journal of Physics,2010,206(1):115-128.

[11]WOODS A,DOCHERTY T,KOCH R.Image Distortions in Stereoscopic Video Systems[EB/OL].http://www.andrewwoods3d.com/spie93pa.html,2010-09-13.

[12]ZHANG C,CHEN T.A self-reconfigurable camera array[A].SIGGRAPH'04ACM SIGGRAPH[C].New York:ACM,2004.151-162.

[13]JULESZ B.Stereoscopic vision[J].Vision Res,1986(26):1 601-1 612.

[14]MARR D.Vision a Computational Investigation into the Human Representation and Processing of Visual Information[M].San Francisco:W H Freman and Company,1982.

[15]MERKLE P,SMOLIC A,MULLER K,et al.Efficient prediction structures for multiview video coding[J].IEEE Transactions on Circuits and Systems for Video Technology,2007,17(11):1 461-1 473.

[16]ISO/IEC JTC1/SC29/WG11,N1366:MPEG-2Multiview Profile[S].

[17]邓智玭,贾克斌,陈锐霖,等.面向立体视频的视差-运动同步联立预测算法[J].计算机辅助设计与图形学学报,2010,22(10):1 710-1 714.DENG Zhipin,JIA Kebin,CHEN Ruilin,et al.A simultaneous motion and disparity estimation for stereoscopic video coding[J].Journal of Computer Aided Design and Computer Graphics,2010,22(10):1 710-1 714.

[18]SMOLIC A,MULLER K,MERKLE P,et al.An overview of available and emerging 3Dvideo formats and depth enhanced stereo as efficient generic solution[A].Proceedings of the 27thConference on Picture Coding Symposium Piscataway[C].NJ:IEEE,2009.389-392.

[19]LIM C S,WITTMANN S,NISHI T.JVT-AE020,Conformance Bitstream Descriptions for Stereo High[R].London:JVT,2009.

[20]SULLIVAN G J,WIEGAND T,SCHWARZ H.JVT-AD007:Editors'draft revision to ITU-T H.264|ISO/IEC 14496-10advanced video coding in preparation for ITU-TSG 16AAP Consent(in integrated form)[R].Geneva:JVT,2009.

[21]刘 超,马力妮,宋雄亮.基于H.264标准的多视点视频编码方案的研究[J].计算机工程与设计,2010,31(3):564-567.LIU Chao,MA Lini,SONG Xiongliang.Researched on multi-view video coding scheme based on H.264standard[J].Computer Engineering and Design,2010,31(3):564-567.

[22]彭宗举,蒋刚毅,郁 梅.基于动态多阈值的多视点视频编码宏块模式快速选择算法[J].电路与系统学报,2009,14(2):111-117.PENG Zongju,JIANG Gangyi,YU Mei.A fast macroblock mode selection algorithm based on dynamic multi-threshold for multiview video coding[J].Journal of Circle and System,2009,14(2):111-117.

[23]DENG Z P,CHAN Y L,JIA K B,et al.Fast iterative motion and disparity estimation algorithm for multiview video coding[A].The True Vision-Capture,Transmission and Display of 3DVideo[C].[S.l.]:[s.n.],2010.1-4.

[24]ISO/IEC JTC1/SC29/WG11,N10857:Applications and Requirements on 3DVideo Coding[S].

[25]SMOLIC A,MUELLER K,MERKLE P,et al.3Dvideo and free viewpoint video-technologies,applications and MPEG standards[A].IEEE International Conference on Multimedia and Expo[C].[S.l.]:[s.n.],2006.2 161-2 164.

[26]SMOLI A,KAUFF P.Interactive 3-D video representation and coding technologies[J].Proceedings of the IEEE,2005,93(1):98.

[27]SHIH H C,HSIAO H F.A depth refinement algorithm for multiview video synthesis[A].IEEE International Conference on Acoustics Speech and Signal Processing[C].[S.l.]:[s.n.],2010.742-745.

[28]FAN Y C,WU S F,LIN B L.Three-dimensional depth map motion estimation and compensation for 3Dvideo compression[J].IEEE Transactions on Magnetics,2011,47(3):691-695.

[29]王彦霞,王震洲,刘教民.基于双目立体视觉的三维建模算法[J].河北科技大学学报,2008,29(3):219-222.WANG Yanxia,WANG Zhenzhou,LIU Jiaomin.Three-dimensional modeling approach based on stereo vision[J].Journal of Hebei University of Science and Technology,2008,29(3):219-222.

[30]KIM S Y,CHO J H,KOSCHAN A,et al.3Dvideo generation and service based on a TOF depth sensor in MPEG-4multimedia framework[J].IEEE Transactions on Consumer Electronics,2010,56(3):1 730-1 738.

[31]SHIMIZU S,KITAHARA M,KIMATA H,et al.View scalable multiview video coding using 3-D warping with depth map[J].IEEE Transactions on Circuits and Systems for Video Technology,2007,17(11):1 485-1 495.

[32]EKMEKCIOGLU E,WORRALL S T,KONDOZ A M.A temporal subsampling approach for multiview depth map compression[J].IEEE Transactions on Circuits and Systems for Video Technology,2009,19(8):1 209-1 213.

[33]TANIMOTO M,WILDEBOER M.Frameworks for FTV coding[A].Proceedings of the 27th Conference on Picture Coding Symposium[C].[S.l.]:[s.n.],2009.1-4.

[34]CHEN Y,WANG Y K,UGUR K,et al.The emerging MVC standard for 3Dvideo services[J].EURASIP Journal on Applied Signal Processing,2009,78:6 015-6 032.

[35]WILLNER K,UGUR K,SALMIMAA M,et al.Mobile 3D video using MVC and N800internet tablet[A].The True Vision-Capture,Transmission and Display of 3DVideo[C].[S.l.]:[s.n.],2008.69-72.

[36]ISO/IEC JTC1/SC29/WG11,N 12036:Call for Proposals on 3DVideo Coding Technology[S].