基于条件随机场与Web数据的缩略语预测

焦 妍,王厚峰,张龙凯

(1. 北京大学 计算语言学教育部重点实验室,北京 100871;2. 北京大学 计算机科学技术系,北京 100871)

1 引言

缩略语是由较长的语词缩短省略而成的语词。在语言学里严格的说是一种词语的简易格式,又称“缩写”和“简称”。例如,“北京大学”的缩略语即“北大”。

由于缩略语在表达上简洁精炼,在自然语言中被大量使用;但另一方面,缩略语是未登录新词的一大“贡献者”,给自然语言处理带来了诸多困难。汉语的分词、词性标注、命名实体识别、机器翻译和信息检索等领域都受到了缩略语问题的困扰。大规模的完整形式与缩略语对照库是解决上述问题的重要资源。从完整形式出发预测缩略形式是构建对照库的途径之一。本文称这一过程为缩略语预测。

从语言学的角度来看,缩略语具有一定的生成规则。但语言上的规则大都有例外。不同的语言中缩略语的形成方式也不太一样。在英文中,通常取出一个单词的一部分作为缩略语,如“abbreviation”的缩略语为“abbrv.”或“abbrev.”或者取出一个词组中每个单词的首字母,如“National Basketball Association”的缩略语即为“NBA”。余富林将英文缩略语大体划分为四类,包括首字母缩略语(Acronym),缩写(Initialism),截短语(Clipping)和拼缀词(Blend)[1]。而汉语则与英文有着较大的差异,英文的缩略语以字母为单位进行删减,字母本身并无意义,中文缩略语则以字为单位,注重保留的字是否具有代表性的意义。

中文缩略语的生成方式是语言学中的一个重要问题。文献[2-3]将中文缩略语的生成过程主要分为三种形式,包括压缩、节略和统括。其中,压缩指将原词语按意义分成几个部分,然后从各部分中抽取最能代表原义的语素(或词)保留,省掉其他部分。例如,“电影明星”按语义分为“电影”和“明星”两个部分,分别取出具有代表性的“影”和“星”,组合为“影星”即为缩略语。另外,有时候也会合并相同的语素,比如将“中医、西医”缩略为“中西医”。节略指直接截取原词语的某一部分,将其余部分省略掉。例如,“复旦大学”简称“复旦”,“清华大学”简称“清华”,“阿拉伯也门共和国”简称“也门”等。统括指把并列短语中原词语所共有的一个词或语素抽取出来,然后在它之前加上表示原词语数目的数词或数量短语,省略其余,例如,“广西、广东”由并列的两个词构成,共同的成分为“广”,加上数字词“两”,即得到缩略语“两广”,再如“西汉、东汉”缩略为“两汉”。

上述的三种形式体现了汉语大多数缩略语的生成模式。但是针对每一个具体的完整形式,究竟应用哪种规则进行缩略,以及省略哪一部分,都是由很多因素共同起作用的,具有不确定性。因此,单从语言学的规则入手很难直接做出预测。跳出语言规则的限制,利用已经有的标注过的资源和网络信息让计算机建立模型是值得尝试的一种思路。本文基于自然语言处理技术,提出了将机器学习方法与网络信息相结合的缩略语预测。首先通过序列标注模型CRF对完整形式进行标注,产生可能的缩略语候选。再进一步利用搜索引擎返回的结果,对候选进行重排序和验证,从而得到最终的缩略形式。

2 相关工作

目前已有不少针对英文的缩略语研究[4]。主要集中在研究科技文献中的缩略语,尤其是生物医药方面,如文献[5-7]等。其中文献[5] 在缩略语预测方面应用了序列标注的方法,使用最大熵马尔可夫模型 (MEMM),取得了较好的结果。文献[6] 在缩略语识别中,并没有使用机器学习的方法,而是一种简单的、直接匹配的方法,也取得了不错的结果。文献[7] 则进行了缩略语挖掘方面的研究。英文缩略语的研究重点在于根据上下文挖掘缩略语和完整形式的关系。另外歧义消解也是英文缩略语中的重要问题,因为一个缩略语通常对应多个完整形式。而汉语中这种现象并不常见,因此研究的重点也不尽相同。

汉语缩略语处理近年来也开始受到重视,并取得了一定的成果。代表性的研究包括Chang的工作[8-9],都使用了基于HMM模型的机器学习的方法。在汉语缩略语预测方面,也已有研究报道。孙栩等人使用支持向量回归(SVR)的方法预测缩略语,即通过回归的方法,对不同的缩略语候选进行打分和重排,取得分最高的候选为最终候选[10]。孙栩还研究了在序列标注基础上引入隐变量的方法(Discriminative Probabilistic Latent Variable Model,DPLVM),它是比CRF更具一般性的序列标注方法,取得了较好的效果,使top-1的准确率达到了72.3%[11]。而Yang使用CRF条件随机场模型生成候选,并利用完整形式和缩略语的字符串长度关系建立长度模型,再根据完整形式和候选的长度对其进行重排序[12]。计峰专门针对汉语机构名的缩略预测也使用了序列标注方式[13]。

此外,网上隐藏了大量的有用信息,可以充分利用网络资源辅助预测缩略语。Jiang利用搜索引擎以及添加线索词的搜索技巧进行了缩略语和完整形式匹配对挖掘方面的研究[14]。Liu 研究了使用Web 资源获取汉语缩略语完整形式的方法[15]。谢丽星则利用查询日志、锚文字以及相关的URL作为桥梁,挖掘汉语缩略语和完整形式匹配对[16]。

缩略语的形成受多种因素的影响,很难找到完全统一的规律,单纯使用机器学习方法或者规则方法都难以覆盖缩略语生成的各种现象。Jiang, Liu和谢丽星的研究表明,利用已有的资源,特别是网络资源,对缩略语分析也具有辅助作用。更多的讨论见王厚峰的综述[17]。

3 基于序列标注模型的缩略语候选生成

3.1 缩略模型

本文将完整形式生成缩略语的过程看作一个序列标注问题。

定义3.1(序列标注) 序列标注问题即: 给定长度为n的输入序列X1X2…Xn∈Xn,形成输出序列Y1Y2…Yn∈Yn,其中Xi来自一个可数集合X,Yi来自有穷集合Y,且Yi是对应Xi的标记。

基于标注模型,可以得到缩略语的生成过程。

定义3.2(缩略生成模型) 定义集合X为所有汉字,标注集为Y={S;K},其中S表示“略过”(skip),K表示“保留”(keep)。从一个完整形式字序列X1X2…Xn∈Xn生成相应缩略语的过程如下:

(1) 生成标记序列Y1Y2…Yn∈Yn;

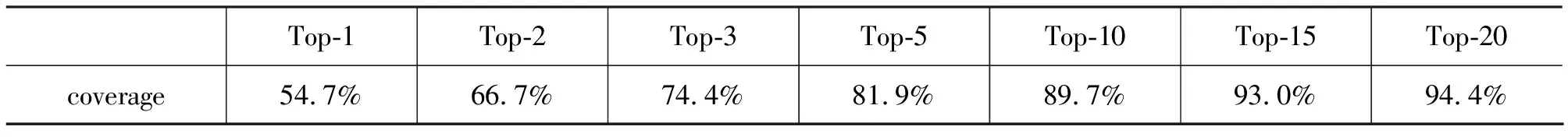

(2) 设其中所有标记为K 的指标从小到大排列为1≤i1 (3)Xi1,Xi2…Xim∈Xm即为相应缩略语字序列。 通过序列标注的方法对完整形式进行序列标注,再抽取标记为K的字顺次连接,便得到缩略形式。例如,“北京理工大学”,若对应的标注序列为“北/K京/S理/K工/K大/S学/S”,则缩略形式即为“北理工”。 条件随机场(CRF)由Lafferty在2001年提出[18],它是一种判别式概率模型(discriminative probabilistic model)。CRF利用无向图模型定义了一个给定输入序列{Xi}时标记序列{Yi}的条件分布。它在给定观察序列的前提下,计算整个标记序列的概率。CRF模型可以较好地解决序列标注问题,在词性标注、命名实体识别、语块分析中都得到了很好的应用。 定义3.3设有集合G= (V,E)为一个图,Y=(Yv)v∈V,是以G中节点v为索引的随机变量Yv构成的集合。在给定标记序列X的条件下,如果每个随机变量Yv服从马尔可夫性质,即p(Yv|X,Yw,w≠v)=p(Yv|X,Yw,w~v)。则(X,Y)就构成一个条件随机场。 最简单且最常用的是一阶链式结构,即线性链结构(Linear-chain CRFs),如图1所示。 图1 链式CRF结构 令x={x1,x2,…,xm}表示待标记的观察序列,y={y1,y2,…,ym}表示对应的标注序列,根据Hammersley和Clifford提出的随机场定理[19],条件概率分布符合如下特征: (1) 其中θ=(λ1,λ2…;μ1,μ2…)是要从训练集中估计的参数。 tj(yi-1,yi,x,i)表示对于观察序列的标记位置i-1与i之间的转移特征函数。sk(yi,x,i)表示观察序列的i位置的状态特征函数。 将两个特征函数统一为fj(yi-1,yi,x,i),则 (2) 其中Z(x)为归一化参数: (3) 在CRF模型中,本文使用的特征模板(简称为特征1~6)如下: 特征模板 1.Xi的汉字,拼音及音调; 2.Xi-1的汉字,拼音及音调; 3. (Xi-j;Xi-j+1) 的汉字二元组和拼音二元组,其中j∈{0;1;2}; 4.Xi-j是否为数字,其中j ∈ {0;1;2;3}; 5. [[Xi-j=Xi-j+1]],其中j ∈ {0;1;2}; 6. [[Xi-j=Xi-j+2]],其中j ∈ {0;1;2;3}。 各个特征的说明如下。 特征1 在完整形式变化成缩略语时,字的省略或保留具有一定的统计规律。需要选择字作为特征。另外,一些汉字的拼音和音调也与其是否缩略有相关性,某些发音拗口的字一般不被保留到缩略语中; 特征2 某些字的取舍与相邻字有一定的相关,需要选择Xi-1的汉字,拼音和音调; 特征3 由于完整形式常由短词拼接而成,需要使用二元组的信息; 特征4 包含数字的缩略语具有区别性的特征,如连续的数字全部保留等,例如,“北京市一零一中学”中“一零一”是必须保留的部分; 特征5~6 在缩略过程中,对相同的部分经常合并,如“中医、西医”缩略为“中西医”。这里将其作为一个特征。 本文利用搜索引擎返回的结果,对序列标注得到的候选进行重排序。 我们的实验发现,使用上述特征模板经过CRF模型标注后,按条件概率从高到低为前20个缩略候选的结果。分别计算Top-k覆盖率(即前k个结果中包含正确答案的测试条目所占总条目百分比)。 表1显示,前10 个候选的覆盖率为89.7%。为了检验重排对Top-1的影响,同时又尽可能控制计算复杂性,本文只选择CRF 的前10 个候选进行打分和重排。 表1 由CRF模型得到的top-k覆盖率 我们使用百度搜索引擎进行搜索,根据返回的前20个搜索结果的信息对前10个缩略语候选评估和打分。用到的搜索结果信息包括标题(title)、摘要(snippet),URL地址以及搜索引擎检索到的结果数量(resultNum)。我们分别采用了以下几种信息对候选进行打分。 将前10个缩略语候选中的每一个作为搜索词,在百度搜索引擎中搜索,取前20个返回结果进行分析和打分。包括如下两种打分。 1) 基于标题的打分 含有缩略语的文章,其完整形式很可能在标题中出现。针对每个缩略语候选abbr,从20个返回结果中统计完整形式full在多少个标题中出现,以titleFullCount(abbr)表示,同时统计被单独标红(强调显示)的缩略形式在多少个标题中出现,以titleAbbrCount(abbr)表示。利用这两种信息,可以排除掉属于完整形式的一部分,但不能构成正常词汇的那些候选。例如,“粮食交易会”的候选“粮食交会”并非正确缩略语,但搜索结果表明前20条中有14条标题包含“粮食交易会”,而每条标题都不包含“粮食交会”这个词。计算方法见式(4)和式(5) 2) 基于摘要的打分 与标题的统计方法类似,统计完整形式在多少个摘要中出现,以snippetFullCoun(abbr)表示,同时统计被单独标红(强调显示)的缩略形式在多少个摘要中出现,以snippetAbbrCount(abbr)表示。计算方式与式(1)和式(2)相同,将title替换为snippet即可。 由于缩略语和完整形式表达同样的语义,那么如果一篇文章中包含了缩略语和完整形式的大量信息,则这个网页很有可能以较高的排名同时出现在二者的搜索结果中。再对完整形式单独进行搜索,再与上一步得到的每个候选的搜索结果进行对比。本文选择网页地址URL和网页标题title分别进行对比。 1) 网页标题对比 考虑到两个网页可能具有相同的内容但不同源,因此对完整形式和缩略形式的搜索结果的标题进行比较。为解决同一标题重复出现的问题,取完整形式的前10个网页标题作为词典索引,指向title第一次出现的排名,以及title在前10个中的计数dicCount。考虑到搜索结果排名的重要性和检索计算量,这里只采取完整形式的前10个(而非20个)搜索结果。将上一步得到的缩略语搜索的前20个标题,一一在标题词典中查询并根据完整形式搜索结果的排序rank赋予比对结果一定的权值1/rank。得到式(6)。 (6) 2) 网页地址URL对比 考虑到一些相似网页隶属于同一网站的不同子集,因此对URL先进行过滤,只考虑网站地址。计算方式与网页标题类似,将式(6)中的title替换为URL即可。 经过上一步的实验发现,很多缩略语形式得到的结果是帖子、博文等较为不规整的资源,不包含全称,也与搜索全称的结果相去甚远。例如,分别搜索“俄罗斯国际航空公司”和搜候选“俄航”的前20条结果,二者相似度为0,且“俄航”的摘要结果中也没有出现完整形式。 于是,我们使用了带特殊线索词的搜索形式。例如,在百度中搜索<完整形式> 简称 <缩略候选>,获取前20条搜索结果。针对“俄罗斯国际航空公司”和“俄航”,可以搜索“俄罗斯国际航空公司 简称“俄航”。在返回结果的摘要中即可以看到“俄罗斯国际航空公司(Aerolot,简称俄航)”这样的句式。考虑到不同的表达形式,包括中间添加标点符号或英文等,归纳为正则表达式后进行匹配,即可得到带线索词的得分策略。 (7) 为了进一步分析网络资源中缩略语和完整形式间的关系,我们也考虑了二者的共现现象,并根据共现进行搜索,其形式为“<完整形式> <缩略形式>”,利用搜索得到的结果数量和摘要信息分别进行打分。 1) 结果数量 一般情况下,一对完整形式和缩略候选的搜索结果较多,说明二者的共现现象更为明显,也意味着二者之间的关系更为密切。但是也有例外的现象。比如一个错误的缩略形式可能是一个单字,或是作为完整形式一部分的一个常用词,那么搜索<完整形式> <缩略形式>就可能出现非常多的结果而误导打分。例如,搜索“影片来源”候选的结果数量见表2。 在表2中,完整形式“影片来源”的候选“片”,“影片”,“影”,“源” 都是错误的候选,但与完整形式“影片来源”组合后,能进一步验证结果。根据经验,如果对缩略语单独搜索获得的结果数量abbrResultNum等于108(百度把超过1亿条的都算做1亿条),且大于单独搜索完整形式的结果数目fullResultNum,则得分为0。通过这种打分,可以排除掉常用词和单字(如,“影片”,“源”),而有利于得到正确的候选(如,“片源”)。计算公式见(8)。 表2 “影片来源”和候选的单独搜索结果数量和共现搜索的结果数量 (8) 2) 摘要信息 我们也按公式(9)统计了在返回结果的摘要中是否同时出现完整形式和缩略形式。 CoOccurCount(abbr) (9) 由上面的四种方法可以得到9个估值。分别对每个统计值count进行归一化: (10) 因此每个值的范围都是[0,1],经过参数为1的平滑处理,与CRF得到的概率值相乘得到最终的分值: Score=CRF×(1+titleAbbr)×(1+titleFull)× (1+urlCompare)×… ×(1+CoOccurCount) (11) 在综合计算后,便可以根据值的大小按降序排列,排在最前面的结果即为最优结果。 本文使用了北京大学计算语言学研究所收集的 8 350对完整形式与缩略语对照表进行测试。其中每个完整形式严格对应一个缩略语(虽然存在一个完整形式可能对应多个缩略语的情况,此处只考虑最常用的缩略形式,选择作为标准答案)。将对照表随机分为10份,进行10交叉训练和测试。 对于结果,依照文献[4]采用了两种评测方法——完全匹配正确率以及Top-k覆盖率。 完全匹配正确率即为系统得出的排名第一的结果等于标准答案的测试用例占所有测试用例的比例。Top-k覆盖率为当系统返回的排名前K个结果包含了正确答案的的测试用例数占所有测试用例的比例。例如,Top-5覆盖率即系统返回的前5个缩略结果中包含了正确结果的测试用例的比例。因此完全匹配正确率即为Top-1覆盖率。 本文利用CRF++工具*CRF++工具见: http://crfpp.sourceforge.net/建立序列标注模型,对测试数据进行序列标注,得到Top-k覆盖率的结果如表1所示,并选择前10个结果作为重排的候选。 在CRF条件概率排列前10的候选中,利用网络搜索的结果分别再进行统计打分,并结合CRF的概率值重排结果。表3给出了评测结果。结果显示单独使用各方法都不同程度的改进了CRF效果,其中使用方法1(缩略语搜索)以及方法4(共现法)中的摘要,结果较好;方法3(线索词)也有一定的提高;而方法1中的标题,方法2(对比法)中的URL以及方法4的搜索数量对结果的提升效果不明显。最终合并所有的影响因子的效果,以及去掉对比法中的标题分数后效果最好,Top-1的正确匹配率比单纯用CRF提高了约5%(p<0.001)*根据t检验对10组结果的Top-1正确率进行统计显著性测试的结果。 表3 使用不同统计方法打分得到的完全匹配正确率和Top-k覆盖率 究其原因,可能是摘要提供的内容更加丰富,并且相对可靠,能带来更多有用的信息。而标题和URL具有一定的局限性: 标题本身信息量较少,而URL一般对注册过官方网站的组织机构名有效,对其他的内容有可能带来一些噪音。对比不同的搜索策略,线索词法虽然作用范围较窄,主要对命名实体具有纠正作用,但它的提升程度不容小觑。另外共现法中的搜索数量并未获得预期的提升,可能由于缩略候选与完整形式的重合度带来了干扰。综合所有的统计量与原始CRF的概率值会带来一定的平衡,弥补各个因子的缺陷,比单独使用任何一个效果都好。另外组合实验也表明,去掉提升效果最不明显的title对比法,能够得到最好的结果。 本文所提出的方法结合了序列标注和网络信息验证两个过程。利用CRF模型得到第一步结果。然后利用搜索引擎返回的结果信息对第一步的结果进行“纠正”。本文利用了大规模的网页信息,加入了缩略语搜索、对比法、线索词法、共现法四种方法的统计打分,并进行了融合,从而使重排序得到了较好的结果,Top1的正确匹配率提高了近5%。与其他人的工作相比,比文献[10]中用HMM模型的完全匹配准确率46.7%要高,和使用SVR模型的结果 62.7%相似。在使用网络信息方面,文献[12]并未给出完全匹配准确率,其Top-10覆盖率与本文的Top-5覆盖率近似。 由于网络资源较复杂,因此统计模型的提升效果不是特别明显,进一步的工作可以涉及优化搜索结果的验证模型,探索新的统计方法,以及设计更加合理的重排序算法。另一方面,从完整形式向缩略语转换中,有很多因素共同起作用,选择更加合理的特征也是要深入分析和探讨的。 [1] 余富林.英汉缩略语的比较与应用[M].清华大学出版社,北京,2002. [2] 殷志平. 构造缩略语的方法和原则[J]. 语言教学与研究. 1999, 2(11). [3] 陈文. 试论缩略语及其与原词语的关系[J]. 广西师院学报: 哲学社会科学版.2001, 22(1):74-77. [4] Manuel Zahariev. ACRONYMS[D]. PHD thesis, Simon Fraser University, 2004. [5] Y. Tsuruoka, S. Ananiadou. A machine learning approach to acronym generation[J]. Linking Biological Literature, Ontologies and Databases: Mining Biological Semantics. 2005:25. [6] A.S. Schwartz, M.A. Hearst. A simple algorithm for identifying abbreviation definitions in biomedical text[C]//Proceedings of Pacific Symposium on Biocomputing. Citeseer, 2003, 8, 451-462. [7] Naoaki Okazaki, Sophia Ananiadou, Jun’ichi Tsujii. A Discriminative Alignment Model for Abbreviation Recognition[C]//Proceedings of the 22nd International Conference on Computational Linguistics (Coling 2008). Manchester, UK: Coling 2008 Organizing Committee, 2008: 657-664. URL http://www.aclweb.org/ anthology/C08-1083. [8] J.Chang, Y.Lai. A Preliminary Study on Probabilistic Models for Chinese Abbreviations[C]//Proceedings of the Third SIGHAN Workshop on Chinese Language Learning, 2004, Barcelona, Spain. [9] Jing-Shin Chang, Wei-Lun Teng. Mining Atomic Chinese Abbreviation Pairs with a Probabilistic Single Character Word Recovery Model[C]//Proceedings of SIGHAN Workshop on Chinese Language Processing, 2006. [10] Xu Sun, Hou-Feng Wang, Bo Wang. Predicting Chinese Abbreviations from Definitions: An Empirical Learning Approach Using Support Vector Regression[J]. Journalof Computer Science and Technology. Jul. 2008, 23(4):602-611. [11] Xu Sun, Naoaki Okazaki, Jun’ichi Tsujii. Robust Approach to Abbreviating Terms:A Discriminative Latent Variable Model with Global Information[C]//Proceedings of the Joint Conference of the 47th Annual Meeting of the ACL and the 4th International Joint Conference on Natural Language Processing of the AFNLP. Suntec, Singapore:Association for Computational Linguistics, 2009: 905-913. [12] Dong Yang,Yi-Cheng Pan, Sadaoki Furui. Automatic Chinese Abbreviation Generation Using Conditional Random Field[C]//Proceedings of Human Language Technologies: The 2009 Annual Conference of the North American Chapter of the Association for Computational Linguistics, Companion Volume: Short Papers. Boulder, Colorado: Association for Computational Linguistics, 2009: 273-276. [13] 计峰,高沫,邱锡鹏,等. 中文机构名简称的自动生成研究[M].孙茂松,陈群秀,中国计算语言学研究前沿进展,清华大学出版社,2009. [14] Guang Jiang, Cao Gungen, Sui Yuefei, et al. A General Approach to Extracting Full Names and Abbreviations for Chinese Entities from the Web[C]//Proceedings of Intelligent Information Processing 2010: 271-280. [15] Hui Liu, Yuquan Chen, Lei Liu. Automatic Expansion of Chinese Abbreviations by Web Mining[C]//Proceedings of the International Conference on Artificial Intelligence and Computational Intelligence. LNAI 5855, 2009, Springer. [16] 谢丽星,孙茂松,佟子健,等. 基于用户查询日志和锚文字的汉语缩略语识别[M].孙茂松,陈群秀,中国计算语言学研究前沿进展,清华大学出版社,2009. [17] 王厚峰,汉语缩略语自动处理研究现状[J]. 中文信息学报,2011,25(5):60-67. [18] J. Lafferty, A. McCallum, F. Pereira. Conditional random fields: Probabilistic models for segmenting and labeling sequence data[C]//Proceedings of Machine Learninginternational Workshop Then Conference-. Citeseer, 2001, 282-289.3.2 CRF模型

3.3 特征模板设计

4 基于网页搜索返回结果的重排序

4.1 基于缩略语的搜索

4.2 缩略语与完整形式的对比

4.3 基于线索词的搜索

4.4 共现现象

4.5 综合

5 实验与分析

5.1 第一步: CRF序列标注

5.2 第二步: 利用网页搜索结果重排

6 结论