融合多尺度和深度特征的快速运动视觉目标跟踪

张 博

(长沙师范学院信息科学与工程学院,湖南 长沙 410100)

0 引言

视觉目标跟踪作为计算机视觉的核心技术,以图像传感器为核心,通过对视频信号的分析与理解,实现对目标的跟踪,从而获得相应的运动轨迹,即在确定了第一个画面的位置之后,通过相应的运算,可以得到下一个画面的对应位置[1-3]。当物体在移动时,背景和物体都会发生变化,包括形状、背景、光线、尺寸等,而这些变化会导致跟踪结果的变化。随着计算机视觉技术的日益普及,尤其是在高速运动的环境中,人们越来越多地关注视觉对象的跟踪,因此进一步研究运动视觉目标跟踪算法显得尤为重要[4-5]。

相关领域学者针对运动视觉目标跟踪进行了研究。文献[6]提出了基于多阶段自适应网络学习元对抗特征的鲁棒视觉目标跟踪算法:利用元学习增强了新跟踪序列的泛化能力;设计对抗性注意掩码模块和多层次多尺度元分类器模块;通过位置自适应子网络细化跟踪位置,实现视觉目标跟踪。但该方法未在提取图像特征过程中有效滤除环境干扰,目标跟踪精度较低。文献[7]提出了基于量化遗传重采样粒子滤波的地面运动目标跟踪算法:采用粒子滤波估计状态,基于量化测量的状态后验结果对一组加权粒子更新;融合Gen-z变换和蒙特卡罗法,计算似然函数数值;将量化遗传重采样方法集成到粒子滤波方法中,完成地面运动目标跟踪。但这种方法未对运动目标的深度特征进行融合,在目标遮挡时无法有效跟踪识别。文献[8]提出了基于视觉的无人机地面运动目标跟踪方法:基于视觉的估计和制导方法,使无人机围绕运动目标飞行圆形轨道;使用卡尔曼滤波器设计来估计目标运动,将机载GPS和惯性传感器与从视觉系统获得的目标指向向量相结合,实现了运动目标视觉跟踪。但这种方法未在目标视觉跟踪前滤除环境干扰,存在后续视觉跟踪鲁棒性较差的问题。文献[9]提出了基于视觉信息和激光模块的无人机目标跟踪方法:利用深度神经网络和核相关滤波器,实现了基于视觉的像素坐标系中的目标识别和定位;通过结合激光测距信息和基于图像的距离估计算法,估计无人机与目标之间的距离,实现无人机目标跟踪。然而,该方法所用的核相关滤波器无法适应视觉目标的多尺度变化,在视觉目标被遮挡时无法精确跟踪识别。文献[10]提出了基于ROS的四足机器人视觉跟踪方法:在ROS上开发了一个测试平台,机载相机从中生成图像帧序列;采用图像处理算法,对图像模糊和其他背景噪声进行处理;坐标恢复将原始目标轨迹恢复为跟踪器在真实世界中的期望路径;目标跟踪控制律沿着期望的轨迹逐点移动跟踪器,实现在真实场景中视觉目标跟踪。该方法对图像模糊和其他背景噪声进行处理时未保留关键特征,在运动目标模糊时难以提取其特征,无法及时跟踪目标。文献[11]提出了基于视觉的VTOL无人机鲁棒跟踪控制算法:考虑到不同的视觉特征集,提出了两种控制方案,用于在存在外部干扰的情况下实现基于视觉特征的运动目标跟踪。该方法没有融合使用两种控制方案,协调性较差,导致跟踪效率较低。文献[12]研究了基于视觉DSP的运动目标跟踪方法。评估硬件优化方法的结果,基于视觉DSP技术中的KCF跟踪算法来优化实时跟踪性能;检查并分析了跟踪系统的影响因素,包括DP,IP以及DSP内核和IDMA;利用分时策略来提高系统运行速度,实现视觉目标快速跟踪。这种研究方法未对环境噪声干扰进行滤除,受到干扰后无法准确跟踪运动目标。

上述方法在实际应用中受到环境干扰、运动目标模糊、视觉目标被遮挡等因素的影响,存在目标跟踪精度和效率低、鲁棒性弱的问题。针对上述问题,提出了融合多尺度核相关滤波和深度特征匹配模型的快速运动视觉目标跟踪算法。

1 基于多尺度的视觉特征提取

为了降低环境噪声对目标图像数据的干扰,采用核相关滤波跟踪算法滤除干扰,同时提取快速运动视觉目标特征;传统的核相关滤波跟踪算法包括三个阶段:分类器训练、候选区域检测和模型更新[13-15]。但在快速运动视觉目标实际跟踪过程中,由于传输延时,运动视觉目标的尺度发生变化后,部分特征信息容易丢失,不利于后续快速运动视觉目标准确跟踪[16]。对此,提出了基于多尺度核相关滤波的快速运动视觉目标跟踪。首先,采用常规的三个步骤检测快速运动视觉目标位置跟踪;然后,采用更新的多尺度核相关滤波进行运动视觉目标跟踪。利用双线性插值函数将子图转化为多尺度大小,并进行特征提取;最后,利用多尺度更新策略对核相关滤波跟踪算法进行优化,在滤除干扰的同时保留目标的多尺度特征。

1.1 分类器训练

分辨目标和背景是快速运动视觉目标跟踪算法的核心。对于n个数据集(zi,xi),i∈1,2,…,n,设计一个鲁棒分类器:

y=min‖zi-xi‖2,

(1)

式(1)中,zi为训练样本,xi为该样本的标签值。在核相关滤波目标跟踪算法中,以快速运动视觉目标位置为中心,通过循环矩阵采样得到所有的训练样本。该方法利用非线性映射函数α(X),将采样训练数据zi映射在线性可分高维空间域内,映射过程表示为

(2)

(3)

利用岭回归函数重建分类器,式(3)的对偶形式用β表示为

(4)

式(4)的闭式解为

β*=(α(X)α(X)T+β)-1y。

(5)

通过核函数K=α(X)α(X)T求解得

β*=(K+β)-1y。

(6)

将K对角化处理为循环矩阵K′,则式(6)转换为

β′=diag(K′+β)-1y,

(7)

则分类器模型的滤波频域为

(8)

故分类器经过训练更新表示为

(9)

由此完成分类器训练,为后续样本特征提取提供模型基础。

1.2 候选区域检测

从搜索区域中采集多个候选样本是快速运动视觉目标位置特征检测中十分重要的步骤。通过循环矩阵采集样本,将不同的样本输入1.1节更新的分类器做相关运算,得到各自对应的响应值。判定置信度响应值最大的样本即为快速运动视觉目标样本,进而确定快速运动视觉目标所在位置。

将分类器中循环矩阵K′定义为核空间中的训练和待检测样本的核矩阵为

K′=α(z)Tα(X)。

(10)

待检测样本的响应度为

(11)

响应度最大的位置即可判定为快速运动视觉目标位置。在快速运动视觉目标跟踪过程中,处理每一帧图像时,快速运动视觉目标的位移Y=f(c;v)由f(b;v)=argmaxF(b,m;v)计算获得,这里的c是上一帧图像中快速运动视觉目标的中心位置区域。置信度响应图为

F(c,m;v)=F-1K′。

(12)

一般采用响应图中最高峰的位置判定为快速运动视觉目标的新位置,也称为单峰检测。对于式(12)中的单峰响应图F(c,m;v),其他峰值为

Q(c)=F(c,m;v)⊗W,

(13)

式(13)中,W与F(c,m;v)是相同大小的二值矩阵,它标识了F(c,m;v)中局部极值的位置。由此完成快速运动视觉目标位置检测,作为视觉目标跟踪的关键尺度特征。

1.3 模型更新

在快速运动视觉目标跟踪过程中,当快速运动视觉目标被遮挡、外界光照变化或者由于自身原因发生形变,若一直采用一个模型很容易检测到错误的快速运动视觉目标上,进而丢失目标。因此能够实时地进行模型更新十分必要,这样才能准确地应对复杂环境的变化,以滤除图像中与目标无关的频域。核相关滤波器跟踪算法常用的模型更新方法是内插法,基于内插法的分类器模型更新频域表示为

(14)

式(14)中,χ是更新系数,决定了上一帧快速运动视觉目标信息和当前帧快速运动视觉目标信息在跟踪模型中所占的权重大小。由此完成分类器模型的更新,结合快速运动视觉目标位置检测结果,完成基于核相关滤波跟踪算法的快速运动视觉跟踪目标特征提取。

1.4 多尺度更新策略

在快速运动视觉目标跟踪过程中,如果一直不改变跟踪框的大小,在快速运动视觉目标的尺度发生变化后,就会只能够提取快速运动视觉目标一部分信息,导致特征信息丢失,不利于快速运动视觉目标跟踪[17-18]。对此,采用更新的多尺度核相关滤波进行快速运动视觉目标跟踪。在1.2节检测到的快速运动视觉目标位置处,采集快速运动视觉目标多尺度的子图;利用双线性插值函数将子图转化为多尺度大小,在每个子图进行特征提取后,对多尺度核相关滤波器进行训练。

若上一帧图像的多尺度为Ec,多尺度金字塔为R层,快速运动视觉目标候选多尺度参数是{δj·Ec|j=-(R-1)/2,…,(R-1)/2},δj为多尺度变化因子,对每个候选区域多尺度变换后,将1.2节提取峰值特征Q(c)一维量化为S(Q(c))=[z1,z2,…,zc],再经Hanning窗口t个尺度处理,获得训练样本zt=[zt1,zt2,…,ztc]。

(15)

用双线性插值函数fs(zt)=[fs(1),fs(2),…,fs(R-1)],对快速运动视觉目标的候选区域进行连续多尺度采样,ε∈[0,R)是连续多尺度参数,f(ε)是连续反应可信度,那么f(ε)可以用fs(zt)进行插值操作来获得:

(16)

多尺度核相关滤波器的多尺度参数εo可表示为

(17)

2 融合深度特征的目标跟踪优化

上述基于多尺度核相关滤波完成了快速运动视觉目标跟踪特征提取。为了提高高速运动视觉目标在被严重遮挡或目标模糊等情况下的跟踪效果,在多尺度核相关滤波目标跟踪[19-20]的基础上,实现快速运动视觉目标跟踪优化。首先,通过贪婪算法对视觉特征重构,获得深度特征,基于置信度将HOG特征与深度特征进行匹配融合;其次,利用SURF算法对视觉目标位置单峰响应图进行校正;最后,采用密集采样跟踪阈值更新策略,优化追踪结果更新效率,完成快速运动视觉目标跟踪。

2.1 基于置信度的深度特征匹配

由于1.2节提取的特征在复杂背景环境中表达能力有限,目标跟踪存在着很大的困难。因此本文堆叠多层自编码器得到深层神经网络,再通过贪婪算法对1.4节输入特征εo重构,得到深度特征pdeep(εo)。为增强该算法的鲁棒性,算法融合了神经网络学习得到的深度特征与跟踪快速运动视觉目标的方向梯度直方图HOG特征。在深度神经网络中添加了快速运动视觉的初值和随后的帧间估计快速运动视觉目标HOG特征。将HOG特征与深度特征通过式(18)匹配融合作为训练样本:

U=φi-1(φ1phog+φ2pdeep(εo)),

(18)

式(18)中,φ1和φ2表示两个特征的融合系数,φi-1表示第i-1帧图像的跟踪结果的置信度,phog代表1×65维的HOG特征,U代表融合特征。由此完成了目标跟踪特征优化。

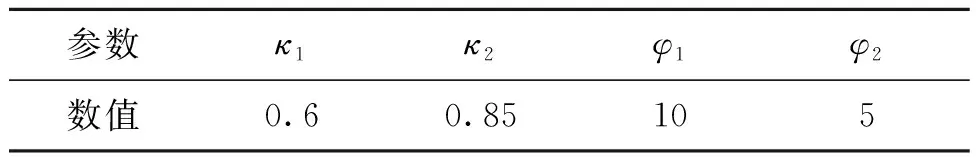

表1 仿真实验参数设置Tab.1 Parameter settings for simulation experiments

2.2 基于改进SURF的目标重定位

快速运动视觉目标遮挡是跟踪领域的诸多挑战之一。遮挡的随机性与未知性导致视觉跟踪过程中样本错误更新,误差累积后造成跟踪失败。针对这种情况,提出一种基于Krawtchouk矩的SURF算法,该算法在求解结果小于搜索域更新阈值时,利用SURF算法对获得的快速运动视觉目标位置单峰响应图F(c,m;v)进行校正,从而提高了算法的准确度。

改进SURF算法使用γ阶Krawtchouk多项式,归一化Krawtchouk多项式为

(19)

由此完成目标位置检测优化。

2.3 快速运动视觉目标跟踪算法

为提高算法的跟踪效率,采用密集采样跟踪策略,对快速运动视觉目标候选区域的更新阈值进行确定,完成追踪结果更新效率优化。

采用一种基于预定义的阈值更新策略,以减少噪声对模型更新效率的影响。如果快速运动的视觉目标位置不在原来的搜索范围内,那么为了提高算法的精度,必须适当地增大搜索面积,扩展搜索范围的前提是

max(φi)<κ1,

(20)

式(20)中,κ1是搜索范围更新阈值。

当式(20)成立,则扩大搜索区域。同时,快速运动视觉目标在跟踪过程中,会受到快速形变、运动模糊、背景改变等因素的影响,从而导致快速运动视觉目标模型阈值更新速度降低,需要学习快速地更新目标追踪网络。满足式(21)时更新网络:

max(φi)<κ2,

(21)

式(21)中,κ2为网络更新阈值。

基于上述搜索范围更新阈值和网络更新阈值,对时间滑动窗的帧进行实时更新,并将当前帧的负样本、初始帧的正样本、时间滑动窗和相应的HOG特征作为输入,对网络参数进行了实时的更新。如果式(20)和式(21)成立,那么结合i-2帧跟踪结果,对第i帧快速运动视觉目标特征点进行计算。再根据式(18),对改进SURF算法与网络更新后的特征点的整体位置进行融合,输入到分类器中,得到快速运动视觉目标位置计算公式为

(22)

通过上述步骤,实现融合多尺度核相关滤波和深度特征匹配模型的快速运动视觉目标跟踪。

3 仿真实验与分析

3.1 设置仿真实验环境

为了验证融合多尺度核相关滤波和深度特征匹配模型的快速运动视觉目标跟踪算法的有效性,本文使用OTB数据集进行了全面的实验评估。在i7-8700K 3.70 GHz处理器和GTX-1081TI GPU的计算机平台上测试算法性能。在Matlab配套神经网络工具箱Neural Network Toolbox中的Tensorflow深度学习框架上使用Python编程语言进行跟踪算法的训练和测试。设置仿真实验参数如表1所示。

实验数据来源于Ladybug3多目全景视觉系统中的一段视频序列,视频的帧大小为938像素×559像素,数据采样截图频率为10帧/s,共截图500张图像,其中200张用于算法训练,300张用于测试。选择视频画面中的运动员头盔作为跟踪目标。选取6种主流跟踪算法与本文算法在OTB-2015测试数据集中进行对比实验。

3.2 跟踪效果对比

为了验证本文算法的快速运动视觉目标跟踪效果,以测试集中的一张具有跟踪目标模糊、有遮挡、不规则情况的照片为例,比较选取的6种主流跟踪算法与本文算法的快速运动视觉目标跟踪结果如图1所示。

图1 不同算法的快速运动视觉目标跟踪结果Fig.1 Fast-motion visual target tracking results for different algorithms

根据图1可知,文献[6]和文献[8]算法均存在快速运动视觉目标跟踪错误的问题;文献[9]和文献[10]算法均存在快速运动视觉目标跟踪遗漏的问题;而文献[11]算法的快速运动视觉目标跟踪效果最差,无法跟踪模糊的快速运动视觉目标;只有本文算法和文献[7]算法能够较好地跟踪快速运动视觉目标,但文献[7]算法无法跟踪被遮挡的快速运动视觉目标。对比上述不同算法的快速运动视觉目标跟踪结果可知,本文算法的快速运动视觉目标跟踪效果较好,能够有效跟踪被遮挡、模糊、不规则的快速运动视觉目标。

3.3 跟踪精度对比

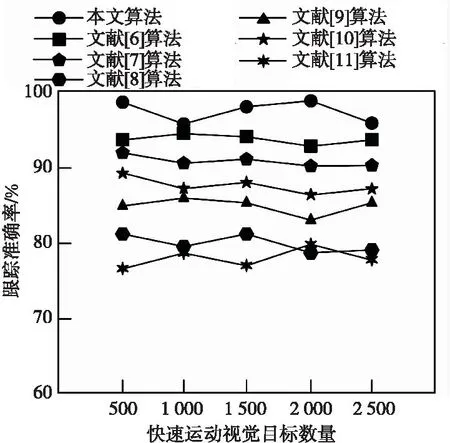

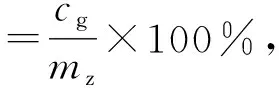

为了验证所提算法的快速运动视觉目标跟踪精度,将跟踪准确率作为评价指标,其跟踪准确率越高,表明算法的快速运动视觉目标跟踪精度越高。其计算公式为

(23)

式(23)中,ms是指正确跟踪的快速运动视觉目标数量;mz是指需要跟踪的快速运动视觉目标总数量,设定为289张测试图像中的2 500个目标。选取6种主流跟踪算法与本文算法进行对比,得到不同算法的快速运动视觉目标跟踪准确率如图2所示。

图2 不同算法的快速运动视觉目标跟踪准确率Fig.2 Fast motion visual target tracking accuracy for different algorithms

根据图2可知,当快速运动视觉目标数量达到2 500个时,所提算法、文献[6]算法和文献[7]算法的平均快速运动视觉目标跟踪准确率分别为97.6%,94.3%和91.8%,其跟踪准确率均在90%以上;文献[9]算法和文献[10]算法的平均快速运动视觉目标跟踪准确率分别为85.6%和88.8%,其跟踪准确率均在80%以上;文献[8]算法和文献[11]算法的平均快速运动视觉目标跟踪准确率分别为79.8%和78.3%,其跟踪准确率均低于80%。对比上述不同算法的快速运动视觉目标跟踪准确率可知,本文算法的快速运动视觉目标跟踪准确率最高,能够有效提高快速运动视觉目标跟踪精度。

3.4 跟踪鲁棒性对比

进一步验证本文算法的快速运动视觉目标跟踪鲁棒性,将跟踪成功率作为评价指标,跟踪成功率越高,表明算法的快速运动视觉目标跟踪鲁棒性越强。其计算公式为

(24)

式(24)中,cg是指成功跟踪的快速运动视觉目标数量。采用选取的6种主流跟踪算法与所提算法进行对比,得到不同算法的快速运动视觉目标跟踪成功率如表2所示。

表2 不同算法的快速运动视觉目标跟踪成功率Tab.2 Success rate of fast motion visual target tracking for different algorithms

根据表2可知,当快速运动视觉目标数量为2 500个时,本文算法、文献[6]算法和文献[7]算法的快速运动视觉目标跟踪成功率均值分别为98.2%,83%和86.2%,其跟踪成功率均在80%以上;文献[8]、文献[9]和文献[10]算法的快速运动视觉目标跟踪成功率均值分别为70%,78%和71.8%,其跟踪准确率均在70%以上;文献[11]算法的快速运动视觉目标跟踪成功率均值仅为63.8%,其跟踪准确率均低于70%。对比上述不同算法的快速运动视觉目标跟踪成功率可知,本文算法的快速运动视觉目标跟踪成功率最高,能够有效增强快速运动视觉目标跟踪鲁棒性。

3.5 跟踪效率对比

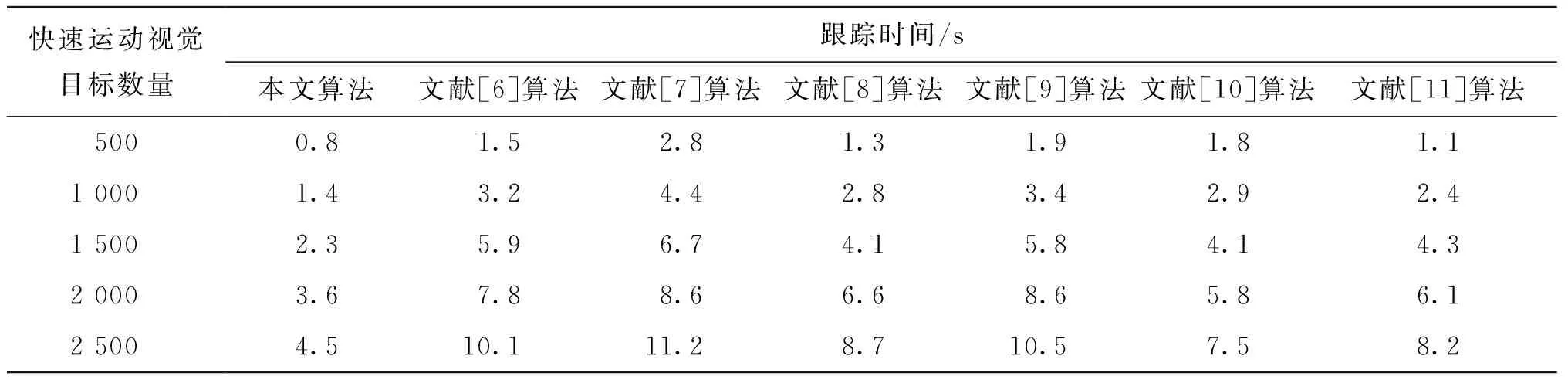

在此基础上,验证本文算法的快速运动视觉目标跟踪效率,将目标跟踪时间作为评价指标,其目标跟踪时间越短,表明算法的快速运动视觉目标跟踪效率越高。采用选取的6种主流跟踪算法与所提算法进行对比,得到不同算法的快速运动视觉目标跟踪时间如表3所示。

表3 不同算法的快速运动视觉目标跟踪时间Tab.3 Fast motion visual target tracking time for different algorithms

根据表3可知,随着快速运动视觉目标数量的增加,不同算法的快速运动视觉目标跟踪时间随之增加。当快速运动视觉目标数量为2 500个时,文献[6]、文献[7]和文献[9]算法的快速运动视觉目标跟踪时间分别为10.1,11.2和10.5 s,其跟踪时间均在10 s以上;文献[8]、文献[10]和文献[11]算法的快速运动视觉目标跟踪时间分别为8.7,7.5和8.2 s,其跟踪时间均在7 s以上;而本文算法的快速运动视觉目标跟踪时间仅为4.5 s。对比上述不同算法的快速运动视觉目标跟踪时间可知,本文算法的快速运动视觉目标跟踪时间较短,能够有效提高快速运动视觉目标跟踪效率。

4 结论

本文提出了融合多尺度核相关滤波和深度特征匹配模型的快速运动视觉目标跟踪算法。采用核相关滤波跟踪算法,针对快速运动视觉目标的尺度变化,训练多尺度核相关滤波器进行快速运动视觉目标跟踪特征提取。当快速运动视觉目标被严重遮挡或目标模糊时,融合深度特征匹配模型,实现快速运动视觉目标跟踪。通过仿真实验验证了该算法的有效性,并得出以下结论:

1) 本文算法具有较好的快速运动视觉目标跟踪效果,能够有效跟踪被遮挡、模糊的快速运动视觉目标。

2) 本文算法的平均快速运动视觉目标跟踪准确率高达97.6%,相比其他算法,其快速运动视觉目标跟踪准确率最高,能够有效提高快速运动视觉目标跟踪精度。

3) 本文算法的快速运动视觉目标跟踪成功率均值高达98.2%,相比其他算法,其快速运动视觉目标跟踪成功率最高,具有较强的快速运动视觉目标跟踪鲁棒性。

4) 随着快速运动视觉目标数量的增加,本文算法的快速运动视觉目标跟踪时间仅为4.5 s,其快速运动视觉目标跟踪时间较短,可以有效提高快速运动视觉目标跟踪效率。

在快速运动视觉目标跟踪过程中,由于多尺度参数在空间位置上与其他尺度有所偏差,使得尺度估计不够精准。因此,在下一步的研究中,可以从金字塔注意力层的思路突破这一局限性。